nltk_28Twitter情感分析模型

sklearn实战-乳腺癌细胞数据挖掘(博客主亲自录制视频教程)

https://study.163.com/course/introduction.htm?courseId=1005269003&utm_campaign=commission&utm_source=cp-400000000398149&utm_medium=share

生产Twitter情感分析的模型,并保存数据为pickle,此过程可能要一个小时,所以下次调用数据就很简单了

# -*- coding: utf-8 -*-

"""

Created on Thu Jan 12 10:44:19 2017 @author: Administrator 用于短评论分析-- Twitter 保存后的"positive.txt","negative.txt"需要转码为utf-8

在线转码网址

http://www.esk365.com/tools/GB2312-UTF8.asp features=5000,准确率百分之60以上

features=10000,准确率百分之 以上 运行时间可能长达一个小时

""" import nltk

import random

import pickle

from nltk.tokenize import word_tokenize short_pos = open("positive.txt","r").read()

short_neg = open("negative.txt","r").read() # move this up here

documents = []

all_words = [] for r in short_pos.split('\n'):

documents.append( (r, "pos") ) for r in short_neg.split('\n'):

documents.append( (r, "neg") ) # j is adject, r is adverb, and v is verb

#allowed_word_types = ["J","R","V"] 允许形容词类别

allowed_word_types = ["J"] for p in short_pos.split('\n'):

documents.append( (p, "pos") )

words = word_tokenize(p)

pos = nltk.pos_tag(words)

for w in pos:

if w[1][0] in allowed_word_types:

all_words.append(w[0].lower()) for p in short_neg.split('\n'):

documents.append( (p, "neg") )

words = word_tokenize(p)

pos = nltk.pos_tag(words)

for w in pos:

if w[1][0] in allowed_word_types:

all_words.append(w[0].lower()) #保存文档

save_documents = open("pickled_algos/documents.pickle","wb")

pickle.dump(documents, save_documents)

save_documents.close() #保存特征

all_words = nltk.FreqDist(all_words)

#最好改成2万以上

word_features = list(all_words.keys())[:5000]

save_word_features = open("pickled_algos/word_features5k.pickle","wb")

pickle.dump(word_features, save_word_features)

save_word_features.close() def find_features(document):

words = word_tokenize(document)

features = {}

for w in word_features:

features[w] = (w in words) return features featuresets = [(find_features(rev), category) for (rev, category) in documents] random.shuffle(featuresets)

print(len(featuresets)) testing_set = featuresets[10000:]

training_set = featuresets[:10000] classifier = nltk.NaiveBayesClassifier.train(training_set)

print("Original Naive Bayes Algo accuracy percent:", (nltk.classify.accuracy(classifier, testing_set))*100)

classifier.show_most_informative_features(15) #保存分类器

save_classifier = open("pickled_algos/originalnaivebayes5k.pickle","wb")

pickle.dump(classifier, save_classifier)

save_classifier.close()

sentiment_mod.py

# -*- coding: utf-8 -*-

"""

Created on Thu Jan 12 16:47:51 2017 @author: Administrator

""" #File: sentiment_mod.py import nltk

import random

import pickle

from nltk.tokenize import word_tokenize documents_f = open("pickled_algos/documents.pickle", "rb")

documents = pickle.load(documents_f)

documents_f.close() word_features5k_f = open("pickled_algos/word_features5k.pickle", "rb")

word_features = pickle.load(word_features5k_f)

word_features5k_f.close() def find_features(document):

words = word_tokenize(document)

features = {}

for w in word_features:

features[w] = (w in words) return features featuresets_f = open("pickled_algos/featuresets.pickle", "rb")

featuresets = pickle.load(featuresets_f)

featuresets_f.close() random.shuffle(featuresets)

print(len(featuresets)) testing_set = featuresets[10000:]

training_set = featuresets[:10000] open_file = open("pickled_algos/originalnaivebayes5k.pickle", "rb")

classifier = pickle.load(open_file)

open_file.close() def sentiment(text):

feats = find_features(text)

return classifier.classify(feats)

测试

# -*- coding: utf-8 -*-

"""

Created on Thu Jan 12 16:50:12 2017 @author: Administrator

""" import sentiment_mod as s print(s.sentiment("This movie was awesome! The acting was great, plot was wonderful, and there were pythons...so yea!"))

print(s.sentiment("This movie was utter junk. There were absolutely 0 pythons. I don't see what the point was at all. Horrible movie, 0/10"))

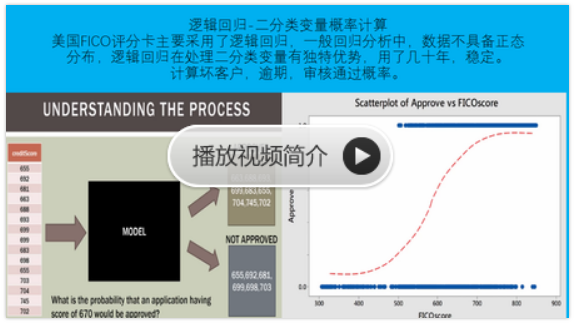

python风控评分卡建模和风控常识(博客主亲自录制视频教程)

nltk_28Twitter情感分析模型的更多相关文章

- 如何使用百度EasyDL进行情感分析

使用百度EasyDL定制化训练和服务平台有一段时间了,越来越能体会到EasyDL的易用性.在此之前我也接触过不少的深度学习平台,如类脑平台.Google的GCP深度学习平台.AWS深度学习平台,但我觉 ...

- NLP之中文自然语言处理工具库:SnowNLP(情感分析/分词/自动摘要)

一 安装与介绍 1.1 概述 SnowNLP是一个python写的类库,可以方便的处理中文文本内容,是受到了TextBlob的启发而写的,由于现在大部分的自然语言处理库基本都是针对英文的,于是写了一个 ...

- 如何用KNIME进行情感分析

Customer Intelligence Social Media Finance Credit Scoring Manufacturing Pharma / Health Care Retail ...

- 基于情感词典的python情感分析

近期老师给我们安排了一个大作业,要求根据情感词典对微博语料进行情感分析.于是在网上狂找资料,看相关书籍,终于搞出了这个任务.现在做做笔记,总结一下本次的任务,同时也给遇到有同样需求的人,提供一点帮助. ...

- 关于ML.NET v0.6的发布说明

ML.NET 0.6版本提供了几项令人兴奋的新增功能: 用于构建和使用机器学习模型的新API 我们主要关注的是发布用于构建和使用模型的新ML.NET API的第一次迭代.这些新的,更灵活的API支持新 ...

- 【译】深度双向Transformer预训练【BERT第一作者分享】

目录 NLP中的预训练 语境表示 语境表示相关研究 存在的问题 BERT的解决方案 任务一:Masked LM 任务二:预测下一句 BERT 输入表示 模型结构--Transformer编码器 Tra ...

- 300万大奖:欢迎参加美团联合主办的全球AI挑战赛

2018年8月29日,由美团.创新工场.搜狗.美图联合主办的“AI Challenger 2018全球AI挑战赛”正式启动.美团CTO罗道峰.创新工场CEO李开复.搜狗CEO王小川和美图CEO吴欣鸿共 ...

- Deep-Learning-with-Python] 文本序列中的深度学习

https://blog.csdn.net/LSG_Down/article/details/81327072 将文本数据处理成有用的数据表示 循环神经网络 使用1D卷积处理序列数据 深度学习模型可以 ...

- 【Social Listening实战】当数据分析遭遇心理动力学:用户深层次的情感需求浮出水面

本文转自知乎 作者:苏格兰折耳喵 ----------------------------------------------------- 本文篇幅较长,分为五部分,在中间部分有关于心理分析工具的介 ...

随机推荐

- Scrum meeting报告

Scrum Meeting报告 要点: 讨论XueBa系统已有的和待实现的功能 短期内的任务分配 初步确定小组成员在第一轮迭代开发中任务 一. XueBa系统已有的和待实现的功能 项目完成情 ...

- so easy, too happy

一.预估与实际 PSP2.1 Personal Software Process Stages 预估耗时(分钟) 实际耗时(分钟) Planning 计划 • Estimate • 估计这个任务需要多 ...

- 关于如何使用Microsoft Word发博客

关于如何使用Microsoft Word发博客 PS:以Microsoft Word 2010为例作具体操作,实际上Microsoft Word 2007也可以完成该功能,略有差异,但是只能是20 ...

- 第三周vim入门学习2

一.vim重复命令 1.重复执行上次命令 在普通模式下.(小数点)表示重复上一次的命令操作 拷贝测试文件到本地目录 $ cp /etc/protocols . 打开文件进行编辑 $ vim proto ...

- 第二次作业利用java语言编写计算器进行四则运算

随着第一次作业的完成,助教 牛老师又布置了第二次作业:用java语言编写一个程序然后进行四则运算用户用键盘输入一个字符来结束程序显示统计结果.一开始看到这个题目我也着实吓了一跳 因为不知道如何下手而且 ...

- 软工1816 · Beta冲刺(6/7)

团队信息 队名:爸爸饿了 组长博客:here 作业博客:here 组员情况 组员1(组长):王彬 过去两天完成了哪些任务 推进Web端完成开发 推进修改一些后端接口的逻辑 着手制作视频 接下来的计划 ...

- ListViewAnimations使用时报错NoClassDefFoundError: com.nineoldandroids.animation.Animator

见 https://github.com/nhaarman/ListViewAnimations/issues/294 解决: Add this to your dependencies in you ...

- 19_集合_第19天(List、Set)_讲义

今日内容介绍 1.List接口 2.Set接口 3.判断集合唯一性原理 非常重要的关系图 xmind下载地址 链接:https://pan.baidu.com/s/1kx0XabmT27pt4Ll9A ...

- Head First Java & final

- Java 经典 书籍

1.<你的灯还亮着么> 方法论 2.<程序员修炼之道 从小工到专家> 方法论 3.<发布!软件的设计与部署> 案例&经验总结 4.<思考,快与慢> ...