获取kafka最新offset-java

之前笔者曾经写过通过scala的方式获取kafka最新的offset

但是大多数的情况我们需要使用java的方式进行获取最新offset

scala的方式可以参考: http://www.cnblogs.com/weishao-lsv/p/8159396.html

以下是通过java代码获取kafka最新offset

GetOffsetShellWrap

public class GetOffsetShellWrap {

private static Logger log = LoggerFactory.getLogger(GetOffsetShellWrap.class);

private String topic;

private int port;

private String host;

private int time;

public GetOffsetShellWrap(String topic,int port,String host,int time) {

this.topic = topic;

this.port = port;

this.host = host;

this.time = time;

}

public Map<String, String> getEveryPartitionMaxOffset() {

//1.获取topic所有分区 以及每个分区的元数据 => 返回 Map<分区id,分区元数据>

TreeMap<Integer, PartitionMetadata> partitionIdAndMeta = findTopicEveryPartition();

Map<String, String> map = new HashMap<String, String>();

for (Entry<Integer, PartitionMetadata> entry : partitionIdAndMeta.entrySet()) {

int leaderPartitionId = entry.getKey();

//2.根据每个分区的元数据信息 ==> 获取leader分区的主机

String leadBroker = entry.getValue().leader().host();

String clientName = "Client_" + topic + "_" + leaderPartitionId;

SimpleConsumer consumer = new SimpleConsumer(leadBroker, port,100000, 64 * 1024, clientName);

//3.从leader主机获取分区的offset

long readOffset = getLastOffset(consumer, topic, leaderPartitionId, clientName);

map.put(String.valueOf(leaderPartitionId), String.valueOf(readOffset));

if (consumer != null)

consumer.close();

}

return map;

}

private TreeMap<Integer, PartitionMetadata> findTopicEveryPartition(){

TreeMap<Integer, PartitionMetadata> map = new TreeMap<Integer, PartitionMetadata>();

SimpleConsumer consumer = null;

try {

consumer = new SimpleConsumer(host, port, 100000, 64 * 1024,"leaderLookup" + new Date().getTime());

List<String> topics = Collections.singletonList(topic);

TopicMetadataRequest req = new TopicMetadataRequest(topics);

kafka.javaapi.TopicMetadataResponse resp = consumer.send(req);

List<TopicMetadata> metaData = resp.topicsMetadata();

if(metaData!=null && !metaData.isEmpty()){

TopicMetadata item = metaData.get(0);

for (PartitionMetadata part : item.partitionsMetadata()) {

map.put(part.partitionId(), part);

}

}

} catch (Exception e) {

e.printStackTrace();

} finally {

if (consumer != null)

consumer.close();

}

return map;

}

private long getLastOffset(SimpleConsumer consumer, String topic,int leaderPartitionId, String clientName) {

TopicAndPartition topicAndPartition = new TopicAndPartition(topic,leaderPartitionId);

Map<TopicAndPartition, PartitionOffsetRequestInfo> requestInfo = new HashMap<TopicAndPartition, PartitionOffsetRequestInfo>();

requestInfo.put(topicAndPartition, new PartitionOffsetRequestInfo(time, 1));

kafka.javaapi.OffsetRequest request = new kafka.javaapi.OffsetRequest(requestInfo, kafka.api.OffsetRequest.CurrentVersion(),clientName);

OffsetResponse response = consumer.getOffsetsBefore(request);

if (response.hasError()) {

log.error("Error fetching data Offset Data the Broker. Reason: "+ response.errorCode(topic, leaderPartitionId));

return 0;

}

long[] offsets = response.offsets(topic, leaderPartitionId);

return offsets[0];

}

}

GetOffsetShellWrapJavaTest

public class GetOffsetShellWrapJavaTest {

public static void main(String[] args) {

int port = 9092;

String topic = "2017-11-6-test";

int time = -1;

GetOffsetShellWrap offsetSearch = new GetOffsetShellWrap(topic,port,"hadoop-01",time);

Map<String, String> map = offsetSearch.getEveryPartitionMaxOffset();

for (String key : map.keySet()) {

System.out.println(key+"---"+map.get(key));

}

}

}

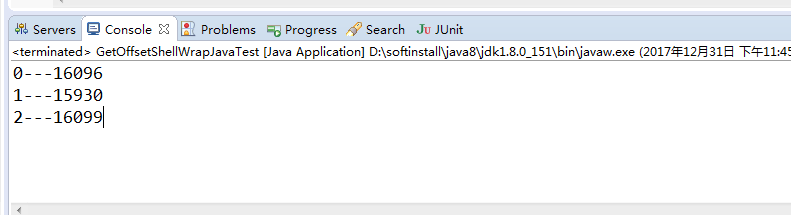

结果输出:

0---16096 1---15930 2---16099

获取kafka最新offset-java的更多相关文章

- 获取kafka最新offset-scala

无论是在spark streaming消费kafka,或是监控kafka的数据时,我们经常会需要知道offset最新情况 kafka数据的topic基于分区,并且通过每个partition的主分区可以 ...

- sparkStreaming获取kafka数据(java版本)

环境 spark-2.2.0 kafka_2.11-0.10.0.1 jdk1.8 配置好jdk,创建项目并将kafka和spark的jar包添加到项目中,除此之外还需要添加spark-streami ...

- 工具篇-Spark-Streaming获取kafka数据的两种方式(转载)

转载自:https://blog.csdn.net/weixin_41615494/article/details/7952173 一.基于Receiver的方式 原理 Receiver从Kafka中 ...

- Spark-Streaming获取kafka数据的两种方式:Receiver与Direct的方式

简单理解为:Receiver方式是通过zookeeper来连接kafka队列,Direct方式是直接连接到kafka的节点上获取数据 Receiver 使用Kafka的高层次Consumer API来 ...

- SparkStreaming获取kafka数据的两种方式:Receiver与Direct

简介: Spark-Streaming获取kafka数据的两种方式-Receiver与Direct的方式,可以简单理解成: Receiver方式是通过zookeeper来连接kafka队列, Dire ...

- spark-streaming获取kafka数据的两种方式

简单理解为:Receiver方式是通过zookeeper来连接kafka队列,Direct方式是直接连接到kafka的节点上获取数据 一.Receiver方式: 使用kafka的高层次Consumer ...

- 获取Kafka每个分区最新Offset的几种方法

目录 脚本方法 Java 程序 参考资料 脚本方法 ./bin/kafka-run-class.sh kafka.tools.GetOffsetShell --broker-list localhos ...

- 关于怎么获取kafka指定位置offset消息(转)

1.在kafka中如果不设置消费的信息的话,一个消息只能被一个group.id消费一次,而新加如的group.id则会被“消费管理”记录,并指定从当前记录的消息位置开始向后消费.如果有段时间消费者关闭 ...

- 如何获取流式应用程序中checkpoint的最新offset

对于流式应用程序,保证应用7*24小时的稳定运行,是非常必要的.因此对于计算引擎,要求必须能够适应与应用程序逻辑本身无关的问题(比如driver应用失败重启.网络问题.服务器问题.JVM崩溃等),具有 ...

随机推荐

- Hibernate基本原理理解

什么是Hibernate? Hibernate,翻译过来是冬眠的意思,正好现在已经进入秋季,世间万物开始准备冬眠了.其实对于对象来说就是持久化. 扫盲------------------------- ...

- VUE DIV模拟input框的基本处理

关键代码 <div class="dialog-main" :contenteditable= "editable" v-text="notic ...

- JavaWeb面试篇(7)

61,JDBC访问数据库的基本步骤是什么?1,加载驱动2,通过DriverManager对象获取连接对象Connection3,通过连接对象获取会话4,通过会话进行数据的增删改查,封装对象5,关闭资源 ...

- python中的类,对象,实例,继承,多态

------------恢复内容开始------------ 类 (通俗来讲是 属性和方法的集合) 用来描述具有相同的属性和方法的对象的集合.它定义了该集合中每个对象所共有的属性和方法. 对象,即为类 ...

- 代码检测docker-sonarqube

gitlab-ce + gitlab-runner + sonarqube,在提交代码时对代码质量进行检测,对不符合要求的代码不允许提交到gitlab version: '3.1' services: ...

- python 线程模块

Python通过两个标准库thread和threading提供对线程的支持.thread提供了低级别的.原始的线程以及一个简单的锁. threading 模块提供的其他方法: threading.cu ...

- 2019 Multi-University Training Contest 3 T6 - Fansblog

Fansblog Time Limit: 2000/2000 MS (Java/Others) Memory Limit: 65536/65536 K (Java/Others)Total Submi ...

- Rust:剑指C++

Rust:极富活力和前途的编程语言,剑指C++ 今天开始学习Rust,马上要回去休息了,只贴上一段实例代码,在后续的学习中,会对这种语言进行一个详尽的介绍(学习中....). extern crate ...

- pycharm 安装激活

下载pycharm :http://www.jetbrains.com/pycharm/download/download 安装 直到 finish 下载补丁jetbrains-agent.jar并添 ...

- Linux6.6及以上版本配置oracle-ASM共享储存-UDEV-V1

1,在该路劲下创建50-udev.rules文件,将要创建成ASM设备的裸设备添加进去,并指定OWNER 两个节点进行创建 [root@oraclea rules.d]# pwd/etc/udev/r ...