OpenStack虚拟机网络问题

当发现你的OpenStack虚拟机网络有问题,不妨先试一下这16个步骤

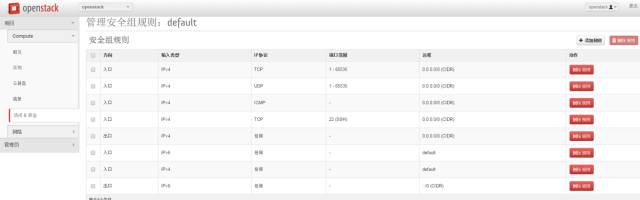

1. Security Group全部打开,这是最基本的,但是很多人容易忘记

其实遇到过无数这种场景了,Debug了半天网络问题,各种手段都用上了,最后发现安全组竟然没有打开。

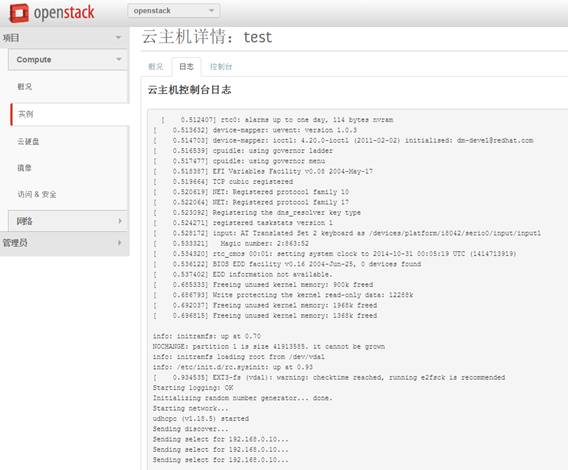

2. 通过界面查看虚拟机的log,也可以在compute节点上查看console.log文件,看看里面是否有DHCP获取IP成功的日志

在界面上可以看控制台日志

在compute节点上可以查看

/var/lib/nova/instances/6323a941-de10-4ed3-9e2f-1b2b25e79b66/console.log

如果没有日志,则说明image有问题

在grub里面

linux /boot/vmlinuz-3.2.0-49-virtual root=UUID=6d2231e4-0975-4f35-a94f-56738c1a8150 ro console=ttyS0

GRUB_CMDLINE_LINUX_DEFAULT="console=ttyS0“

update-grub

3. 如果虚拟机连不上DHCP Server,则需要准备一个不使用metadata server,而是用用户名密码可以登录的image

这种Image很好做,自己动手做一个就可以了,启动镜像后去掉cloud-init相关配置,然后设置一个默认的用户名密码。

4. 通过VNC登录

5. 如果VNC登录不进去,说明VNC配置的有问题,方法一重新配置VNC

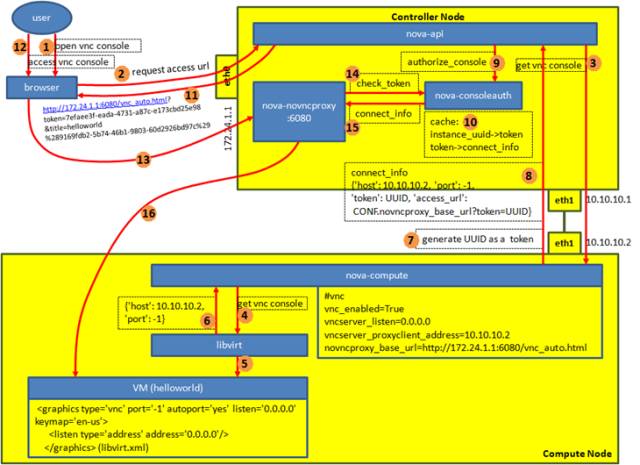

VNC Proxy的功能:

将公网(public network)和私网(private network)隔离

VNC client运行在公网上,VNCServer运行在私网上,VNC Proxy作为中间的桥梁将二者连接起来

VNC Proxy通过token对VNC Client进行验证

VNC Proxy不仅仅使得私网的访问更加安全,而且将具体的VNC Server的实现分离,可以支持不同Hypervisor的VNC Server但不影响用户体验

VNC Proxy的部署

在Controller节点上部署nova-consoleauth 进程,用于Token验证

在Controller节点上部署nova-novncproxy 服务,用户的VNC Client会直接连接这个服务

Controller节点一般有两张网卡,连接到两个网络,一张用于外部访问,我们称为public network,或者API network,这张网卡的IP地址是外网IP,如图中172.24.1.1,另外一张网卡用于openstack各个模块之间的通信,称为management network,一般是内网IP,如图中10.10.10.2

在Compute节点上部署nova-compute,在nova.conf文件中有下面的配置

vnc_enabled=True

vncserver_listen=0.0.0.0 //VNC Server的监听地址

vncserver_proxyclient_address=10.10.10.2 //nova vnc proxy是通过内网IP来访问vnc server的,所以nova-compute会告知vnc proxy用这个IP来连接我。

novncproxy_base_url=http://172.24.1.1:6080/vnc_auto.html //这个url是返回给客户的url,因而里面的IP是外网IP

VNC Proxy的运行过程:

一个用户试图从浏览器里面打开连接到虚拟机的VNC Client

浏览器向nova-api发送请求,要求返回访问vnc的url

nova-api调用nova-compute的get vnc console方法,要求返回连接VNC的信息

nova-compute调用libvirt的get vnc console函数

libvirt会通过解析虚拟机运行的/etc/libvirt/qemu/instance-0000000c.xml文件来获得VNC Server的信息

libvirt将host, port等信息以json格式返回给nova-compute

nova-compute会随机生成一个UUID作为Token

nova-compute将libvirt返回的信息以及配置文件中的信息综合成connect_info返回给nova-api

nova-api会调用nova-consoleauth的authorize_console函数

nova-consoleauth会将instance –> token, token –> connect_info的信息cache起来

nova-api将connect_info中的access url信息返回给浏览器:http://172.24.1.1:6080/vnc_auto.html?token=7efaee3f-eada-4731-a87c-e173cbd25e98&title=helloworld%289169fdb2-5b74-46b1-9803-60d2926bd97c%29

浏览器会试图打开这个链接

这个链接会将请求发送给nova-novncproxy

nova-novncproxy调用nova-consoleauth的check_token函数

nova-consoleauth验证了这个token,将这个instance对应的connect_info返回给nova-novncproxy

nova-novncproxy通过connect_info中的host, port等信息,连接compute节点上的VNC Server,从而开始了proxy的工作

6. 如果VNC登录不进去,还有一个方法,使用自己的VNC Client,通过compute物理节点的IP地址登陆

qemu-system-x86_64 有参数 -vnc 0.0.0.0:5

就可以通过compute node的ip地址进入

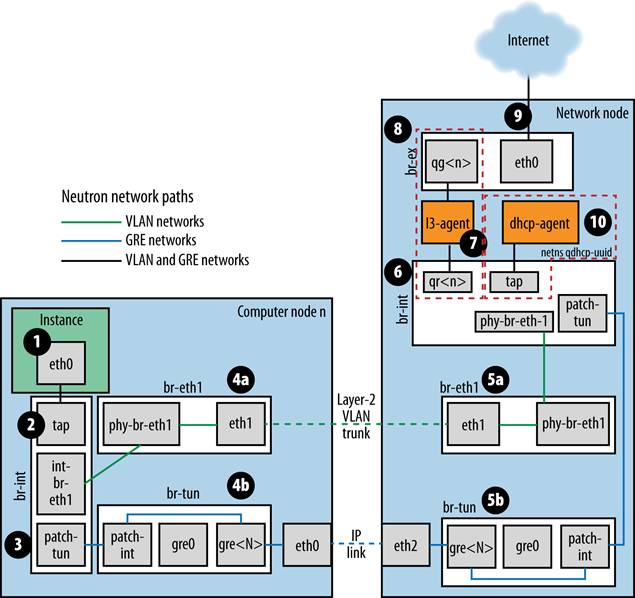

7. 通过ovs-vsctl show和brctl来查看,各个网卡和bridge之间关系是否正确,tunnel之间是否能够通,网卡是否都处于up的状态

8. 如果从虚拟机的虚拟网卡到DHCP Server的网卡一路都是配置正确的,则需要查看br-tun上ovs-ofctl dumpflows查看flows规则,是否对包的改写正确,是否有正确的规则

9. 通过VNC登录进去后,就可以通过命令行运行dhclient,来重启连接DHCP Server, 从compute节点上的网卡和bridge,一个个进行tcpdump,看到底哪个网卡或者bridge没有收到包,收到的包里面的VLAN ID等是否正确

10. 如果VM能从DHCP Server获得IP,则好事成了一半,接下来换一个有cloud-init的image,看metadata server能够连接成功,能够注入key,也是通过console.log来看

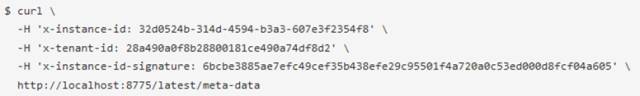

11. 如果metadata server不能连接成功,就需要顺着metadata server的整个流程,一个一个模块看,看每个模块的log,端口是否正确,是否收到请求,也可以在VM里面用curl来模拟metadata server的请求

openstack里的metadata,是提供一个机制给用户,可以设定每一个instance 的参数。比如你想给instance设置某个属性,比如主机名。

Instance访问metadata server http://169.254.169.254

metadata的一个重要应用,是设置每个instance的ssh公钥。

获取metadata的api接口是:

http://169.254.169.254/latest/meta-data/public-keys/0/openssh-key

这个IP地址,在 openstack 是不存在的。为什么可以获取到metadata呢?

这是由于Amazon的原因,最早metadata是亚马逊提出来的,参见:http://docs.amazonwebservices.com/AWSEC2/latest/UserGuide/AESDG-chapter-instancedata.html

后来很多人给亚马逊定制了一些操作系统的镜像,比如 ubuntu, fedora, centos 等等,而且将里面获取 metadta 的api地址也写死了。所以opentack为了兼容,保留了这个地址169.254.169.254。

然后通过iptables nat映射到真实的api上:

iptables -A nova-network-PREROUTING -d 169.254.169.254/32 -p tcp -m tcp --dport 80 -j DNAT --to-destination 16.158.166.197:8775

nova如何区分到底是哪个虚拟机请求metadata?采取的方法是在HTTP头部识别是哪个虚拟机。

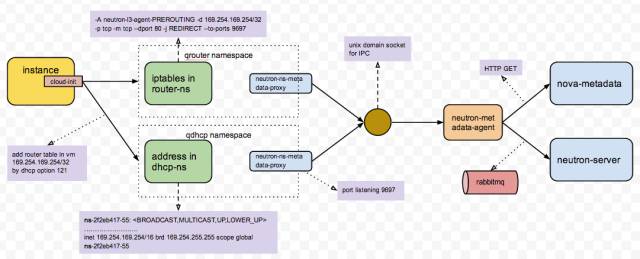

一个虚拟机访问169.254.169.254的流程如下:

(1) 虚拟机发出请求

虚拟机启动时会访问169.254.169.254

数据包会直接发送到虚拟机的默认网关172.71.71.1

默认网关在network node上,qr-XXXXX

(2) namespace中的iptables

因为使用了namespace,在network node上每个namespace里都会有相应的iptables规则和网络设备。

iptables规则中,会把目的地址169.254.169.254的数据包,重定向到本地端口9697

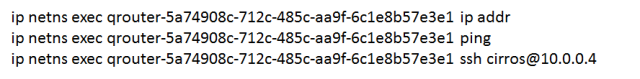

ip netns exec qrouter-5a74908c-712c-485c-aa9f-6c1e8b57e3e1 iptables -t nat -nvL

(3) namespace-metadata-proxy

启用namespace场景下,对于每一个router,都会创建这样一个进程。该进程监听9697端口,其主要功能:

1、向请求头部添加X-Forwarded-For和X-Neutron-Router-ID,分别表示虚拟机的fixedIP和router的ID

2、将请求代理至Unix domain socket(/var/lib/neutron/metadata_proxy)

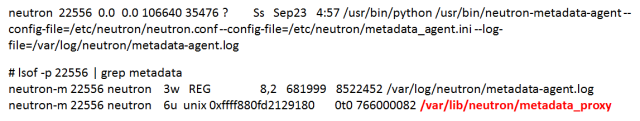

(4) Neutron-metadata-agent

network node上的metadata agent监听/var/lib/neutron/metadata_proxy:

该进程的功能是,根据请求头部的X-Forwarded-For和X-Neutron-Router-ID参数,向Neutron service查询虚拟机ID,然后向Nova Metadata服务发送请求(默认端口8775),消息头:X-Forwarded-For,X-Instance-ID、X-Instance- ID-Signature分别表示虚拟机的fixedIP,虚拟机ID和虚拟机ID的签名。

12. 如果metadata server能够连接成功,key成功注入,下一步需要从namespace里面看是否能够ping通,能够ssh

13. 如果namespace里面能够成功,则在network节点上,ping floating ip和ssh,是否能够成功,如果不成功,看br-ex的网卡是否添加正确,是否配置了ip,路由表是否正确,namespace里面floating ip的iptables规则是否添加正确

14. 在network节点上能够ssh到floating ip,则需要从其他节点上ssh,如果不成功,可能br-ex的网址配置有问题,很可能是br-ex添加的物理网卡不是混合状态,也可能是路由配置有问题,对于floating ip所在的网段,不指向network节点

15. 如果floating ip能够成功,则需要进去VM里面运行apt-get update,如果不可以,看能否ping通openstack里面的gateway(10.0.0.1),然后看能否ping通物理网络环境的gateway(16.158.XXX.1)

16. 看DNS Server是否配置正确,是否能够ping通,如果能,apt-get update运行成功

(转载)

OpenStack虚拟机网络问题的更多相关文章

- 当发现你的OpenStack虚拟机网络有问题,不妨先试一下这16个步骤

1. Security Group全部打开,这是最基本的,但是很多人容易忘记 其实遇到过无数这种场景了,Debug了半天网络问题,各种手段都用上了,最后发现安全组竟然没有打开. 2. 通过界面查看虚拟 ...

- openstack的一台Nova主机上的虚拟机网络的配置

1.一台虚拟机器的网络配置,通过openstack/nova计算节点服务生成的虚拟机配置文件 <interface type='bridge'> <mac address='fa:1 ...

- openstack虚拟机启动过程

核心项目3个 1.控制台 服务名:Dashboard 项目名:Horizon 功能:web方式管理云平台,建云主机,分配网络,配安全组,加云盘 2.计算 服务名:计算 项目名:Nova 功能:负责响应 ...

- Namespace:Openstack的网络实现

前言:众所周知在linux系统中PID.IPC.Network等都是全局性的资源,不论什么的改动和删减都会对整个系统造成影响.这也是为什么kvm之类的虚拟化技术须要模拟一个完毕主机系统的原因. 可是. ...

- 别以为真懂Openstack: 虚拟机创建的50个步骤和100个知识点(5)

八.KVM 这一步,像virsh start命令一样,将虚拟机启动起来了.虚拟机启动之后,还有很多的步骤需要完成. 步骤38:从DHCP Server获取IP 有时候往往数据库里面,VM已经有了IP, ...

- OpenStack虚拟机冷迁移与热迁移

一.虚拟机迁移分析 openstacvk虚拟机迁移分为冷迁移和热迁移两种方式. 1.1冷迁移: 冷迁移(cold migration),也叫静态迁移.关闭电源的虚拟机进行迁移.通过冷迁移,可以选择将关 ...

- 云计算与OpenStack(虚拟机Nova篇)

<云计算与OpenStack(虚拟机Nova篇)> 基本信息 作者: 伯龙 程志鹏 张杰 出版社:电子工业出版社 ISBN:9787121201202 上架时间:2013-8-5 出版日期 ...

- openstack——neutron网络服务

一.neutron 介绍: Neutron 概述 传统的网络管理方式很大程度上依赖于管理员手工配置和维护各种网络硬件设备:而云环境下的网络已经变得非常复杂,特别是在多租户场景里,用户随时都可能需要 ...

- OpenStack 虚拟机冷/热迁移的实现原理与代码分析

目录 文章目录 目录 前文列表 冷迁移代码分析(基于 Newton) Nova 冷迁移实现原理 热迁移代码分析 Nova 热迁移实现原理 向 libvirtd 发出 Live Migration 指令 ...

随机推荐

- MySQL5.7在Ubuntu上的安装、配置与使用

前言 服务器上安装东西一直是很让我头疼的事情,缘由:Linux基础不好.. 安装MySQL踩了很多坑,绕了很多弯路,这次踩得是tar包安装的坑... 当然,与tar包无关... 环境: Ubuntu ...

- php array_fill()函数 语法

php array_fill()函数 语法 作用:用键值填充数组.大理石平台价格 语法:array_fill(index,number,value) 参数: 参数 描述 index 必需.被返回数组的 ...

- web大文件断点续传

1,项目调研 因为需要研究下断点上传的问题.找了很久终于找到一个比较好的项目. 在GoogleCode上面,代码弄下来超级不方便,还是配置hosts才好,把代码重新上传到了github上面. http ...

- sqlserver安装-1

原文地址: https://blog.csdn.net/qq_41432123/article/details/79053486 下载:(免费使用安装dev版) ed2k://|file|cn_sql ...

- ES6中set的用法回顾

ES6中的set类似一个数组,但是其中的值都是唯一的,Set本身是一个构造函数,用来生成 Set 数据结构. set函数可以接受一个数组作为参数,用来初始化: const set = new Set( ...

- HDU 6583 Typewriter 题解

——本题来自杭电多校第一场 题意:给定一个字符串,主角需要用打字机将字符串打出来,每次可以: 1.花费p来打出任意一个字符 2.花费q来将已经打出的某一段(子串)复制到后面去 对于这种最优化的问题,我 ...

- 第五周课程总结&实验报告三

1.已知字符串:"this is a test of java".按要求执行以下操作:(要求源代码.结果截图.) •统计该字符串中字母s出现的次数. •统计该字符串中子串" ...

- 网页导出excel

package site.action.ecom.backend.wechat.exportExcel; import java.lang.annotation.Documented;import j ...

- [BZOJ 3307]Cow Politics (LCA)

[BZOJ 3307]Cow Politics (LCA) 题面 给出一棵N个点的树,树上每个节点都有颜色.对于每种颜色,求该颜色距离最远的两个点之间的距离.N≤200000 分析 显然对于每种颜色建 ...

- Codeforces 1091C (数学)

题面 传送门 分析 假设k是固定的,那访问到的节点编号就是\(1+(a·k \mod n )\),其中a为正整数. 通过找规律不难发现会出现循环. 通过题目中的图片我们不难发现 只有k=1,2,3,6 ...