爬虫之 案列1补充(pipelines优化)

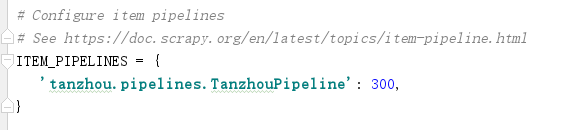

1. 先打开settings.py文件将 'ITEM_PIPELINES'启动(取消注释即可)

2. spider代码

# -*- coding: utf-8 -*-

import scrapy

import json class TzcSpider(scrapy.Spider):

# spider的名字,唯一

name = 'tzc'

# 起始地址

start_urls = ['https://hr.tencent.com/position.php?keywords=python&tid=0&lid=2268'] # 每个url爬取之后会调用这个方法

def parse(self, response):

tr = response.xpath( '//table[@class="tablelist"]/tr[@class = "even"]|//table[@class="tablelist"]/tr[@class = "odd"]')

if tr:

for i in tr:

data = {

"jobName": i.xpath('./td[1]/a/text()').extract_first(),

"jobType":i.xpath('./td[2]/text()').extract_first(),

"Num":i.xpath('./td[3]/text()').extract_first(),

"Place":i.xpath('./td[4]/text()').extract_first(),

"Time":i.xpath('./td[5]/text()').extract_first()

}

# 将数据变成json数据便于存储

# data = json.dumps(data,ensure_ascii=False)

yield data

# 寻找下一页标签

url_next = response.xpath('//a[@id = "next"]/@href').extract_first()

# 提取的是段标签,需要加上域名

url_next = 'https://hr.tencent.com/{}'.format(url_next)

# 返回下一页地址,scrapy会递归

yield scrapy.Request(url_next)

3. pipelines.py代码

import json class TanzhouPipeline(object):

def process_item(self, item, spider):

# 数据json化

item = json.dumps(item,ensure_ascii=False)

self.f.write(item)

self.f.write('\n')

return item

# 爬虫开启时运行

def open_spider(self,spider):

# 打开文件

self.f = open('info3.json','w')

# 爬虫关闭时运行

def close_spider(self,spider):

# 关闭文件

self.f.close()

4. 补充2,防止item不规范,可以使用items.py文件对其限制(还要改spider中的item代码)(还要修改pipelines中的代码,要先dict(item)转化成字典,再json转化)

pipeline.py中先转化成字典dict()再json转化:

item = json.dumps(dict(item),ensure_ascii=False)

items.py代码:

import scrapy class TanzhouItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

jobName = scrapy.Field()

jobType = scrapy.Field()

Num = scrapy.Field()

Place = scrapy.Field()

Time =scrapy.Field()

spider代码:

import scrapy

import json

from ..items import TanzhouItem class TzcSpider(scrapy.Spider):

# spider的名字,唯一

name = 'tzc'

# 起始地址

start_urls = ['https://hr.tencent.com/position.php?keywords=python&tid=0&lid=2268'] # 每个url爬取之后会调用这个方法

def parse(self, response):

tr = response.xpath( '//table[@class="tablelist"]/tr[@class = "even"]|//table[@class="tablelist"]/tr[@class = "odd"]')

if tr:

for i in tr:

# 自定义字典的方式,下面是第二种方式

data = {

"jobName": i.xpath('./td[1]/a/text()').extract_first(),

"jobType":i.xpath('./td[2]/text()').extract_first(),

"Num":i.xpath('./td[3]/text()').extract_first(),

"Place":i.xpath('./td[4]/text()').extract_first(),

"Time":i.xpath('./td[5]/text()').extract_first()

}

# 第二种方式,用items.py约束

# data = TanzhouItem()

# data["jobName"] = i.xpath('./td[1]/a/text()').extract_first()

# data["jobType"] = i.xpath('./td[2]/text()').extract_first()

# data["Num"] = i.xpath('./td[3]/text()').extract_first()

# data["Place"] = i.xpath('./td[4]/text()').extract_first()

# data["Time"] = i.xpath('./td[5]/text()').extract_first()

# 将数据变成json数据便于存储

# data = json.dumps(data,ensure_ascii=False)

yield data

# 寻找下一页标签

url_next = response.xpath('//a[@id = "next"]/@href').extract_first()

# 提取的是段标签,需要加上域名

url_next = 'https://hr.tencent.com/{}'.format(url_next)

# 返回下一页地址,scrapy会递归

yield scrapy.Request(url_next)

爬虫之 案列1补充(pipelines优化)的更多相关文章

- 2021年-在windwos下如何用TOMACT发布一个系统(完整配置案列)

2021年新年第一篇:博主@李宗盛-关于在Windwos下使用TOMCAT发布一个系统的完成配置案列. 之前写过关于TOMCAT的小篇幅文档,比较分散,可以作为对照与参考. 此篇整合在一起,一篇文档写 ...

- Spring MVC的配置文件(XML)的几个经典案列

1.既然是配置文件版的,那配置文件自然是必不可少,且应该会很复杂,那我们就以一个一个的来慢慢分析这些个经典案列吧! 01.实现Controller /* * 控制器 */ public class M ...

- js闭包的作用域以及闭包案列的介绍:

转载▼ 标签: it js闭包的作用域以及闭包案列的介绍: 首先我们根据前面的介绍来分析js闭包有什么作用,他会给我们编程带来什么好处? 闭包是为了更方便我们在处理js函数的时候会遇到以下的几 ...

- SAMSUNG某型号一千短信成功记录!对比其他软件恢复不成功的案列!

Hello! 大家好欢迎再次来到Dr.wonde的博客, 下面谈一下今天的案列,今年11月26号收到了一客户寄来的三星S4手机恢复里面短信, 如下图所示,用其他软件恢复以后,数据为零,没有恢复,,这下 ...

- php知识案列分享

今天再跟大家分享一下,以下案列. 使用array_flip函数生成随机数,可以去掉重复值. 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 < ...

- linux下mysql函数的详细案列

MYSQL * STDCALL mysql_real_connect(MYSQL *mysql, const char *host, const char *user, const char *pas ...

- axis1,xfire,jUnit 测试案列+开Web Service开发指南+axis1.jar下载 代码

axis1,xfire,jUnit 测试案列+Web Service开发指南(中).pdf+axis1.jar下载 代码 项目和资源文档+jar 下载:http://download.csdn. ...

- 大数据技术之_14_Oozie学习_Oozie 的简介+Oozie 的功能模块介绍+Oozie 的部署+Oozie 的使用案列

第1章 Oozie 的简介第2章 Oozie 的功能模块介绍2.1 模块2.2 常用节点第3章 Oozie 的部署3.1 部署 Hadoop(CDH版本的)3.1.1 解压缩 CDH 版本的 hado ...

- react 的安装和案列Todolist

react 的安装和案列Todolist 1.react的安装和环境的配置 首先检查有没有安装node.js和npm node -v npm -v 查看相关版本 2.安装脚手架工具 2.构建:crea ...

随机推荐

- C# 如何获取自定义的config中节点的值,并修改节点的值

现定义一个方法 DIYConfigHelper.cs using System; using System.Xml; using System.Configuration; using System. ...

- python-面向对象入门

一.面向对象介绍 介绍面向对象之前,先来回顾一下以前学的面向过程的编程思想 面向过程编程: 核心是过程二字,过程指的是解决问题的步骤,即先干什么,再干什么后干什么,基于该思想编程就好比是在设计一条流水 ...

- 【进阶3-1期】JavaScript深入之史上最全--5种this绑定全面解析(转)

这是我在公众号(高级前端进阶)看到的文章,现在做笔记 https://github.com/yygmind/blog/issues/20 this的绑定规则总共有下面5种. 1.默认绑定(严格/非严 ...

- Android:四大架构的优缺点,你真的了解吗?

声明|转载于作者:KunMinX原文链接:https://www.jianshu.com/p/9ef813d5c1af 前言 前不久刚结束对 20 模块项目的第 3 轮重构,一路见证 MVC.MVP. ...

- with文件操作

enumeratef = open('lyrics',"r",encoding=""utf-8) #文件句柄"""对文件操作流程 ...

- jquery 中多选和全选

- 对于stark(curd)插件的使用简单介绍

一.创建表 from django.db import models from django.db import models class Department(models.Model): &quo ...

- logical_backup: expdp/impdp

Table of Contents 1. 注意事项 2. 前期准备 3. 常用参数及示例 4. 常用语句示例 5. 交互式命令 6. 技巧 6.1. 不生成文件直接导入目标数据库 6.2. 通过she ...

- K8s-Pod

一:Pod-资源对象概述 Pod是k8s系统中可以创建和管理的最小单元,是资源对象模型中由用户创建或部署的最小资源对象模型,也是在k8s上运行容器化应用的资源对象,其他的资源对象都是用来支撑或者扩展P ...

- pycharm常用设置和快捷键大全

pycharm常用快捷键 1.编辑(Editing) Ctrl + Space 基本的代码完成(类.方法.属性)Ctrl + Alt + Space 快速导入任意类Ctrl + Shift + ...