吴裕雄--天生自然python Google深度学习框架:Tensorflow实现迁移学习

import glob

import os.path

import numpy as np

import tensorflow as tf

from tensorflow.python.platform import gfile

import tensorflow.contrib.slim as slim # 加载通过TensorFlow-Slim定义好的inception_v3模型。

import tensorflow.contrib.slim.python.slim.nets.inception_v3 as inception_v3 # 处理好之后的数据文件。

INPUT_DATA = '../../datasets/flower_processed_data.npy'

# 保存训练好的模型的路径。

TRAIN_FILE = 'train_dir/model'

# 谷歌提供的训练好的模型文件地址。因为GitHub无法保存大于100M的文件,所以

# 在运行时需要先自行从Google下载inception_v3.ckpt文件。

CKPT_FILE = '../../datasets/inception_v3.ckpt' # 定义训练中使用的参数。

LEARNING_RATE = 0.0001

STEPS = 300

BATCH = 32

N_CLASSES = 5 # 不需要从谷歌训练好的模型中加载的参数。

CHECKPOINT_EXCLUDE_SCOPES = 'InceptionV3/Logits,InceptionV3/AuxLogits'

# 需要训练的网络层参数明层,在fine-tuning的过程中就是最后的全联接层。

TRAINABLE_SCOPES='InceptionV3/Logits,InceptionV3/AuxLogit'

def get_tuned_variables():

exclusions = [scope.strip() for scope in CHECKPOINT_EXCLUDE_SCOPES.split(',')] variables_to_restore = []

# 枚举inception-v3模型中所有的参数,然后判断是否需要从加载列表中移除。

for var in slim.get_model_variables():

excluded = False

for exclusion in exclusions:

if var.op.name.startswith(exclusion):

excluded = True

break

if not excluded:

variables_to_restore.append(var)

return variables_to_restore

def get_trainable_variables():

scopes = [scope.strip() for scope in TRAINABLE_SCOPES.split(',')]

variables_to_train = [] # 枚举所有需要训练的参数前缀,并通过这些前缀找到所有需要训练的参数。

for scope in scopes:

variables = tf.get_collection(tf.GraphKeys.TRAINABLE_VARIABLES, scope)

variables_to_train.extend(variables)

return variables_to_train

def main():

# 加载预处理好的数据。

processed_data = np.load(INPUT_DATA)

training_images = processed_data[0]

n_training_example = len(training_images)

training_labels = processed_data[1] validation_images = processed_data[2]

validation_labels = processed_data[3] testing_images = processed_data[4]

testing_labels = processed_data[5]

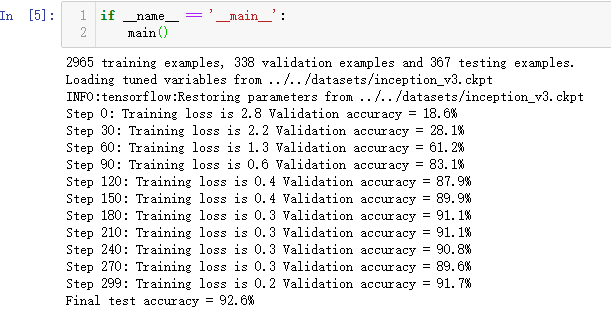

print("%d training examples, %d validation examples and %d testing examples." % (

n_training_example, len(validation_labels), len(testing_labels))) # 定义inception-v3的输入,images为输入图片,labels为每一张图片对应的标签。

images = tf.placeholder(tf.float32, [None, 299, 299, 3], name='input_images')

labels = tf.placeholder(tf.int64, [None], name='labels') # 定义inception-v3模型。因为谷歌给出的只有模型参数取值,所以这里

# 需要在这个代码中定义inception-v3的模型结构。虽然理论上需要区分训练和

# 测试中使用到的模型,也就是说在测试时应该使用is_training=False,但是

# 因为预先训练好的inception-v3模型中使用的batch normalization参数与

# 新的数据会有出入,所以这里直接使用同一个模型来做测试。

with slim.arg_scope(inception_v3.inception_v3_arg_scope()):

logits, _ = inception_v3.inception_v3(

images, num_classes=N_CLASSES, is_training=True) trainable_variables = get_trainable_variables()

# 定义损失函数和训练过程。

tf.losses.softmax_cross_entropy(

tf.one_hot(labels, N_CLASSES), logits, weights=1.0)

total_loss = tf.losses.get_total_loss()

train_step = tf.train.RMSPropOptimizer(LEARNING_RATE).minimize(total_loss) # 计算正确率。

with tf.name_scope('evaluation'):

correct_prediction = tf.equal(tf.argmax(logits, 1), labels)

evaluation_step = tf.reduce_mean(tf.cast(correct_prediction, tf.float32)) # 定义加载Google训练好的Inception-v3模型的Saver。

load_fn = slim.assign_from_checkpoint_fn(

CKPT_FILE,

get_tuned_variables(),

ignore_missing_vars=True) # 定义保存新模型的Saver。

saver = tf.train.Saver() with tf.Session() as sess:

# 初始化没有加载进来的变量。

init = tf.global_variables_initializer()

sess.run(init) # 加载谷歌已经训练好的模型。

print('Loading tuned variables from %s' % CKPT_FILE)

load_fn(sess) start = 0

end = BATCH

for i in range(STEPS):

_, loss = sess.run([train_step, total_loss], feed_dict={

images: training_images[start:end],

labels: training_labels[start:end]}) if i % 30 == 0 or i + 1 == STEPS:

saver.save(sess, TRAIN_FILE, global_step=i) validation_accuracy = sess.run(evaluation_step, feed_dict={

images: validation_images, labels: validation_labels})

print('Step %d: Training loss is %.1f Validation accuracy = %.1f%%' % (

i, loss, validation_accuracy * 100.0)) start = end

if start == n_training_example:

start = 0 end = start + BATCH

if end > n_training_example:

end = n_training_example # 在最后的测试数据上测试正确率。

test_accuracy = sess.run(evaluation_step, feed_dict={

images: testing_images, labels: testing_labels})

print('Final test accuracy = %.1f%%' % (test_accuracy * 100))

吴裕雄--天生自然python Google深度学习框架:Tensorflow实现迁移学习的更多相关文章

- 吴裕雄--天生自然python Google深度学习框架:经典卷积神经网络模型

import tensorflow as tf INPUT_NODE = 784 OUTPUT_NODE = 10 IMAGE_SIZE = 28 NUM_CHANNELS = 1 NUM_LABEL ...

- 吴裕雄--天生自然python Google深度学习框架:图像识别与卷积神经网络

- 吴裕雄--天生自然python Google深度学习框架:MNIST数字识别问题

import tensorflow as tf from tensorflow.examples.tutorials.mnist import input_data INPUT_NODE = 784 ...

- 吴裕雄--天生自然python Google深度学习框架:深度学习与深层神经网络

- 吴裕雄--天生自然python Google深度学习框架:TensorFlow实现神经网络

http://playground.tensorflow.org/

- 吴裕雄--天生自然python Google深度学习框架:Tensorflow基础应用

import tensorflow as tf a = tf.constant([1.0, 2.0], name="a") b = tf.constant([2.0, 3.0], ...

- 吴裕雄--天生自然python Google深度学习框架:人工智能、深度学习与机器学习相互关系介绍

- 吴裕雄--天生自然神经网络与深度学习实战Python+Keras+TensorFlow:Bellman函数、贪心算法与增强性学习网络开发实践

!pip install gym import random import numpy as np import matplotlib.pyplot as plt from keras.layers ...

- 吴裕雄--天生自然神经网络与深度学习实战Python+Keras+TensorFlow:使用TensorFlow和Keras开发高级自然语言处理系统——LSTM网络原理以及使用LSTM实现人机问答系统

!mkdir '/content/gdrive/My Drive/conversation' ''' 将文本句子分解成单词,并构建词库 ''' path = '/content/gdrive/My D ...

随机推荐

- WebFlux系列(十二)MongoDB应用,新增、修改、查询、删除

#Java#Spring#SpringBoot#Mongo#reactor#webflux#数据库#新增#修改#查询#删除# Spring Boot WebFlux Mongo数据库新增.删除.查询. ...

- 使用文件流创建File文件和目录以及其他的一些操作

我们创建文件时可以直接通过File f=new File(path)来创建一个文件对象,然后再通过 f.createNewFile() 就创建出来了一个文件.比如设置 path 为 C:\Users\ ...

- Python String startswith() Method

一,摘自官方API https://docs.python.org/3/library/stdtypes.html#methods str.startswith(prefix[, start[, e ...

- codeigniter框架开发技巧

codeigniter框架开发技巧 来源:未知 时间:2014-10-20 11:36 阅读数:171 作者:xbdadmin [导读] (1)自动加载modelsphp5风格 使用这个 ...

- Redis 在NETCore中的应用

Redis 在NETCore中的应用 Redis 在netFramework中的应用 也一样 新建.NETCORE(webapi)项目 安装NuGet //查询NuGet语句 Find-Packag ...

- 简单模拟B1001

#include<iostream> using namespace std; int main() { int n; ; cin >> n; ) { == ) { n = ( ...

- [极客大挑战 2019]LoveSQL

0x00 知识点 1:万能密码登陆 2:登陆后直接使用联合查询注入 0x01解题 登陆后进行简单测试发现是字符型注入 order by 测试数据库有多少字段 发现在4的时候报错,没有过滤,直接进行注入 ...

- this深度面试题2

var name = "windows" var object = { name:"object", show:function(){ return funct ...

- mysql数据库大规模数据读写并行时导致的锁表问题

问题介绍 最近在给学校做的一个项目中,有一个功能涉及到考核分数问题. 我当时一想,这个问题并不是很难,于是就直接采用了这样的方法:拿着一个表中的数据作为索引,去挨个遍历相关表中的数据,最后经过算分的过 ...

- 洛谷 P1731 [NOI1999]生日蛋糕 && POJ 1190 生日蛋糕

题目传送门(洛谷) OR 题目传送门(POJ) 解题思路: 一道搜索题,暴力思路比较容易想出来,但是这道题不剪枝肯定会TLE.所以这道题难点在于如何剪枝. 1.如果当前状态答案已经比我们以前某个状态 ...