CS231n 2016 通关 第四章-反向传播与神经网络(第一部分)

在上次的分享中,介绍了模型建立与使用梯度下降法优化参数、梯度校验,以及一些超参数的经验。

本节课的主要内容:

1==链式法则

2==深度学习框架中链式法则

3==全连接神经网络

=========================================================================================

1、链式法则

目前我们所处的阶段:

学习了SVM softmax两个模型或者算法,需要优化w》》梯度下降。

上述公式的计算图例:

由上述计算图可见,模型非常简洁,可以使用计算偏导的方式来优化参数,但是当模型非常大时,比如:

此时直接求偏导的方法不可行。

解决方法》》链式法则。

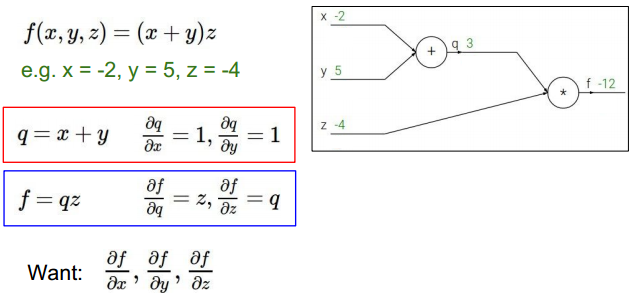

举例:

对具体函数用链式法则求导。首先进行前向计算。如上图。

求f对中间变量偏导:

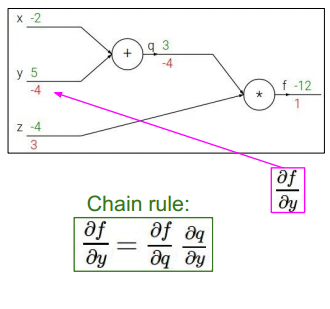

求中间变量对初始变量的偏导,结合之前计算,得到f对初始变量的偏导》》链式法则

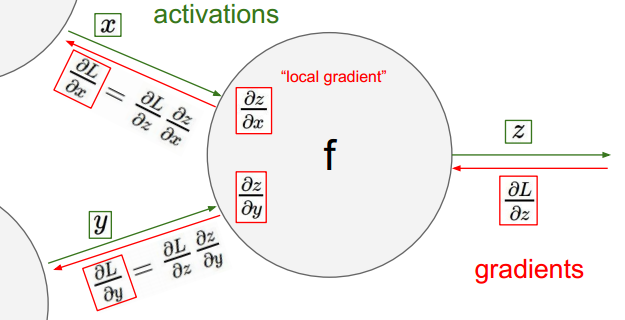

链式法则解释:

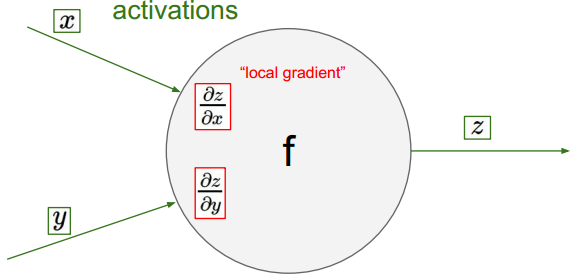

单一结点,输出值对输入变量的偏导:

计算此结点与下一节点,联合对输入变量的偏导:

多节点:

上述即为链式法则的过程。

实际例子:

可视化流程如上,其中已经实现了前向计算。

反向传播,首先计算最后节点:

倒数第二个节点:

按照上述方法,逐一反向计算:

达到分支时:

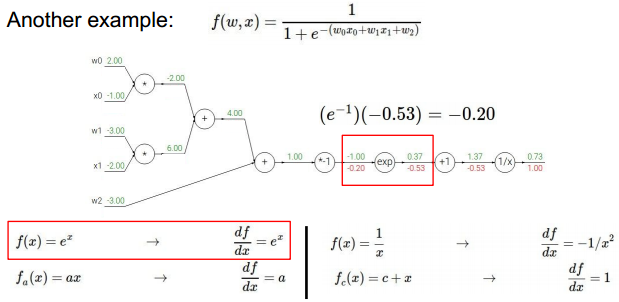

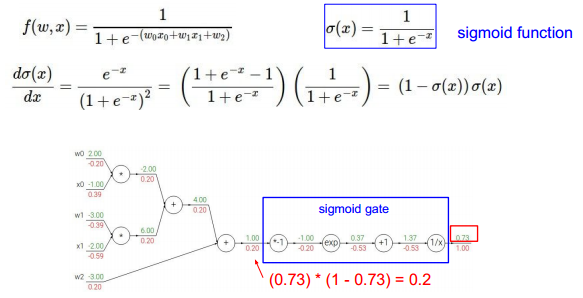

可以对某些步骤进行简化》》直接对某个表达式整体求导:

各种计算的链式计算以及代码结构:

加法:

乘法:

深度学习框架实现:

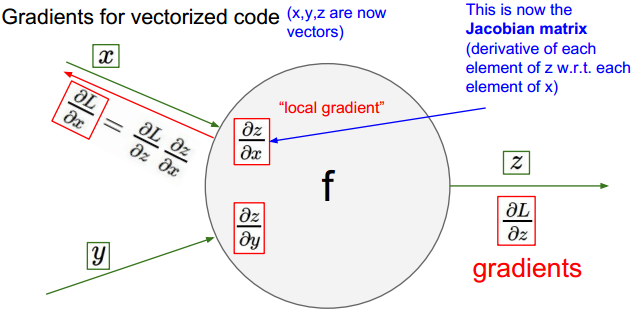

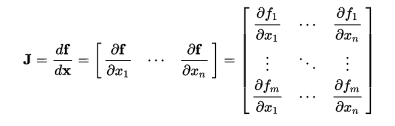

向量形式的链式法则:

向量形式链式法则举例:

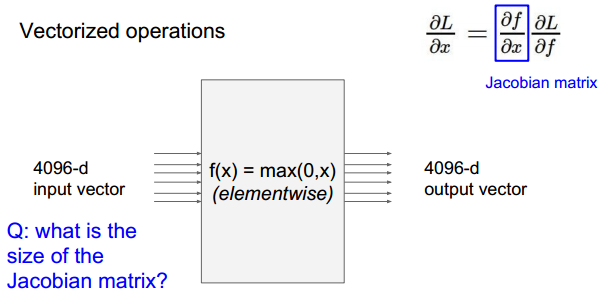

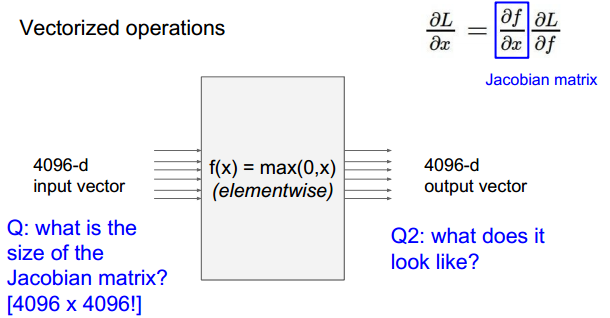

问题:

问题:

此时的输出如f1只与x1相关,所以对应的雅克比行列式只有在对角线上有值,为0或者1.其余元素均为0.

由此可见,计算雅克比矩阵的方式不是很简洁。

总结:

=========================================================================================

2、神经网络 Neural Network

两层NN与线性函数对比:

之前的分类器得到的可视化:

可视化的结果显示,模型将某一类的特征训练调整到单一的w(向量或矩阵),此时的w混合了很多特点,比如颜色、形状。

而NN包含了很多隐藏层,隐藏层的某个节点对应相应的某个特征,比如颜色,方向等等。将隐藏层节点得到的特征抽象到输出,可以得出结果。

两层隐藏层:

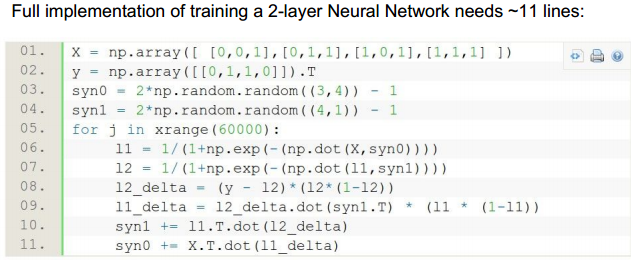

代码实现:

其实就是层的叠加。

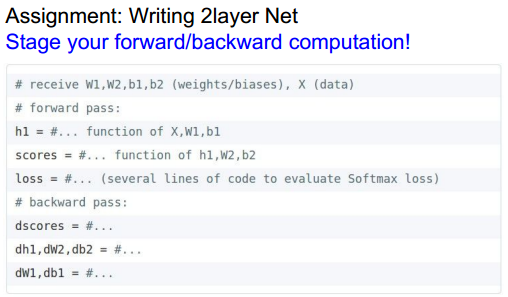

前向、反向传播代码结构:

具体细节在下一节课会涉及。

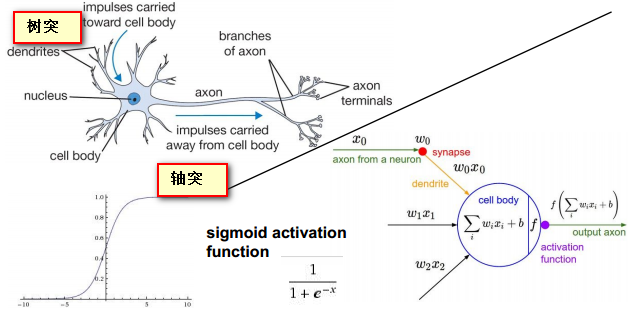

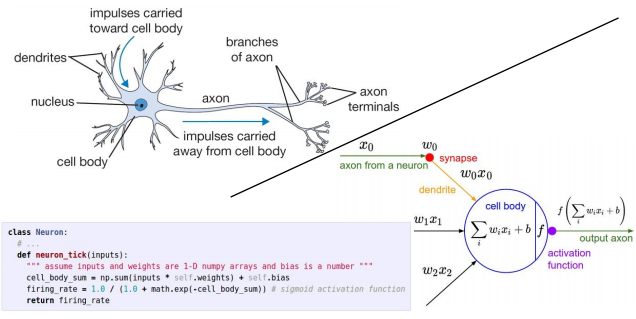

NN的生物学知识:

使用sigmoid作为激活函数。

神经系统中的树突如输入层到隐藏层节点的连接。轴突相当于隐藏层节点的输出与其他节点的连接。

代码实现(结构):

一些区别:

生物神经系统功能更复杂。

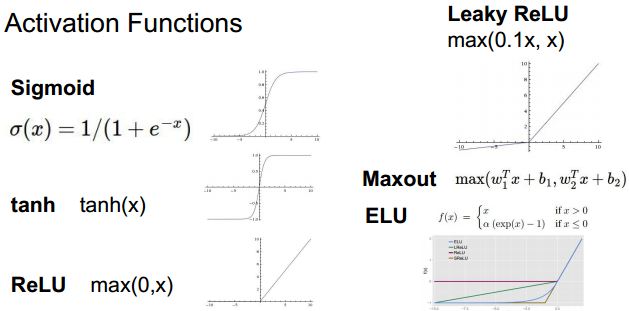

常用的激活函数:

根据模型特点以及计算的效果,选择不同的激活函数。其中ReLU、Maxout比较常用。

各个激活函数的特点在课程配套的笔记中有详细说明。之后会把总结好的笔记扫描、分享出来。

NN层数:

下图以2 3层网络为例,层数不计输入层,注意与UFLDL进行对比,UFLDL中计入了输入层:

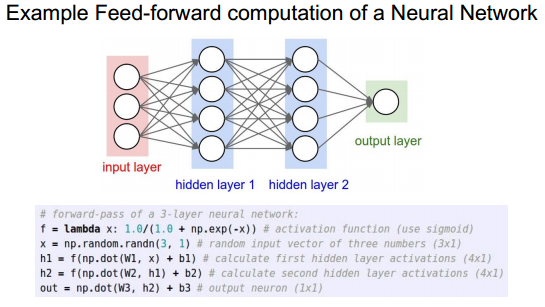

前向传播代码结构:

前向传播实例:

关于NN的层数:

NN可以视为对飞线性函数的逼近》》证明可以逼近任何函数。

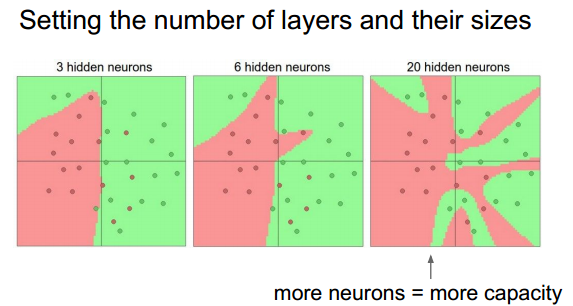

由上图可见,NN层数不同,分类的准确率也有差异,一般选取3层或以上的层数,并加入正则的方式。

当高于3层时,层数的增加并不能很好的改善最终的结果,甚至会产生过拟合。

cnn中层数较高表示抽象能力更强,希望较高的层数。

正则化强度对结果的影响:

可以通过选择合适的正则化强度系数控制过拟合结果。上图中看出较高的正则化强度系数使得分类界面更平滑。

=========================================================================================

总结:

下节课的内容:

附:通关CS231n企鹅群:578975100 validation:DL-CS231n

CS231n 2016 通关 第四章-反向传播与神经网络(第一部分)的更多相关文章

- CS231n 2016 通关 第四章-NN 作业

cell 1 显示设置初始化 # A bit of setup import numpy as np import matplotlib.pyplot as plt from cs231n.class ...

- CS231n 2016 通关 第五章 Training NN Part1

在上一次总结中,总结了NN的基本结构. 接下来的几次课,对一些具体细节进行讲解. 比如激活函数.参数初始化.参数更新等等. ====================================== ...

- Cs231n课堂内容记录-Lecture 4-Part1 反向传播及神经网络

反向传播 课程内容记录:https://zhuanlan.zhihu.com/p/21407711?refer=intelligentunit 雅克比矩阵(Jacobian matrix) 参见ht ...

- CS231n 2016 通关 第六章 Training NN Part2

本章节讲解 参数更新 dropout ================================================================================= ...

- CS231n 2016 通关 第三章-SVM与Softmax

1===本节课对应视频内容的第三讲,对应PPT是Lecture3 2===本节课的收获 ===熟悉SVM及其多分类问题 ===熟悉softmax分类问题 ===了解优化思想 由上节课即KNN的分析步骤 ...

- CS231n 2016 通关 第三章-Softmax 作业

在完成SVM作业的基础上,Softmax的作业相对比较轻松. 完成本作业需要熟悉与掌握的知识: cell 1 设置绘图默认参数 mport random import numpy as np from ...

- CS231n 2016 通关 第三章-SVM 作业分析

作业内容,完成作业便可熟悉如下内容: cell 1 设置绘图默认参数 # Run some setup code for this notebook. import random import nu ...

- 第四章 跨平台图像显示库——SDL 第一节 与SDL第一次亲密接触

http://blog.csdn.net/visioncat/article/details/1596576 GCC for Win32 开发环境介绍(5) 第四章 跨平台图像显示库——SDL 第一节 ...

- CS231n 2016 通关 第五、六章 Dropout 作业

Dropout的作用: cell 1 - cell 2 依旧 cell 3 Dropout层的前向传播 核心代码: train 时: if mode == 'train': ############ ...

随机推荐

- DataGridView.DataSource= list(Of T)

注:本文样例的代码承接上篇文章:DataTable填充实体类返回泛型集合. 在D层查询完毕之后.我们将DataTable转化为泛型集合.然后经过中间各层,返回U层.到了这里,问题来了.我们这时候要将这 ...

- shell(2):正则表达式

一.整理正则表达式博客 (1)正则 正则就是用一些具有特殊含义的符号组合到一起(称为正则表达式)来描述字符或者字符串的方法.或者说:正则就是用来描述一类事物的规则. 在linux中,通配符是由shel ...

- C# 利用ICSharpCode.SharpZipLib实现在线加密压缩和解密解压缩 C# 文件压缩加解密

C# 利用ICSharpCode.SharpZipLib实现在线加密压缩和解密解压缩 这里我们选用ICSharpCode.SharpZipLib这个类库来实现我们的需求. 下载地址:http:// ...

- JS中Float类型加减乘除 修复 JQ 操作 radio、checkbox 、select LINQ to SQL:Where、Select/Distinct LINQ to SQL Count/Sum/Min/Max/Avg Join

JS中Float类型加减乘除 修复 MXS&Vincene ─╄OvЁ &0000027─╄OvЁ MXS&Vincene MXS&Vincene ─╄Ov ...

- Allegro基本操作——PCB布线

转:http://blog.sina.com.cn/s/blog_1538bc9470102vyyq.html http://www.elecfans.com/article/80/110/2010/ ...

- python--面向对象封装

from collectoins import namedtuple Point=namedtuple('point',['x','y']) t1=Point(1,2) print(t1.x) pri ...

- python--函数程序分析

写函数,用户传入修改的文件名,与要修改的内容,执行函数,完成整个文件的批量修改操作 import os #加载模块 def xiu(a,b,c): #三个接受值的形参 f = open(a,encod ...

- YARN和MapReduce的内存设置參考

怎样确定Yarn中容器Container,Mapreduce相关參数的内存设置,对于初始集群,由于不知道集群的类型(如cpu密集.内存密集)我们须要依据经验提供给我们一个參考配置值,来作为基础的配置. ...

- 两个经典的文件IO程序示例

前言 本文分析两个经典的C++文件IO程序,提炼出其中文件IO的基本套路,留待日后查阅. 程序功能 程序一打印用户指定的所有文本文件,程序二向用户指定的所有文本文件中写入数据. 程序一代码及其注释 # ...

- hdu5261单调队列

题意特难懂,我看了好多遍,最后还是看讨论版里别人的问答,才搞明白题意,真是汗. 其实题目等价于给n个点,这n个点均匀分布在一个圆上(知道圆半径),点与点之间的路程(弧长)已知,点是有权值的,已知,点与 ...