Python爬虫和函数调试

一:函数调试

用之前学过的try···except进行调试

def gameover(setA,setB):

if setA==3 or setB==3:

return True

else:

return False

try:

a=gameover(7,11)

print(a)

except:

print("Error")

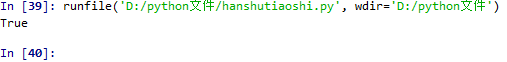

调试完毕~~~~

结果如下

输入7,8的结果

输入3,4的结果

不输入参数时,得到Error

二:Python爬虫

requests库是一个简洁且简单的处理HTTP请求的第三方库。

get()是对应与HTTP的GET方式,获取网页的最常用方法,可以增加timeout=n 参数,设定每次请求超时时间为n秒

text()是HTTP相应内容的字符串形式,即url对应的网页内容

content()是HTTP相应内容的二进制形式

用requests()打开搜狗主页20次

# -*- coding: utf-8 -*-

"""

Created on Mon May 20 10:20:45 2019 @author: guo'yu'yi

"""

import requests

try:

for i in range(20):

r=get("https://123.sogou.com/")

r.raise_for_status()

r.encoding='utf-8'

print(r)

print(len(r.text))

print(len(r.content))

except:

print("Error")

结果如下:

获取中国大学排名

直接上代码

import requests

from bs4 import BeautifulSoup

import pandas

# 1. 获取网页内容

def getHTMLText(url):

try:

r = requests.get(url, timeout = 30)

r.raise_for_status()

r.encoding = 'utf-8'

return r.text

except Exception as e:

print("Error:", e)

return "" # 2. 分析网页内容并提取有用数据

def fillTabelList(soup): # 获取表格的数据

tabel_list = [] # 存储整个表格数据

Tr = soup.find_all('tr')

for tr in Tr:

Td = tr.find_all('td')

if len(Td) == 0:

continue

tr_list = [] # 存储一行的数据

for td in Td:

tr_list.append(td.string)

tabel_list.append(tr_list)

return tabel_list # 3. 可视化展示数据

def PrintTableList(tabel_list, num):

# 输出前num行数据

print("{1:^2}{2:{0}^10}{3:{0}^5}{4:{0}^5}{5:{0}^8}".format(chr(12288), "排名", "学校名称", "省市", "总分", "生涯质量"))

for i in range(num):

text = tabel_list[i]

print("{1:{0}^2}{2:{0}^10}{3:{0}^5}{4:{0}^8}{5:{0}^10}".format(chr(12288), *text)) # 4. 将数据存储为csv文件

def saveAsCsv(filename, tabel_list):

FormData = pandas.DataFrame(tabel_list)

FormData.columns = ["排名", "学校名称", "省市", "总分", "生涯质量", "培养结果", "科研规模", "科研质量", "顶尖成果", "顶尖人才", "科技服务", "产学研合作", "成果转化"]

FormData.to_csv(filename, encoding='utf-8', index=False) if __name__ == "__main__":

url = "http://www.zuihaodaxue.cn/zuihaodaxuepaiming2016.html"

html = getHTMLText(url)

soup = BeautifulSoup(html, features="html.parser")

data = fillTabelList(soup)

#print(data)

PrintTableList(data, 10) # 输出前10行数据

saveAsCsv("D:\\python文件\\daxuepaimingRank.csv", data)

Python爬虫和函数调试的更多相关文章

- python爬虫基础18-Chrome调试前端工具

01 Chrome调试 抓包工具原理 Chrome 开发者工具是一套内置在Google Chrome中Web开发和调试工具.使用开发者工具来重演,调试和剖析您的网站. 其中常用的有Elements(元 ...

- python 爬虫可视化函数,可以先看看要爬取的数据是否存在

import requests url = "http://www.spbeen.com" headers = { "User-Agent":"tes ...

- Python爬虫:新浪新闻详情页的数据抓取(函数版)

上一篇文章<Python爬虫:抓取新浪新闻数据>详细解说了如何抓取新浪新闻详情页的相关数据,但代码的构建不利于后续扩展,每次抓取新的详情页时都需要重新写一遍,因此,我们需要将其整理成函数, ...

- Python帮助函数调试函数 用于获取对象的属性及属性值

Python帮助函数调试函数 用于获取对象的属性及属性值 刚接触Python,上篇 <Python入门>第一个Python Web程序--简单的Web服务器 中调试非常不方便,不知道对象详 ...

- python爬虫利器Selenium使用详解

简介: 用pyhon爬取动态页面时普通的urllib2无法实现,例如下面的京东首页,随着滚动条的下拉会加载新的内容,而urllib2就无法抓取这些内容,此时就需要今天的主角selenium. Sele ...

- Python爬虫:用BeautifulSoup进行NBA数据爬取

爬虫主要就是要过滤掉网页中没用的信息.抓取网页中实用的信息 一般的爬虫架构为: 在python爬虫之前先要对网页的结构知识有一定的了解.如网页的标签,网页的语言等知识,推荐去W3School: W3s ...

- [转]Python爬虫框架--pyspider初体验

标签: python爬虫pyspider 2015-09-05 10:57 9752人阅读 评论(0) 收藏 举报 分类: Python(8) 版权声明:本文为博主原创文章,未经博主允许不得转载. ...

- python爬虫 - Urllib库及cookie的使用

http://blog.csdn.net/pipisorry/article/details/47905781 lz提示一点,python3中urllib包括了py2中的urllib+urllib2. ...

- python爬虫积累(一)--------selenium+python+PhantomJS的使用(转)

阅读目录 一.Selenium介绍 二.爬虫为什么要用selenium? 三.PhantomJS介绍 四.PhantomJS安装 五.操作实战 六.在此推荐虫师博客的学习资料 selenium + p ...

随机推荐

- Antd cracoTs Js 配置流程

JS:文档:0.1.4 配置 js 环境.note链接:http://note.youdao.com/noteshare?id=e32fa75c1baa014b5819fa5e22887dbc& ...

- Vue源码分析之数据驱动

响应式特点 数据响应式 修改数据时,视图自动更新,避免繁琐Dom操作,提高开发效率 双向绑定 数据改变,视图随之改变.视图改变,数据随之改变 数据驱动 开发时仅需要关注数据本身,不需要关心数据如何渲染 ...

- Dubbo直连方式

目录 一.dubbo概述 1. 基本架构 2. dubbo 支持的协议 二.直连方法 三.创建服务提供者 1. 思路 1. 创建maven web 2. pom.xml 3. 创建实体 4. 创建服务 ...

- Spring Security拦截器加载流程分析--练气中期

写在前面 上回我们讲了spring security整合spring springmvc的流程,并且知道了spring security是通过过滤器链来进行认证授权操作的.今天我们来分析一下sprin ...

- 解Bug之路-dubbo应用无法重连zookeeper

前言 dubbo是一个成熟且被广泛运用的框架.饶是如此,在某些极端条件下基于dubbo的应用还会出现无法重连zookeeper的问题.由于此问题容易导致比较大的故障,所以笔者费了一番功夫去定位,现将排 ...

- h5c3

HTML5 第一天 一.什么是 HTML5 HTML5 的概念与定义 定义:HTML5 定义了 HTML 标准的最新版本,是对 HTML 的第五次重大修改,号称下一代的 HTML 两个概念: 是一个新 ...

- python+opencv 打开网络摄像头

python+opencv 打开网络摄像头(手机)(转) #以下是最常用的读取视频流的方法import cv2url = 'rtsp://admin:admin@192.169.5.2:554/'#根 ...

- 2020,最新APP重构:网络请求框架

在现在的app,网络请求是一个很重要的部分,app中很多部分都有或多或少的网络请求,所以在一个项目重构时,我会选择网络请求框架作为我重构的起点.在这篇文章中我所提出的架构,并不是所谓的 最好 的网络请 ...

- USB Key

随着互联网和电子商务的发展,USB Key作为网络用户身份识别和数据保护的“电子钥匙”,正在被越来越多的用户所认识和使用.本文对USB Key的产生和未来的发展趋势作了一个简单的介绍. 目前市场上见到 ...

- 盒子上下滚动到js 底部触发的事件

//html是用法举列子,js亲测有效(把这段js#scro加到你要滚动的盒子) <div id="scro"> <div>1</div> & ...