Java HashMap中在resize()时候的rehash,即再哈希法的理解

HashMap的扩容机制---resize()

虽然在hashmap的原理里面有这段,但是这个单独拿出来讲rehash或者resize()也是极好的。

什么时候扩容:当向容器添加元素的时候,会判断当前容器的元素个数,如果大于等于阈值(知道这个阈字怎么念吗?不念fa值,念yu值四声)---即当前数组的长度乘以加载因子的值的时候,就要自动扩容啦。

扩容(resize)就是重新计算容量,向HashMap对象里不停的添加元素,而HashMap对象内部的数组无法装载更多的元素时,对象就需要扩大数组的长度,以便能装入更多的元素。当然Java里的数组是无法自动扩容的,方法是使用一个新的数组代替已有的容量小的数组,就像我们用一个小桶装水,如果想装更多的水,就得换大水桶。

先看一下什么时候,resize();

/**

* HashMap 添加节点

*

* @param hash 当前key生成的hashcode

* @param key 要添加到 HashMap 的key

* @param value 要添加到 HashMap 的value

* @param bucketIndex 桶,也就是这个要添加 HashMap 里的这个数据对应到数组的位置下标

*/

void addEntry(int hash, K key, V value, int bucketIndex) {

//size:The number of key-value mappings contained in this map.

//threshold:The next size value at which to resize (capacity * load factor)

//数组扩容条件:1.已经存在的key-value mappings的个数大于等于阈值

// 2.底层数组的bucketIndex坐标处不等于null

if ((size >= threshold) && (null != table[bucketIndex])) {

resize(2 * table.length);//扩容之后,数组长度变了

hash = (null != key) ? hash(key) : 0;//为什么要再次计算一下hash值呢?

bucketIndex = indexFor(hash, table.length);//扩容之后,数组长度变了,在数组的下标跟数组长度有关,得重算。

}

createEntry(hash, key, value, bucketIndex);

} /**

* 这地方就是链表出现的地方,有2种情况

* 1,原来的桶bucketIndex处是没值的,那么就不会有链表出来啦

* 2,原来这地方有值,那么根据Entry的构造函数,把新传进来的key-value mapping放在数组上,原来的就挂在这个新来的next属性上了

*/

void createEntry(int hash, K key, V value, int bucketIndex) {

HashMap.Entry<K, V> e = table[bucketIndex];

table[bucketIndex] = new HashMap.Entry<>(hash, key, value, e);

size++;

}

我们分析下resize的源码,鉴于JDK1.8融入了红黑树,较复杂,为了便于理解我们仍然使用JDK1.7的代码,好理解一些,本质上区别不大,具体区别后文再说。

void resize(int newCapacity) { //传入新的容量

Entry[] oldTable = table; //引用扩容前的Entry数组

int oldCapacity = oldTable.length;

if (oldCapacity == MAXIMUM_CAPACITY) { //扩容前的数组大小如果已经达到最大(2^30)了

threshold = Integer.MAX_VALUE; //修改阈值为int的最大值(2^31-1),这样以后就不会扩容了

return;

}

Entry[] newTable = new Entry[newCapacity]; //初始化一个新的Entry数组

transfer(newTable); //!!将数据转移到新的Entry数组里

table = newTable; //HashMap的table属性引用新的Entry数组

threshold = (int) (newCapacity * loadFactor);//修改阈值

}

这里就是使用一个容量更大的数组来代替已有的容量小的数组,transfer()方法将原有Entry数组的元素拷贝到新的Entry数组里。

void transfer(Entry[] newTable) {

Entry[] src = table; //src引用了旧的Entry数组

int newCapacity = newTable.length;

for (int j = 0; j < src.length; j++) { //遍历旧的Entry数组

Entry<K, V> e = src[j]; //取得旧Entry数组的每个元素

if (e != null) {

src[j] = null;//释放旧Entry数组的对象引用(for循环后,旧的Entry数组不再引用任何对象)

do {

Entry<K, V> next = e.next;

int i = indexFor(e.hash, newCapacity); //!!重新计算每个元素在数组中的位置

e.next = newTable[i]; //标记[1]

newTable[i] = e; //将元素放在数组上

e = next; //访问下一个Entry链上的元素

} while (e != null);

}

}

}

static int indexFor(int h, int length) {

return h & (length - 1);

}

文章中间部分:四、存储实现;详细解释了为什么indexFor方法中要h & (length-1)

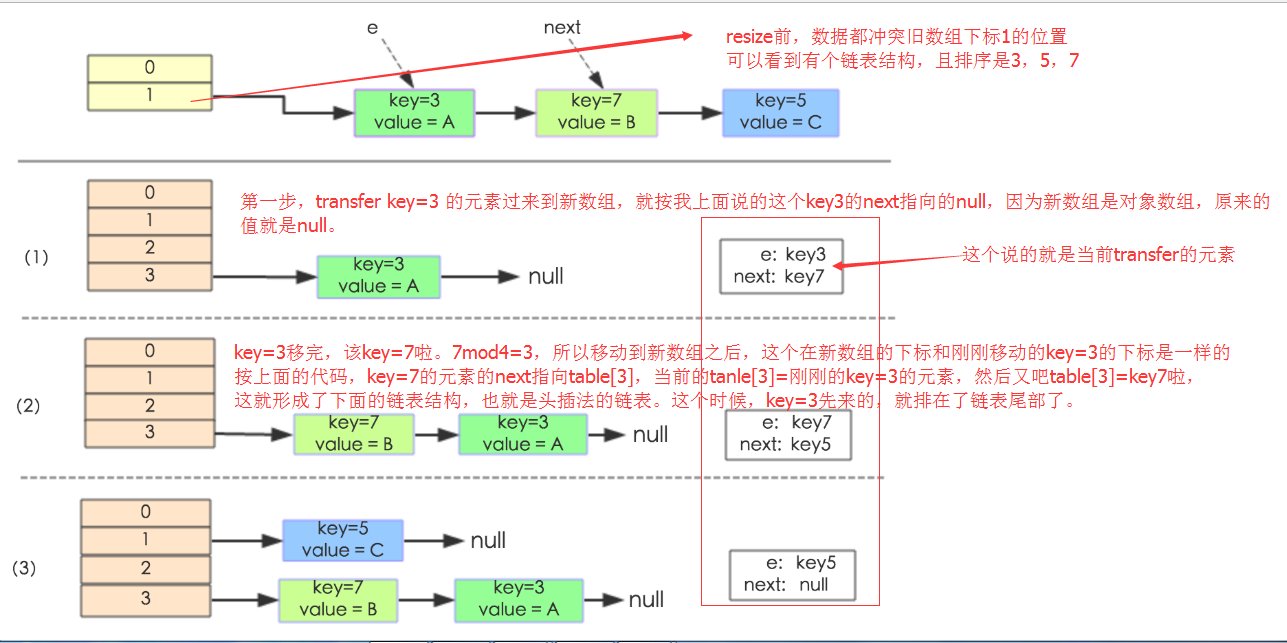

newTable[i]的引用赋给了e.next,也就是使用了单链表的头插入方式,同一位置上新元素总会被放在链表的头部位置;这样先放在一个索引上的元素终会被放到Entry链的尾部(如果发生了hash冲突的话),这一点和Jdk1.8有区别,下文详解。在旧数组中同一条Entry链上的元素,通过重新计算索引位置后,有可能被放到了新数组的不同位置上。

从上面的for循环内部开始说起吧:详细解释下,这个转存的过程。和怎么个头插入法.

Entry<K, V> e = src[j];

这句话,就把原来数组上的那个链表的引用就给接手了,所以下面src[j] = null;可以放心大胆的置空,释放空间。告诉gc这个地方可以回收啦。

继续到do while 循环里面,

Entry<K, V> next = e.next;

int i = indexFor(e.hash, newCapacity);计算出元素在新数组中的位置

下面就是单链表的头插入方式转存元素啦

关于这个 单链表的头插入方式 的理解,我多说两句。

这地方我再看的时候,就有点蒙了,他到底怎么在插到新的数组里面的?

要是在插入新数组的时候,也出现了一个数组下标的位置处,出现了多个节点的话,那又是怎么插入的呢?

1,假设现在刚刚插入到新数组上,因为是对象数组,数组都是要默认有初始值的,那么这个数组的初始值都是null。不信的可以新建个Javabean数组测试下。

那么e.next = newTable[i],也就是e.next = null啦。然后再newTable[i] = e;也就是 说这个时候,这个数组的这个下标位置的值设置成这个e啦。

2,假设这个时候,继续上面的循环,又取第二个数据e2的时候,恰好他的下标和刚刚上面的那个下标相同啦,那么这个时候,是又要有链表产生啦、

e.next = newTable[i];,假设上面第一次存的叫e1吧,那么现在e.next = newTable[i];也就是e.next = e1;

然后再,newTable[i] = e;,把这个后来的赋值在数组下标为i的位置,当然他们两个的位置是相同的啦。然后注意现在的e,我们叫e2吧。e2.next指向的是刚刚的e1,e1的next是null。

这就解释啦:先放在一个索引上的元素终会被放到Entry链的尾部。这句话。

关于什么时候resize()的说明:

看1.7的源码上说的条件是:

if ((size >= threshold) && (null != table[bucketIndex])) {。。。}

其中

size表示当前hashmap里面已经包含的元素的个数。

threshold:threshold = (int) Math.min(capacity * loadFactor, MAXIMUM_CAPACITY + 1);

一般是容量值X加载因子。

而1.8的是:

if (++size > threshold){}

其中

size:The number of key-value mappings contained in this map.和上面的是一样的

threshold:newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);

也是一样的,

最后总结一下:就是这个map里面包含的元素,也就是size的值,大于等于这个阈值的时候,才会resize();

具体到实际情况就是:假设现在阈值是4;在添加下一个假设是第5个元素的时候,这个时候的size还是原来的,还没加1,size=4,那么阈值也是4的时候,

当执行put方法,添加第5个的时候,这个时候,4 >= 4。元素个数等于阈值。就要resize()啦。添加第4的时候,还是3 >= 4不成立,不需要resize()。

经过这番解释,可以发现下面的这个例子,不应该是在添加第二个的时候resize(),而是在添加第三个的时候,才resize()的。

这个也是我后来再细看的时候,发现的。当然,这个咱可以先忽略,重点看如何resize(),以及如何将旧数据移动到新数组的

下面举个例子说明下扩容过程。

这句话是重点----hash(){return key % table.length;}方法,就是翻译下面的一行解释:

假设了我们的hash算法就是简单的用key mod 一下表的大小(也就是数组的长度)。

其中的哈希桶数组table的size=2, 所以key = 3、7、5,put顺序依次为 5、7、3。在mod 2以后都冲突在table[1]这里了。这里假设负载因子 loadFactor=1,即当键值对的实际大小size 大于 table的实际大小时进行扩容。接下来的三个步骤是哈希桶数组 resize成4,然后所有的Node重新rehash的过程。

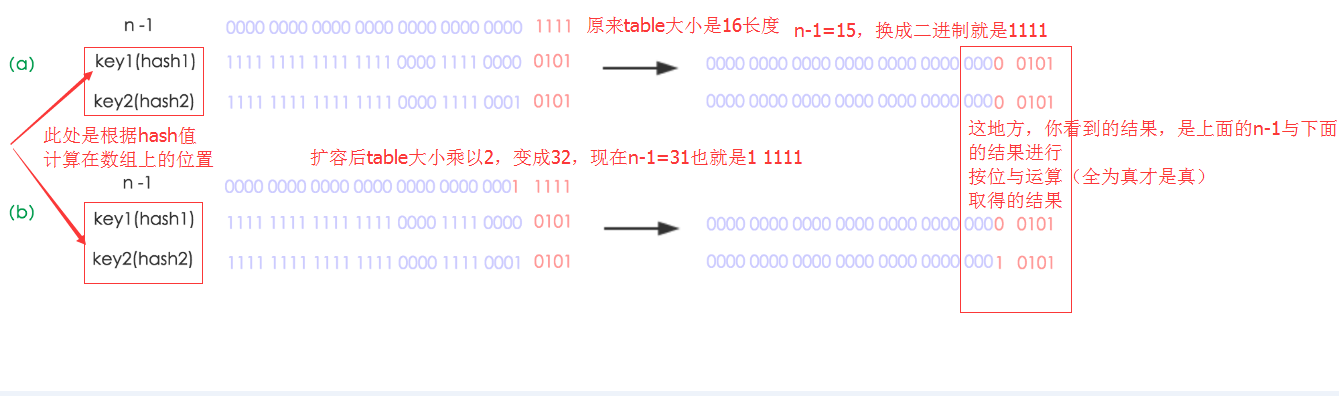

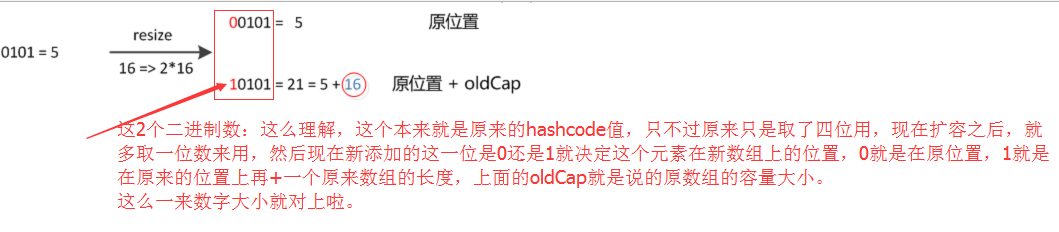

下面我们讲解下JDK1.8做了哪些优化。经过观测可以发现,我们使用的是2次幂的扩展(指长度扩为原来2倍),所以,

经过rehash之后,元素的位置要么是在原位置,要么是在原位置再移动2次幂的位置。对应的就是下方的resize的注释。

- /**

- * Initializes or doubles table size. If null, allocates in

- * accord with initial capacity target held in field threshold.

- * Otherwise, because we are using power-of-two expansion, the

- * elements from each bin must either stay at same index, or move

- * with a power of two offset in the new table.

- *

- * @return the table

- */

- final Node<K,V>[] resize() {

看下图可以明白这句话的意思,n为table的长度,图(a)表示扩容前的key1和key2两种key确定索引位置的示例,图(b)表示扩容后key1和key2两种key确定索引位置的示例,其中hash1是key1对应的哈希值(也就是根据key1算出来的hashcode值)与高位与运算的结果。

元素在重新计算hash之后,因为n变为2倍,那么n-1的mask范围在高位多1bit(红色),因此新的index就会发生这样的变化:

因此,我们在扩充HashMap的时候,不需要像JDK1.7的实现那样重新计算hash,只需要看看原来的hash值新增的那个bit是1还是0就好了,是0的话索引没变,是1的话索引变成“原索引+oldCap”,可以看看下图为16扩充为32的resize示意图:

我是 没看懂他连个图是怎么前后对应的,谁看懂了,交流哈赛。

当时上面这个图,没看懂,是因为,他就没说每个节点的hashcode是啥,他怎么确定是保留在原来的位置,还是说在原来位置的基础上再加个原来数组的长度呢。所以,上面那个图仅仅具有丁点儿参考价值。

这个设计确实非常的巧妙,既省去了重新计算hash值的时间,而且同时,由于新增的1bit是0还是1可以认为是随机的,因此resize的过程,均匀的把之前的冲突的节点分散到新的bucket了。这一块就是JDK1.8新增的优化点。有一点注意区别,JDK1.7中rehash的时候,旧链表迁移新链表的时候,如果在新表的数组索引位置相同,则链表元素会倒置,但是从上图可以看出,JDK1.8不会倒置。有兴趣的同学可以研究下JDK1.8的resize源码,写的很赞,如下:

- 1 final Node<K,V>[] resize() {

- 2 Node<K,V>[] oldTab = table;

- 3 int oldCap = (oldTab == null) ? 0 : oldTab.length;

- 4 int oldThr = threshold;

- 5 int newCap, newThr = 0;

- 6 if (oldCap > 0) {

- 7 // 超过最大值就不再扩充了,就只好随你碰撞去吧

- 8 if (oldCap >= MAXIMUM_CAPACITY) {

- 9 threshold = Integer.MAX_VALUE;

- 10 return oldTab;

- 11 }

- 12 // 没超过最大值,就扩充为原来的2倍

- 13 else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY &&

- 14 oldCap >= DEFAULT_INITIAL_CAPACITY)

- 15 newThr = oldThr << 1; // double threshold

- 16 }

- 17 else if (oldThr > 0) // initial capacity was placed in threshold

- 18 newCap = oldThr;

- 19 else { // zero initial threshold signifies using defaults

- 20 newCap = DEFAULT_INITIAL_CAPACITY;

- 21 newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);

- 22 }

- 23 // 计算新的resize上限

- 24 if (newThr == 0) {

- 25

- 26 float ft = (float)newCap * loadFactor;

- 27 newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ?

- 28 (int)ft : Integer.MAX_VALUE);

- 29 }

- 30 threshold = newThr;

- 31 @SuppressWarnings({"rawtypes","unchecked"})

- 32 Node<K,V>[] newTab = (Node<K,V>[])new Node[newCap];

- 33 table = newTab;

- 34 if (oldTab != null) {

- 35 // 把每个bucket都移动到新的buckets中

- 36 for (int j = 0; j < oldCap; ++j) {

- 37 Node<K,V> e;

- 38 if ((e = oldTab[j]) != null) {

- 39 oldTab[j] = null;

- 40 if (e.next == null)

- 41 newTab[e.hash & (newCap - 1)] = e;

- 42 else if (e instanceof TreeNode)

- 43 ((TreeNode<K,V>)e).split(this, newTab, j, oldCap);

- 44 else { // 链表优化重hash的代码块

- 45 Node<K,V> loHead = null, loTail = null;

- 46 Node<K,V> hiHead = null, hiTail = null;

- 47 Node<K,V> next;

- 48 do {

- 49 next = e.next;

- 50 // 原索引

- 51 if ((e.hash & oldCap) == 0) {

- 52 if (loTail == null)

- 53 loHead = e;

- 54 else

- 55 loTail.next = e;

- 56 loTail = e;

- 57 }

- 58 // 原索引+oldCap

- 59 else {

- 60 if (hiTail == null)

- 61 hiHead = e;

- 62 else

- 63 hiTail.next = e;

- 64 hiTail = e;

- 65 }

- 66 } while ((e = next) != null);

- 67 // 原索引放到bucket里

- 68 if (loTail != null) {

- 69 loTail.next = null;

- 70 newTab[j] = loHead;

- 71 }

- 72 // 原索引+oldCap放到bucket里

- 73 if (hiTail != null) {

- 74 hiTail.next = null;

- 75 newTab[j + oldCap] = hiHead;

- 76 }

- 77 }

- 78 }

- 79 }

- 80 }

- 81 return newTab;

- 82 }

Java HashMap中在resize()时候的rehash,即再哈希法的理解的更多相关文章

- HashMap中的resize以及死链的情况

之前我已经写过关于HashMap的内容了:http://www.cnblogs.com/wang-meng/p/7545725.html 我们都知道HashMap是线程不安全的, 如果多线程来访问会有 ...

- java HashMap中出现反复的key, 求解释

上代码: Person p1 = new Person("xiaoer",1); Person p2 = new Person("san",4); Map< ...

- 【java基础 12】HashMap中是如何形成环形链表的?

导读:经过前面的博客总结,可以知道的是,HashMap是有一个一维数组和一个链表组成,从而得知,在解决冲突问题时,hashmap选择的是链地址法.为什么HashMap会用一个数组这链表组成,当时给出的 ...

- java jdk 中HashMap的源码解读

HashMap是我们在日常写代码时最常用到的一个数据结构,它为我们提供key-value形式的数据存储.同时,它的查询,插入效率都非常高. 在之前的排序算法总结里面里,我大致学习了HashMap的实现 ...

- [改善Java代码]减少HashMap中元素的数量

在系统开发中我们经常会使用HashMap作为数据集容器,或者是用缓冲池来处理,一般很稳定,但偶尔也会出现内存溢出的问题(OutOfMemory错误),而且这经常是与HashMap有关的.而且这经常是与 ...

- HashMap中的散列函数、冲突解决机制和rehash

一.概述 散列算法有两个主要的实现方式:开散列和闭散列,HashMap采用开散列实现. HashMap中,键值对(key-value)在内部是以Entry(HashMap中的静态内部类)实例的方式存储 ...

- Java集合中的HashMap类

jdk1.8.0_144 HashMap作为最常用集合之一,继承自AbstractMap.JDK8的HashMap实现与JDK7不同,新增了红黑树作为底层数据结构,结构变得复杂,效率变得更高.为满足自 ...

- Java 7 和 Java 8 中的 HashMap原理解析

HashMap 可能是面试的时候必问的题目了,面试官为什么都偏爱拿这个问应聘者?因为 HashMap 它的设计结构和原理比较有意思,它既可以考初学者对 Java 集合的了解又可以深度的发现应聘者的数据 ...

- Java基础:HashMap中putAll方法的疑惑

最近回顾了下HashMap的源码(JDK1.7),当读到putAll方法时,发现了之前写的TODO标记,当时由于时间匆忙没来得及深究,现在回顾到了就再仔细思考了下 @Override public v ...

随机推荐

- Linux下使用xargs得到字符串作为参数进行输出、awk得到字符串作为参数进行输出

背景: cat test.txt 实例: 1.xargs cat test.txt | xargs -i echo {} cat test.txt | xargs -I {} echo {} 大小写i ...

- Social regularizations

trust-aware :如何从隐式信任中导出显示信任.链接预测就是搞这一方面的么? 和类似谱聚类的拉普拉斯矩阵结合在一起,没怎么看.

- WebLogic Server 多租户资源迁移

重新建立一个动态集群,并启动,注意监听地址不能和其他集群重合 选择相应的资源组进行迁移, 迁移后,访问新的地址成功. 通过OTD负载均衡器访问原有的地址成功. 直接访问原来后台地址失败,表示资源确实已 ...

- iOS:二维码的生成

所谓的二维码就是一个图片,只不过在iOS需要借用<CoreImage/CoreImage.h>来实现, 并且二维码图片是通过CIImage来转成UIImage的.具体步骤如下: // 1 ...

- Oracle使用row_number()函数查询时增加序号列

使用Oracle自带的row_number()函数能够实现自动增加序号列的要求,但是同时引发一个问题,如果我们查询出来的数据需要使用Order By排序的话,那么我们会发现新增加的序号列是乱序的,它会 ...

- sqls

ALTER TABLE `shh_data`.`topic_floor` ADD COLUMN `updated_date` DATETIME NULL AFTER `publish_date`,AD ...

- android 博客列表

1. Hongyang http://blog.csdn.net/lmj623565791/article/details/37970961

- 使用InstallUtil对Windows服务进行安装与卸载

关于Visual Studio 2012中使用InstallUtil对Windows服务进行安装与卸载的文章,在MSDN中的http://msdn.microsoft.com/en-us/librar ...

- 一个简单的JS函数,用于判断文本是否数字

/****************************************************** 判断是否是数字(整数,小数均可,不包括负数)* 2014年10月10日22:38:19* ...

- DB2解锁

1.登录数据库 db2 connect to 数据库名字 user 用户名 using 密码 2.进入db2top db2top -d 数据库名 进入到如下界面: 3.按下shift+u(图中U-L ...