slf4j+logback&logback.xml

添加maven依赖

<dependencies>

<!--https://mvnrepository.com/artifact/org.slf4j/slf4j-api -->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

<version>1.7.25</version>

</dependency>

<!-- https://mvnrepository.com/artifact/ch.qos.logback/logback-classic -->

<dependency>

<groupId>ch.qos.logback</groupId>

<artifactId>logback-classic</artifactId>

<version>1.2.3</version>

</dependency>

<!-- https://mvnrepository.com/artifact/ch.qos.logback/logback-core -->

<dependency>

<groupId>ch.qos.logback</groupId>

<artifactId>logback-core</artifactId>

<version>1.2.3</version>

</dependency>

<!-- https://mvnrepository.com/artifact/ch.qos.logback/logback-access -->

<dependency>

<groupId>ch.qos.logback</groupId>

<artifactId>logback-access</artifactId>

<version>1.2.3</version>

</dependency>

</dependencies>

resources目录下配置logback.xml

<?xml version="1.0" encoding="utf-8" ?>

<configuration debug="true"> <!--设置日志上下文名称,后面输出格式中可以通过定义 %contextName 来打印日志上下文名称-->

<contextName>sk-log</contextName>

<!--用来设置相关变量,通过key-value的方式配置,然后在后面的配置文件中通过 ${key}来访问-->

<property name = "sk.name" value ="test"></property> <!--======================================ConsoleAppender===================================================================-->

<!--日志输出组件,主要负责日志的输出以及格式化日志。 stdout:标准输出-->

<appender name ="stdout" class="ch.qos.logback.core.ConsoleAppender">

<!--定义了一个过滤器,在LEVEL之下的日志输出不会被打印出来 这个和logger里的level共同决定在stdout输出的级别(filter非必需的)

临界值过滤器,过滤掉低于指定临界值的日志。当日志级别等于或高于临界值时,过滤器返回NEUTRAL;当日志级别低于临界值时,日志会被拒绝。 -->

<filter class="ch.qos.logback.classic.filter.ThresholdFilter">

<level>debug</level>

</filter>

<!--级别过滤器,根据日志级别进行过滤。如果日志级别等于配置级别,过滤器会根据onMath 和 onMismatch接收或拒绝日志

<level>:设置过滤级别

<onMatch>:用于配置符合过滤条件的操作

<onMismatch>:用于配置不符合过滤条件的操作-->

<!-- <filter class="ch.qos.logback.classic.filter.LevelFilter">-->

<!-- <level>debug</level>-->

<!-- <onMatch>ACCEPT</onMatch>-->

<!-- <onMismatch>DENY</onMismatch>-->

<!-- </filter>-->

<!-- encoder 默认配置为PatternLayoutEncoder -->

<!--定义控制台输出格式-->

<!--

%d{yyyy-MM-dd HH:mm:ss} 时间格式 hh是12h制 HH是24h制

[%thread] 线程

%-5level 级别

%logger{36} 日志包 36包长度

[%file : %line] 目标类 和 行数

%msg log信息

%n 换行

(encoder必需的)-->

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss} [%thread] %-5level %logger{36} [%file : %line] - %msg%n</pattern>

</encoder>

</appender> <!--==========================RollingFileAppender===============================================================================--> <!--<appender name="file" class="ch.qos.logback.core.rolling.RollingFileAppender">--> <!--<!–如果是 true,日志被追加到文件结尾,如果是 false,清空现存文件,默认是true-->

<!--but 我加了之后 警告 Append mode is mandatory for RollingFileAppender. Defaulting to append=true. 我还是不加了–>-->

<!--<!– <append>false</append>–>--> <!--<filter class="ch.qos.logback.classic.filter.ThresholdFilter">-->

<!--<level>trace</level>-->

<!--</filter>-->

<!--<!–rollingPolicy没写的话 会有警告 No TriggeringPolicy was set for the RollingFileAppender named file 没有输出本地文件–>-->

<!--<rollingPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">-->

<!--<fileNamePattern>E:/logDemo1/${sk.name}.log.%i.%d{yyyy-MM-dd}</fileNamePattern>-->

<!--<!–30d周期–>-->

<!--<maxHistory>30</maxHistory>-->

<!--<!–每个文件最大10M–>-->

<!--<maxFileSize>10MB</maxFileSize>-->

<!--</rollingPolicy>--> <!--<encoder>-->

<!--<pattern>%d{yyyy-MM-dd HH:mm:ss} [%thread] %-5level %logger{36} [%file : %line] - %msg%n</pattern>-->

<!--</encoder>-->

<!--</appender>--> <!--=========================================================================================================--> <!--root是默认的logger 这里没设定输出级别-->

<root>

<!--定义了appender,日志会通过往appender里面写-->

<appender-ref ref="stdout"/>

<appender-ref ref="file"/>

</root> <!--==================================指定包的日志======================================================-->

<!--这个logger没有指定appender,它会继承root节点中定义的那些appender -->

<logger name="edu.cn" level="debug">

<!-- <appender-ref ref="stdout"/>-->

</logger> <!--通过 LoggerFactory.getLogger("Test3") 可以获取到这个logger

additivity="false" 没有它 输出双倍 自身的和继承的root的appender-->

<logger name="Test3" level="trace" additivity="false">

<appender-ref ref="stdout"/>

<appender-ref ref="file"/>

</logger> <!--由于设置了 additivity="false" ,所以输出时不会使用rootLogger的appender-->

<!--但是这个logger本身又没有配置appender,所以使用这个logger输出日志的话就不会输出到任何地方-->

<!-- <logger name="Test3" level="trace" additivity="false"></logger>--> </configuration>

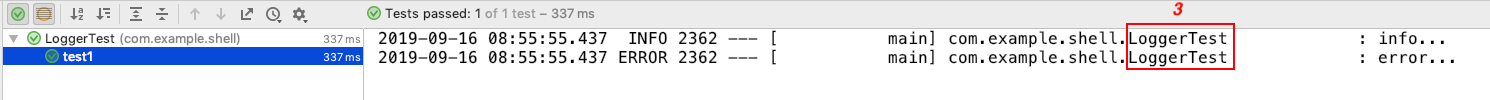

使用:下图中3是根据2的值同步变化的,2写哪个类名,3就显示哪个类名,为了日志输出时定位到所在类,所以3应该与1的值保持一致,所以2的值应尽可能写成1的值,即与所在类名相同

slf4j+logback&logback.xml的更多相关文章

- java日志组件介绍(common-logging,log4j,slf4j,logback )

转自:http://www.blogjava.net/daiyongzhi/archive/2014/04/13/412364.html common-logging是apache提供的一个通用的日志 ...

- slf4j log4j logback关系详解和相关用法

slf4j log4j logback关系详解和相关用法 写java也有一段时间了,一直都有用slf4j log4j输出日志的习惯.但是始终都是抱着"拿来主义"的态度,复制粘贴下配 ...

- 【转】logback logback.xml常用配置详解(二)<appender>

原创文章,转载请指明出处:http://aub.iteye.com/blog/1101260, 尊重他人即尊重自己 详细整理了logback常用配置, 不是官网手册的翻译版,而是使用总结,旨在更快更透 ...

- 【转】logback logback.xml常用配置详解(一)<configuration> and <logger>

原创文章,转载请指明出处:http://aub.iteye.com/blog/1101260, 尊重他人即尊重自己 详细整理了logback常用配置, 不是官网手册的翻译版,而是使用总结,旨在更快更透 ...

- lombok+slf4j+logback SLF4J和Logback日志框架详解

maven 包依赖 <dependency> <groupId>org.projectlombok</groupId> <artifactId>lomb ...

- slf4j,log4j,logback 初步使用

log4j,slf4j,logback简单介绍见 LogBack简易教程 Logback浅析 简单的将,slf4j是一个日志的框架,有各种日志的接口,但是并不包含实际的写日志的方法. log4j,lo ...

- 转:java日志组件介绍(common-logging,log4j,slf4j,logback )

原网址:http://www.blogjava.net/daiyongzhi/archive/2014/04/13/412364.html common-logging common-logging是 ...

- java日志,(commons-loging 、log4j 、slf4j 、LogBack介绍)

如果对于commons-loging .log4j .slf4j .LogBack 等都已经非常清楚了,可以忽略本文.几次解决日志冲突问题时对这几个概念的简单总结,希望对这块基础没有理解透的同学能有所 ...

- How to setup SLF4J and LOGBack in a web app - fast--转载

原文:https://wiki.base22.com/display/btg/How+to+setup+SLF4J+and+LOGBack+in+a+web+app+-+fast Logback is ...

- logback logback.xml 常用配置详解

一:根节点<configuration>包含的属性: scan: 当此属性设置为true时,配置文件如果发生改变,将会被重新加载,默认值为true. scanPeriod: 设置监测配置文 ...

随机推荐

- codeforces 245 D. Restoring Table(位运算+思维)

题目链接:http://codeforces.com/contest/245/problem/D 题意:给出一个矩阵b,b[i][j]=a[i]&a[j],b[i][i]=-1.然后求a[i] ...

- 019 模块2-time库的使用

目录 一.概述 二.time库基本介绍 2.1 time库概述 三.时间获取 四.时间格式化 4.1 格式化控制符 4.2 时间格式化-代码 五.程序计时应用 5.1 程序计时 六.单元小结 参考:h ...

- Invalid bound statement (not found): com.taotao.mapper.TbItemMapper.selectByExample问题解决

最近在做一个关于ssm框架整合的项目,但是今天正合完后出现了问题: Invalid bound statement (not found): com.taotao.mapper.TbItemMappe ...

- MongoDB的入门使用以及遇到的坑

一:MonoDB的简单介绍 MongoDB是一个介于关系型数据库与非关系型数据库中间的数据库,是使用C++进行编写的,他的优点是在支持的查询格式特别的强大,可以进行存储比较复杂的数据类型,支持建立索引 ...

- android 端缓存清理的实现

首先关于缓存清理,网上已经有太多的工具类,但是遗憾的是,基本上都不完善,或者说根本就不能用,而项目中又要求实现这个烂东西(其实这玩意真没一点屁用,毕竟第三方清理/杀毒软件都带这么一个功能),但是只好硬 ...

- Net基础篇_学习笔记_第十一天_面向对象(面向过程与面向对象的区别/类的概念)

1.面向过程-----> 面向对象 面向过程:面向的是完成这件事儿的过程,强调的是完成这件事儿的动作. 把大象塞进冰箱里1.打开冰箱门2.把大象塞进去,亲下大象的屁股3.关闭冰箱门 孙全 瘦小 ...

- linux 堆栈查看

top -c 查看进程ID pstree PID 查看线程树 pstack PID 查看堆栈

- java教程系列二:Java JDK,JRE和JVM分别是什么?

多情只有春庭月,犹为离人照落花. 概述 本章主要了解JDK,JRE和JVM之间的区别.JVM是如何工作的?什么是类加载器,解释器和JIT编译器.还有一些面试问题. Java程序执行过程 在深入了解Ja ...

- Kubernetes学习之Kubernetes架构

架构 Kubernetes历史

- 将Jexus+mono和网站一起通过Dockerfile打包到docker镜像

上次使用别人打包好的docker镜像,往里边加入文件,最终asp.net的docker容器化运行. 这次决定直接全新打包一个jexus+asp.net网站的docker包. 进入root目录,并在ro ...