OVS实现VXLAN隔离

一、实验环境

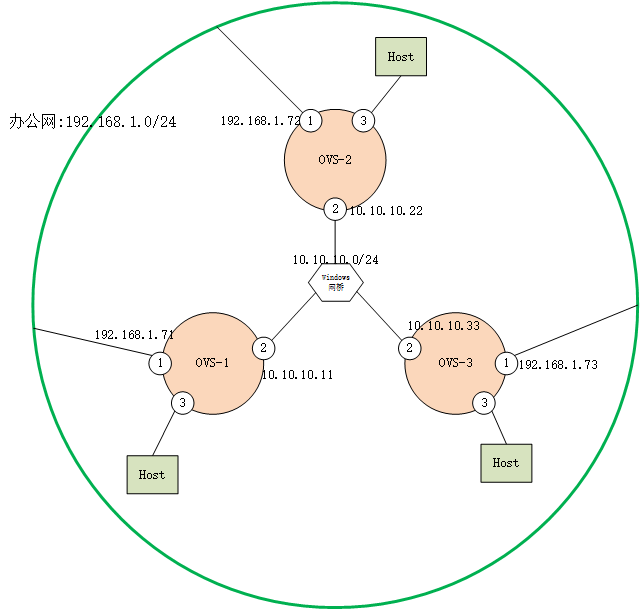

1.准备3个CentOS7 mini版本的虚拟机,每个主机3个网卡。如图:

图中OVS-1、OVS-2、OVS-3分别为三台CentOS7 mini版虚拟机,分别配备3个虚拟网卡。如图中编号所示:

网卡1(eno16777736):作为管理网,桥接到办公网络。

网卡2(eno33554960):VXLAN VTEP互联的L3网络。IP段为10.10.10.0/24

网卡3(eno50332184):用于连接测试用虚拟机,也使用Windows网桥连接。

2.准备好虚拟机后,更新每台虚拟机yum源。

yum install -y wget wget -O /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo yum clean all;yum makecache;yum -y update; yum install net-tools -y

3.按照安装过程安装OVS。

4.三台OVS主机上分别创建br

#添加一个br ovs-vsctl add-br br0 #分别给br0添加一个IP地址,用于VXLAN的测试 ifconfig br0 192.168.100.11 up #OVS-2和OVS-3上分别设置22和33

二、实验过程

1.添加VTEP

OVS-1:ovs-vsctl add-port br0 vx12 -- set interface vx12 type=vxlan options:remote_ip=10.10.10.22

OVS-1:ovs-vsctl add-port br0 vx13 -- set interface vx13 type=vxlan options:remote_ip=10.10.10.33

OVS-2:ovs-vsctl add-port br0 vx21 -- set interface vx21 type=vxlan options:remote_ip=10.10.10.11

OVS-3:ovs-vsctl add-port br0 vx31 -- set interface vx31 type=vxlan options:remote_ip=10.10.10.11

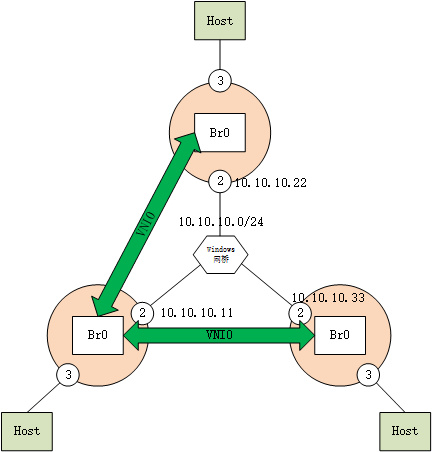

形成下面拓扑:

图中,OVS-1中的Br0上创建了两个VTEP,这两个VTEP的remote_ip分别是10.10.10.22和10.10.10.33。

同样的,OVS-2中创建一个Remote_IP为10.10.10.11。OVS-3中也创建一个Remote_IP为10.10.10.11。

这样就创建了两条VXLAN隧道,默认VNI为0。

此时,测试VXLAN是否能够ping通:

[root@OVS- ~]# ping 192.168.100.22

PING 192.168.100.22 (192.168.100.22) () bytes of data.

bytes from 192.168.100.22: icmp_seq= ttl= time=1.16 ms

bytes from 192.168.100.22: icmp_seq= ttl= time=1.30 ms

[root@OVS- ~]# ping 192.168.100.33

PING 192.168.100.33 (192.168.100.33) () bytes of data.

bytes from 192.168.100.33: icmp_seq= ttl= time=1.43 ms

bytes from 192.168.100.33: icmp_seq= ttl= time=1.51 ms

[root@OVS- ~]# ping 192.168.100.11

PING 192.168.100.11 (192.168.100.11) () bytes of data.

bytes from 192.168.100.11: icmp_seq= ttl= time=1.28 ms

bytes from 192.168.100.11: icmp_seq= ttl= time=1.32 ms

[root@OVS- ~]# ping 192.168.100.11

PING 192.168.100.11 (192.168.100.11) () bytes of data.

bytes from 192.168.100.11: icmp_seq= ttl= time=1.28 ms

bytes from 192.168.100.11: icmp_seq= ttl= time=1.59 ms

说明,上述拓扑图中VXLAN是成功的。

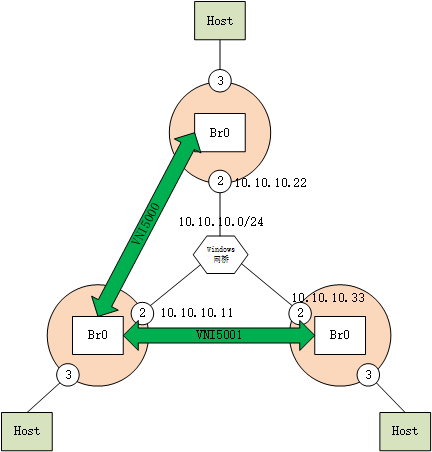

3.使用option:key=5000可以指定每个隧道的VNI:

例如:

OVS-1:ovs-vsctl add-port br0 vx12 -- set interface vx12 type=vxlan options:remote_ip=10.10.10.22 option:key=5000

OVS-1:ovs-vsctl add-port br0 vx13 -- set interface vx13 type=vxlan options:remote_ip=10.10.10.33 option:key=5001

OVS-2:ovs-vsctl add-port br0 vx21 -- set interface vx21 type=vxlan options:remote_ip=10.10.10.11 option:key=5000

OVS-3:ovs-vsctl add-port br0 vx31 -- set interface vx31 type=vxlan options:remote_ip=10.10.10.11 option:key=5001

这样,拓扑中的两条隧道的VNI就不同了:

此时,再次测试VXLAN是否能够ping通:

[root@OVS- ~]# ping 192.168.100.22

PING 192.168.100.22 (192.168.100.22) () bytes of data.

bytes from 192.168.100.22: icmp_seq= ttl= time=1.36 ms

bytes from 192.168.100.22: icmp_seq= ttl= time=0.986 ms

同样,在这种情况下(VNI不同),通讯也是OK的。

从这里,得出结论,每个VXLAN隧道是独立工作的。由于三台虚拟机上的Br0未划分VLAN网段,所以相当于三个Br0通过VXLAN隧道组成了一个L2网络。

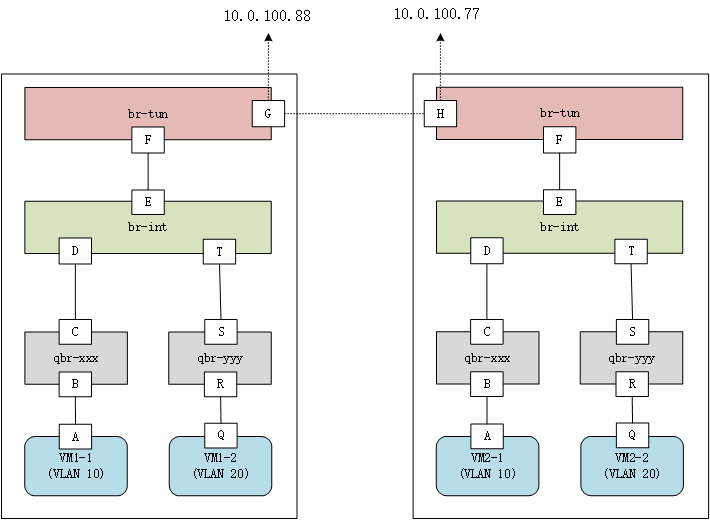

4.云平台中使用VXLAN隔离租户原理

在云平台中如何使用VXLAN来隔离租户:

当在云平台中,例如Openstack中选择使用VXLAN作为网络模式。那么意味着,每个租户使用一个VNI来进行隔离,一共可以支持成百上千万个租户。

上图中:

G、H为两个VTEP,形成VXLAN隧道,两端IP为10.0.100.88和10.0.100.77。

br-tun和br-int一般载体是OVS,供多租户共享,每个租户的数据包在G和H处进行封装,使用不同的VNI隔离。

qbr-xxx是虚拟机独享的,载体是linux bridge。因为OVS无法支持基于iptables规则的安全组功能,所以只能使用Linux bridge来实现安全组功能。

报文出的过程:

1.报文从VM1-1的A端口发出,是Untag报文。

2.报文从B口进入qbr-xxx,再从C端口离开qbr-xxx,也是Untag报文。

3.报文从D端口进入br-int,在D端口,报文被打上标签,VLAN ID=10。

4.报文从E端口离开br-int,此时报文VID=10。

5.报文从F端口进入br-tun,此时报文VID=10。

6.报文从G端口离开Host,在G端口,报文被再次封装为VXLAN报文,外层VID=5000。

OVS实现VXLAN隔离的更多相关文章

- 【Network】OVS、VXLAN/GRE、OVN等 实现 Docker/Kubernetes 网络的多租户隔离

多租户隔离 DragonFlow与OVN | SDNLAB | 专注网络创新技术 Neutron社区每周记(6.25~7.6)| OVS将加入Linux基金会?OVN或抛弃ovsdb? | Unite ...

- [原] 利用 OVS 建立 VxLAN 虚拟网络实验

OVS 配置 VxLAN HOST A ------------------------------------------ | zh-veth0(10.1.1.1) VM A | | ---|--- ...

- OpenStack OVS GRE/VXLAN

https://www.jianshu.com/p/0b52de73a4b3 OpenStack OVS GRE/VXLAN网络 学习或者使用OpenStack普遍有这样的现象:50%的时间花费在了网 ...

- OVS DPDK VXLAN隧道处理

原文链接: OVS DPDK VXLAN隧道处理

- [转载]OpenStack OVS GRE/VXLAN网络

学习或者使用OpenStack普遍有这样的现象:50%的时间花费在了网络部分:30%的时间花费在了存储方面:20%的时间花费在了计算方面.OpenStack网络是不得不逾越的鸿沟,接下来我们一起尝 ...

- 【Network】OVS VXLAN/GRE 实践

参考资料: OVS/VXLAN/GRE参考 ovs vxlan IP overray_百度搜索 OVS操作总结-Neutron-about云开发 OpenStack OVS GRE/VXLAN网络_z ...

- OpenvSwitch系列之八 vxlan隧道

Open vSwitch系列之一 Open vSwitch诞生 Open vSwitch系列之二 安装指定版本ovs Open vSwitch系列之三 ovs-vsctl命令使用 Open vSwit ...

- Neutron 理解(14):Neutron ML2 + Linux bridge + VxLAN 组网

学习 Neutron 系列文章: (1)Neutron 所实现的虚拟化网络 (2)Neutron OpenvSwitch + VLAN 虚拟网络 (3)Neutron OpenvSwitch + GR ...

- Namespace:Openstack的网络实现

前言:众所周知在linux系统中PID.IPC.Network等都是全局性的资源,不论什么的改动和删减都会对整个系统造成影响.这也是为什么kvm之类的虚拟化技术须要模拟一个完毕主机系统的原因. 可是. ...

随机推荐

- Android官方教程翻译(4)——启动另一个Activity

Starting Another Activity 启动另一个Activity PREVIOUSNEXT THIS LESSON TEACHES YOU TO 这节课教你 1. Respond t ...

- hdu - 4971 - A simple brute force problem.(最大权闭合图)

题意:n(n <= 20)个项目,m(m <= 50)个技术问题,做完一个项目能够有收益profit (<= 1000),做完一个项目必须解决对应的技术问题,解决一个技术问题须要付出 ...

- PBS 作业调度应用

PBS(Portable Batch System),最初由 NASA 的 Ames 研究中心开发,主要为了提供一个能满足异构计算网络需要的软件包,用于灵活的批处理(Portable Batch Pr ...

- 简明Python3教程 11.数据结构

简介 数据结构基本上就是 – 可以将一些数据结合到一起的结构,换言之用于存储一组相关的数据. python拥有4种内建数据结构 – 列表,元组(tuple),字典和集合. 我们将看到如何它们,它们又是 ...

- Tomcat 8(十)HTTP/AJP Connector、Bio/Nio/Apr性能对照

Tomcat 8(七)解读Bootstrap介绍过,Connector初始化/启动的时候,将初始化/启动内部的ProtocolHandler.事实上ProtocolHandler仅仅是个接口 Prot ...

- OpenGL(十七) 绘制折线图、柱状图、饼图

一.绘制折线图 glutBitmapCharacter(GLUT_BITMAP_8_BY_13,label[j])函数可以绘制GLUT位图字符,第一个参数是GLUT中指定的特定字形集,第二个参数是要写 ...

- c# 守护进程,WPF程序自守护

原文:c# 守护进程,WPF程序自守护 版权声明:本文为博主原创文章,转载请注明出处. https://blog.csdn.net/lwwl12/article/details/79035246 如何 ...

- centos6.5安装apache2.x并更改默认80port

因为现在nginx它已成为反向代理软件的主流.因此,linuxserver在系统.我们几乎总是安装nginx东方的,这使在同一时间使用apache带来了麻烦.因为apache它用于通过缺省80port ...

- WPF控件获得焦点时去除虚线框

原文:WPF控件获得焦点时去除虚线框 <Setter Property="FocusVisualStyle" Value="{x:Null}" />

- MVVMLight 实现指定Frame控件的导航

原文:MVVMLight 实现指定Frame控件的导航 在UWP开发中,利用汉堡菜单实现导航是常见的方法.汉堡菜单导航一般都需要新建一个Frame控件,并对其进行导航,但是在MvvmLight框架默认 ...