celery 入门

认识

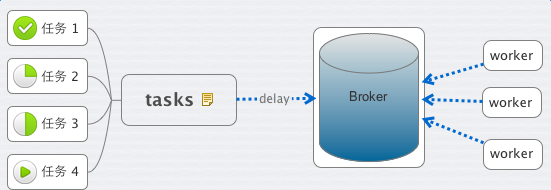

这里有几个概念,task、worker、broker。

顾名思义,task 就是老板交给你的各种任务,worker 就是你手下干活的人员。

那什么是 Broker 呢?

老板给你下发任务时,你需要 把它记下来, 这个它 可以是你随身携带的本子,也可以是 电脑里地记事本或者excel,或者是你的 任何时间管理工具。

Broker 则是 Celery 记录task的地方。

作为一个任务管理者的你,将老板(前端程序)发给你的 安排的工作(Task) 记录到你的本子(Broker)里。接下来,你就安排你手下的IT程序猿们(Worker),都到你的本子(Broker)里来取走工作(Task)

1. broker为rabbitmq

#tasks.py

from celery import Celery

app = Celery('tasks', broker='amqp://admin:admin@localhost:5672')

@app.task

def add(x, y):

return x + y

启动

celery -A tasks worker --loglevel=info

运行

>>> from tasks import add

>>> add(, ) >>> add.delay(,)

<AsyncResult: 07614cef-f314-4c7b-a33f-92c080cadb83>

>>>

注:delay是使用异步的方式,会压入到消息队列。否则,不会使用消息队列。

文件名为tasks.py,则其中代码app = Celery('tasks', broker=),Celery第一个参数为工程名,启动时也是celery -A tasks worker --loglevel=info

对比

注:投入到指定的队列用:add.delay(1, 3, queue='queue_add1')

test_2.py

from celery import Celery

app = Celery('proj', broker='amqp://admin:admin@localhost:5672', include='test_2')

@app.task

def add(x, y):

return x + y

2. 以python+文件名的方式启动

例1:

#test.py

from celery import Celery

import time

app = Celery('test', backend='amqp', broker='amqp://admin:admin@localhost:5672') @app.task

def add(x, y):

print "------>"

time.sleep(5)

print "<--------------"

return x + y if __name__ == "__main__":

app.start()

启动

python test.py worker

celery默认启动的worker数为内核个数,如果指定启动个数,用参数-c,例

python test.py worker -c 2

例2:

#test.py

from celery import Celery

import time

app = Celery('test', backend='amqp', broker='amqp://admin:admin@localhost:5672') @app.task

def add(x, y):

print "------>"

time.sleep(2)

print "<--------------"

return x + y if __name__ == "__main__":

app.start()

#eg.py

from test import *

import time rev = []

for i in range(3):

rev.append(add.delay(1,3)) print "len rev:", len(rev)

while 1:

tag = 1

for key in rev:

if not key.ready():

tag = 0

time.sleep(1)

print "sleep 1"

if tag:

break

print "_____________________>"

3. broker为redis

#test_redis.py

from celery import Celery

import time

#app = Celery('test_redis', backend='amqp', broker='redis://100.69.201.116:7000')

app = Celery('test_redis', backend='redis', broker='redis://100.69.201.116:7000') @app.task

def add(x, y):

print "------>"

time.sleep(5)

print "<--------------"

return x + y if __name__ == "__main__":

app.start()

启动

python test_redis.py worker -c 2

测试

from celery import group

from test_redis import *

g = group(add.s(2, 3)).apply_async()

g = group(add.s(2, 3)).apply_async()

g = group(add.s(2, 3)).apply_async()

g = group(add.s(2, 3)).apply_async()

g = group(add.s(2, 3)).apply_async()

for ret in g.get():

print ret

print "end-----------------------------------"

结果

5

end-----------------------------------

4. 两个队列(redis)

#test_redis.py

from celery import Celery

import time

#app = Celery('test_redis', backend='amqp', broker='redis://100.69.201.116:7000')

app = Celery('test_redis', backend='redis', broker='redis://100.69.201.116:7000') @app.task

def add(x, y):

print "------>"

time.sleep(5)

print "<--------------"

return x + y if __name__ == "__main__":

app.start()

#test_redis_2.py

from celery import Celery

import time

#app = Celery('test_redis', backend='amqp', broker='redis://100.69.201.116:7000')

app = Celery('test_redis_2', backend='redis', broker='redis://100.69.201.116:7001') @app.task

def add_2(x, y):

print "=======>"

time.sleep(5)

print "<================="

return x + y if __name__ == "__main__":

app.start()

测试

from celery import group

from test_redis import *

from test_redis_2 import *

ll = [(1,2), (3,4), (5,6)]

g = group(add.s(key[0], key[1]) for key in ll).apply_async()

for ret in g.get():

print ret

print "end redis_1 -----------------------------------" ll = [(1,2), (3,4), (5,6)]

g = group(add_2.s(key[0], key[1]) for key in ll).apply_async()

for ret in g.get():

print ":", ret

print "end redis_2 -----------------------------------"

结果

3

7

11

end redis_1 -----------------------------------

: 3

: 7

: 11

end redis_2 -----------------------------------

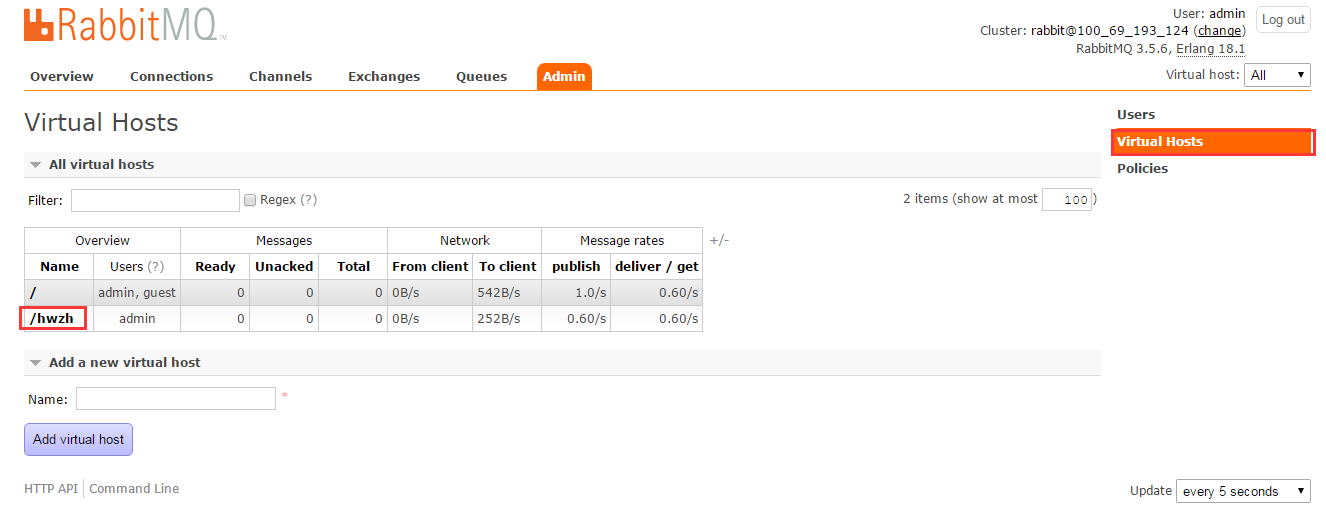

5. 两个队列(同一个rabbitmq)

注释:需要提前设置下队列

##例1

#test.py

from celery import Celery

import time

app = Celery('test', backend='amqp', broker='amqp://admin:admin@localhost:5672//') @app.task

def add(x, y):

print "------>"

time.sleep(5)

print "<--------------"

return x + y if __name__ == "__main__":

app.start()

#test_2.py

from celery import Celery

import time

app = Celery('test_2', backend='amqp', broker='amqp://admin:admin@localhost:5672//hwzh') @app.task

def add_2(x, y):

print "=====>"

time.sleep(5)

print "<=========="

return x + y if __name__ == "__main__":

app.start()

测试

from celery import group

from test import *

from test_2 import * ll = [(1,2), (3,4), (7,8)]

g = group(add.s(key[0], key[1]) for key in ll).apply_async()

for ret in g.get():

print ret ll = [(1,2), (3,4), (7,8)]

g = group(add_2.s(key[0], key[1]) for key in ll).apply_async()

for ret in g.get():

print ret

结果

3

7

15

3

7

15

##例2

#test.py

from celery import Celery

import time

app = Celery('test', backend='amqp', broker='amqp://admin:admin@localhost:5672//mq4') @app.task

def add(x, y):

print "------>"

time.sleep(2)

print "<--------------"

return x + y @app.task

def sum(x, y):

print "------>"

time.sleep(2)

print "<--------------"

return x + y if __name__ == "__main__":

app.start()

#eg2.py

from test import *

import time rev = []

for i in range(3):

rev.append(add.delay(1,3)) for i in range(3):

rev.append(sum.delay(1,3)) print "len rev:", len(rev)

while 1:

tag = 1

for key in rev:

if not key.ready():

tag = 0

time.sleep(1)

print "sleep 1"

if tag:

break

print "_____________________>"

6. 保存结果

from celery import Celery

app = Celery('tasks', backend='amqp', broker='amqp://admin:admin@localhost')

@app.task

def add(x, y):

return x + y

启动

celery -A tasks_1 worker --loglevel=info

与前例不同:

- ** ---------- [config]

- ** ---------- .> app: tasks:0x7f8057931810

- ** ---------- .> transport: amqp://admin:**@localhost:5672//

- ** ---------- .> results: amqp

运行

>>> from tasks_1 import add

>>> result = add.delay(, )

>>> result.ready()

True

>>> result.get()

7. 多个队列

from celery import Celery

from kombu import Exchange, Queue

BROKER_URL = 'amqp://admin:admin@localhost//'

app = Celery('tasks', backend='amqp',broker=BROKER_URL)

app.conf.update(

CELERY_ROUTES={

"add1":{"queue":"queue_add1"},

"add2":{"queue":"queue_add2"},

"add3":{"queue":"queue_add3"},

"add4":{"queue":"queue_add4"},

},

)

@app.task

def add1(x, y):

return x + y @app.task

def add2(x, y):

return x + y @app.task

def add3(x, y):

return x + y @app.task

def add4(x, y):

return x + y

8. 消息路由

文件:tasks.py

from celery import Celery, platforms

import time

import os app = Celery('proj', broker='amqp://admin:admin@ip:5672',

include=['tasks']

)

app.conf.update(

CELERY_ROUTES={

'tasks.fun_1': {

'queue': "q_1"

},

'tasks.fun_2': {

'queue': "q_2"

}

}

)

platforms.C_FORCE_ROOT = True @app.task

def fun_1(n):

print "(((((((((((((((func_1", n

return 1 @app.task

def fun_2(n):

print n, ")))))))))))))))"

return 2 if __name__ == "__main__":

app.start()

启动

python tasks.py worker -c 2 -Q q_1

python tasks.py worker -c 2 -Q q_2

两个消息队列:q_1, q_2,调用示例

>>> from tasks import *

>>> fun_1(1)

(((((((((((((((func_1 1

1

>>> fun_1.delay(1)

<AsyncResult: 528a2ad1-bc16-4bdc-beff-cd166fe3e885>

>>> fun_2.delay(2)

<AsyncResult: ee5881eb-b384-4a39-ba00-08aa8ee53504>

9. woker内启多进程

#tasks.py

from celery import Celery

import time

import multiprocessing as mp app = Celery('proj', broker='amqp://admin:admin@ip:5672', include="tasks") def test_func(i):

print "beg...:", i

time.sleep(5)

print "....end:", i

return i * 5 @app.task

def fun_1(n):

curr_proc = mp.current_process()

curr_proc.daemon = False

p = mp.Pool(mp.cpu_count())

curr_proc.daemon = True

for i in range(n):

p.apply_async(test_func, args=(i,))

p.close()

p.join()

return 1 if __name__ == "__main__":

app.start()

说明

直接启动多进程是肯定不可以的,因为是守候进程(curr_proc.daemon=True),所以启多进程之前主动设置为非守候进程:curr_proc.daemon=False,启动了以后再设为守候进程

#tasks_callback.py

from celery import Celery

import time

import multiprocessing as mp app = Celery('proj', broker='amqp://admin:admin@ip:5672', include="tasks_callback")

rev = []

def test_func(i):

print "beg...:", i

time.sleep(5)

print "....end:", i

return i * 5 def callback_log(rev_val):

rev.append(rev_val) @app.task

def fun_1(n):

print "before rev:", rev

curr_proc = mp.current_process()

curr_proc.daemon = False

p = mp.Pool(mp.cpu_count())

curr_proc.daemon = True

for i in range(n):

p.apply_async(test_func, args=(i,), callback=callback_log)

p.close()

p.join()

print "after rev:", rev

return 1 if __name__ == "__main__":

app.start()

10. 常用参数配置

1. CELERYD_PREFETCH_MULTIPLIER

同时预取得消息个数,比如如果CELERYD_PREFETCH_MULTIPLIER=2,那么如果现在对于1个worker,有一个状态是STARTED, 那么可以有2个处于RECEVED状态(如果有的话),这样就避免了如果消息很多全部分下取,后起来的worker领不到消息的尴尬。

参考代码

from celery import Celery, platforms

import time

import os app = Celery('proj', broker='amqp://admin:admin@localhost:5672',

include=['tasks']

)

app.conf.update(

CELERYD_PREFETCH_MULTIPLIER=2,

CELERY_ROUTES={

'tasks.fun_1': {

'queue': "q_1"

},

'tasks.fun_2': {

'queue': "q_2"

}

}

)

platforms.C_FORCE_ROOT = True @app.task

def fun_1(n):

print "(((((((((((((((func_1", n

time.sleep(20)

return 1 @app.task

def fun_2(n):

print n, ")))))))))))))))"

return 2

调用

>>> from tasks import *

>>> fun_1.delay(3)

<AsyncResult: 609f2216-6785-409e-9f6f-85ae3fcce084>

>>> fun_1.delay(3)

<AsyncResult: 0230b8bd-b237-40ef-bc73-88929f8f8290>

>>> fun_1.delay(3)

<AsyncResult: 8fce172a-93c9-41f8-8c08-377a4363389c>

>>> fun_1.delay(3)

参考:http://windrocblog.sinaapp.com/?p=1585

celery 入门的更多相关文章

- Celery入门指北

Celery入门指北 其实本文就是我看完Celery的官方文档指南的读书笔记.然后由于我的懒,只看完了那些入门指南,原文地址:First Steps with Celery,Next Steps,Us ...

- 分布式队列Celery入门

Celery 是一个简单.灵活且可靠的,处理大量消息的分布式系统,并且提供维护这样一个系统的必需工具.它是一个专注于实时处理的任务队列,同时也支持任务调度.Celery 是语言无关的,虽然它是用 Py ...

- celery入门

认识 这里有几个概念,task.worker.broker.顾名思义,task 就是老板交给你的各种任务,worker 就是你手下干活的人员. 那什么是 Broker 呢? 老板给你下发任务时,你需要 ...

- 分布式任务队列Celery入门与进阶

一.简介 Celery是由Python开发.简单.灵活.可靠的分布式任务队列,其本质是生产者消费者模型,生产者发送任务到消息队列,消费者负责处理任务.Celery侧重于实时操作,但对调度支持也很好,其 ...

- 异步任务神器 Celery-入门

一.Celery入门介绍 在程序的运行过程中,我们经常会碰到一些耗时耗资源的操作,为了避免它们阻塞主程序的运行,我们经常会采用多线程或异步任务.比如,在 Web 开发中,对新用户的注册,我们通常会给他 ...

- 初识Celery

本系列文章的开发环境: window + python2. + pycharm5 + celery3.1.25 + django1.9.4 在我们日常的开发工作中,经常会遇到这几种情况: 1.在web ...

- Celery异步调度框架(一)基本使用

介绍 之前部门开发一个项目我们需要实现一个定时任务用于收集每天DUBBO接口.域名以及TOMCAT(核心应用)的访问量,这个后面的逻辑就是使用定时任务去ES接口抓取数据存储在数据库中然后前台进行展示. ...

- Django中使用Celery

一.前言 Celery是一个基于python开发的分布式任务队列,如果不了解请阅读笔者上一篇博文Celery入门与进阶,而做python WEB开发最为流行的框架莫属Django,但是Django的请 ...

- 转 Celery 使用

http://www.mamicode.com/info-detail-1798782.html https://blog.csdn.net/lu1005287365/article/details/ ...

随机推荐

- 分布式架构高可用架构篇_08_MyCat在MySQL主从复制基础上实现读写分离

参考: 龙果学院http://www.roncoo.com/share.html?hamc=hLPG8QsaaWVOl2Z76wpJHp3JBbZZF%2Bywm5vEfPp9LbLkAjAnB%2B ...

- GridVeiw 使用

1. 因使用的是 Mongodb,因此要在 ActiveDataProvider 中指定 key 属性 2. 自定义表格中的按钮 'class' => 'yii\grid\ActionColum ...

- 课堂Scrum站立会议演示

组名:连连看 组长:张政 组员:张金生.李权.武志远 时间:2016.10.13 20:20--20:40 会议内容: 已完成的内容: 1.选定编译语言,安装软件并配置环境,完成了游戏的基本模型. ...

- VFS

VFS的作用:为文件系统提供通用的接口. 通用文件模型:common file model.特殊文件系统需要将它的物理结构转换成通用文件模型. common file model包括以下几个重要对象: ...

- UVALive 2635 匈牙利算法

题意 给出k块地 规模n*m 需要在每块地中找至多一块h*w的地 这些地中如果包含字母 只能包含一种字母 如果一块地中选地使用了A 其余的地就不能使用A 但是全0可以重复 问 最后能最多选出来多少块地 ...

- Apache Spark源码走读之15 -- Standalone部署模式下的容错性分析

欢迎转载,转载请注明出处,徽沪一郎. 概要 本文就standalone部署方式下的容错性问题做比较细致的分析,主要回答standalone部署方式下的包含哪些主要节点,当某一类节点出现问题时,系统是如 ...

- S5PV210裸板驱动:启动

以往2440和6410的启动方式,只要我们把裸板代码烧写到NAND FLASH的开始位置,当开发板上点启动时,处理器会自动从NAND FLASH上拷贝前面一段的代码到内部的RAM中执行.按照以前的方法 ...

- 20145235 《Java程序设计》第10周学习总结

教材学习内容总结 网络编程 网络编程对于很多的初学者来说,都是很向往的一种编程技能,但是很多的初学者却因为很长一段时间无法进入网络编程的大门而放弃了对于该部分技术的学习. 程序员所作的事情就是把数据发 ...

- 云计算中心网络资源分配-Faircloud: sharing the network in cloud computing

网络资源同计算资源以及存储资源一样,是一种可被租户共享使用并提高利用率的资源.但是,不同租户的计算资源以及存储资源之间,有很强的隔离性,可以实现按需按比例分配的使用方式,但是网络资源却不可以. 主要原 ...

- 类库引用EF

安装EntityFramework 添加引用system.data.entity;