python爬虫---selenium库的用法

selenium是一个自动化测试工具,支持Firefox,Chrome等众多浏览器

在爬虫中的应用主要是用来解决JS渲染的问题。

1.使用前需要安装这个第三方库,CMD下:

pip install selenium

2.为你的测试浏览器下载驱动,我用的是Chrome,对应的去百度一下Chrome webdrive下载,并解压到python安装目录scripts下。

开始使用

from selenium import webdrive browser = webdrive.Chrome()

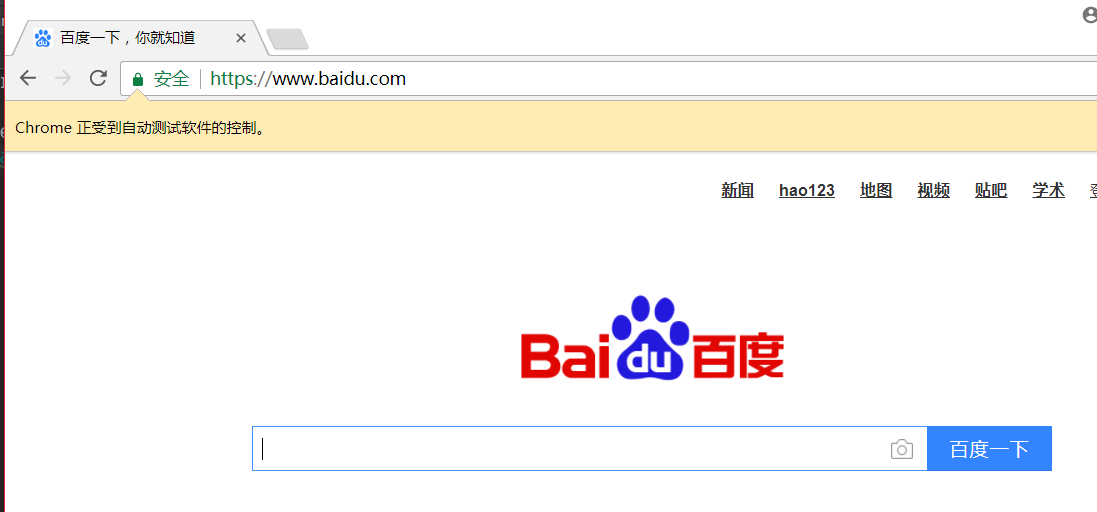

browser.get('http://www.baidu.com')

运行代码就会弹出一个Chrome浏览器,并执行了一个get请求到达了百度。

如果是像微博这样的页面经过大量JS代码渲染过的,仅仅使用requests来打印页面源码,看到的时很简单的html和少量JS代码,这就获取不了我们需要的内容

所以,selenium解决了这个问题,通过模拟浏览器的访问,实现了页面源码的完整打印

from selenium import webdrive browser = webdrive.Chrome()

browser.get('https://www.zhihu.com/explore')

print(browser.page_source)

browser.close() #源码打印后,可以选择自动关闭或者手动关闭

这样的话,页面完全加载后,源码全部打印。

元素查找

单个元素查找

查找方法有以下七种:

find_element_by_name

find_element_by_xpath

find_element_by_link_text

find_element_by_partial_link_text

find_element_by_tag_name

find_element_by_class_name

find_element_by_css_selector

以淘宝作为示例,下面是淘宝输入框的html代码

<input id="q" name="q" aria-label="请输入搜索文字" accesskey="s" autofocus="autofocus" autocomplete="off" class="search-combobox-input" aria-haspopup="true" aria-combobox="list" role="combobox" x-webkit-grammar="builtin:translate" tabindex="0">

其中id为q

使用三种方式进行查找

from selenium import webdriver browser = webdriver.Chrome()

browser.get('http://www.taobao.com') input_first = browser.find_element_by_id('q')

input_sec = browser.find_element_by_css_selector('#q') #在进行css选择时,class以#代替

input_third = browser.find_element_by_xpath('//*[@id="q"]')

print(input_first, input_sec, input_third)

输出信息:可以看到三者的element值全部相同

<selenium.webdriver.remote.webelement.WebElement (session="058a6d63356b317ab154f05c765c965c", element="0.10777909912780625-1")>

<selenium.webdriver.remote.webelement.WebElement (session="058a6d63356b317ab154f05c765c965c", element="0.10777909912780625-1")>

<selenium.webdriver.remote.webelement.WebElement (session="058a6d63356b317ab154f05c765c965c", element="0.10777909912780625-1")>

另一种查找方式:

这种查找方式无非就是将查找方式作为参数传入,相比还是上一种更简洁

from selenium import webdriver

from selenium.webdriver.common.by import By browser = webdriver.Chrome()

browser.get('http://www.taobao.com')

input_fir = browser.find_element(By.ID, 'q')

input_sec = browser.find_element(By.CSS_SELECTOR, '#q')

input_thi = browser.find_element(By.XPATH, '//*[@id="q"]')

print(input_fir, input_sec, input_thi)

输出:三者的element值还是相同的

<selenium.webdriver.remote.webelement.WebElement (session="0b52c54d919026a491c53474b4e148c7", element="0.8407035458653862-1")>

<selenium.webdriver.remote.webelement.WebElement (session="0b52c54d919026a491c53474b4e148c7", element="0.8407035458653862-1")>

<selenium.webdriver.remote.webelement.WebElement (session="0b52c54d919026a491c53474b4e148c7", element="0.8407035458653862-1")>

多元素查找

find_elements_by_xxx,find_elements(By.xxxxx)

淘宝元素查找示例,服务导航条的html代码如下

<ul class="service-bd" role="menubar">

<li data-closeper="" aria-label="查看更多" role="menuitem" aria-haspopup="true" data-groupid="101" class="J_Cat a-all">

查找service-bd下级的li标签

from selenium import webdriver

from selenium.webdriver.common.by import By browser = webdriver.Chrome()

browser.get('http://www.taobao.com')

a = browser.find_elements_by_css_selector('.service-bd li')

# b = browser.find_elements(By.CSS_SELECTOR, '.service-bd li') #第二种的参数传入查找方式 print(a)

结果:li标签的值仍然是相同的,多元素查找时,返回的时list集合

[<selenium.webdriver.remote.webelement.WebElement (session="387a43bf87c016a86c80f072f4a62aca", element="0.4632603097227008-1")>,

<selenium.webdriver.remote.webelement.WebElement (session="387a43bf87c016a86c80f072f4a62aca", element="0.4632603097227008-2")>,

<selenium.webdriver.remote.webelement.WebElement (session="387a43bf87c016a86c80f072f4a62aca", element="0.4632603097227008-3")>,

.......]

元素交互操作

由网页get--->>>元素查找---->>>键值插入及删除--->>>点击事件

以下代码实现的过程是:到达淘宝--->>>查找输入框id为q的元素--->>>键入值---等待---重新键入值-----提交按钮元素查找---点击

from selenium import webdriver

import time browser = webdriver.Chrome()

browser.get('http://www.taobao.com')

input = browser.find_element_by_id('q')

input.send_keys('iPhone')

time.sleep(2)

input.clear()

input.send_keys('gigabyte')

button = browser.find_element_by_class_name('btn-search')

button.click()

print(browser.current_url) # 打印当前页面的url

执行JS语句

from selenium import webdriver #执行js语句:实现一个网页下拉动作

browser = webdriver.Chrome()

browser.get('http://www.zhihu.com/explore')

browser.execute_script('window.scrollTo(0, document.body.scrollHeight)')

browser.execute_script('alert("succ")')

前进与后退操作

>>> from selenium import webdriver

>>> driver = webdriver.Chrome()

>>> driver.get('http://www.baidu.com')

>>> driver.get('http://www.sina.com')

>>> driver.back()

>>> driver.forward()

标签页的增加

from selenium import webdriver driver = webdriver.Chrome()

driver.get('http://www.zhihu.com/explore')

driver.execute_script('window.open()')

print(driver.window_handles)

driver.switch_to.window(driver.window_handles[0])

driver.get('http://www.taobao.com')

driver.switch_to.window(driver.window_handles[1])

driver.get('http://m.weibo.com')

driver.close()

今天博客园抽风了,截图上传不了...

我用selenium做了模拟登陆百度,不过验证码需要自己手打

验证码问题的解决需要依赖PIL库,我还没学习过。。

from selenium import webdriver

import time #声明浏览器对象

browser = webdriver.Chrome()

browser.get('https://passport.baidu.com/v2/?login&fr=old&login&tpl=mn') username = browser.find_element_by_id('TANGRAM__PSP_3__userName')

username.send_keys('account') password = browser.find_element_by_id('TANGRAM__PSP_3__password')

password.send_keys('passwd')

time.sleep(5) button = browser.find_element_by_id('TANGRAM__PSP_3__submit')

button.click() # sendcode = browser.find_element_by_class_name('forceverify-button forceverify-button-send')

# sendcode.click()

#

# time.sleep(10)

#

# finalogin = browser.find_element_by_id('TANGRAM__28__button_submit')

# finalogin.click()

如果不需要显示的调用浏览器,可以使用第三方浏览器:PhantomJS

phantomjs介绍

(1)一个基于webkit内核的无头浏览器,即没有UI界面,即它就是一个浏览器,只是其内的点击、翻页等人为相关操作需要程序设计实现。

(2)提供javascript API接口,即通过编写js程序可以直接与webkit内核交互,在此之上可以结合java语言等,通过java调用js等相关操作,从而解决了以前c/c++才能比较好的基于webkit开发优质采集器的限制。

(3)提供windows、linux、mac等不同os的安装使用包,也就是说可以在不同平台上二次开发采集项目或是自动项目测试等工作。

Windows下安装使用:

pip install PhantomJS

用法

from selenium import webdriver browser = webdriver.PhantomJS()

只有声明浏览器对象时不同,其他用法全部相同

异常的捕获:

http://selenium-python.readthedocs.io/index.html

python爬虫---selenium库的用法的更多相关文章

- Python爬虫-- selenium库

selenium库 selenium 是一套完整的web应用程序测试系统,包含了测试的录制(selenium IDE),编写及运行(Selenium Remote Control)和测试的并行处理(S ...

- python爬虫---requests库的用法

requests是python实现的简单易用的HTTP库,使用起来比urllib简洁很多 因为是第三方库,所以使用前需要cmd安装 pip install requests 安装完成后import一下 ...

- Python爬虫Urllib库的高级用法

Python爬虫Urllib库的高级用法 设置Headers 有些网站不会同意程序直接用上面的方式进行访问,如果识别有问题,那么站点根本不会响应,所以为了完全模拟浏览器的工作,我们需要设置一些Head ...

- [Python爬虫] Selenium实现自动登录163邮箱和Locating Elements介绍

前三篇文章介绍了安装过程和通过Selenium实现访问Firefox浏览器并自动搜索"Eastmount"关键字及截图的功能.而这篇文章主要简单介绍如何实现自动登录163邮箱,同时 ...

- 安装python的selenium库和驱动

对于使用selenium来进行python爬虫操作可以简化好多操作,它实际上的运行就是通过打开一个浏览器来一步一步的按照你的代码来执行 如果安装过python编译器后应该pip工具也是有的,验证pyt ...

- [Python爬虫] Selenium+Phantomjs动态获取CSDN下载资源信息和评论

前面几篇文章介绍了Selenium.PhantomJS的基础知识及安装过程,这篇文章是一篇应用.通过Selenium调用Phantomjs获取CSDN下载资源的信息,最重要的是动态获取资源的评论,它是 ...

- [Python爬虫] Selenium获取百度百科旅游景点的InfoBox消息盒

前面我讲述过如何通过BeautifulSoup获取维基百科的消息盒,同样可以通过Spider获取网站内容,最近学习了Selenium+Phantomjs后,准备利用它们获取百度百科的旅游景点消息盒(I ...

- [Python爬虫] Selenium爬取新浪微博客户端用户信息、热点话题及评论 (上)

转载自:http://blog.csdn.net/eastmount/article/details/51231852 一. 文章介绍 源码下载地址:http://download.csdn.net/ ...

- [python爬虫] Selenium常见元素定位方法和操作的学习介绍

这篇文章主要Selenium+Python自动测试或爬虫中的常见定位方法.鼠标操作.键盘操作介绍,希望该篇基础性文章对你有所帮助,如果有错误或不足之处,请海涵~同时CSDN总是屏蔽这篇文章,再加上最近 ...

随机推荐

- Spine用于Timeline(NullReferenceException: Object reference not set to an instance of an object pine.Unity.Editor.AnimationReferenceAssetEditor.OnInspectorGUI ())

报错信息:Spine.Unity.Editor.AnimationReferenceAssetEditor.OnInspectorGUI () (at Assets/Extention/Spine/E ...

- PTA-栈

1-1 若一个栈的输入序列为1,2,3,…,N,输出序列的第一个元素是i,则第j个输出元素是j−i−1. (2分) T F 作者: DS课程组 单位: 浙江大学 1-2 若一个栈的 ...

- Unity Canvas vs Panel

Unity guys specifically gave a performance talk about UI Canvases on some of the past Unite(s). You ...

- svg 高宽随父元素自适应

<html lang="en"> <head> <meta charset="UTF-8"> <meta name=& ...

- Javascript 数组相关操作

数组排序问题: sort() arr.sort() 可以直接进行排序,但是排序的方式是按unicode 顺序而来,比如1,1000,200,这个顺序不是我们想要的结果: 所以有了另一种方法,针对num ...

- Holer实现手机APP应用外网访问本地WEB应用

手机APP应用公网访问内网WEB应用 本地安装了WEB服务端,手机APP应用只能在局域网内访问本地WEB,怎样使手机APP应用从公网也能访问本地WEB? 本文将介绍使用holer实现的具体步骤. 1. ...

- ElementUI - Table 表头排序

ElementUI - Table 表头自带排序功能,和排序事件,但是目前只是对当前界面的数据进行排序. 项目需求: 点击表头排序的时候,对所有数据进行排序. 初步方案: 在点击排序按钮的时,在排序事 ...

- iOS常用算法

1.冒泡排序 冒泡算法是一种基础的排序算法,这种算法会重复的比较数组中相邻的两个元素,如果一个元素比另一个元素大/小,那么就交换这两个元素的位置.重复一直比较到最后一个元素. 1.最差时间复杂度:O( ...

- 集群web-ui

一旦Hadoop集群启动并运行,可以通过web-ui进行集群查看,如下所述: 1.hdfs的集群端口号默认50070 NameNode http://localhost1:50070(默认端口号po ...

- SVN配置(服务器端及客户端)

版本控制工具,在前几年一直用的SVN,从去年后半年开始本人开始使用GIT.为了避免后期再次使用SVN过程中出现生疏,在此将SVN服务端及客户端配置方式罗列出来. 本人使用的SVN版本为 服务端: Vi ...