058 kafka与log4j集成

1.首先在resources下面写log4j.properties

主要是因为kafka.producer.KafkaLog4jAppender类的存在。

log4j.rootLogger=INFO,console,KAFKA ## appender KAFKA

log4j.appender.KAFKA=kafka.producer.KafkaLog4jAppender

## topic must exitss

log4j.appender.KAFKA.topic=beifeng

log4j.appender.KAFKA.brokerList=linux-hadoop01.ibeifeng.com:9092,linux-hadoop01.ibeifeng.com:9093

log4j.appender.KAFKA.compressionType=none

log4j.appender.KAFKA.syncSend=false

log4j.appender.KAFKA.layout=org.apache.log4j.PatternLayout

log4j.appender.KAFKA.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss} %-5p %c{1}:%L %% - %m ## appender console

log4j.appender.console=org.apache.log4j.ConsoleAppender

log4j.appender.console.layout=org.apache.log4j.PatternLayout

log4j.appender.console.layout.ConversionPattern=%d (%t) [%p - %l] %m%n

2.测试类

package com.jun.it;

import org.apache.log4j.Logger;

public class KafkaLoggerTest {

public static final Logger logger = Logger.getLogger(KafkaLoggerTest.class);

public static void main(String[] args) throws InterruptedException {

for(int i=0;i<50;i++) {

logger.debug("debug_" + i);

logger.info("info_" + i);

logger.warn("warn_" + i);

logger.error("error_" + i);

logger.fatal("fatal_" + i);

}

// 如果不sleep,会出现什么情况?怎么解决

Thread.sleep(10000);

}

}

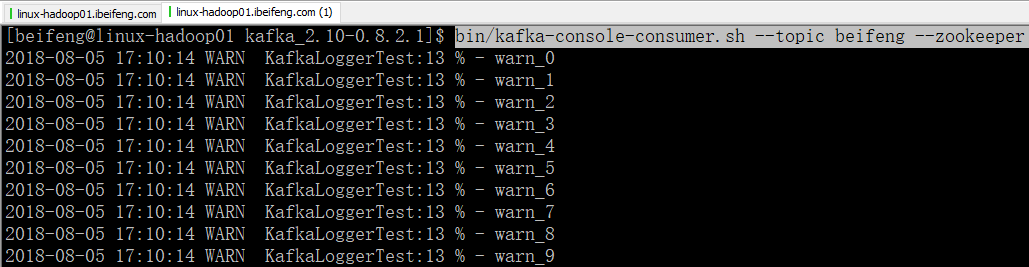

3.开启9092端口的消费者服务

bin/kafka-console-consumer.sh --topic beifeng --zookeeper linux-hadoop01.ibeifeng.com:2181/kafka

4.效果

058 kafka与log4j集成的更多相关文章

- Kafka设计解析(十八)Kafka与Flink集成

转载自 huxihx,原文链接 Kafka与Flink集成 Apache Flink是新一代的分布式流式数据处理框架,它统一的处理引擎既可以处理批数据(batch data)也可以处理流式数据(str ...

- 简单测试flume+kafka+storm的集成

集成 Flume/kafka/storm 是为了收集日志文件而引入的方法,最终将日志转到storm中进行分析.storm的分析方法见后面文章,这里只讨论集成方法. 以下为具体步骤及测试方法: 1.分别 ...

- Kafka与Flink集成

Apache Flink是新一代的分布式流式数据处理框架,它统一的处理引擎既可以处理批数据(batch data)也可以处理流式数据(streaming data).在实际场景中,Flink利用Apa ...

- 基于Flume+LOG4J+Kafka的日志采集架构方案

本文将会介绍如何使用 Flume.log4j.Kafka进行规范的日志采集. Flume 基本概念 Flume是一个完善.强大的日志采集工具,关于它的配置,在网上有很多现成的例子和资料,这里仅做简单说 ...

- Flume+LOG4J+Kafka

基于Flume+LOG4J+Kafka的日志采集架构方案 本文将会介绍如何使用 Flume.log4j.Kafka进行规范的日志采集. Flume 基本概念 Flume是一个完善.强大的日志采集工具, ...

- kafka与Spring的集成

准备工作 kafka版本:kafka_2.10-0.10.1.0 spring版本:spring4.3 配置文件 pom文件配置(也可以直接下载jar包) Kafka和spring集成的支持类库,sp ...

- log4j.xml 报告集成

等级: trace< debug<info<warn<error<fatal trace 追踪 deug: eclipse, Log4j配置 [1]从零开始 a). ...

- flume从log4j收集日志输出到kafka

1. flume安装 (1)下载:wget http://archive.cloudera.com/cdh5/cdh/5/flume-ng-1.6.0-cdh5.7.1.tar.gz (2)解压:ta ...

- flume采集log4j日志到kafka

简单测试项目: 1.新建Java项目结构如下: 测试类FlumeTest代码如下: package com.demo.flume; import org.apache.log4j.Logger; pu ...

随机推荐

- swoole深入学习 2. tcp Server和tcp Client

这节来学习Swoole最基础的Server和Client.会通过创建一个tcp Server来讲解. server <?php class Server { private $serv; pub ...

- css一些基础效果

1.旋转 .center>.bj>.div1>ul>li>.img1:hover {transform: rotate(-360deg);transition: 1s}/ ...

- spring jdbctemplate调用存储过程,返回list对象

注:本文来源于< spring jdbctemplate调用存储过程,返回list对象 > spring jdbctemplate调用存储过程,返回list对象 方法: /** * 调用 ...

- Confluence 6 配置字符集编码

Confluence 和你的数据库必须配置使用相同的字符集.为了避免字符出现问题,请将所有的字符集设置为使用 UTF-8 编码(或者根据你配置的数据库来制定正确的 UTF-8 编码字符集,例如在 Or ...

- Confluence 6 MySQL 输入你的数据库细节

Confluence 的安装向导将会指导你一步一步的在 Confluence 中配置安装 MySQL 数据库. 使用 JDBC 连接(默认) JDBC 是推荐的连接你的 Confluence 到数据库 ...

- VUE开发请求本地数据的配置,旧版本dev-server.js,新版本webpack.dev.conf.js

VUE开发请求本地数据的配置,早期的vue-lic下面有dev-server.js和dev-client.js两文件,请求本地数据在dev-server.js里配置,最新的vue-webpack-te ...

- Socket网络编程(一)

1.什么是网络通讯?(udp.tcp.netty.mina) udp:漂流瓶,每个人都可以向大海里面扔漂流瓶,不管有没有人捡到.(不管接收方有没有,我只往指定的地址发送东西,64kb以内) tcp:电 ...

- J2SE基础小结

1. 九种基本数据类型的大小,以及他们的封装类. 类型 基本类型 大小(字节) 默认值 封装类 整数型 byte 1 (byte)0 Byte short 2 (short)0 Short int 4 ...

- linux文件权限目录配置笔记

###linux 文件权限目录配置笔记 ---------- 多人多任务环境 linux 一般将文件可存取的身份分为三个类别:owner group others Permission deny ls ...

- 图书管理系统(无中间件,用装饰器的)-----未基于FORM组件

目的:实现图书的增删改查 models.py from django.db import models # Create your models here. class Book(models.Mod ...