hive学习笔记之八:Sqoop

欢迎访问我的GitHub

https://github.com/zq2599/blog_demos

内容:所有原创文章分类汇总及配套源码,涉及Java、Docker、Kubernetes、DevOPS等;

关于Sqoop

Sqoop是Apache开源项目,用于在Hadoop和关系型数据库之间高效传输大量数据,本文将与您一起实践以下内容:

- 部署Sqoop

- 用Sqoop将hive表数据导出至MySQL

- 用Sqoop将MySQL数据导入到hive表

部署

- 在hadoop账号的家目录下载Sqoop的1.4.7版本:

wget https://mirror.bit.edu.cn/apache/sqoop/1.4.7/sqoop-1.4.7.bin__hadoop-2.6.0.tar.gz

- 解压:

tar -zxvf sqoop-1.4.7.bin__hadoop-2.6.0.tar.gz

- 解压后得到文件夹sqoop-1.4.7.bin__hadoop-2.6.0,将mysql-connector-java-5.1.47.jar复制到sqoop-1.4.7.bin__hadoop-2.6.0/lib目录下

- 进入目录sqoop-1.4.7.bin__hadoop-2.6.0/conf,将sqoop-env-template.sh改名为sqoop-env.sh:

mv sqoop-env-template.sh sqoop-env.sh

- 用编辑器打开sqoop-env.sh,增加下面三个配置,HADOOP_COMMON_HOME和HADOOP_MAPRED_HOME是完整的hadoop路径,HIVE_HOME是完整的hive路径:

export HADOOP_COMMON_HOME=/home/hadoop/hadoop-2.7.7

export HADOOP_MAPRED_HOME=/home/hadoop/hadoop-2.7.7

export HIVE_HOME=/home/hadoop/apache-hive-1.2.2-bin

- 安装和配置完成了,进入sqoop-1.4.7.bin__hadoop-2.6.0/bin,执行./sqoop version查看sqoop版本,如下所示,可见是1.4.7版本(有些环境变量没配置会输出告警,在此先忽略):

[hadoop@node0 bin]$ ./sqoop version

Warning: /home/hadoop/sqoop-1.4.7.bin__hadoop-2.6.0/bin/../../hbase does not exist! HBase imports will fail.

Please set $HBASE_HOME to the root of your HBase installation.

Warning: /home/hadoop/sqoop-1.4.7.bin__hadoop-2.6.0/bin/../../hcatalog does not exist! HCatalog jobs will fail.

Please set $HCAT_HOME to the root of your HCatalog installation.

Warning: /home/hadoop/sqoop-1.4.7.bin__hadoop-2.6.0/bin/../../accumulo does not exist! Accumulo imports will fail.

Please set $ACCUMULO_HOME to the root of your Accumulo installation.

Warning: /home/hadoop/sqoop-1.4.7.bin__hadoop-2.6.0/bin/../../zookeeper does not exist! Accumulo imports will fail.

Please set $ZOOKEEPER_HOME to the root of your Zookeeper installation.

20/11/02 12:02:58 INFO sqoop.Sqoop: Running Sqoop version: 1.4.7

Sqoop 1.4.7

git commit id 2328971411f57f0cb683dfb79d19d4d19d185dd8

Compiled by maugli on Thu Dec 21 15:59:58 STD 2017

- sqoop装好之后,接下来体验其功能

MySQL准备

为了接下来的实战,需要把MySQL准备好,这里给出的MySQL的配置供您参考:

- MySQL版本:5.7.29

- MySQL服务器IP:192.168.50.43

- MySQL服务端口:3306

- 账号:root

- 密码:123456

- 数据库名:sqoop

关于MySQL部署,我这为了省事儿,是用docker部署的,参考《群晖DS218+部署mysql》

从hive导入MySQL(export)

- 执行以下命令,将hive的数据导入到MySQL:

./sqoop export \

--connect jdbc:mysql://192.168.50.43:3306/sqoop \

--table address \

--username root \

--password 123456 \

--export-dir '/user/hive/warehouse/address' \

--fields-terminated-by ','

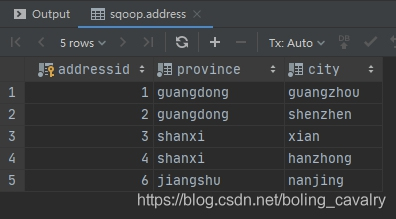

- 查看address表,数据已经导入:

从MySQL导入hive(import)

- 在hive的命令行模式执行以下语句,新建名为address2的表结构和address一模一样:

create table address2 (addressid int, province string, city string)

row format delimited

fields terminated by ',';

- 执行以下命令,将MySQL的address表的数据导入到hive的address2表,-m 2表示启动2个map任务:

./sqoop import \

--connect jdbc:mysql://192.168.50.43:3306/sqoop \

--table address \

--username root \

--password 123456 \

--target-dir '/user/hive/warehouse/address2' \

-m 2

- 执行完毕后,控制台输入类似以下内容:

Virtual memory (bytes) snapshot=4169867264

Total committed heap usage (bytes)=121765888

File Input Format Counters

Bytes Read=0

File Output Format Counters

Bytes Written=94

20/11/02 16:09:22 INFO mapreduce.ImportJobBase: Transferred 94 bytes in 16.8683 seconds (5.5726 bytes/sec)

20/11/02 16:09:22 INFO mapreduce.ImportJobBase: Retrieved 5 records.

- 去查看hive的address2表,可见数据已经成功导入:

hive> select * from address2;

OK

1 guangdong guangzhou

2 guangdong shenzhen

3 shanxi xian

4 shanxi hanzhong

6 jiangshu nanjing

Time taken: 0.049 seconds, Fetched: 5 row(s)

- 至此,Sqoop工具的部署和基本操作已经体验完成,希望您在执行数据导入导出操作时,此文能给您一些参考;

你不孤单,欣宸原创一路相伴

欢迎关注公众号:程序员欣宸

微信搜索「程序员欣宸」,我是欣宸,期待与您一同畅游Java世界...

https://github.com/zq2599/blog_demos

hive学习笔记之八:Sqoop的更多相关文章

- hive学习笔记之一:基本数据类型

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之三:内部表和外部表

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之四:分区表

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之五:分桶

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之六:HiveQL基础

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之七:内置函数

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之九:基础UDF

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之十:用户自定义聚合函数(UDAF)

欢迎访问我的GitHub 这里分类和汇总了欣宸的全部原创(含配套源码):https://github.com/zq2599/blog_demos 本篇概览 本文是<hive学习笔记>的第十 ...

- hive学习笔记之十一:UDTF

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

随机推荐

- Linux 系统定时任务:crontab,anacron

Linux 系统定时任务:crontab,anacron 一.Cron 服务 1. 启动服务 service cron start 2. 关闭服务 service cron stop 3. 重启服务 ...

- Nginx——Docker下安装部署

前言 Nginx 是一个高性能的 HTTP 和反向代理 web 服务器,同时也提供了 IMAP/POP3/SMTP 服务 . 一. 环境说明 docker: 18.09.9-ce nginx: 1.1 ...

- 像素 PIXEL 图片的基本单位 像素非常小 图片是成千上万的像素组成 显示/屏幕分辨率 (DPI 屏幕分辨率)

像素 PIXEL 图片的基本单位 像素非常小 图片是成千上万的像素组成 显示/屏幕分辨率 (DPI 屏幕分辨率) 图像分辨率 (PPI) 1920*1080是像素点长度1920个像素点 X1080个像 ...

- ft2000安装tigervnc

apt update apt install tigervnc*vncserver :88 history >>history

- JQuery Ajax 发送请求成功后却接收不到任何响应数据问题

问题描述 使用 JQuery Ajax 向后端服务器发送请求,服务器也收到请求返回了响应数据,但是 Ajax 却收不到任何响应数据. 举例如下: $.ajax({ type: "post&q ...

- vue项目使用百度地图API获取经纬度

一.首先在百度api注册获得ak密钥 二.进行引入 (1).第一种方式: 直接在vue中index.html中用script标签引入. //你的ak密钥需要替换真实的你的ak码 <script ...

- linux(centos 7)下安装JDK,Tomcat,mysql 运行Maven 项目

一.在Linux中安装JDK 1. 将JDK上传到root下(任何位置均可以). 如图: 2. 用解压命令解压JDK tar -xvf (此处为jdk文件名) 如果是rpm包,执行rpm -i jdk ...

- [Django高级之Auth模块]

[Django高级之Auth模块] auth模块 ←详情点击查看 1.Auth模块是什么 Auth模块是Django自带的用户认证模块: 我们在开发一个网站的时候,无可避免的需要设计实现网站的用户系统 ...

- python异步编程之asyncio

python异步编程之asyncio 前言:python由于GIL(全局锁)的存在,不能发挥多核的优势,其性能一直饱受诟病.然而在IO密集型的网络编程里,异步处理比同步处理能提升成百上千倍的效率, ...

- win系统下如何安装xgboost,开发环境是anaconda,以及这中间需要注意的问题

最近学到了xgboost,但是anaconda并没有这个环境只好自己安装了... 注: (1)并没有测试anaconda在2.x的版本下是如何安装的, 基本上应该是大同小类的,我的anaconda版本 ...