java实现有道翻译爬虫

我的博文地址

https://www.cnblogs.com/lingdurebing/p/11618902.html

使用的库

1.commons-codec

主要是为了加密,可以直接用java原生的,这里偷懒了,有点大才小用的感觉。

2.requests-5.0.7

大佬写的java 类似python的requests库

github地址:https://github.com/zhangjingpu/requests

和python的requests用法差不多。

3.fastjson

主要为了解析json字符串,没有要求。

4.实现

实现在上面博文里说的很详细,有道翻译的加密基本没改,唯一修改的就是字符串D: n%A-rKaT5fb[Gy?;N5@Tj

这里主要贴java代码

先引入需要的依赖。

<dependency>

<groupId>net.dongliu</groupId>

<artifactId>requests</artifactId>

<version>5.0.7</version>

</dependency>

<!-- https://mvnrepository.com/artifact/commons-codec/commons-codec -->

<dependency>

<groupId>commons-codec</groupId>

<artifactId>commons-codec</artifactId>

<version>1.13</version>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>fastjson</artifactId>

<version>1.2.47</version>

</dependency>

然后是主要的实现类

import java.io.IOException;

package com.yang.easySpider; import java.io.IOException;

import java.io.InputStream;

import java.util.HashMap;

import java.util.Map;

import java.util.Properties; import org.apache.commons.codec.digest.DigestUtils;

import net.dongliu.requests.Requests; public class Fanyi {

private String msg;

private String url="http://fanyi.youdao.com/translate_o?smartresult=dict&smartresult=rule";

private String D="n%A-rKaT5fb[Gy?;N5@Tj";

private String bv;

private String salt;

private String sign;

private String ts;

private Map<String,Object> header;

private Map<String,Object> params;

public Fanyi()

{

params=new HashMap<String,Object>();

header=new HashMap<String,Object>();

}

private Map<String,Object> getParams(String msg)

{

params.put("i", setMsg(msg));//设置msg同时更新ts,salt,sign;

params.put("from","AUTO");

params.put("to","AUTO");

params.put("smartresult","dict");

params.put("client","fanyideskweb");

params.put("sign",this.sign);

params.put("bv",this.bv);

params.put("ts",this.ts);

params.put("salt",this.salt);

params.put("doctype","json");

params.put("version", "2.1");

params.put("keyfrom", "fanyi.web");

params.put("action", "FY_BY_REALTlME");

return params;

}

public String getResult(String msg)

{

return Requests.post(url).headers(getHeaders()).body(getParams(msg)).send().readToText();

//得到json格式的文本

}

public void setHeaders(Map<String,Object> header)

{

this.header=header;

}

public Map<String,Object> getHeaders()

{

if(this.header.get("Referer")==null)

{

this.header.put("Referer", "http://fanyi.youdao.com/");

}

return this.header;

}

public void setUserAgent(String UA)

{

this.header.put("User-Agent", UA);

//设置UserAgent

String cookie=Requests.get("http://fanyi.youdao.com").headers(this.header).send().getHeader("Set-Cookie").split(";")[0]+";";

//得到Cookie //设置Cookie

this.header.put("Cookie", cookie);

this.bv=getBv(UA);//设置UA的同时要更新bv,因为bv是通过加密UA得到的。

}

private String getSalt()

{

this.salt=String.valueOf(this.ts)+String.valueOf(((int)Math.random()*10));

return this.salt; }

private String getSign()

{

return getMd5("fanyideskweb"+this.msg+this.salt+this.D);

}

private String getTs()

{

return String.valueOf(System.currentTimeMillis());

}

private String getBv(String UserAgent)

{

return getMd5(UserAgent);

}

private String getMd5(String val)

{

return DigestUtils.md5Hex(val);

}

public String setMsg(String msg)

{ this.msg=msg;

//设置需要翻译的内容

this.ts=getTs();//更新ts

this.salt=getSalt();//更新salt

//设置翻译内容的同时更新ts,salt

this.sign=getSign();

//有了翻译内容,salt才能得到sign,网易主要靠此判断

return this.msg;

}

}

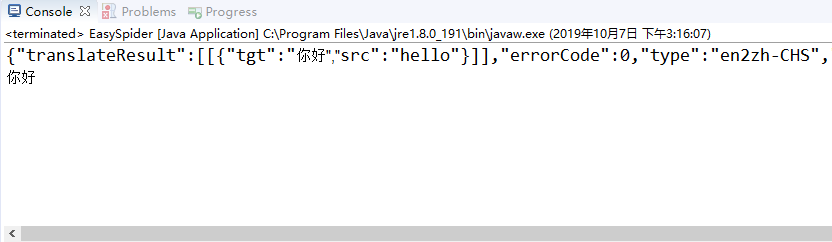

测试一下

public static void main( String[] args )

{

Fanyi fanyi=new Fanyi();

fanyi.setUserAgent("Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/76.0.3809.132 Safari/537.36");

String st=fanyi.getResult("hello");

System.out.print(st);

JSONObject json=JSONObject.parseObject(st);

JSONArray ja=(JSONArray) ((JSONArray) json.get("translateResult")).get(0);

JSONObject js=(JSONObject) ja.get(0);

System.out.print(js.get("tgt")); }

Ok, 没有问题,完成。

参考博文连接地址:https://blog.csdn.net/suixinlun/article/details/93976400

java实现有道翻译爬虫的更多相关文章

- Selenium+PhantomJS实现简易有道翻译爬虫

Selenium一款自动化测试工具,当然用来写爬虫也是没有问题的.它支持Chrome.Safari.Firefox等主流界面式浏览器,另外它也支持多种语言开发,比如 Java,C,Ruby,Pytho ...

- python学习笔记(6)--有道翻译爬虫

说明: 1. 导入三个模块,urllib.request.urlopen用来打开url链接,urllib.parse的urlencode方法将浏览器network里的data对象转为urlopen的第 ...

- Python 有道翻译 爬虫 有道翻译API 突破有道翻译反爬虫机制

py2.7 #coding: utf-8 import time import random import hashlib import requests while(1): url = 'http: ...

- 爬虫新手学习2-爬虫进阶(urllib和urllib2 的区别、url转码、爬虫GET提交实例、批量爬取贴吧数据、fidder软件安装、有道翻译POST实例、豆瓣ajax数据获取)

1.urllib和urllib2区别实例 urllib和urllib2都是接受URL请求相关模块,但是提供了不同的功能,两个最显著的不同如下: urllib可以接受URL,不能创建设置headers的 ...

- Java接口测试之使用有道翻译API

写接口测试框架,找了有道翻译API来当测试数据 package com.httpGetTest; import java.beans.Encoder; import java.net.URLEncod ...

- python3爬虫:利用urllib与有道翻译获得翻译结果

在实现这一功能时遇到了一些困难,由于按照<零基础入门python>中的代码无法实现翻译,会爆出“您的请求来源非法,商业用途使用请关注有道翻译API官方网站“有道智云”: http://ai ...

- 爬虫实战2_有道翻译sign破解

目标url 有道翻译 打开网站输入要翻译的内容,一一查找network发现数据返回json格式,红框就是我们的翻译结果 查看headers,发现返回结果的请求是post请求,且携带一大堆form_da ...

- (未完成...)Python3网络爬虫(2):利用urllib.urlopen向有道翻译发送数据并获得翻译结果

环境: 火狐浏览器 pycharm2017.3.3 python3.5 1.url不仅可以是一个字符串,例如:http://www.baidu.com.url也可以是一个Request对象,这就需要我 ...

- python爬虫-有道翻译-js加密破解

有道翻译-js加密破解 这是本地爬取的网址:http://fanyi.youdao.com/ 一.分析请求 我们在页面中输入:水果,翻译后的英文就是:fruit.请求携带的参数有很多,先将参数数据保存 ...

随机推荐

- Springboot源码分析之事务问题

摘要: 事务在后端开发中无处不在,是数据一致性的最基本保证.要明白进事务的本质就是进到事务切面的代理方法中,最常见的是同一个类的非事务方法调用一个加了事务注解的方法没进入事务.我们以cglib代理为例 ...

- 微擎 人人商城 导出excel表分析

在 数据处理上 ,有很多时候需要导出excel表 来当报表, 等 , php 人人商城导出报表过程简单分析 在导出时候发现 ca('statistics.order.export'); 出于好奇 ...

- Python实现 下载IJCAI会议所有论文

import requests import threading def get_file_content(num): savepath = '%04d.pdf' % (num) suburl = ' ...

- lightoj 1037 - Agent 47(状压dp)

题目链接:http://www.lightoj.com/volume_showproblem.php?problem=1037 #include <iostream> #include & ...

- 《即时消息技术剖析与实战》学习笔记5——IM系统如何保证消息的一致性

一.什么是消息一致性 消息一致性指的是消息的时序一致性,即消息收发的一致性.如果不能保证时序一致性,就会造成聊天语义不连贯,引起误会. 对于点对点的聊天场景,时序一致性保证接收方的接收顺序和发送方的发 ...

- c语言实现字符指针(字符串)数组的排序

需求: "ff555d", "114ddd", "114dd","aaa", "aaab", &qu ...

- springboot以jar运行时参数传递

springboot以jar运行时参数传递 spring boot项目我们都习惯以内嵌tomcat方式.直接打包成jar,运行时使用: java -jar XXX.jar --spring.prof ...

- 去重合并两个有序链表之直接操作和Set集合操作

两者思路对比: 直接操作:因为传入的是两个有序的链表,所以说我就直接以其中一个链表为基准,与另外一个链表比较,只将比返回值链表的最后一个记录的值大的插入,不将等值的插入,理论时间复杂度为O(n) Se ...

- FreeSql (二十六)贪婪加载 Include、IncludeMany、Dto、ToList

贪婪加载顾名思议就是把所有要加载的东西一次性读取. 本节内容为了配合[延时加载]而诞生,贪婪加载和他本该在一起介绍,开发项目的过程中应该双管齐下,才能写出高质量的程序. Dto 映射查询 Select ...

- 装系统---------- u盘 安装系统

1.首先根据你的电脑品牌进入bios 模式 如何进入: 不同电脑品牌进入bios 方法 进入之后设置启动方式 将第一启动设置为U盘启动设置好后 使用 Fn + F10 保存 2.使用制作好的 U盘 ...