Java 网络爬虫获取页面源代码

原博文:http://www.cnblogs.com/xudong-bupt/archive/2013/03/20/2971893.html

1.网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。

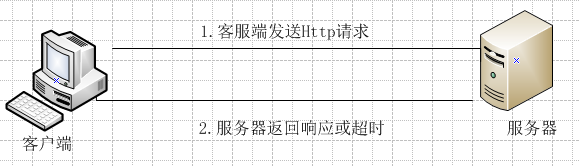

2.那么程序获取网页的原理到底是怎么回事呢?看下面的图:客服端首先向服务器端发出Http请求,之后服务器端返回相应的结果或者请求超时客户端自己报错。

服务器端发出的Http请求,实际上说是对服务器的文件的请求。下面的表格是一些常见的HTTP请求对应的文件。(因为第一列给出的都是主机的网址信息,主机一般都通过配置文件将该请求转换为网站主页地址index.php或index.jsp或者index.html等)

服务器端发出的Http请求,实际上说是对服务器的文件的请求。下面的表格是一些常见的HTTP请求对应的文件。(因为第一列给出的都是主机的网址信息,主机一般都通过配置文件将该请求转换为网站主页地址index.php或index.jsp或者index.html等)

| HTTP请求 | HTTP对应的文件 |

| http://www.baidu.com | http://www.baidu.com/index.php |

| http://www.sina.com.cn | http://www.sina.com.cn/index.html |

| http://www.cnblogs.com | http://www.cnblogs.com/index.html |

| http://ac.jobdu.com | http://ac.jobdu.com/index.php |

3.java实现网页源码获取的步骤:

(1)新建URL对象,表示要访问的网址。如:url=new URL("http://www.sina.com.cn");

(2)建立HTTP连接,返回连接对象urlConnection对象。如:urlConnection = (HttpURLConnection)url.openConnection();

(3)获取相应HTTP 状态码。如responsecode=urlConnection.getResponseCode();

(4)如果HTTP 状态码为200,表示成功。从urlConnection对象获取输入流对象来获取请求的网页源代码。

4.java获取网页源码代码:

import java.io.BufferedReader;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

public class WebPageSource {

public static void main(String args[]){

URL url;

int responsecode;

HttpURLConnection urlConnection;

BufferedReader reader;

String line;

try{

//生成一个URL对象,要获取源代码的网页地址为:http://www.sina.com.cn

url=new URL("http://www.sina.com.cn");

//打开URL

urlConnection = (HttpURLConnection)url.openConnection();

//获取服务器响应代码

responsecode=urlConnection.getResponseCode();

if(responsecode==200){

//得到输入流,即获得了网页的内容

reader=new BufferedReader(new InputStreamReader(urlConnection.getInputStream(),"UTF-8"));

while((line=reader.readLine())!=null){

System.out.println(line);

}

}

else{

System.out.println("获取不到网页的源码,服务器响应代码为:"+responsecode);

}

}

catch(Exception e){

System.out.println("获取不到网页的源码,出现异常:"+e);

}

}

}

Java 网络爬虫获取页面源代码的更多相关文章

- Java 网络爬虫获取网页源代码原理及实现

Java 网络爬虫获取网页源代码原理及实现 1.网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成.传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL ...

- Java 网络爬虫,就是这么的简单

这是 Java 网络爬虫系列文章的第一篇,如果你还不知道 Java 网络爬虫系列文章,请参看 学 Java 网络爬虫,需要哪些基础知识.第一篇是关于 Java 网络爬虫入门内容,在该篇中我们以采集虎扑 ...

- java网络爬虫基础学习(一)

刚开始接触java爬虫,在这里是搜索网上做一些理论知识的总结 主要参考文章:gitchat 的java 网络爬虫基础入门,好像要付费,也不贵,感觉内容对新手很友好. 一.爬虫介绍 网络爬虫是一个自动提 ...

- 学 Java 网络爬虫,需要哪些基础知识?

说起网络爬虫,大家想起的估计都是 Python ,诚然爬虫已经是 Python 的代名词之一,相比 Java 来说就要逊色不少.有不少人都不知道 Java 可以做网络爬虫,其实 Java 也能做网络爬 ...

- Java网络爬虫笔记

Java网络爬虫笔记 HttpClient来代替浏览器发起请求. select找到的是元素,也就是elements,你想要获取具体某一个属性的值,还是要用attr("")方法.标签 ...

- java网络爬虫基础学习(三)

尝试直接请求URL获取资源 豆瓣电影 https://movie.douban.com/explore#!type=movie&tag=%E7%83%AD%E9%97%A8&sort= ...

- java网络爬虫----------简单抓取慕课网首页数据

© 版权声明:本文为博主原创文章,转载请注明出处 一.分析 1.目标:抓取慕课网首页推荐课程的名称和描述信息 2.分析:浏览器F12分析得到,推荐课程的名称都放在class="course- ...

- 简单的Java网络爬虫(获取一个网页中的邮箱)

import java.io.BufferedReader; import java.io.FileNotFoundException; import java.io.FileReader; impo ...

- 【转】44款Java 网络爬虫开源软件

原帖地址 http://www.oschina.net/project/lang/19?tag=64&sort=time 极简网络爬虫组件 WebFetch WebFetch 是无依赖极简网页 ...

随机推荐

- python学习 3笔记

merge dict def merge(defaults, override): r = {} for k, v in defaults.items(): if k in override: if ...

- VS 编辑器扩展辅助工具

[工具]——[扩展和更新]——[联机]输入 C# outline 2015

- 寒冬之下,浩瀚智能开单收银打印扫描POS为何能在批发零售门店商场 车销行业 风靡!:进销存+打印扫描POS机

是一款适用于商超.餐饮.服装鞋帽.家电专营等等具有零售行业特点的企业,供企业管理人员用于管理.监控本品牌的市场占有率.门店覆盖区域.网点分布合理性等经济地理信息的工具平台. 1,功能一:业务抄单文章来 ...

- [资料分享]7天搞定Node.js微信公众号开发

- Poj2676

经典DFS现在看来nice啊! package SoduKu; import java.io.InputStreamReader; import java.util.Scanner; /* *我用ro ...

- 【BZOJ1700】[Usaco2007 Jan]Problem Solving 解题 动态规划

[BZOJ1700][Usaco2007 Jan]Problem Solving 解题 Description 过去的日子里,农夫John的牛没有任何题目. 可是现在他们有题目,有很多的题目. 精确地 ...

- 【填坑】bzoj3224 splay裸题

人生第一道splay不出所料是一道裸题,一道水题,一道2k代码都不到的题 #include <cstdio> ,n,p,q; ],c[][],size[],sp[]; void rot(i ...

- 我听说 C...

我听说在 c 语言的世界里,goto 和异常处理都是声名狼藉的东西,而我认为它们在一起就能化解各自的问题.

- tomcat之Session的管理

Session是由服务器端的应用服务器容器(如Tomcat.Jetty)存储的.下面分析一下Tomcat是如何管理Session的. 转自:tomcat架构分析 (Session管理) Tomcat中 ...

- SectionIndexer示例

This small tutorial will show you how to create a ListView, enable fast scrolling, and create a alph ...