一 kubeadm介绍

1.1 概述

参考《附003.Kubeadm部署Kubernetes》。

1.2 kubeadm功能

参考《附003.Kubeadm部署Kubernetes》。

二 部署规划

2.1 节点规划

|

节点主机名

|

IP

|

类型

|

运行服务

|

|

master01

|

172.24.8.71

|

Kubernetes master节点

|

docker、etcd、kube-apiserver、kube-scheduler、kube-controller-manager、kubectl、kubelet、metrics、calico

|

|

master02

|

172.24.8.72

|

Kubernetes master节点

|

docker、etcd、kube-apiserver、kube-scheduler、kube-controller-manager、kubectl、kubelet、metrics、calico

|

|

master03

|

172.24.8.73

|

Kubernetes master节点

|

docker、etcd、kube-apiserver、kube-scheduler、kube-controller-manager、kubectl、kubelet、metrics、calico

|

|

worker01

|

172.24.8.74

|

Kubernetes node节点1

|

docker、kubelet、proxy、calico

|

|

worker02

|

172.24.8.75

|

Kubernetes node节点2

|

docker、kubelet、proxy、calico

|

|

worker03

|

172.24.8.76

|

Kubernetes node节点3

|

docker、kubelet、proxy、calico

|

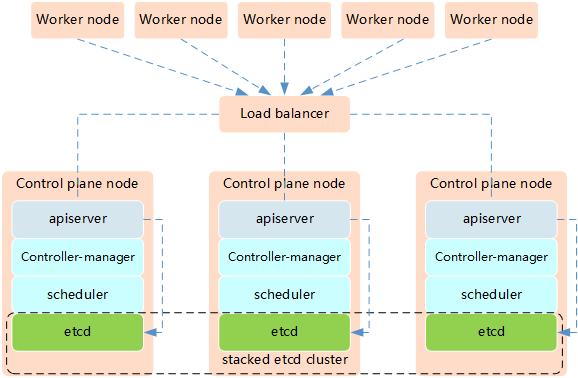

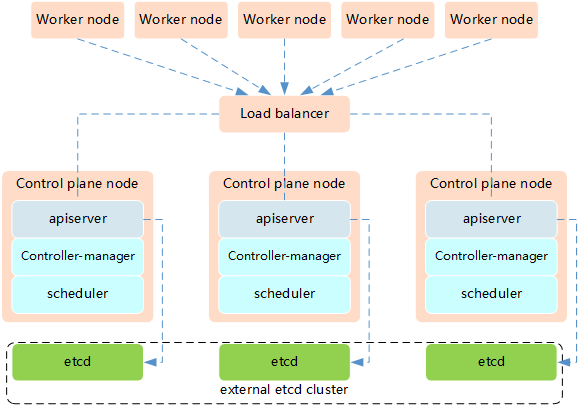

Kubernetes的高可用主要指的是控制平面的高可用,即指多套Master节点组件和Etcd组件,工作节点通过负载均衡连接到各Master。HA有通常有如下两种架构:

高可用架构一:etcd与Master节点组件混布在一起。

高可用架构二:使用独立的Etcd集群,不与Master节点混布。

释义:

两种方式的相同之处在于都提供了控制平面的冗余,实现了集群高可以用,区别在于:

- 所需机器资源少

- 部署简单,利于管理

- 容易进行横向扩展

- 风险大,一台宿主机挂了,master和etcd就都少了一套,集群冗余度受到的影响比较大。

- 所需机器资源多(按照Etcd集群的奇数原则,这种拓扑的集群关控制平面最少需要6台宿主机了)

- 部署相对复杂,要独立管理etcd集群和和master集群

- 解耦了控制平面和Etcd,集群风险小健壮性强,单独挂了一台master或etcd对集群的影响很小

提示:本实验使用高可用架构一实现Kubernetes的高可用。

2.2 初始准备

[root@master01 ~]# vi k8sinit.sh

#!/bin/sh

#****************************************************************#

# ScriptName: k8sinit.sh

# Author: xhy

# Create Date: 2019-06-23 22:19

# Modify Author: xhy

# Modify Date: 2020-03-16 20:44

# Version:

#***************************************************************#

# Initialize the machine. This needs to be executed on every machine.

# Add host domain name.

cat >> /etc/hosts << EOF

172.24.8.71 master01

172.24.8.72 master02

172.24.8.73 master03

172.24.8.74 worker01

172.24.8.75 worker02

172.24.8.76 worker03

EOF

# Add docker user

useradd -m docker

# Disable the SELinux.

sed -i 's/^SELINUX=.*/SELINUX=disabled/' /etc/selinux/config

# Turn off and disable the firewalld.

systemctl stop firewalld

systemctl disable firewalld

# Modify related kernel parameters & Disable the swap.

cat > /etc/sysctl.d/k8s.conf << EOF

net.ipv4.ip_forward = 1

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.tcp_tw_recycle = 0

vm.swappiness = 0

vm.overcommit_memory = 1

vm.panic_on_oom = 0

net.ipv6.conf.all.disable_ipv6 = 1

EOF

sysctl -p /etc/sysctl.d/k8s.conf >&/dev/null

swapoff -a

sed -i '/ swap / s/^\(.*\)$/#\1/g' /etc/fstab

modprobe br_netfilter

# Add ipvs modules

cat > /etc/sysconfig/modules/ipvs.modules <<EOF

#!/bin/bash

modprobe -- ip_vs

modprobe -- ip_vs_rr

modprobe -- ip_vs_wrr

modprobe -- ip_vs_sh

modprobe -- nf_conntrack_ipv4

EOF

chmod 755 /etc/sysconfig/modules/ipvs.modules

bash /etc/sysconfig/modules/ipvs.modules

# Install rpm

yum install -y conntrack ntpdate ntp ipvsadm ipset jq iptables curl sysstat libseccomp wget

# Install Docker Compose

sudo curl -L "http://down.linuxsb.com:8888/docker/compose/releases/download/1.25.4/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

sudo chmod +x /usr/local/bin/docker-compose

# Update kernel

rpm --import http://down.linuxsb.com:8888/RPM-GPG-KEY-elrepo.org

rpm -Uvh http://down.linuxsb.com:8888/elrepo-release-7.0-4.el7.elrepo.noarch.rpm

yum --disablerepo="*" --enablerepo="elrepo-kernel" install -y kernel-ml

sed -i 's/^GRUB_DEFAULT=.*/GRUB_DEFAULT=0/' /etc/default/grub

grub2-mkconfig -o /boot/grub2/grub.cfg

yum update -y

# Reboot the machine.

# reboot

提示:对于某些特性,可能需要升级内核,内核升级操作见《018.Linux升级内核》。

2.3 互信配置

为了更方便远程分发文件和执行命令,本实验配置master节点到其它节点的 ssh 信任关系。

[root@master01 ~]# ssh-keygen -f ~/.ssh/id_rsa -N ''

[root@master01 ~]# ssh-copy-id -i ~/.ssh/id_rsa.pub root@master01

[root@master01 ~]# ssh-copy-id -i ~/.ssh/id_rsa.pub root@master02

[root@master01 ~]# ssh-copy-id -i ~/.ssh/id_rsa.pub root@master03

[root@master01 ~]# ssh-copy-id -i ~/.ssh/id_rsa.pub root@worker01

[root@master01 ~]# ssh-copy-id -i ~/.ssh/id_rsa.pub root@worker02

[root@master01 ~]# ssh-copy-id -i ~/.ssh/id_rsa.pub root@worker03

提示:此操作仅需要在master01节点操作。

2.4 其他准备

[root@master01 ~]# vi environment.sh

#!/bin/sh

#****************************************************************#

# ScriptName: environment.sh

# Author: xhy

# Create Date: 2020-03-16 23:11

# Modify Author: xhy

# Modify Date: 2020-03-16 23:11

# Version:

#***************************************************************#

# 集群 MASTER 机器 IP 数组

export MASTER_IPS=(172.24.8.71 172.24.8.72 172.24.8.73)

# 集群 MASTER IP 对应的主机名数组

export MASTER_NAMES=(master01 master02 master03)

# 集群 NODE 机器 IP 数组

export NODE_IPS=(172.24.8.74 172.24.8.75 172.24.8.76)

# 集群 NODE IP 对应的主机名数组

export NODE_NAMES=(worker01 worker02 worker03)

# 集群所有机器 IP 数组

export ALL_IPS=(172.24.8.71 172.24.8.72 172.24.8.73 172.24.8.74 172.24.8.75 172.24.8.76)

# 集群所有IP 对应的主机名数组

export ALL_NAMES=(master01 master02 master03 worker01 worker02 worker03)

[root@master01 ~]# source environment.sh

[root@master01 ~]# chmod +x environment.sh

[root@master01 ~]# for all_ip in ${ALL_IPS[@]}

do

echo ">>> ${all_ip}"

scp -rp k8sinit.sh root@${all_ip}:/root/

ssh root@${all_ip} "bash /root/k8sinit.sh"

done

三 集群部署

3.1 Docker安装

[root@master01 ~]# for all_ip in ${ALL_IPS[@]}

do

echo ">>> ${all_ip}"

ssh root@${all_ip} "yum -y install yum-utils device-mapper-persistent-data lvm2"

ssh root@${all_ip} "yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo"

ssh root@${all_ip} "yum -y install docker-ce"

ssh root@${all_ip} "mkdir /etc/docker"

ssh root@${all_ip} "cat > /etc/docker/daemon.json <<EOF

{

\"registry-mirrors\": [\"https://dbzucv6w.mirror.aliyuncs.com\"],

\"exec-opts\": [\"native.cgroupdriver=systemd\"],

\"log-driver\": \"json-file\",

\"log-opts\": {

\"max-size\": \"100m\"

},

\"storage-driver\": \"overlay2\",

\"storage-opts\": [

\"overlay2.override_kernel_check=true\"

]

}

EOF"

ssh root@${all_ip} "systemctl restart docker"

ssh root@${all_ip} "systemctl enable docker"

ssh root@${all_ip} "systemctl status docker"

ssh root@${all_ip} "iptables -nvL"

done

提示:如上仅需Master01节点操作,从而实现所有节点自动化安装。

3.2 相关组件包

需要在每台机器上都安装以下的软件包:

kubeadm: 用来初始化集群的指令;

kubelet: 在集群中的每个节点上用来启动 pod 和 container 等;

kubectl: 用来与集群通信的命令行工具。

kubeadm不能安装或管理 kubelet 或 kubectl ,所以得保证他们满足通过 kubeadm 安装的 Kubernetes 控制层对版本的要求。如果版本没有满足要求,可能导致一些意外错误或问题。

具体相关组件安装见《附001.kubectl介绍及使用》。

提示:Kubernetes 1.17版本所有兼容相应组件的版本参考:https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG/CHANGELOG-1.17.md。

3.3 正式安装

[root@master01 ~]# for all_ip in ${ALL_IPS[@]}

do

echo ">>> ${all_ip}"

ssh root@${all_ip} "cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF"

ssh root@${all_ip} "yum install -y kubeadm-1.17.4-0.x86_64 kubelet-1.17.4-0.x86_64 kubectl-1.17.4-0.x86_64 --disableexcludes=kubernetes"

ssh root@${all_ip} "systemctl enable kubelet"

done

提示:如上仅需Master01节点操作,从而实现所有节点自动化安装,同时此时不需要启动kubelet,初始化的过程中会自动启动的,如果此时启动了会出现报错,忽略即可。

说明:同时安装了cri-tools, kubernetes-cni, socat三个依赖:

socat:kubelet的依赖;

cri-tools:即CRI(Container Runtime Interface)容器运行时接口的命令行工具。

四 部署高可用组件I

4.1 Keepalived安装

[root@master01 ~]# for master_ip in ${MASTER_IPS[@]}

do

echo ">>> ${master_ip}"

ssh root@${master_ip} "yum -y install gcc gcc-c++ make libnl libnl-devel libnfnetlink-devel openssl-devel"

ssh root@${master_ip} "wget http://down.linuxsb.com:8888/software/keepalived-2.0.20.tar.gz"

ssh root@${master_ip} "tar -zxvf keepalived-2.0.20.tar.gz"

ssh root@${master_ip} "cd keepalived-2.0.20/ && ./configure --sysconf=/etc --prefix=/usr/local/keepalived && make && make install"

ssh root@${master_ip} "systemctl enable keepalived && systemctl start keepalived"

done

提示:如上仅需Master01节点操作,从而实现所有节点自动化安装。

4.2 创建配置文件

[root@master01 ~]# git clone https://github.com/cookeem/kubeadm-ha #拉取github的高可用自动配置脚本

[root@master01 ~]# cd kubeadm-ha/

[root@master01 kubeadm-ha]# vi create-config.sh #其他部分保持默认

#!/bin/bash

#######################################

# set variables below to create the config files, all files will create at ./config directory

#######################################

# master keepalived virtual ip address

export K8SHA_VIP=172.24.8.71

# master01 ip address

export K8SHA_IP1=172.24.8.72

# master02 ip address

export K8SHA_IP2=172.24.8.73

# master03 ip address

export K8SHA_IP3=172.24.8.74

# master keepalived virtual ip hostname

export K8SHA_VHOST=master

# master01 hostname

export K8SHA_HOST1=master01

# master02 hostname

export K8SHA_HOST2=master02

# master03 hostname

export K8SHA_HOST3=master03

# master01 network interface name

export K8SHA_NETINF1=eth0

# master02 network interface name

export K8SHA_NETINF2=eth0

# master03 network interface name

export K8SHA_NETINF3=eth0

# keepalived auth_pass config

export K8SHA_KEEPALIVED_AUTH=412f7dc3bfed32194d1600c483e10ad1d

# calico reachable ip address

export K8SHA_CALICO_REACHABLE_IP=172.24.8.2

# kubernetes CIDR pod subnet

export K8SHA_CIDR=10.10.0.0

[root@master01 kubeadm-ha]# bash create-config.sh

解释:如上仅需Master01节点操作。执行脚本后会生产如下配置文件清单:

执行create-config.sh脚本后,会自动生成以下配置文件:

- kubeadm-config.yaml:kubeadm初始化配置文件,位于kubeadm-ha代码的./根目录

- keepalived:keepalived配置文件,位于各个master节点的/etc/keepalived目录

- nginx-lb:nginx-lb负载均衡配置文件,位于各个master节点的/root/nginx-lb目录

- calico.yaml:calico网络组件部署文件,位于kubeadm-ha代码的./calico目录

[root@master01 kubeadm-ha]# vi kubeadm-config.yaml #完善配置

---

apiVersion: kubeadm.k8s.io/v1beta1

kind: ClusterConfiguration

kubernetesVersion: v1.17.4 #设置安装版本

apiServerCertSANs:

- master01

- master02

- master03

- master

- 172.24.8.71

- 172.24.8.72

- 172.24.8.73

- 172.24.8.254

controlPlaneEndpoint: "172.24.8.254:16443" #设置相关地址

networking:

# This CIDR is a Calico default. Substitute or remove for your CNI provider.

podSubnet: "10.10.0.0/16" #设置Pod网段

serviceSubnet: "192.168.0.0/16" #设置svc网段

---

apiVersion: kubeproxy.config.k8s.io/v1alpha1

kind: KubeProxyConfiguration

mode: ipvs

提示:如上仅需Master01节点操作,更多config文件参考:https://godoc.org/k8s.io/kubernetes/cmd/kubeadm/app/apis/kubeadm/v1beta2。

4.3 启动Keepalived

[root@master01 ~]# cat /etc/keepalived/keepalived.conf

[root@master01 ~]# cat /etc/keepalived/check_apiserver.sh 确认Keepalived配置

[root@master01 ~]# for master_ip in ${MASTER_IPS[@]}

do

echo ">>> ${master_ip}"

ssh root@${master_ip} "systemctl restart keepalived.service"

ssh root@${master_ip} "systemctl status keepalived.service"

ssh root@${master_ip} "ping -c1 172.24.8.254"

done

提示:如上仅需Master01节点操作,从而实现所有节点自动启动服务。

4.4 启动Nginx

执行create-config.sh脚本后,nginx-lb的配置文件会自动复制到各个master的节点的/root/nginx-lb目录

[root@master01 ~]# for master_ip in ${MASTER_IPS[@]}

do

echo ">>> ${master_ip}"

ssh root@${master_ip} "cd /root/nginx-lb/ && docker-compose up -d"

ssh root@${master_ip} "docker-compose ps"

done

提示:如上仅需Master01节点操作,从而实现所有节点自动启动服务。

五 初始化集群-Master

5.1 拉取镜像

[root@master01 ~]# kubeadm --kubernetes-version=v1.17.4 config images list #列出所需镜像

[root@master01 ~]# docker login --username=x120952576@126.com registry.aliyuncs.com

[root@master01 ~]# vi down.sh

#!/bin/bash

# 使用如下脚本下载国内镜像,并修改tag为google的tag

KUBE_VERSION=v1.17.4

KUBE_PAUSE_VERSION=3.1

ETCD_VERSION=3.4.3-0

CORE_DNS_VERSION=1.6.5

GCR_URL=k8s.gcr.io

ALIYUN_URL=registry.cn-hangzhou.aliyuncs.com/google_containers

images=(kube-proxy:${KUBE_VERSION}

kube-scheduler:${KUBE_VERSION}

kube-controller-manager:${KUBE_VERSION}

kube-apiserver:${KUBE_VERSION}

pause:${KUBE_PAUSE_VERSION}

etcd:${ETCD_VERSION}

coredns:${CORE_DNS_VERSION})

for imageName in ${images[@]} ; do

docker pull $ALIYUN_URL/$imageName

docker tag $ALIYUN_URL/$imageName $GCR_URL/$imageName

docker rmi $ALIYUN_URL/$imageName

done

[root@master01 ~]# chmod u+x down.sh

[root@master01 ~]# for master_ip in ${MASTER_IPS[@]}

do

echo ">>> ${master_ip}"

scp -rp down.sh root@${master_ip}:/root/

ssh root@${master_ip} "bash down.sh &"

done

提示:如上仅需Master01节点操作,从而实现所有Master节点自动拉取镜像。

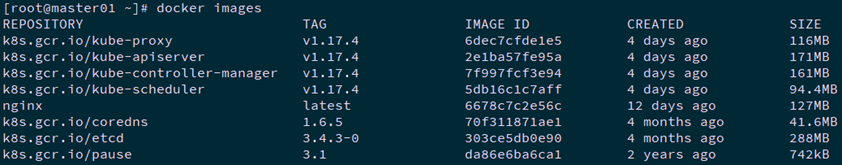

[root@master01 ~]# docker images #确认验证

5.2 Master上初始化

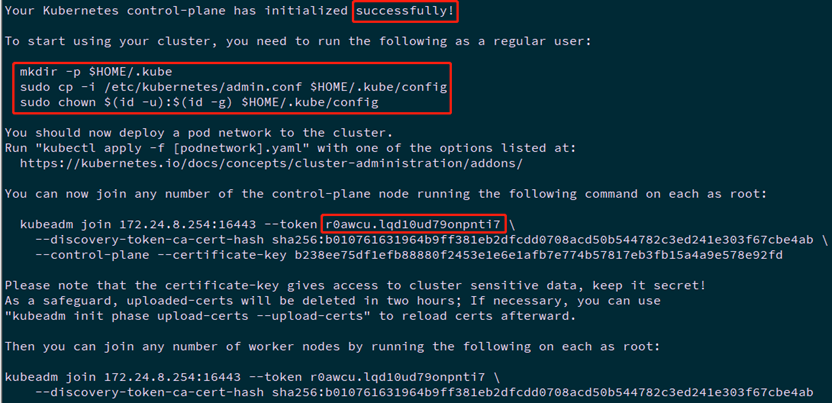

[root@master01 ~]# kubeadm init --config=/root/kubeadm-ha/kubeadm-config.yaml --upload-certs

保留如下命令用于后续节点添加:

You can now join any number of the control-plane node running the following command on each as root:

kubeadm join 172.24.8.254:16443 --token r0awcu.lqd10ud79onpnti7 \

--discovery-token-ca-cert-hash sha256:b010761631964b9ff381eb2dfcdd0708acd50b544782c3ed241e303f67cbe4ab \

--control-plane --certificate-key b238ee75df1efb88880f2453e1e6e1afb7e774b57817eb3fb15a4a9e578e92fd

Please note that the certificate-key gives access to cluster sensitive data, keep it secret!

As a safeguard, uploaded-certs will be deleted in two hours; If necessary, you can use

"kubeadm init phase upload-certs --upload-certs" to reload certs afterward.

Then you can join any number of worker nodes by running the following on each as root:

kubeadm join 172.24.8.254:16443 --token r0awcu.lqd10ud79onpnti7 \

--discovery-token-ca-cert-hash sha256:b010761631964b9ff381eb2dfcdd0708acd50b544782c3ed241e303f67cbe4ab

注意:如上token具有默认24小时的有效期,token和hash值可通过如下方式获取:

kubeadm token list

如果 Token 过期以后,可以输入以下命令,生成新的 Token

kubeadm token create openssl x509 -pubkey -in /etc/kubernetes/pki/ca.crt | openssl rsa -pubin -outform der 2>/dev/null | openssl dgst -sha256 -hex | sed 's/^.* //'

[root@master01 ~]# mkdir -p $HOME/.kube

[root@master01 ~]# sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

[root@master01 ~]# sudo chown $(id -u):$(id -g) $HOME/.kube/config

[root@master01 ~]# cat << EOF >> ~/.bashrc

export KUBECONFIG=$HOME/.kube/config

EOF #设置KUBECONFIG环境变量

[root@master01 ~]# echo "source <(kubectl completion bash)" >> ~/.bashrc

[root@master01 ~]# source ~/.bashrc

附加:初始化过程大致步骤如下:

- [kubelet-start] 生成kubelet的配置文件”/var/lib/kubelet/config.yaml”

- [certificates]生成相关的各种证书

- [kubeconfig]生成相关的kubeconfig文件

- [bootstraptoken]生成token记录下来,后边使用kubeadm join往集群中添加节点时会用到

提示:初始化仅需要在master01上执行,若初始化异常可通过kubeadm reset && rm -rf $HOME/.kube重置。

5.3 添加其他master节点

[root@master02 ~]# kubeadm join 172.24.8.254:16443 --token r0awcu.lqd10ud79onpnti7 \

--discovery-token-ca-cert-hash sha256:b010761631964b9ff381eb2dfcdd0708acd50b544782c3ed241e303f67cbe4ab \

--control-plane --certificate-key b238ee75df1efb88880f2453e1e6e1afb7e774b57817eb3fb15a4a9e578e92fd

[root@master02 ~]# mkdir -p $HOME/.kube

[root@master02 ~]# sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

[root@master02 ~]# sudo chown $(id -u):$(id -g) $HOME/.kube/config

[root@master02 ~]# cat << EOF >> ~/.bashrc

export KUBECONFIG=$HOME/.kube/config

EOF #设置KUBECONFIG环境变量

[root@master02 ~]# echo "source <(kubectl completion bash)" >> ~/.bashrc

[root@master02 ~]# source ~/.bashrc

提示:master03也如上执行添加至集群的controlplane。

提示:若添加异常可通过kubeadm reset && rm -rf $HOME/.kube重置。

六 安装NIC插件

6.1 NIC插件介绍

Calico 是一个安全的 L3 网络和网络策略提供者。

Canal 结合 Flannel 和 Calico, 提供网络和网络策略。

Cilium 是一个 L3 网络和网络策略插件, 能够透明的实施 HTTP/API/L7 策略。 同时支持路由(routing)和叠加/封装( overlay/encapsulation)模式。

Contiv 为多种用例提供可配置网络(使用 BGP 的原生 L3,使用 vxlan 的 overlay,经典 L2 和 Cisco-SDN/ACI)和丰富的策略框架。Contiv 项目完全开源。安装工具同时提供基于和不基于 kubeadm 的安装选项。

Flannel 是一个可以用于 Kubernetes 的 overlay 网络提供者。

Romana 是一个 pod 网络的层 3 解决方案,并且支持 NetworkPolicy API。Kubeadm add-on 安装细节可以在这里找到。

Weave Net 提供了在网络分组两端参与工作的网络和网络策略,并且不需要额外的数据库。

CNI-Genie 使 Kubernetes 无缝连接到一种 CNI 插件,例如:Flannel、Calico、Canal、Romana 或者 Weave。

提示:本实验使用Calico插件。

6.2 设置标签

[root@master01 ~]# kubectl taint nodes --all node-role.kubernetes.io/master- #允许master部署应用

提示:部署完内部应用后可使用kubectl taint node k8smaster03 node-role.kubernetes.io/master="":NoSchedule重新设置Master为Master Only 状态。

6.3 部署calico

[root@master01 ~]# for all_ip in ${ALL_IPS[@]}

do

echo ">>> ${all_ip}"

ssh root@${all_ip} "docker pull calico/cni:v3.11.2"

ssh root@${all_ip} "docker pull calico/pod2daemon-flexvol:v3.11.2"

ssh root@${all_ip} "docker pull calico/node:v3.11.2"

ssh root@${all_ip} "docker pull calico/kube-controllers:v3.11.2"

done

#建议提前pull镜像

提示:如上仅需Master01节点操作,从而实现所有Master节点自动拉取镜像。

[root@master01 ~]# wget https://docs.projectcalico.org/v3.11/manifests/calico.yaml

[root@master01 ~]# vi calico.yaml

……

- name: CALICO_IPV4POOL_CIDR

value: "10.10.0.0/16" #配置Pod网段

……

- name: IP_AUTODETECTION_METHOD

value: "interface=eth.*" #追加节点之间的网卡

# Auto-detect the BGP IP address.

- name: IP

value: "autodetect"

……

[root@master01 ~]# kubectl apply -f calico.yaml

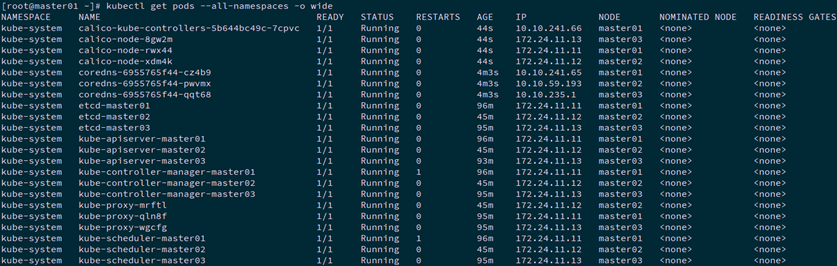

[root@master01 ~]# kubectl get pods --all-namespaces -o wide #查看部署

[root@master01 ~]# kubectl get nodes

七 部署高可用组件II

7.1 高可用说明

高可用kubernetes集群步骤三已完成配置,但是使用docker-compose方式启动nginx-lb由于无法提供kubernetes集群的健康检查和自动重启功能,nginx-lb作为高可用kubernetes集群的核心组件建议也作为kubernetes集群中的一个pod来进行管理。

在/etc/kubernetes/manifests/目录下,是kubelet直接管理的核心部署文件。现在我们停止原先使用docker-compose启动的nginx-lb,由kubelet直接管理nginx-lb服务。

7.2 容器化实现高可用

[root@master01 ~]# for master_ip in ${MASTER_IPS[@]}

do

echo ">>> ${master_ip}"

ssh root@${master_ip} "systemctl stop kubelet"

ssh root@${master_ip} "docker stop nginx-lb && docker rm nginx-lb"

scp -rp /root/nginx-lb/nginx-lb.conf root@${master_ip}:/etc/kubernetes/

scp -rp /root/nginx-lb/nginx-lb.yaml root@${master_ip}:/etc/kubernetes/manifests/

ssh root@${master_ip} "systemctl restart kubelet docker"

done

提示:如上仅需Master01节点操作,从而实现所有Master节点自动启动服务。

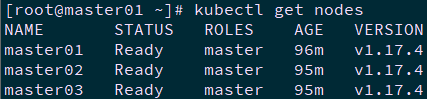

[root@master01 ~]# kubectl get pods --all-namespaces -o wide #再次验证

八 添加Worker节点

8.1 下载镜像

为避免node节点无法pull相关镜像,建议体现pull。

[root@master01 ~]# for node_ip in ${NODE_IPS[@]}

do

echo ">>> ${node_ip}"

ssh root@${node_ip} "docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1"

ssh root@${node_ip} "docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1 k8s.gcr.io/pause:3.1"

ssh root@${node_ip} "docker rmi registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1"

ssh root@${node_ip} "docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.17.4"

ssh root@${node_ip} "docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.17.4 k8s.gcr.io/kube-proxy:v1.17.4"

ssh root@${node_ip} "docker rmi registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.17.4"

done

提示:如上仅需Master01节点操作,从而实现所有Master节点自动拉取镜像。

8.2 添加Worker节点

[root@master01 ~]# for node_ip in ${NODE_IPS[@]}

do

echo ">>> ${node_ip}"

ssh root@${node_ip} "kubeadm join 172.24.8.254:16443 --token r0awcu.lqd10ud79onpnti7 --discovery-token-ca-cert-hash sha256:b010761631964b9ff381eb2dfcdd0708acd50b544782c3ed241e303f67cbe4ab"

ssh root@${node_ip} "systemctl enable kubelet.service"

done

提示:如上仅需Master01节点操作,从而实现所有Worker节点添加至集群,若添加异常可通过如下方式重置:

[root@node01 ~]# kubeadm reset

[root@node01 ~]# ifconfig cni0 down

[root@node01 ~]# ip link delete cni0

[root@node01 ~]# ifconfig flannel.1 down

[root@node01 ~]# ip link delete flannel.1

[root@node01 ~]# rm -rf /var/lib/cni/

8.3 确认验证

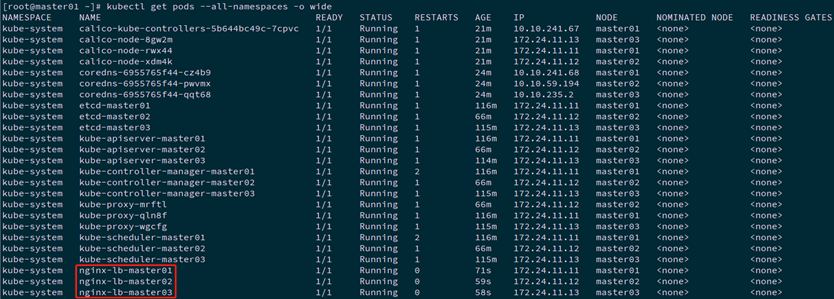

[root@master01 ~]# kubectl get nodes #节点状态

[root@master01 ~]# kubectl get cs #组件状态

[root@master01 ~]# kubectl get serviceaccount #服务账户

[root@master01 ~]# kubectl cluster-info #集群信息

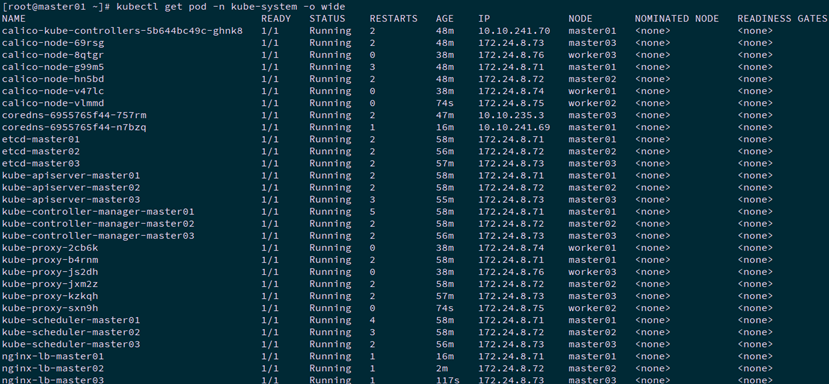

[root@master01 ~]# kubectl get pod -n kube-system -o wide #所有服务状态

提示:更多Kubetcl使用参考:https://kubernetes.io/docs/reference/kubectl/kubectl/

https://kubernetes.io/docs/reference/kubectl/overview/

更多kubeadm使用参考:https://kubernetes.io/docs/reference/setup-tools/kubeadm/kubeadm/

九 开启IPVS

提示:通常4.2修改config文件后已开启ipvs,若未开启可通过如下方式修改。

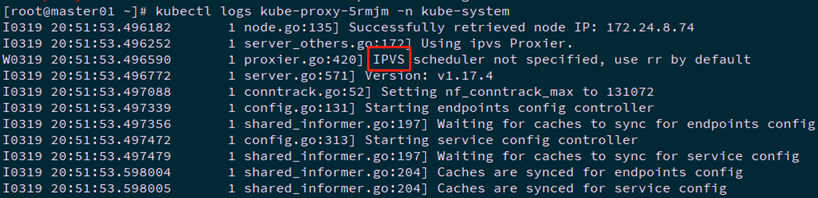

[root@master01 ~]# kubectl logs kube-proxy-b4rnm -n kube-system #查看任意一个proxy pod的日志

9.1 修改ConfigMap

[root@master01 ~]# kubectl edit cm kube-proxy -n kube-system #模式改为ipvs

……

mode: "ipvs"

……

[root@master01 ~]# kubectl get pod -n kube-system | grep kube-proxy | awk '{system("kubectl delete pod "$1" -n kube-system")}'

[root@master01 ~]# kubectl get pod -n kube-system | grep kube-proxy #查看proxy的pod

[root@master01 ~]# kubectl logs kube-proxy-2c8tj -n kube-system #查看任意一个proxy pod的日志

十 测试集群

10.1 创建测试service

[root@master01 ~]# kubectl run nginx --replicas=2 --labels="run=load-balancer-example" --image=nginx --port=80

[root@master01 ~]# kubectl expose deployment nginx --type=NodePort --name=example-service #暴露端口

[root@master01 ~]# kubectl get service #查看服务状态

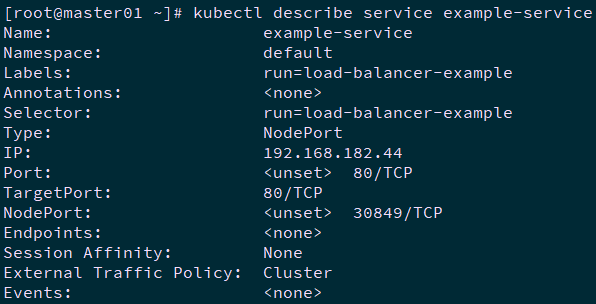

[root@master01 ~]# kubectl describe service example-service #查看信息

10.2 测试访问

[root@master01 ~]# curl 192.168.182.44

[root@master01 ~]# kubectl get pod -o wide #查看endpoint

[root@master01 ~]# curl 10.10.5.1 #访问endpoint,与访问服务ip结果相同

[root@master01 ~]# curl 10.10.19.65

[root@master01 ~]# kubectl delete deployments.apps nginx

[root@master01 ~]# kubectl delete service example-service

十一 部署dashboard

参考《附017.Kubernetes_v1.17 Dashboard部署》。

参考链接:

https://blog.csdn.net/fanren224/article/details/86573264

https://blog.frognew.com/2019/04/kubeadm-install-kubernetes-1.14.html

http://www.luyixian.cn/news_show_11429.aspx

https://www.kubernetes.org.cn/4956.html

https://github.com/cookeem/kubeadm-ha

- 附024.Kubernetes_v1.18.3高可用部署架构二

kubeadm介绍 kubeadm概述 参考<附003.Kubeadm部署Kubernetes>. kubeadm功能 参考<附003.Kubeadm部署Kubernetes> ...

- 附028.Kubernetes_v1.20.0高可用部署架构二

目录 kubeadm介绍 kubeadm概述 kubeadm功能 本方案描述 部署规划 节点规划 初始准备 互信配置 其他准备 集群部署 相关组件包 正式安装 部署高可用组件I Keepalived安 ...

- 附031.Kubernetes_v1.20.4高可用部署架构二

kubeadm介绍 kubeadm概述 参考附003.Kubeadm部署Kubernetes. kubeadm功能 参考附003.Kubeadm部署Kubernetes. 本方案描述 本方案采用kub ...

- 附034.Kubernetes_v1.21.0高可用部署架构二

kubeadm介绍 kubeadm概述 Kubeadm 是一个工具,它提供了 kubeadm init 以及 kubeadm join 这两个命令作为快速创建 kubernetes 集群的最佳实践. ...

- 附022.Kubernetes_v1.18.3高可用部署架构一

kubeadm介绍 kubeadm概述 参考附003.Kubeadm部署Kubernetes. kubeadm功能 参考附003.Kubeadm部署Kubernetes. 本方案描述 本方案采用kub ...

- Kubernetes 1.17.2 高可用部署

20.0.0.200 10.0.0.200 bs-k8s-master01 管理节点 2c2g 20.0.0.201 10.0.0.201 bs-k8s-master02 管理节点 2c2 ...

- 附017.Kubernetes_v1.17.4 Dashboard部署

一 Kubernetes dashboard简介 1.1 Web UI简介 dashboard是基于Web的Kubernetes用户界面.可以使用dashboard将容器化应用程序部署到Kuberne ...

- kubeadm使用外部etcd部署kubernetes v1.17.3 高可用集群

文章转载自:https://mp.weixin.qq.com/s?__biz=MzI1MDgwNzQ1MQ==&mid=2247483891&idx=1&sn=17dcd7cd ...

- kubernetes1.7.6 ha高可用部署

写在前面: 1. 该文章部署方式为二进制部署. 2. 版本信息 k8s 1.7.6,etcd 3.2.9 3. 高可用部分 etcd做高可用集群.kube-apiserver 为无状态服务使用hap ...

随机推荐

- 【Mac】anaconda自定义channels

1.查看channels conda config --show channels 输出 channels: - defaults 2.添加channels conda config --add ch ...

- Python - 常用的PyCharm的快捷键和使用场景介绍

关于PyCharm的快捷键,由于数量众多,差不多有100个,相信几乎没有人会记住所有,每个人都会有自己顺手的几个,这里我将自己用着顺手,不别扭的快捷键分享出来,同时分享在哪里可以找到所有的快捷键. 一 ...

- 快服务常见TOP3审核雷区,再不过审就要崩溃啦!

仰天大笑出门去,审核提交很神气. 垂死病中惊坐起,突然驳回伤不起. 江州司马青衫湿,重新修改苦自知. 梦里花落知多少,回复马上就改好. 审批被驳回可能是最常见的令开发者头大的问题了,明明看起来&quo ...

- 对 eval 命令的理解

eval 格式:eval [argument...] 可以二次迭代参数中的引用变量,然后将参数作为命令,在shell中执行 如果是多个参数,那么变量替换之后必须符合某个命令的格式,否则eval会报错& ...

- DQN(Deep Q-learning)入门教程(三)之蒙特卡罗法算法与Q-learning算法

蒙特卡罗法 在介绍Q-learing算法之前,我们还是对蒙特卡罗法(MC)进行一些介绍.MC方法是一种无模型(model-free)的强化学习方法,目标是得到最优的行为价值函数\(q_*\).在前面一 ...

- 读Pyqt4教程,带你入门Pyqt4 _011

当我们想要改变或者增强已存在的窗口组件时,或者准备从零开始创建自定义窗口组件时,可以使用绘图.我们通过使用PyQt4工具包提供的绘图API来绘图. 绘图在 paintEvent() 方法中进行.绘制代 ...

- 第一次写js轮播图

仿小米首页轮播图(注意事项) 布局部分 1.用ul包裹li再包裹a的形式来装图片,建立focus类: <div class="focus"> <ul> &l ...

- 【算法】单元最短路径之Bellman-Ford算法和SPFA算法

SPFA是经过对列优化的bellman-Ford算法,因此,在学习SPFA算法之前,先学习下bellman-Ford算法. bellman-Ford算法是一种通过松弛操作计算最短路的算法. 适用条件 ...

- Rocket - diplomacy - misaligned

https://mp.weixin.qq.com/s/poCJBcx45clXHm6Uuv8M6w 介绍AddressSet.misaligned的实现.之前介绍的比较概括,也有偏差.这里根据实际执行 ...

- 快速搭建基于Spring Boot + Spring Security 环境

个人博客网:https://wushaopei.github.io/ (你想要这里多有) 1.Spring Security 权限管理框架介绍 简介: Spring Security 提供了基于 ...