Scrapy模拟登录信息

携带cookie模拟登录

- 需要在爬虫里面自定义一个

start_requests()的函数- 里面的内容:

def start_requests(self):

cookies = '真实有效的cookie'

yield scrapy.Request(

self.start_urls[0],

callback = self.paese,

cookies = cookies

)

下载中间件

- 只需在文件最下面定义自己的中间件即可

下载中间键里可以做很多内容:携带登录信息,设置user-agent,添加代理等

- 使用前要在settings里面设置一下

- 数字代表权重

projectname.middlewares.DownloadMiddlewareName

DOWNLOADER_MIDDLEWARES = {

'superspider.middlewares.SuperspiderDownloaderMiddleware': 543,

}

- 设置user-agent

process_request

定义一个名为RandomUserAgentMiddleware的下载中间件

from fake_useragent import UserAgent

class RandomUserAgentMiddleware:

def process_request(self, request, spider):

##### 还可以为不同爬虫指定不同的中间件

if spider.name == 'spider1':

ua = UserAgent()

request.headers["User-Agent"] = ua.random

在settings里导入

DOWNLOADER_MIDDLEWARES = {

'superspider.middlewares.RandomUserAgentMiddleware': 543

}

- 审核user-agent

process_response- 需要返回response

- 在settings里导入

class UserAgentCheck:

def process_response(self, request, response, spider):

print(request.headers['User-Agent'])

return response

DOWNLOADER_MIDDLEWARES = {

'superspider.middlewares.RandomUserAgentMiddleware': 543,

'superspider.middlewares.UserAgentCheck': 544

}

- 设置代理

- 需要在request的meta信息中添加proxy字段

- 添加代理的形式:协议+IP+端口

- settings里导入

class ProxyMiddleware:

def process_request(self, request, spider):

if spider.name == 'spider0':

request.meta["proxy"] = "http://ip:port"

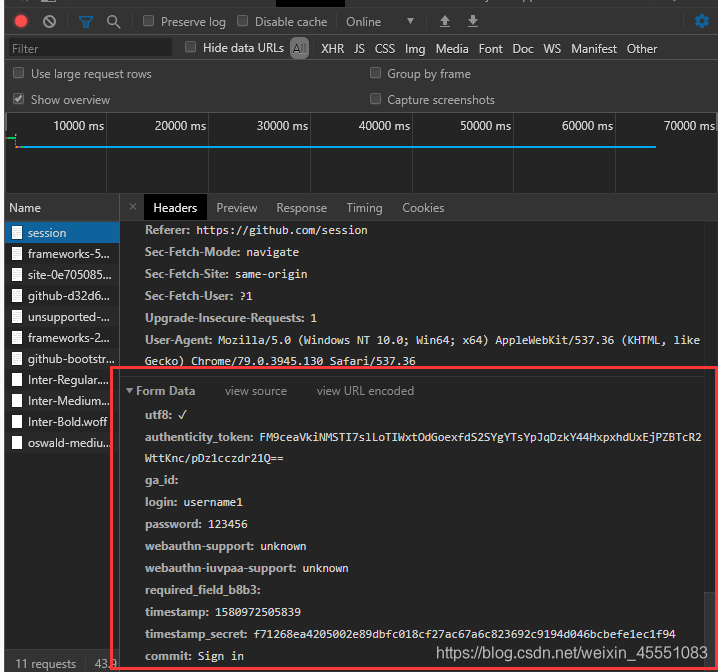

模拟登录GitHub

自己构造表单模拟登录 使用 FormRequest

- 明确要yield的内容,并交给下一个函数处理

# -*- coding: utf-8 -*-

import scrapy

class Spider0Spider(scrapy.Spider):

name = 'spider0'

allowed_domains = ['github.com']

start_urls = ['https://github.com/session']

def parse(self, response):

yield scrapy.FormRequest(

"https://github.com/session",

formdata=,

callback=self.after_login

)

def after_login(self, response):

pass

- formdate的构造

# -*- coding: utf-8 -*-

import scrapy

class Spider0Spider(scrapy.Spider):

name = 'spider0'

allowed_domains = ['github.com']

start_urls = ['https://github.com/session']

def parse(self, response):

form = {

'utf8': "✓",

'authenticity_token': response.xpath(

"//*[@id='unsupported-browser']/div/div/div[2]/form/input[2]/text()").extract_first(),

'ga_id': response.xpath('//*[@id="login"]/form/input[3]/@value').extract_first(),

'login': "",

'password': "",

'webauthn-support': 'supported',

'webauthn-iuvpaa-support': 'supported',

response.xpath('//*[@id="login"]/form/div[3]/input[5]/@name').extract_first(): "",

'timestamp': response.xpath("//*[@id='login']/form/div[3]/input[6]/@value").extract_first(),

"timestamp_secret": response.xpath("//*[@id='login'']/form/div[3]/input[7]/@value").extract_first(),

"commit": "Sign in"

}

print(form)

yield scrapy.FormRequest(

"https://github.com/session",

formdata=form,

callback=self.after_login

)

def after_login(self, response):

pass

自动寻找form表单中的信息

# -*- coding: utf-8 -*-

import scrapy

class Spider0Spider(scrapy.Spider):

name = 'spider0'

allowed_domains = ['github.com']

start_urls = ['https://github.com/session']

def parse(self, response):

yield scrapy.FormRequest.from_response(

response,

formdata={"login": "", "password":""},

callback=self.after_login

)

def after_login(self, response):

print(response.text)

Scrapy模拟登录信息的更多相关文章

- scrapy模拟登录微博

http://blog.csdn.net/pipisorry/article/details/47008981 这篇文章是介绍使用scrapy模拟登录微博,并爬取微博相关内容.关于登录流程为嘛如此设置 ...

- 利用scrapy模拟登录知乎

闲来无事,写一个模拟登录知乎的小demo. 分析网页发现:登录需要的手机号,密码,_xsrf参数,验证码 实现思路: 1.获取验证码 2.获取_xsrf 参数 3.携带参数,请求登录 验证码url : ...

- scrapy模拟登录

对于scrapy来说,也是有两个方法模拟登陆: 直接携带cookie 找到发送post请求的url地址,带上信息,发送请求 scrapy模拟登陆之携带cookie 应用场景: cookie过期时间很长 ...

- python爬虫之scrapy模拟登录

背景: 初来乍到的pythoner,刚开始的时候觉得所有的网站无非就是分析HTML.json数据,但是忽略了很多的一个问题,有很多的网站为了反爬虫,除了需要高可用代理IP地址池外,还需要登录.例如知乎 ...

- Scrapy模拟登录赶集网

1.打开赶集网登录界面,先模拟登录并抓包,获得post请求的request参数 2. 我们只需构造出上面的参数传入formdata即可 参数分析: setcookie:为自动登录所传的值,不勾选时默认 ...

- scrapy 基础组件专题(十二):scrapy 模拟登录

1. scrapy有三种方法模拟登陆 1.1直接携带cookies 1.2找url地址,发送post请求存储cookie 1.3找到对应的form表单,自动解析input标签,自动解析post请求的u ...

- Scrapy模拟登录知乎

建立项目 scrapy startproject zhihu_login scrapy genspider zhihu www.zhihu.com 编写spider 知乎的登录页url是http:// ...

- Scrapy模拟登录GitHub

d: 进入D盘 scrapy startproject GitHub 创建项目 scrapy genspider github github.com 创建爬虫 编辑github.py: # -*- c ...

- scrapy 模拟登录后再抓取

深度好文: from scrapy.contrib.spiders.init import InitSpider from scrapy.http import Request, FormReques ...

随机推荐

- Ubuntu环境下如何设置文件(文件夹)权限

查看文件(文件夹)权限 cd到需要查看的文件(文件夹)所在目录并执行: (base) duanyongchun@hc1217:~$ ls -l #查看当前文件夹下的所有文件(包括文件夹)的权限 如图: ...

- Dome_iptest_server

一个简单的ip测试服务器 打印返回 请求头request import socket def send_data(conn, data=None, status=200): if status != ...

- 硬不硬你说了算!35 张图解被问千百遍的 TCP 三次握手和四次挥手面试题

每日一句英语学习,每天进步一点点: 前言 不管面试 Java .C/C++.Python 等开发岗位, TCP 的知识点可以说是的必问的了. 任 TCP 虐我千百遍,我仍待 TCP 如初恋. 遥想小林 ...

- Educational Codeforces Round 84 (Rated for Div. 2)

A. Sum of Odd Integers(思维) 思路 这一题看完ans之后觉得是真简单,不过有一些地方还是要理解的. 这一题输出YES,有两个条件 kk%2 == n%2k,这个条件的意思是 k ...

- C++STL(一)——string类

STL--string类 初始化 string的赋值 string的连接 string的性质描述 遍历 字符指针和string的转化 查找.替换.交换 字符串的拼接 区间删除. 插入 大小写转换 比较 ...

- c语言 0与非0

------------恢复内容开始------------ 结论: 其它的编程语言中有布尔数据类型,并用百来表示逻辑真和逻辑假,C语言没有这个内置类度型,在C语言中真和假是用整型值来表示知的,0就表 ...

- Light of future-冲刺Day 3

目录 1.SCRUM部分: 每个成员进度 SCRUM 会议的照片 签入记录 代码运行截图 发布界面 用户浏览界面 管理员浏览界面 2.PM 报告: 时间表 燃尽图 任务总量变化曲线 每名成员的贡献比 ...

- .Net微服务实践(四)[网关]:Ocelot限流熔断、缓存以及负载均衡

目录 限流 熔断 缓存 Header转化 HTTP方法转换 负载均衡 注入/重写中间件 后台管理 最后 在上篇.Net微服务实践(三)[网关]:Ocelot配置路由和请求聚合中我们介绍了Ocelot的 ...

- python--Django(三)视图

Django的视图 不同于其他语言的MVC模式,Django采用的是MVT模式,即Model.View.Template,这里的View其实质就是其他语言中的Controller(emmm.....) ...

- Flask入门 之 endpoint

首先,要纠正两个错误! 1.flask是通过endpoint找到viewfunction(视图函数的),并不是通过路由直接找到viewfunction的. 2.是url_for(endpoint)而不 ...