python 3.x 爬虫基础---Urllib详解

python 3.x 爬虫基础

python 3.x 爬虫基础---http headers详解

前言

爬虫也了解了一段时间了希望在半个月的时间内结束它的学习,开启python的新大陆,今天大致总结一下爬虫基础相关的类库---Urllib。

Urllib

官方文档地址:https://docs.python.org/3/library/urllib.html

urllib提供了一系列用于操作URL的功能。

Python3中将python2.7的urllib和urllib2两个包合并成了一个urllib库,其主要包括一下模块:

urllib.request 请求模块

urllib.error 异常处理模块

urllib.parse url解析模块

urllib.robotparser robots.txt解析模块

urllib.request

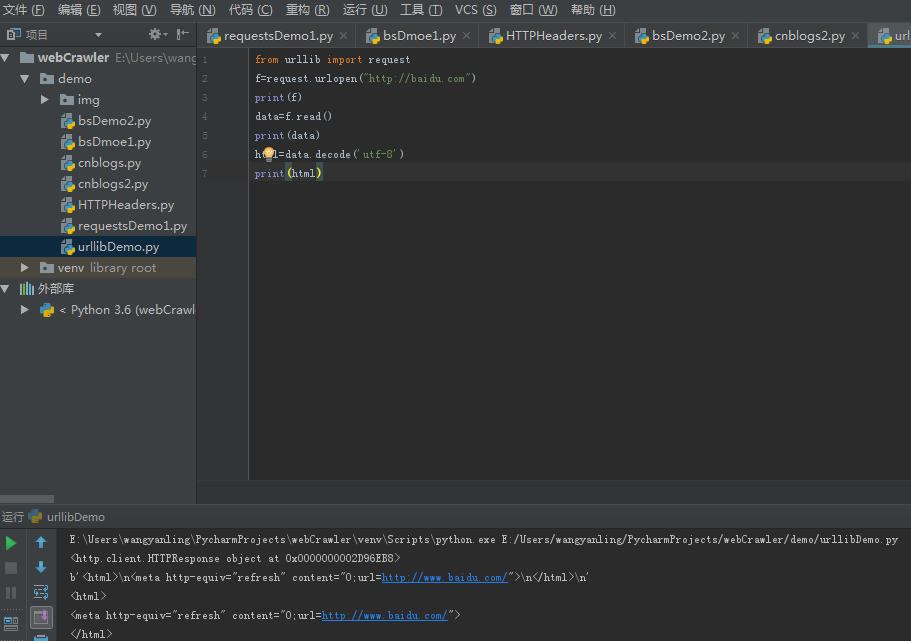

urlopen

通过案例可以看出urlopen,会返回一个二进制的对象,对这个对象进行read()操作可以得到一个包含网页的二进制字符串,然后用decode()解码成一段html代码。

urlopen参数如下:

urllib.request.urlopen(url, data=None, [timeout, ]*, cafile=None, capath=None, cadefault=False, context=None)

常用参数:

url:访问的地址,一般不只是地址。

data:此参数为可选字段,特别要注意的是,如果选择,请求变为post传递方式,其中传递的参数需要转为bytes,如果是我们只需要通过 urllib.parse.urlencode 转换即可:

import urllib.parse

import urllib.request

data = bytes(urllib.parse.urlencode({'word': 'hello'}), encoding= 'utf8')

response = urllib.request.urlopen('http://xxxxx', data=data)

print(response.read().decode('utf-8'))

timeout:设置网站的访问超时时间

其他参数:

context 参数:它必须是 ssl.SSLContext 类型,用来指定 SSL 设置。

cafile 和 capath 两个参数:是指定CA证书和它的路径,这个在请求 HTTPS 链接时会有用。

cadefault 参数:现在已经弃用了,默认为 False

urlopen返回对象提供方法:

read() , readline() ,readlines() , fileno() , close() :对HTTPResponse类型数据进行操作。

info():返回HTTPMessage对象,表示远程服务器返回的头信息。

getcode():返回Http状态码。

geturl():返回请求的url。

import urllib.request

response = urllib.request.urlopen('http://python.org/')

print("查看 response 的返回类型:",type(response))

print("查看反应地址信息: ",response)

print("查看头部信息1(http header):\n",response.info())

print("查看头部信息2(http header):\n",response.getheaders())

print("输出头部属性信息:",response.getheader("Server"))

print("查看响应状态信息1(http status):\n",response.status)

print("查看响应状态信息2(http status):\n",response.getcode())

print("查看响应 url 地址:\n",response.geturl())

page = response.read()

print("输出网页源码:",page.decode('utf-8'))

Request

import urllib.request

headers = {'Host': 'www.xicidaili.com',

'User-Agent': 'Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)',

'Accept': r'application/json, text/javascript, */*; q=0.01',

'Referer': r'http://www.xicidaili.com/', }

req = urllib.request.Request(r'http://www.xicidaili.com/nn/', headers=headers)

response = urllib.request.urlopen(req)

html = response.read().decode('utf-8')

print(html)

通过代码我们可以看出urlopen不再是传递url了,而是一个 request。这样一来我们不带把请求独立成一个对象,而且能更加灵活方便的配置访问参数,这是爬虫http必不可少的一步。

Request参数如下:

urllib.request.Request(url, data=None, headers={}, origin_req_host=None, unverifiable=False, method=None)

常用参数:

url:访问的地址。

data:此参数为可选字段,其中传递的参数需要转为bytes,如果是字典我们只需要通过 urllib.parse.urlencode 转换即可:

headers:http相应headers传递的信息,构造方法:headers 参数传递,通过调用 Request 对象的 add_header() 方法来添加请求头。python 3.x 爬虫基础---http headers详解,可参考此文章。

其他参数:

origin_req_host :指的是请求方的 host 名称或者 IP 地址。

unverifiable :用来表明这个请求是否是无法验证的,默认是 False 。意思就是说用户没有足够权限来选择接收这个请求的结果。如果没有权限,这时 unverifiable 的值就是 True 。

method :用来指示请求使用的方法,比如 GET , POST , PUT 等

ProxyHandler(ip代理)

以上做些简单的demo是没有问题的,但是如果想让你的爬虫更加强大,那么 rulllib.request.ProxyHandler 设置代理你一定要知道,网站它会检测某一段时间某个IP 的访问次数,如果访问次数过多,它会禁止你的访问,所以这个时候需要通过设置代理来爬取数据

ef Proxy_read(proxy_list, user_agent_list, i):

proxy_ip = proxy_list[i]

print('当前代理ip:%s'%proxy_ip)

user_agent = random.choice(user_agent_list)

print('当前代理user_agent:%s'%user_agent)

sleep_time = random.randint(,)

print('等待时间:%s s' %sleep_time)

time.sleep(sleep_time)

print('开始获取')

headers = {'User-Agent': user_agent,'Accept': r'application/json, text/javascript, */*; q=0.01',

'Referer': r'https://www.cnblogs.com'

}

proxy_support = request.ProxyHandler({'http':proxy_ip})

opener = request.build_opener(proxy_support)

request.install_opener(opener)

req = request.Request(r'https://www.cnblogs.com/kmonkeywyl/p/8409715.html',headers=headers)

try:

html = request.urlopen(req).read().decode('utf-8')

except Exception as e:

print('******打开失败!******')

else:

global count

count +=

print('OK!总计成功%s次!'%count)

以上代码是前段时间写的刷新页面的但是没有达到想要的效果,不过里面有用到 request.ProxyHandler({'http':proxy_ip}) 。其中 urllib.request.build_opener() 方法来利用这个处理器构建一个 Opener ,那么这个 Opener 在发送请求的时候就具备了认证功能了。 request.install_opener(opener) 方法打开链接,就可以完成认证了。

HTTPCookieProcessor(cookie操作)

网站中通过cookie进行判断权限是很常见的。那么我们可以通过 urllib.request.HTTPCookieProcessor(cookie) 来操作cookie。使用Cookie和使用代理IP一样,也需要创建一个自己的opener。在HTTP包中,提供了cookiejar模块,用于提供对Cookie的支持。 http.cookiejar功能强大,我们可以利用本模块的CookieJar类的对象来捕获cookie并在后续连接请求时重新发送,比如可以实现模拟登录功能。该模块主要的对象有CookieJar、FileCookieJar、MozillaCookieJar、LWPCookieJar。

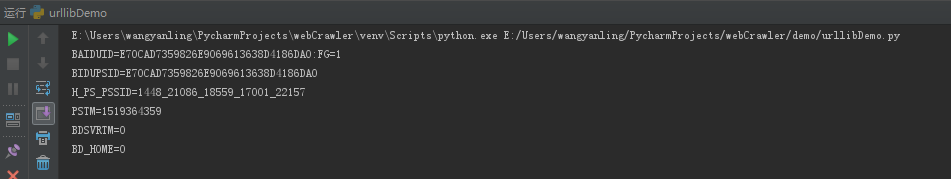

获取cookie( CookieJar)

import http.cookiejar, urllib.request

cookie = http.cookiejar.CookieJar()

handler = urllib.request.HTTPCookieProcessor(cookie)

opener = urllib.request.build_opener(handler)

response = opener.open('http://www.baidu.com')

for item in cookie:

print(item.name+"="+item.value)

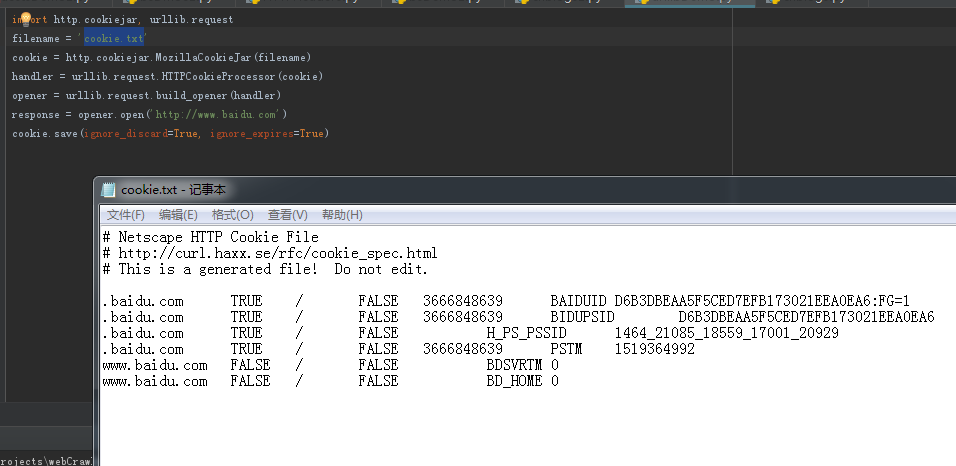

保存cookie(MozillaCookieJar)

filename = 'cookie.txt'

cookie = http.cookiejar.MozillaCookieJar(filename)

handler = urllib.request.HTTPCookieProcessor(cookie)

opener = urllib.request.build_opener(handler)

response = opener.open('http://www.baidu.com')

cookie.save(ignore_discard=True, ignore_expires=True)

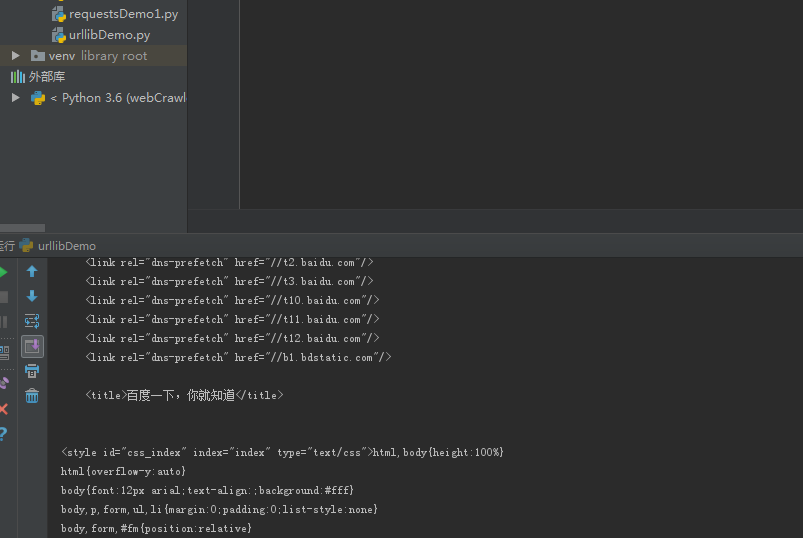

使用cookie

import http.cookiejar, urllib.request

cookie = http.cookiejar.MozillaCookieJar()

cookie.load('cookie.txt', ignore_discard=True, ignore_expires=True)

handler = urllib.request.HTTPCookieProcessor(cookie)

opener = urllib.request.build_opener(handler)

response = opener.open('http://www.baidu.com')

print(response.read().decode('utf-8'))

其中FileCookieJar、MozillaCookieJar、LWPCookieJar约为保存cookie信息,只是保存格式不同。我们在进行操作cookie时使用对应的格式即可。

urllib.error

用 try-except来捕捉异常,主要的错误方式就两种 URLError(错误信息)和HTTPError(错误编码).

try:

data=urllib.request.urlopen(url)

print(data.read().decode('utf-8'))

except urllib.error.HTTPError as e:

print(e.code)

except urllib.error.URLError as e:

print(e.reason)

urllib.parse

urlparse

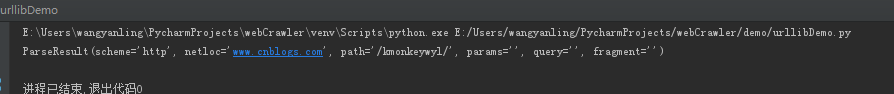

将对应的URL解析成六部分,并以元组的数据格式返回来。

import urllib.parse

o = urllib.parse.urlparse('http://www.cnblogs.com/kmonkeywyl/')

print(o)

参数

result = urlparse('url',scheme='https')解析协议 可以去掉http://

result = urlparse('url',scheme='http')

result = urlparse('url',allow_fragments=False) url带有查询参数

result = urlparse('url',allow_fragments=False) url不带有查询参数

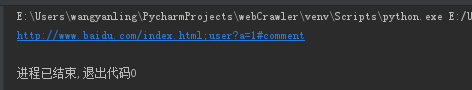

urlunparse

拼接url

from urllib.parse data = ['http','www.baidu.com','index.html','user','a=1','comment'] print(urllib.parse.urlunparse(data))

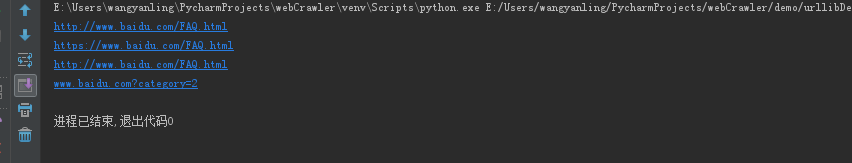

urljoin

用来拼接url的方法 或者叫组合方法,url必须为一致站点,否则后面参数会覆盖前面的host

from urllib.parse import urljoin

print(urljoin('http://www.baidu.com','FAQ.html'))

print(urljoin('http://www.badiu.com','https://www.baidu.com/FAQ.html'))

print(urljoin('http://www.baidu.com/about.html','http://www.baidu.com/FAQ.html'))

print(urljoin('www.baidu.com#comment','?category=2'))

这个在这个就不过多的介绍了,有兴趣的可以去看资料。

python 3.x 爬虫基础---Urllib详解的更多相关文章

- python 3.x 爬虫基础---常用第三方库(requests,BeautifulSoup4,selenium,lxml )

python 3.x 爬虫基础 python 3.x 爬虫基础---http headers详解 python 3.x 爬虫基础---Urllib详解 python 3.x 爬虫基础---常用第三方库 ...

- python 3.x 爬虫基础---正则表达式

python 3.x 爬虫基础 python 3.x 爬虫基础---http headers详解 python 3.x 爬虫基础---Urllib详解 python 3.x 爬虫基础---Requer ...

- python 3.x 爬虫基础---Requersts,BeautifulSoup4(bs4)

python 3.x 爬虫基础 python 3.x 爬虫基础---http headers详解 python 3.x 爬虫基础---Urllib详解 python 3.x 爬虫基础---Requer ...

- python 3.x 爬虫基础---http headers详解

前言 上一篇文章 python 爬虫入门案例----爬取某站上海租房图片 中有对headers的讲解,可能是对爬虫了解的不够深刻,所以老觉得这是一项特别简单的技术,也可能是简单所以网上对爬虫系统的文档 ...

- Python基础知识详解 从入门到精通(七)类与对象

本篇主要是介绍python,内容可先看目录其他基础知识详解,欢迎查看本人的其他文章Python基础知识详解 从入门到精通(一)介绍Python基础知识详解 从入门到精通(二)基础Python基础知识详 ...

- python中requests库使用方法详解

目录 python中requests库使用方法详解 官方文档 什么是Requests 安装Requests库 基本的GET请求 带参数的GET请求 解析json 添加headers 基本POST请求 ...

- python+requests接口自动化测试框架实例详解

python+requests接口自动化测试框架实例详解 转自https://my.oschina.net/u/3041656/blog/820023 摘要: python + requests实 ...

- RabbitMQ,Apache的ActiveMQ,阿里RocketMQ,Kafka,ZeroMQ,MetaMQ,Redis也可实现消息队列,RabbitMQ的应用场景以及基本原理介绍,RabbitMQ基础知识详解,RabbitMQ布曙

消息队列及常见消息队列介绍 2017-10-10 09:35操作系统/客户端/人脸识别 一.消息队列(MQ)概述 消息队列(Message Queue),是分布式系统中重要的组件,其通用的使用场景可以 ...

- kafka实战教程(python操作kafka),kafka配置文件详解

kafka实战教程(python操作kafka),kafka配置文件详解 应用往Kafka写数据的原因有很多:用户行为分析.日志存储.异步通信等.多样化的使用场景带来了多样化的需求:消息是否能丢失?是 ...

随机推荐

- javascript之事件监听

addEventListener是一个监听事件并处理相应的函数,用于向指定元素添加事件句柄,可使用removeEventListener()方法来移除addEventListener()方法添加的事件 ...

- 算法-java代码实现堆排序

堆排序 第7节 堆排序练习题 对于一个int数组,请编写一个堆排序算法,对数组元素排序. 给定一个int数组A及数组的大小n,请返回排序后的数组. 测试样例: [1,2,3,5,2,3],6 [1,2 ...

- 网站搭建中,怎么区分ASP和PHP

1:空间支持上 ASP:程序要求比较低,空间只要支持ASP+access即可运行 PHP:配置要求比较高,空间需要支持PHP及数据库,而且程序和数据库是单独的,一般的 unix空间都是这种配置. 2: ...

- dedecms织梦自定义表单发送到邮箱-用163邮箱发送邮件

https://www.baidu.com/s?ie=utf-8&f=8&rsv_bp=1&tn=monline_3_dg&wd=dedecms 邮箱&oq=d ...

- vue 入门第一课

windows安装git 安装淘宝镜像 npm install -g cnpm --registry=https://registry.npm.taobao.org 全局安装vue cnpm inst ...

- python基础8之自定义模块、if __name__==__main__:解释

一.自定义模块与使用 python模块说明:类似于函数式编程和面向过程编程,函数式编程则完成一个功能,其他代码用来调用即可,提供了代码的重用性和代码间的耦合.而对于一个复杂的功能来,可能需要多个函数才 ...

- WEB安全_csrf攻击

什么是xss跨站攻击? 正常访问服务器A,用户信任并在服务器A上登录操作,服务器A保存着用户的session数据,这时用户并没有退出服务器A的系统,然后访问危险服务器B,本来是用户请求服务器返回数据, ...

- JAVA 锁之 Synchronied

■ Java 锁 1. 锁的内存语义 锁可以让临界区互斥执行,还可以让释放锁的线程向同一个锁的线程发送消息 锁的释放要遵循 Happens-before 原则(锁规则:解锁必然发生在随后的加锁之前) ...

- Linux普通用户修改owner非本人文件为什么成功

关键字:错误提示:E45 已设定选项’readonly’(请加!强制执行) Linux对文件和目录有很好的权限管理,但今天遇到一个比较诡异的事情,普通用户对文件权限不可写,但可以强制保存该文件,这样就 ...

- [JAVA] - 从 m 个元素中随机选中 n 个

之前业务中曾经遇到过从m个元素中选取 n 个的需求,当时只是跑循环根据长度进行随机选取,然后放入 Set 中去重,一直到收集到足够的个数. 这样做的缺点很明显,当剩下的元素个数越少的时候,选取的元素越 ...