Hadoop分布式集群配置

硬件环境:

安装一个Hadoop集群时,需要专门指定一个服务器作为主节点。

三台虚拟机搭建的集群:(搭建集群时主机名不能一样,主机名在/etc/hostname修改)

master机器:集群的主节点,驻留NameNode和JobTracker守护进程)

dbrg1 192.168.0.102

slaves机器:(集群的从节点,驻留DataNode和TaskTracker守护进程)

dbrg2 192.168.0.112

dbrg3 192.168.0.113

这三台机器都安装好了hadoop-0.20.2,JDK和ssh。

安装方法参考上一篇博文。

共有3台机器,均使用的linux系统,Java使用的是sun

jdk1.7.0。

1. 修改主机名和IP地址

vi /etc/hostname(分别给每一台主机指定主机名)

vi /etc/hosts(分别给每一台主机指定主机名到IP地址的映射)

这里有一点需要强调的就是,务必要确保每台机器的主机名和IP地址之间能正确解析。一个很简单的测试办法就是ping一下主机名,比如在dbrg1上pingdbrg2,如果能ping通就OK!若不能正确解析,可以修改/etc/hosts文件,如果该台机器作Namenode用,则需要在hosts文件中加上集群中所有机器的IP地址及其对应的主机名;如果该台机器作Datanode用,则只需要在hosts文件中加上本机IP地址和Namenode机器的IP地址。

1. 三台机器都要修改/etc/hosts。

在dbrg1中添加:

192.168.0.102 dbrg1 dbrg1

192.168.0.112 dbrg2 dbrg2

192.168.0.113 dbrg3 dbrg3

在dbrg2中添加:

192.168.0.102 dbrg1 dbrg1

192.168.0.112 dbrg2 dbrg2

在dbrg3中添加:

192.168.0.102 dbrg1 dbrg1

192.168.0.113 dbrg3 dbrg3

2.免密码SSH设置

(1) 在三台机器上安装ssh,启动ssh-server。

sudo apt-get install openssh-server

sudo /etc/init.d/ssh start

ps -e|grep ssh //这个是检验命令

(2)在dbrg1上生成密钥对。

ssh-keygen -t -rsa //然后一直enter,按照默认的选项生成的密钥对保存在.ssh/id_rsa文件中

进入.ssh目录,输入

cp id_rsa.pub authorized_keys

执行 ssh localhost 看看需不需要输入命令

(3)远程拷贝

生成好后,需要将该文件传到dbrg2和3上

在dbrg1中的.ssh目录中,输入

scp authorized_keys dbrg2:/home/dbrg/.ssh/

scp authorized_keys dbrg3:/home/dbrg/.ssh/

说明:如果提示在dbrg2和3上没有此目录,记得创建。此处是需要输入密码的。

(4)修改权限。在dbrg2和dbrg3上对该文件进行权限修改

打开.ssh,输入

chmod 644 authorized_keys

(5)配置修改

在三台服务器上对sshd服务进行配置,都需要修改。在sudo vi /etc/ssh/sshd_config中

修改:PasswordAuthentictation no

AuthorizedKeyFile /home/dbrg/.ssh/authorized_keys

(6)检验

在dbrg1上,ssh dbrg2,输入yes,这样以后访问都不需要输入密码了

同样ssh dbrg3,输入yes。

之后再检验下,看看需不需要输入密码

3.Hadoop环境配置

在dbrg1中,打开hadoop目录,ls下,发现了conf文件夹,这个里面全是配置,打开

(1)修改hadoop_env.sh,输入:

export HADOOP_HOME=/home/dbrg/HadoopInstall/hadoop

export JAVA_HOME=/usr/java/jdk1.7.0

说明:根据实际的安装路径来,这是我机子上的

(2) 修改masters

删除localhost,改为dbrg1

(3)修改slaves

删除,改为dbrg2、dbrg3

(4)修改core-site.html //N啊么node IP地址及端口

在configuration之间加入:

<property>

<name>fs.default.name</name>

<value>hdfs://dbrg1:9000</value>

<description>The name and URI of the default FS.</description>

</property>

(5)修改mapred-site.html //Jobtracker 调度并记录任务的执行情况

在configuration之间加入:

<property>

<name>mapred.job.tracker</name>

<value>dbrg1:9001</value>

<description>Map Reduce jobtracker</description>

</property>

(6)修改hdfs-site.html //block的文件副本数

在configuration之间加入:

<property>

<name>dfs.replication</name>

<value>2</value>

<description>Default block replication</description>

</property>

(7)环境配置的拷贝

利用scp命令将上面修改的文件,替代dbrg2和dbrg3中的相应文件

4.HDFS的运行

在dbrg1中初始化namenode,在hadoop目录下,输入

bin/hadoop namenode -format

然后再三台机器上都要bin/start-all.sh下,启动了

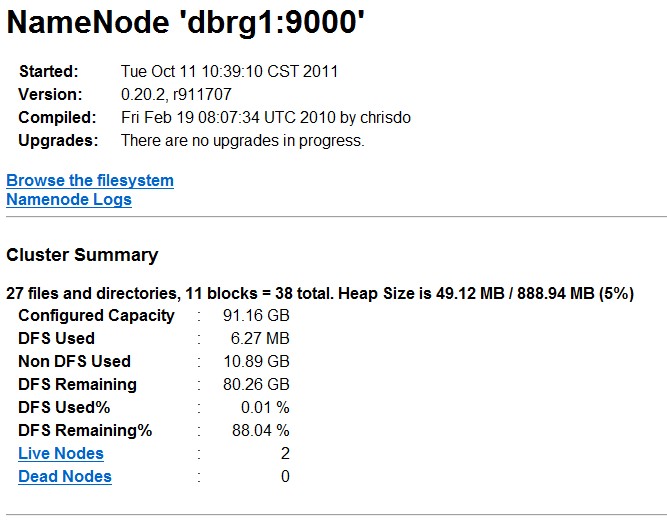

在dbrg1上可以查看,输入jps;或者可以通过http://dbrg1:50070查看

4. mapduce程序实例

参考网址:

http://blog.csdn.net/moodytong/article/details/6862020

http://www.cnblogs.com/welbeckxu/archive/2011/12/30/2306887.html

http://puxuanling.blog.163.com/blog/static/87476635201210704825265/

http://wenku.baidu.com/view/91e0240b52ea551811a68706.html

问题解决篇:

http://lwjlaser.iteye.com/blog/1443147

Hadoop分布式集群配置的更多相关文章

- CentOS6安装各种大数据软件 第四章:Hadoop分布式集群配置

相关文章链接 CentOS6安装各种大数据软件 第一章:各个软件版本介绍 CentOS6安装各种大数据软件 第二章:Linux各个软件启动命令 CentOS6安装各种大数据软件 第三章:Linux基础 ...

- 超快速使用docker在本地搭建hadoop分布式集群

超快速使用docker在本地搭建hadoop分布式集群 超快速使用docker在本地搭建hadoop分布式集群 学习hadoop集群环境搭建是hadoop入门的必经之路.搭建分布式集群通常有两个办法: ...

- 大数据系列之Hadoop分布式集群部署

本节目的:搭建Hadoop分布式集群环境 环境准备 LZ用OS X系统 ,安装两台Linux虚拟机,Linux系统用的是CentOS6.5:Master Ip:10.211.55.3 ,Slave ...

- Hadoop分布式集群搭建hadoop2.6+Ubuntu16.04

前段时间搭建Hadoop分布式集群,踩了不少坑,网上很多资料都写得不够详细,对于新手来说搭建起来会遇到很多问题.以下是自己根据搭建Hadoop分布式集群的经验希望给新手一些帮助.当然,建议先把HDFS ...

- Hadoop分布式集群搭建

layout: "post" title: "Hadoop分布式集群搭建" date: "2017-08-17 10:23" catalog ...

- 暑假第二弹:基于docker的hadoop分布式集群系统的搭建和测试

早在四月份的时候,就已经开了这篇文章.当时是参加数据挖掘的比赛,在计科院大佬的建议下用TensorFlow搞深度学习,而且要在自己的hadoop分布式集群系统下搞. 当时可把我们牛逼坏了,在没有基础的 ...

- 使用Docker在本地搭建Hadoop分布式集群

学习Hadoop集群环境搭建是Hadoop入门必经之路.搭建分布式集群通常有两个办法: 要么找多台机器来部署(常常找不到机器) 或者在本地开多个虚拟机(开销很大,对宿主机器性能要求高,光是安装多个虚拟 ...

- 一脸懵逼学习Hadoop分布式集群HA模式部署(七台机器跑集群)

1)集群规划:主机名 IP 安装的软件 运行的进程master 192.168.199.130 jdk.hadoop ...

- hadoop分布式集群的搭建

电脑如果是8G内存或者以下建议搭建3节点集群,如果是搭建5节点集群就要增加内存条了.当然实际开发中不会用虚拟机做,一些小公司刚刚起步的时候会采用云服务,因为开始数据量不大. 但随着数据量的增大才会考虑 ...

随机推荐

- awk的+=用法

awk增加统计列值为增加列数或进行运行结果统计,使用符号 + =.增加的结果赋给符号左边变量值,增加到变量的域在符号右边.例如将 $ 1加入变量total,表达式为toatl+=$1.列值增加很有用. ...

- redis动态配置

Config get CONFIG GET parameter CONFIG GET 命令用于取得运行中的 Redis 服务器的配置参数(configuration parameters),在 Red ...

- 用Lua定制Redis命令

* { color: #3e3e3e } body { font-family: "Helvetica Neue", Helvetica, "Hiragino Sans ...

- Django之wagtail安装及配置

安装指引原文地址:Http://docs.wagtail.io/en/v1.13.1 需要注意的几点: 指定端口启动服务:在项目根目录下 ,运行 python manage.py runserver ...

- Using Custom Domains With IIS Express In Asp.Net Core

IIS Express是一个Mini版的IIS,能够支持所有的Web开发任务,但是这种设计有一些缺陷,例如只能通过localhost:<port>的方式来访问我们的应用程序,看起来就有点不 ...

- UOJ #274. 【清华集训2016】温暖会指引我们前行 [lct]

#274. [清华集训2016]温暖会指引我们前行 题意比较巧妙 裸lct维护最大生成树 #include <iostream> #include <cstdio> #incl ...

- NOIP2016提高组初赛(C++语言)试题 个人的胡乱分析 Part 2.

洛谷秋令营day1模拟赛原地爆炸,心态崩了.于是打算写一下初赛题放松一下. 上次胡乱分析到了选择题,这次我想说说后面的题. 问题求解 T1.有一个1x8的方格图形,黑白两色填涂每个方格,两个黑格并不能 ...

- Python图形界面开发编程:wxPython(浅尝篇)

Python 提供了多个图形开发界面的库,几个常用 Python GUI 库如下: Tkinter: Tkinter 模块(Tk 接口)是 Python 的标准 Tk GUI 工具包的接口 .Tk 和 ...

- 链表回文判断(C++)

题目描述: 对于一个链表,请设计一个时间复杂度为O(n),额外空间复杂度为O(1)的算法,判断其是否为回文结构. 给定一个链表的头指针A,请返回一个bool值,代表其是否为回文结构.保证链表长度小于等 ...

- mac qq怎么删除全部聊天记录

找到 ./Users/user/Library/Containers/com.tencent.qq/ 删除com.tencent.qq文件夹就行.