Group Normalization

Group Normalization

FAIR 团队,吴育昕和恺明大大的新作Group Normalization。

主要的优势在于,BN会受到batchsize大小的影响。如果batchsize太小,算出的均值和方差就会不准确,如果太大,显存又可能不够用。

而GN算的是channel方向每个group的均值和方差,和batchsize没关系,自然就不受batchsize大小的约束。

从上图可以看出,随着batchsize的减小,GN的表现基本不受影响,而BN的性能却越来越差。

BatchNorm基础:

其中u为均值,seigema为方差,实际训练中使用指数滑动平均EMA计算。

gamma为scale值,beta为shift值

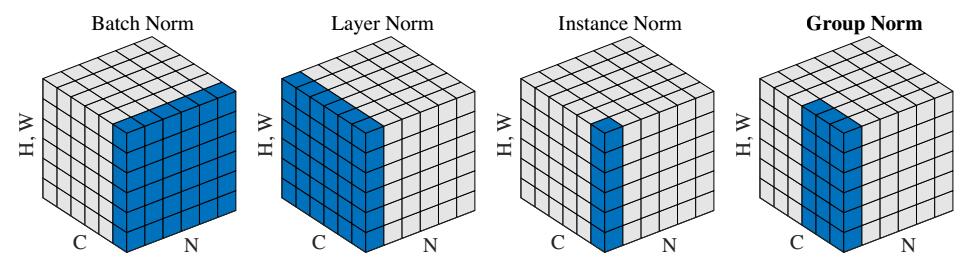

BatchNorm:batch方向做归一化,算N*H*W的均值

LayerNorm:channel方向做归一化,算C*H*W的均值

InstanceNorm:一个channel内做归一化,算H*W的均值

GroupNorm:将channel方向分group,然后每个group内做归一化,算(C//G)*H*W的均值

Tensorflow代码:

- def GroupNorm(x,G=16,eps=1e-5):

- N,H,W,C=x.shape

- x=tf.reshape(x,[tf.cast(N,tf.int32),tf.cast(H,tf.int32),tf.cast(W,tf.int32),tf.cast(G,tf.int32),tf.cast(C//G,tf.int32)])

- mean,var=tf.nn.moments(x,[1,2,4],keep_dims=True)

- x=(x-mean)/tf.sqrt(var+eps)

- x=tf.reshape(x,[tf.cast(N,tf.int32),tf.cast(H,tf.int32),tf.cast(W,tf.int32),tf.cast(C,tf.int32)])

- gamma = tf.Variable(tf.ones(shape=[1,1,1,tf.cast(C,tf.int32)]), name="gamma")

- beta = tf.Variable(tf.zeros(shape=[1,1,1,tf.cast(C,tf.int32)]), name="beta")

- return x*gamma+beta

References:

https://www.zhihu.com/question/269576836/answer/348670955

https://github.com/taokong/group_normalization

https://github.com/shaohua0116/Group-Normalization-Tensorflow

Group Normalization的更多相关文章

- Group Normalization笔记

作者:Yuxin,Wu Kaiming He 机构:Facebook AI Research (FAIR) 摘要:BN是深度学习发展中的一个里程碑技术,它使得各种网络得以训练.然而,在batch维度上 ...

- Batch Normalization、Layer Normalization、Instance Normalization、Group Normalization、Switchable Normalization比较

深度神经网络难训练一个重要的原因就是深度神经网络涉及很多层的叠加,每一层的参数变化都会导致下一层输入数据分布的变化,随着层数的增加,高层输入数据分布变化会非常剧烈,这就使得高层需要不断适应低层的参数更 ...

- 全面解读Group Normalization,对比BN,LN,IN

前言 Face book AI research(FAIR)吴育昕-何恺明联合推出重磅新作Group Normalization(GN),提出使用Group Normalization 替代深度学习里 ...

- (转载)深度剖析 | 可微分学习的自适配归一化 (Switchable Normalization)

深度剖析 | 可微分学习的自适配归一化 (Switchable Normalization) 作者:罗平.任家敏.彭章琳 编写:吴凌云.张瑞茂.邵文琪.王新江 转自:知乎.原论文参考arXiv:180 ...

- 扫盲记-第六篇--Normalization

深度学习模型中的Normalization 数据经过归一化和标准化后可以加快梯度下降的求解速度,这就是Batch Normalization等技术非常流行的原因,Batch Normalization ...

- 『计算机视觉』各种Normalization层辨析

『教程』Batch Normalization 层介绍 知乎:详解深度学习中的Normalization,BN/LN/WN 一.两个概念 独立同分布(independent and identical ...

- 深度学习中的Normalization模型

Batch Normalization(简称 BN)自从提出之后,因为效果特别好,很快被作为深度学习的标准工具应用在了各种场合.BN 大法虽然好,但是也存在一些局限和问题,诸如当 BatchSize ...

- bn两个参数的计算以及layer norm、instance norm、group norm

bn一般就在conv之后并且后面再接relu 1.如果输入feature map channel是6,bn的gamma beta个数是多少个? 6个. 2.bn的缺点: BN会受到batchsize大 ...

- [优化]深度学习中的 Normalization 模型

来源:https://www.chainnews.com/articles/504060702149.htm 机器之心专栏 作者:张俊林 Batch Normalization (简称 BN)自从提出 ...

随机推荐

- ios之清除cell缓存,解决cell的重用问题。

tableView表格中的cell有重用机制,这是一个很好的东西,可以避免开辟很多的空间内存.但是有时候我们不想让它重用cell,,可以用以下的代码解决. 将这个代码放在: - (UITableVie ...

- [sql]mysql指引(整理中...)-对db的分类

参考 db存储及分层 一个db一个文件夹. 一张表两个文件frm是存表结构的,ibd是存数据的 连接层: sock ip sql层: 存储层: 2018年4月1日 20:53:54小结: 时间太久,抓 ...

- Boost家族

大师Yoav Freund在文章<A decision-theoretic generalization of on-line leanring and an application to bo ...

- haproxy-1.7.7 源码安装

安装一下依赖 yum install openssl-devel openssl 编译安装 make TARGET=linux2628 USE_OPENSSL=1 ADDLIB=-lz make in ...

- LoadingController

--local MainSceneConfig = require "res.scripts.configs.MainSceneConfig" -- 暂时添加一个临时配置文件 -- ...

- (原创)C++11改进我们的程序之简化我们的程序(四)

这次要讲的是:c++11统一初始化.统一begin()/end()和for-loop循环如何简化我们的程序 初始化列表 c++11之前有各种各样的初始化语法,有时候初始化的时候还挺麻烦,比较典型的如v ...

- 每日英语:The Power of Parents Who Say 'No'

I grew up in an affluent area. Most kids owned multiple Cabbage Patch dolls and Gear bags and pairs ...

- 【Java】PreparedStatement VS Statement

创建时: Statement statement = conn.createStatement(); PreparedStatement preStatement = conn.prepareS ...

- LVS负载均衡模型及算法概述

集群类型 LB: Load Balancing,负载均衡 HA:High Availability, 高可用 HP:High Performance, 高性能 负载均衡 负载均衡设备 Hardwa ...

- Docker、Dockerfile、Docker镜像、容器这些都是什么鸟?

老生常谈,再再再……普及一下: Docker:最早是dotCloud公司出品的一套容器管理工具,但后来Docker慢慢火起来了,连公司名字都从dotCloud改成Docker. Dockerfile: ...