Hadoop学习笔记—7.计数器与自定义计数器

一、Hadoop中的计数器

计数器:计数器是用来记录job的执行进度和状态的。它的作用可以理解为日志。我们通常可以在程序的某个位置插入计数器,用来记录数据或者进度的变化情况,它比日志更便利进行分析。

例如,我们有一个文件,其中包含如下内容:

hello you

hello me

它被WordCount程序执行后显示如下日志:

在上图所示中,计数器有19个,分为四个组:File Output Format Counters、FileSystemCounters、File Input Format Counters和Map-Reduce Framkework。

分组File Input Format Counters包括一个计数器Bytes Read,表示job执行结束后输出文件的内容包括19个字节(空格、换行都是字符),如下所示。

hello

me

you

分组File Output Format Counters包括一个计数器Bytes Written,表示job执行时读取的文件内容包括19个字节(空格、换行都是字符),如下所示。

hello you

hello me

关于以上这段计数器日志中详细的说明请见下面的注释:

Counters: 19 // Counter表示计数器,19表示有19个计数器(下面一共4计数器组)

File Output Format Counters // 文件输出格式化计数器组

Bytes Written=19 // reduce输出到hdfs的字节数,一共19个字节

FileSystemCounters// 文件系统计数器组

FILE_BYTES_READ=481

HDFS_BYTES_READ=38

FILE_BYTES_WRITTEN=81316

HDFS_BYTES_WRITTEN=19

File Input Format Counters // 文件输入格式化计数器组

Bytes Read=19 // map从hdfs读取的字节数

Map-Reduce Framework // MapReduce框架

Map output materialized bytes=49

Map input records=2 // map读入的记录行数,读取两行记录,”hello you”,”hello me”

Reduce shuffle bytes=0 // 规约分区的字节数

Spilled Records=8

Map output bytes=35

Total committed heap usage (bytes)=266469376

SPLIT_RAW_BYTES=105

Combine input records=0 // 合并输入的记录数

Reduce input records=4 // reduce从map端接收的记录行数

Reduce input groups=3 // reduce函数接收的key数量,即归并后的k2数量

Combine output records=0 // 合并输出的记录数

Reduce output records=3 // reduce输出的记录行数。<helllo,{1,1}>,<you,{1}>,<me,{1}>

Map output records=4 // map输出的记录行数,输出4行记录

二、用户自定义计数器

以上是在Hadoop中系统内置的标准计数器。除此之外,由于不同的场景有不同的计数器应用需求,因此我们也可以自己定义计数器使用。

2.1 敏感词记录-准备

现在假设我们需要对文件中的敏感词做一个统计,即对敏感词在文件中出现的次数做一个记录。这里,我们还是以下面这个文件为例:

Hello World!

Hello Hadoop!

文本内容很简单,这里我们指定Hello是一个敏感词,显而易见这里出现了两次Hello,即两次敏感词需要记录下来。

2.2 敏感词记录-程序

在WordCount程序的基础之上,改写Mapper类中的map方法,统计Hello出现的次数,如下代码所示:

public static class MyMapper extends

Mapper<LongWritable, Text, Text, LongWritable> {

/*

* @param KEYIN →k1 表示每一行的起始位置(偏移量offset)

*

* @param VALUEIN →v1 表示每一行的文本内容

*

* @param KEYOUT →k2 表示每一行中的每个单词

*

* @param VALUEOUT →v2表示每一行中的每个单词的出现次数,固定值为1

*/

protected void map(LongWritable key, Text value,

Mapper<LongWritable, Text, Text, LongWritable>.Context context)

throws java.io.IOException, InterruptedException {

Counter sensitiveCounter = context.getCounter("Sensitive Words:", "Hello"); String line = value.toString();

// 这里假定Hello是一个敏感词

if(line.contains("Hello")){

sensitiveCounter.increment(1L);

}

String[] spilted = line.split(" ");

for (String word : spilted) {

context.write(new Text(word), new LongWritable(1L));

}

};

}

我们首先通过Mapper.Context类直接获得计数器对象。这里有两个形参,第一个是计数器组的名称,第二是计数器的名称。

然后通过String类的contains方法判断是否存在Hello敏感词。如果有,进入条件判断语句块,调用计数器对象的increment方法。

2.3 敏感词记录-结果

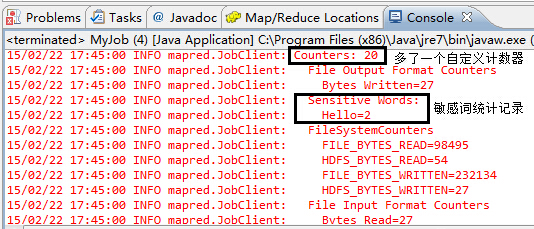

通过查看控制台日志信息,可以看到如下图所示的信息:

我们可以清楚地看到计数器由原来的19个变为20个,多出来的这个计数器正是我们自定义的敏感词计数器,由于文件中只有两个Hello,因此这里显示Hello=2。

参考资料

(1)Suddenly,《Hadoop日记17-计数器、Map规约与分区》:http://www.cnblogs.com/sunddenly/p/4009568.html

(2)吴超,《Hadoop中的计数器》:http://www.superwu.cn/2013/08/14/460

(3)dajuezhao,《Hadoop中自定义计数器》:http://blog.csdn.net/dajuezhao/article/details/5788705

(4)万川梅、谢正兰,《Hadoop应用开发实战详解(修订版)》:http://item.jd.com/11508248.html

Hadoop学习笔记—7.计数器与自定义计数器的更多相关文章

- Hadoop学习笔记—8.Combiner与自定义Combiner

一.Combiner的出现背景 1.1 回顾Map阶段五大步骤 在第四篇博文<初识MapReduce>中,我们认识了MapReduce的八大步凑,其中在Map阶段总共五个步骤,如下图所示: ...

- Hadoop学习笔记—9.Partitioner与自定义Partitioner

一.初步探索Partitioner 1.1 再次回顾Map阶段五大步骤 在第四篇博文<初识MapReduce>中,我们认识了MapReduce的八大步凑,其中在Map阶段总共五个步骤,如下 ...

- Hadoop学习笔记—5.自定义类型处理手机上网日志

转载自http://www.cnblogs.com/edisonchou/p/4288737.html Hadoop学习笔记—5.自定义类型处理手机上网日志 一.测试数据:手机上网日志 1.1 关于这 ...

- Hadoop学习笔记系列文章导航

一.为何要学习Hadoop? 这是一个信息爆炸的时代.经过数十年的积累,很多企业都聚集了大量的数据.这些数据也是企业的核心财富之一,怎样从累积的数据里寻找价值,变废为宝炼数成金成为当务之急.但数据增长 ...

- Hadoop学习笔记系列

Hadoop学习笔记系列 一.为何要学习Hadoop? 这是一个信息爆炸的时代.经过数十年的积累,很多企业都聚集了大量的数据.这些数据也是企业的核心财富之一,怎样从累积的数据里寻找价值,变废为宝炼 ...

- Hadoop学习笔记(7) ——高级编程

Hadoop学习笔记(7) ——高级编程 从前面的学习中,我们了解到了MapReduce整个过程需要经过以下几个步骤: 1.输入(input):将输入数据分成一个个split,并将split进一步拆成 ...

- Hadoop学习笔记—22.Hadoop2.x环境搭建与配置

自从2015年花了2个多月时间把Hadoop1.x的学习教程学习了一遍,对Hadoop这个神奇的小象有了一个初步的了解,还对每次学习的内容进行了总结,也形成了我的一个博文系列<Hadoop学习笔 ...

- Hadoop学习笔记(6) ——重新认识Hadoop

Hadoop学习笔记(6) ——重新认识Hadoop 之前,我们把hadoop从下载包部署到编写了helloworld,看到了结果.现是得开始稍微更深入地了解hadoop了. Hadoop包含了两大功 ...

- Hadoop学习笔记(2)

Hadoop学习笔记(2) ——解读Hello World 上一章中,我们把hadoop下载.安装.运行起来,最后还执行了一个Hello world程序,看到了结果.现在我们就来解读一下这个Hello ...

- Hadoop学习笔记(5) ——编写HelloWorld(2)

Hadoop学习笔记(5) ——编写HelloWorld(2) 前面我们写了一个Hadoop程序,并让它跑起来了.但想想不对啊,Hadoop不是有两块功能么,DFS和MapReduce.没错,上一节我 ...

随机推荐

- 【leetcode】Pascal's Triangle II

题目简述: Given an index k, return the kth row of the Pascal's triangle. For example, given k = 3, Retur ...

- NetMQ(三): 发布订阅模式 Publisher-Subscriber

ZeroMQ系列 之NetMQ 一:zeromq简介 二:NetMQ 请求响应模式 Request-Reply 三:NetMQ 发布订阅模式 Publisher-Subscriber 四:NetMQ ...

- 移动端js知识总结

1.如果使用jquery绑定touch事件的话,获取touchstart,touchmove的触点坐标用 e.originalEvent.targetTouches[0].pageX, 获取touch ...

- 【ajax 提交表单】多种方式的注意事项

在业务中,可能因为表单内容过于庞大,字段过于繁杂,如果人为去拼接的话 ,需要耗费大量的时间和精力,与此同时,代码看上去也是冗余不堪. 所以,提交表单的时候如果能整个表单数据整体提交,那是非常开心的事情 ...

- C# 解析JSON的几种办法

欲成为海洋大师,必知晓海中每一滴水的真名. 刚开始只是想找一个转换JSON数组的方法,结果在MSDN翻到一大把. 搜索过程中免不了碰到一大堆名词:WCF => DataContract => ...

- 《转》 浅谈C# 多态的魅力(虚方法,抽象,接口实现)

前言:我们都知道面向对象的三大特性:封装,继承,多态.封装和继承对于初学者而言比较好理解,但要理解多态,尤其是深入理解,初学者往往存在有很多困惑,为什么这样就可以?有时候感觉很不可思议,由此,面向对象 ...

- C++ win32线程数上限

hThread = CreateThread( NULL, 0, WorkerFunction, &threadParm, 0, &dwThreadID ); 这样的创建方法 ...

- Nodejs windows的安装

0.下载地址: http://nodejs-org.qiniudn.com/ https://nodejs.org/download/ https://nodejs.org/en/ 1.基本就是一路N ...

- iPhone开发基础教程_第二章

1.各个子文件夹的作用 Classes: 编写的大多代码都保存在这里,其中包括所有的Objective-C类,可以在Classes文件夹下创建一些子 ...

- 基础1.初次接触Jquery

1.浅理解Jquery:jQuery是一个快速的,简洁的javaScript库,使用户能更方便地处理HTML documents.events.实现动画效果,并且方便地为网站提供AJAX交互. 2.D ...