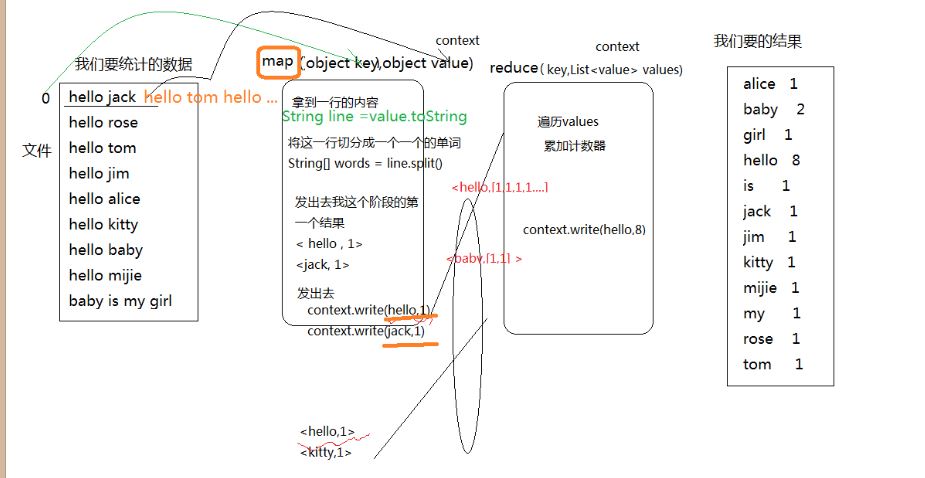

Mapperreduce的wordCount原理

wordcount原理:

1.mapper(Object key,Object value ,Context contex)阶段

2.从数据源读取一行数据传递给mapper函数的value

3.处理数据并将处理结果输出到reduce中去

String line = value.toString();

String[] words = line.split(" ");

context.write(word,1)

4.reduce(Object key ,List<value> values ,Context context)阶段

遍历values累加技术结果,并将数据输出

context.write(word,1)

代码示例:

Mapper类:

package com.hadoop.mr; import java.io.IOException; import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

/**

* Mapper <Long, String, String, Long>

* Mapper<LongWritable, Text, Text, LongWritable>//hadoop对上边的数据类型进行了封装

* LongWritable(Long):偏移量

* Text(String):输入数据的数据类型

* Text(String):输出数据的key的数据类型

* LongWritable(Long):输出数据的key的数据类型

* @author shiwen

*/

public class WordCountMapper extends Mapper<LongWritable, Text, Text, LongWritable>{

@Override

protected void map(LongWritable key, Text value,

Mapper<LongWritable, Text, Text, LongWritable>.Context context)

throws IOException, InterruptedException {

//1.读取一行

String line = value.toString();

//2.分割单词

String[] words = line.split(" ");

//3.统计单词

for(String word : words){

//4.输出统计

context.write(new Text(word), new LongWritable(1));

}

}

}

reduce类

package com.hadoop.mr; import java.io.IOException; import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; public class WordCountReduce extends Reducer<Text, LongWritable, Text, LongWritable>{

@Override

protected void reduce(Text key, Iterable<LongWritable> values,

Reducer<Text, LongWritable, Text, LongWritable>.Context context)

throws IOException, InterruptedException { long count = 0;

//1.遍历vlues统计数据

for(LongWritable value : values){

count += value.get();

}

//输出统计

context.write(key, new LongWritable(count)); } }

运行类:

package com.hadoop.mr; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; import com.sun.jersey.core.impl.provider.entity.XMLJAXBElementProvider.Text; public class WordCountRunner {

public static void main(String[] args) throws IOException, ClassNotFoundException, InterruptedException {

//1.创建配置对象

Configuration config = new Configuration();

//2.Job对象

Job job = new Job(config); //3.设置mapperreduce所在的jar包

job.setJarByClass(WordCountRunner.class); //4.设置mapper的类

job.setMapOutputKeyClass(WordCountMapper.class);

//5.设置reduce的类

job.setReducerClass(WordCountReduce.class); //6.设置reduce输入的key的数据类型

job.setOutputKeyClass(Text.class);

//7.设置reduce输出的value的数据类型

job.setOutputValueClass(LongWritable.class); //8.设置输入的文件位置

FileInputFormat.setInputPaths(job, new Path("hdfs://192.168.1.10:9000/input"));

//9.设置输出的文件位置

FileOutputFormat.setOutputPath(job, new Path("hdfs://192.168.1.10:9000/input")); //10.将任务提交给集群

job.waitForCompletion(true); } }

Mapperreduce的wordCount原理的更多相关文章

- Hive实现WordCount详解

一.WordCount原理 初学MapReduce编程,WordCount作为入门经典,类似于初学编程时的Hello World.WordCount的逻辑就是给定一个/多个文本,统计出文本中每次单词/ ...

- 4、wordcount程序原理剖析及Spark架构原理

一.wordcount程序原理深度剖析 二.Spark架构原理 1.

- MapReduce本地运行模式wordcount实例(附:MapReduce原理简析)

1. 环境配置 a) 配置系统环境变量HADOOP_HOME b) 把hadoop.dll文件放到c:/windows/System32目录下 c) ...

- Hadoop WordCount单词计数原理

计算文件中出现每个单词的频数 输入结果按照字母顺序进行排序 编写WordCount.java 包含Mapper类和Reducer类 编译WordCount.java javac -classpath ...

- Spark入门实战系列--7.Spark Streaming(上)--实时流计算Spark Streaming原理介绍

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .Spark Streaming简介 1.1 概述 Spark Streaming 是Spa ...

- hadoop运行原理之Job运行(二) Job提交及初始化

本篇主要介绍Job从客户端提交到JobTracker及其被初始化的过程. 以WordCount为例,以前的程序都是通过JobClient.runJob()方法来提交Job,但是现在大多用Job.wai ...

- MapReduce编程job概念原理

在Hadoop中,每个MapReduce任务都被初始化为一个job,每个job又可分为两个阶段:map阶段和reduce阶段.这两个阶段分别用两个函数来表示.Map函数接收一个<key,valu ...

- JStorm第一个程序WordCount详解

一.Strom基本知识(回顾) 1,首先明确Storm各个组件的作用,包括Nimbus,Supervisor,Spout,Bolt,Task,Worker,Tuple nimbus是整个storm任务 ...

- 开源分布式实时计算引擎 Iveely Computing 之 WordCount 详解(3)

WordCount是很多分布式计算中,最常用的例子,例如Hadoop.Storm,Iveely Computing也不例外.明白了WordCount在Iveely Computing上的运行原理,就很 ...

随机推荐

- 关于linux中的system函数

Linux下使用system()函数一定要谨慎 https://blog.csdn.net/senen_wakk/article/details/51496322 system()正确应用 https ...

- 微服务测试打桩/mock工具mountebank

1,安装 Linux安装包,不用安装Node.js https://s3.amazonaws.com/mountebank/v1.10/mountebank-v1.10.0-linux-x64.tar ...

- PAT 乙级1030 完美数列(25) C++版

1030. 完美数列(25) 时间限制 300 ms 内存限制 65536 kB 代码长度限制 8000 B 判题程序 Standard 作者 CAO, Peng 给定一个正整数数列,和正整数p,设这 ...

- 第一个react

个人觉着react和vue是很相似的,之前还转载过一篇介绍两个异同点的文章,那个时候还完全不懂react,现在才慢慢开始接触,所以只能总结一些个人的心得,首先自然是react的优点了,个人觉着主要有以 ...

- 服务网关zuul之六:Zuul高可用

我们实际使用Zuul的方式如上图,不同的客户端使用不同的负载将请求分发到后端的Zuul,Zuul在通过Eureka调用后端服务,最后对外输出.因此为了保证Zuul的高可用性,前端可以同时启动多个Zuu ...

- jquery中each()的三种遍历用法

1.选择器+遍历 $('div').each(function (i){ i就是索引值 this 表示获取遍历每一个dom对象 }); 2.选择器+遍历 $('div').each(function ...

- [ZZ]面向对象编程,再见!

面向对象编程,再见!- 机器学习算法与自然语言处理 https://mp.weixin.qq.com/s/icXBlVOOYLvDnER7cEeCeg https://medium.com/@csca ...

- 漫谈数据仓库之拉链表(原理、设计以及在Hive中的实现)

本文将会谈一谈在数据仓库中拉链表相关的内容,包括它的原理.设计.以及在我们大数据场景下的实现方式. 全文由下面几个部分组成: 先分享一下拉链表的用途.什么是拉链表. 通过一些小的使用场景来对拉链表做近 ...

- 在MySQL中实现Rank高级排名函数

MySQL中没有Rank排名函数,当我们需要查询排名时,只能使用MySQL数据库中的基本查询语句来查询普通排名.尽管如此,可不要小瞧基础而简单的查询语句,我们可以利用其来达到Rank函数一样的高级排名 ...

- .net core identity(一)简单运用

1.net core identity涉及到很多知识,很多概念包括Claims,Principal等等概念需要我们一步步学习才能掌握其原理,有两篇博客是比较好的介绍该框架的, https://segm ...