Hadoop化繁为简(一)-从安装Linux到搭建集群环境

简介与环境准备

hadoop的核心是分布式文件系统HDFS以及批处理计算MapReduce。近年,随着大数据、云计算、物联网的兴起,也极大的吸引了我的兴趣,看了网上很多文章,感觉还是云里雾里,很多不必要的配置都在入门教程出现。通过思考总结与相关教程,我想通过简单的方式传递给同样想入门hadoop的同学。其实,如果你有很好的Java基础,当你入门以后,你会感觉到hadoop其实也是很简单的,大数据无非就是数据量大,需要很多机器共同来完成存储工作,云计算无非就是多台机器一起运算。

操作建议:理论先了解三分,先实践操作完毕,再回头看理论,在后续文章我将对理论进行分析,最后用思维导图总结了解它的hadoop的整体面貌。

环境准备:https://pan.baidu.com/s/10Fd-dfeP0Ozk3pXmXb9n9Q 密码:bciy(建议自己去官网下环境,要原生原味的,不要二手货)

CentOS-Linux系统:CentOS-7-x86_64-DVD-1511.iso

VirtualBox虚拟机:VirtualBox-5.1.18-114002-Win.exe

xshell远程登录工具:xshell.exe

xftp远程文件传输:xftp.exe

hadoop:hadoop-2.7.3.tar.gz

jdk8:jdk-8u91-linux-x64.rpm

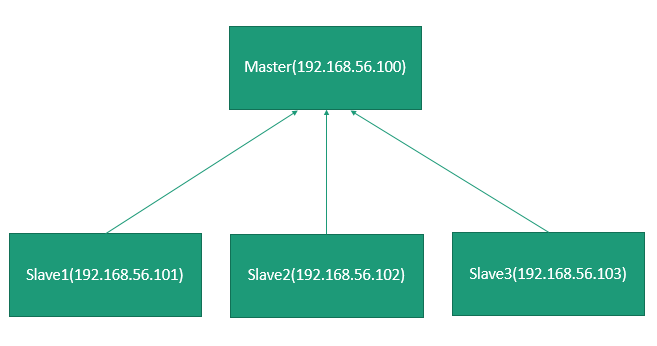

hadoop的物理架构

物理架构:假设机房有四台机器搭建一个集群环境,Master(ip:192.168.56.100)、Slave1(ip:192.168.56.101)、Slave2(ip:192.168.56.102)、Slave3(ip:192.168.56.103)。在这里简要介绍一下,至于具体内容,我将在Hadoop的Hdfs文章详细介绍。

分布式:将不同地点,不同功能的,用于不同数据的多态计算机通过通信网络连接其他,统一控制,协调完成大规模信息处理的计算机系统。简单说,一块硬盘可以分成两部分:文件索引和文件数据,那么文件索引部署在单独一台服务器上我们称为Master根节点(NameNode),文件数据部署在Master结点管理的孩子结点被称为Slave结点(DataNode)。

利用VirtulBox安装Linux

参考:http://www.cnblogs.com/qiuyong/p/6815903.html

配置集群在同一虚拟局域网下通信

说明:通过上述操作,已经搭建好master(192.168.56.100)这台机器,开始配置虚拟网络环境在同一虚拟机下。

- vim /etc/sysconfig/network

- NETWORKING=yes GATEWAY=192.168.56.1(说明:配置意思是,连上VirtualBox这块网卡)

- vim /etc/sysconfig/network-sripts/ifcfg-enp0s3

- TYPE=Ethernet IPADDR=192.168.56.100 NETMASK=255.255.255.0(说明:配置意思是,设置自己ip)

- 修改主机名:hostnamectl set-hostname master

- 重启网络:service network restart

- 查看ip:ifconfig

- 与windows能否ping通、若ping不同,关闭防火墙。master:ping 192.168.56.1 windows:ping 192.168.56.100

- systemctl stop firewalld -->system disable firewalld

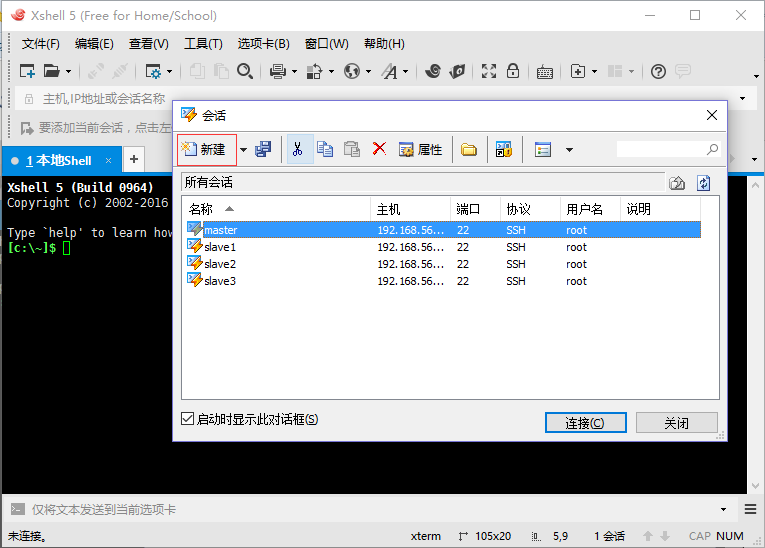

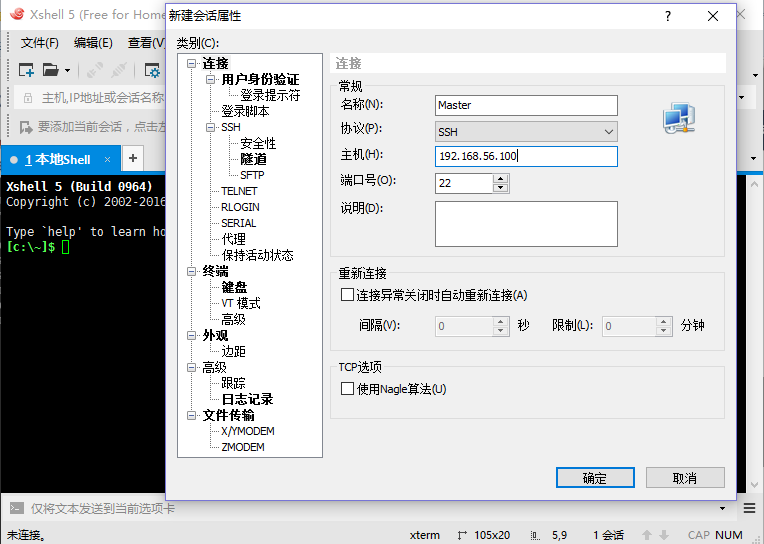

利用Xshell、Xftp进行远程登录与文件传输

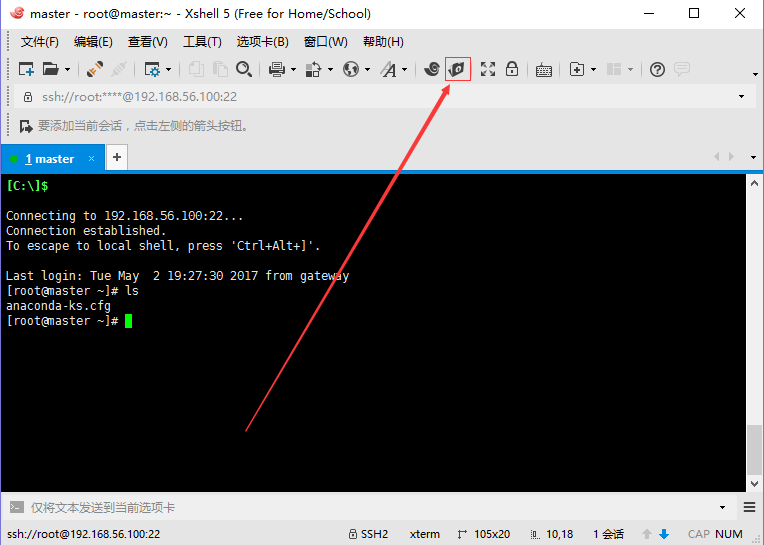

利用VirtualBox登录,上传文件会比较麻烦,采用Xshell远程登录。

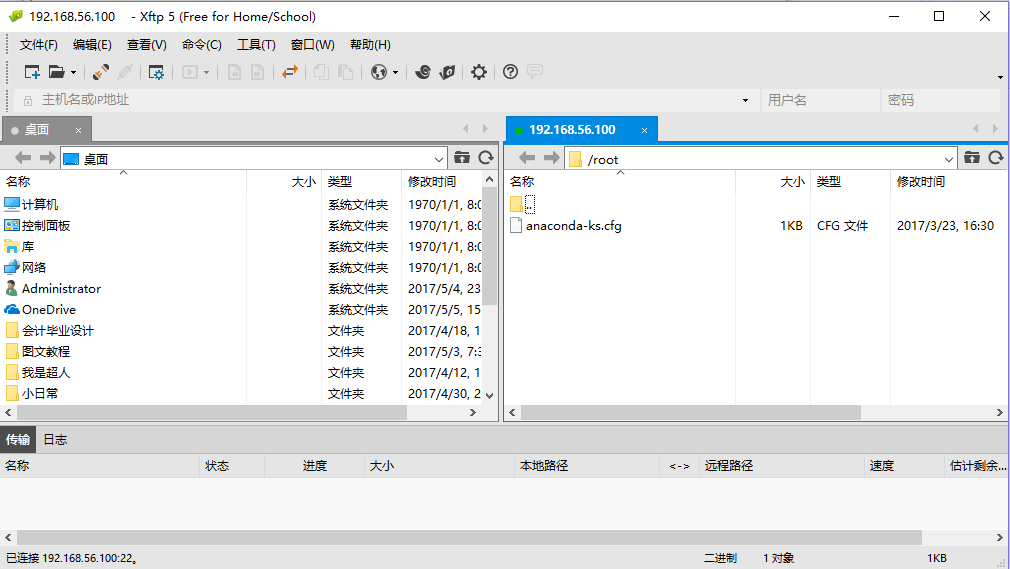

采用Xftp上传文件。

上传hadoop-2.7.3.tar.gz、jdk-8u91-linux-x64.rpm到/usr/local目录下。新手提示:在右边窗口选中/usr/local目录,左边双击压缩包就上传成功了。

配置hadoop环境

- 解压jdk-8u91-linux-x64.rpm:rpm -ivh /usr/local/jdk-8u91-linux-x64.rpm-->默认安装目录到/usr/java

- 确认jdk是否安装成功。 rpm -qa | grep jdk,java -version查看是否安装成功。

- 解压hadoop-2.7.3.tar.gz:tar -vhf /usr/local/hadoop-2.7.3.tar.gz。

- 修改目录名为hadoop:mv /usr/local/hadoop-2.7.3 hadoop

- 切换目录到hadoop配置文件目录:cd /usr/local/hadoop/etc/hadoop

- vim hadoop-env.sh

- 修改export JAVA_HOME 语句为 export JAVA_HOME=/usr/java/default

- 退出编辑页面:按esc键 输入:wq

- vim /etc/profile

- 在文件最后追加 export PATH=$PATH:/usr/hadoop/bin:/usr/hadoop/sbin

- source /etc/profile

发散思考-更进一步

问题1:现在只是配置了一台master?那slave1、slave2、slave3也这样一台一台配置吗?

答:潜意识里面,肯定有解决办法避免。当然,VirtualBox也提供了,复制机器的功能。选中master,右键复制。这样的话,就一台跟master一模一样的机器就搞定了。我们只需要修改网络的相关配置即可。注意:搭建集群环境需要自己复制三台。

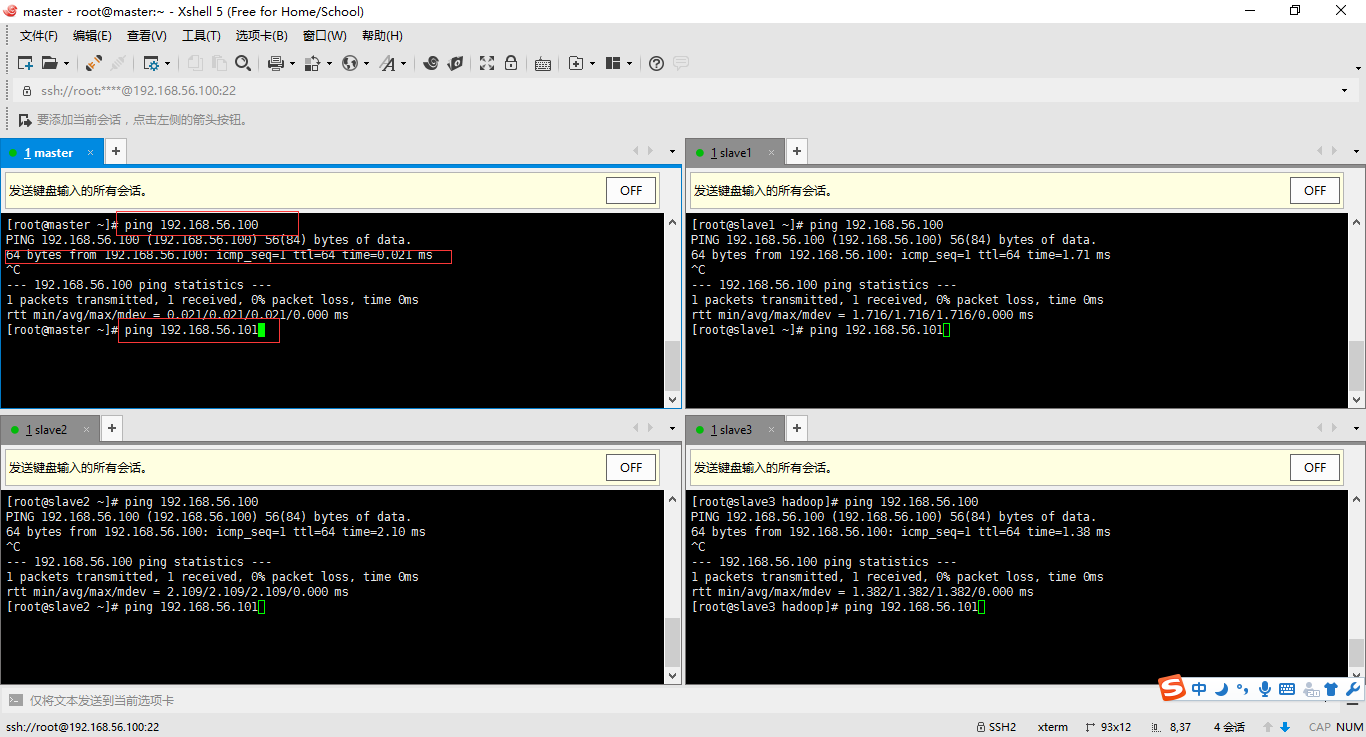

问题2:如何查看这些linux机器是否在同一个环境下?

答:我重新捋一遍内容。启动四台linux机器(可以右键选择无界面启动)-->利用xshell远程登录-->选择工具(发送键到所用界面)。依次输入ping 192.168.56.100、192.168.56.101、192.168.56.102、192.168.56.103。

配置与启动hadoop

1、为四台机器配置域名。vim /etc/hosts

192.168.56.100 master

192.168.56.101 slave1

192.168.56.102 slave2

192.168.56.103 slave3

2、切换到hadoop配置文件目录 /usr/local/hadoop/etc/hadoop vim core-site.xml

3、修改四台linux机器的core-site.xml,指名四台机器谁是master(NameNode)。

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

4、在master结点机器指名它的子节点有哪些:vim /usr/local/hadoop/etc/hadoop/slaves(其实就是指名子节点的ip)

slave1

slave2

slave3

5、初始化一下master配置:hdfs namenode -format

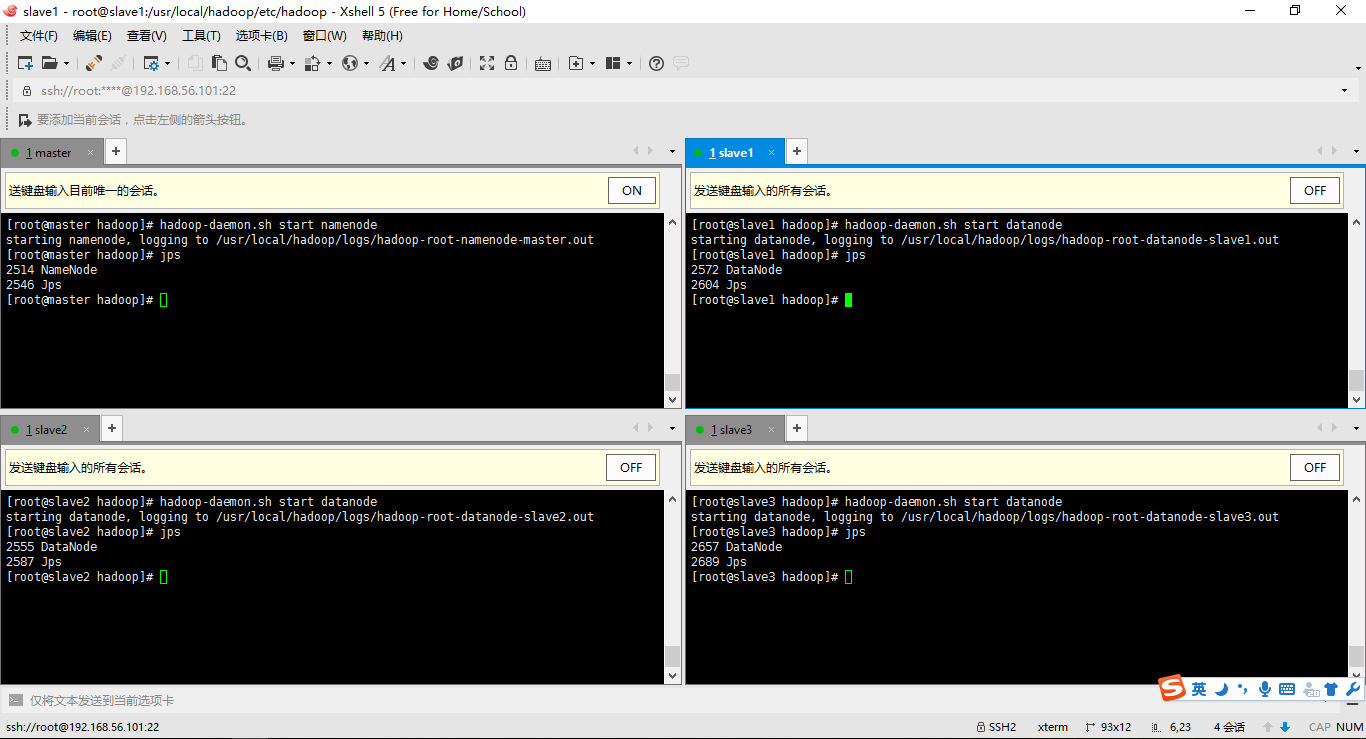

6、启动hadoop集群并且用jps查看结点的启动情况

启动master:hadoop-daemon.sh start namenode

启动slave:hadoop-daemon.sh start datanode

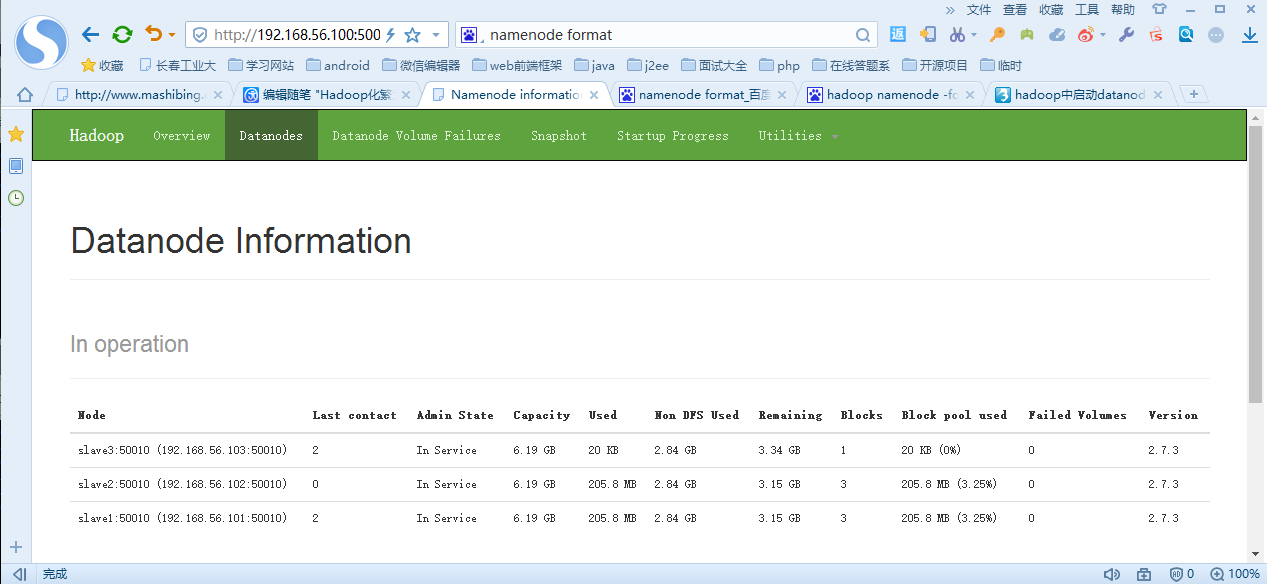

7、查看集群启动情况:hdfs dfsadmin -report或者利用网页http://192.168.56.100:50070/

版权声明

作者:邱勇Aaron

出处:http://www.cnblogs.com/qiuyong/

您的支持是对博主深入思考总结的最大鼓励。

本文版权归作者所有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接,尊重作者的劳动成果。

Hadoop化繁为简(一)-从安装Linux到搭建集群环境的更多相关文章

- Hadoop化繁为简-从安装Linux到搭建集群环境

简介与环境准备 hadoop的核心是分布式文件系统HDFS以及批处理计算MapReduce.近年,随着大数据.云计算.物联网的兴起,也极大的吸引了我的兴趣,看了网上很多文章,感觉还是云里雾里,很多不必 ...

- linux下安装 zookeeper-3.4.9并搭建集群环境

本文主要记录作者在实践过程中实现在centos7环境下安装zookeeper并搭建集群的详细步骤,关于zookeeper本文将不做详细介绍,安装步骤详情如下: 前提准备:3台linux服务器(因为zo ...

- 使用Nginx在windows和linux上搭建集群

Nginx Nginx (engine x) 是一个高性能的HTTP和反向代理服务器,也是一个IMAP/POP3/SMTP服务器 特点:反向代理 负载均衡 动静分离… 反向代理(Reverse Pro ...

- 【Nutch2.3基础教程】集成Nutch/Hadoop/Hbase/Solr构建搜索引擎:安装及运行【集群环境】

1.下载相关软件,并解压 版本号如下: (1)apache-nutch-2.3 (2) hadoop-1.2.1 (3)hbase-0.92.1 (4)solr-4.9.0 并解压至/opt/jedi ...

- 【redis】 linux 下redis 集群环境搭建

Redis集群 (要让集群正常工作至少需要3个主节点,在这里我们要创建6个redis节点,其中三个为主节点,三个为从节点,对应的redis节点的ip和端口对应关系如下) 127.0.0.1:63791 ...

- Nginx --Windows下和Linux下搭建集群小记

nginx: Nginx是一款轻量级的Web 服务器/反向代理服务器及电子邮件(IMAP/POP3)代理服务器 特点: 反向代理 负载均衡 动静分离... 反向代理 : 先来了解正向代理:需要我们用户 ...

- 基于redis 3.x搭建集群环境

由于我团队开发的在线坐席系统,即将面对线上每周3000W的下行投放客户,产品的咨询量可能会很大,基于前期,200W的投放时,前10分钟,大概800问题量,平均一个客户大概8个问题,也就是说每分钟10个 ...

- druid 搭建集群环境

下载druid 下载地址 http://static.druid.io/artifacts/releases/druid-services-0.6.145-bin.tar.gz 解压 tar -zxv ...

- Hadoop学习(一):完全分布式集群环境搭建

1. 设置免密登录 (1) 新建普通用户hadoop:useradd hadoop(2) 在主节点master上生成密钥对,执行命令ssh-keygen -t rsa便会在home文件夹下生成 .ss ...

随机推荐

- CIKM Competition数据挖掘竞赛夺冠算法陈运文

CIKM Competition数据挖掘竞赛夺冠算法陈运文 背景 CIKM Cup(或者称为CIKM Competition)是ACM CIKM举办的国际数据挖掘竞赛的名称.CIKM全称是Intern ...

- nodejs安装zmq出错

想用zmq来做进程间通信,在Windows下.Centos下安装成功.记录如下: 一.Windows安装zmq 直接 npm install zmq 成功就成功. 不成功的话估计是报"未能 ...

- [转载]DOMContentLoaded与interactive

http://www.cnblogs.com/muxrwc/archive/2011/01/13/1934379.html ie中inline script执行时竟然第一次进入页面,doc.ready ...

- 使用js获取浏览器地址栏里的参数

用JS获取地址栏参数的方法(超级简单) 方法一:采用正则表达式获取地址栏参数:( 强烈推荐,既实用又方便!) function GetQueryString(name) { var reg = new ...

- jquery的几种ajax方式对比

jquery的几种ajax方式对比 jquery的ajax方式有如下几种: 1. $.post(url,params,callback); 2. $.getJSON(url,params,ca ...

- linux命令中which、whereis、locate有什么区别?

1.find find是最常用和最强大的查找命令.它能做到实时查找,精确查找,但速度慢. find的使用格式如下: #find [指定目录] [指定条件] [指定动作] 指定目录:是指所要搜索的目录和 ...

- 大数据系列之并行计算引擎Spark介绍

相关博文:大数据系列之并行计算引擎Spark部署及应用 Spark: Apache Spark 是专为大规模数据处理而设计的快速通用的计算引擎. Spark是UC Berkeley AMP lab ( ...

- **CI中的order_by在get_where之前

public function show_list_by_order($array_data, $order_field, $order_mode) { $query = $this->db-& ...

- ***在PHP语言中使用JSON和将json还原成数组(json_decode()的常见错误)

在之前我写过php返回json数据简单实例,刚刚上网,突然发现一篇文章,也是介绍json的,还挺详细,值得参考.内容如下 从5.2版本开始,PHP原生提供json_encode()和json_deco ...

- 方法调用---springMVC中调用controller的方法

我们有一个路由StudentController,里面有一个方法count().如果要在另外一个GradeController中调用count()方法有2种方式: 因为StudentControlle ...