CDH中如何升级Spark

公司平时使用的CDH版本的hadoop生态,spark任务是基于yarn来管理的,而不是基于原生的spark master slave集群管理。

因此任务的大致启动模式是:

如果是Cluster模式:

- A节点启动Spark-submit,这个程序即为client,client连接Resource Manager

- Resource Manager指定一个Node Manager创建AppMaster,这个AppMaster就是Driver

- AppMaster向Resource Manager申请资源创建Spark的Excutor

- Excutor向Driver(AppMaster)报告程序结果

如果是Client模式:

- A节点启动Spark-submit,这个程序就是client,此时直接创建Driver。

- 连接Resource Manager创建AppMaster

- Driver向AppMaster申请创建Excutor,AppMaster再跟Resource Manager申请资源创建Excutor

- Excutor向Driver(Client)报告程序结果

那么这种环境下如何升级Spark呢?

通过上面的过程分析,可以知道,Spark版本存在两个地方:一个是A节点提交Spark-submit的程序必须是2.3.0版本的;另一个是Yarn使用的lib必须是2.3.0版本的。

虽然暂时还屡不清楚来龙去脉,但是跟着过一遍吧!

第一步,在A节点下载spark2.3的jar

[xxx@hnode10 app]$ ls -l

total 628168

drwxrwxr-x 6 hdfs hdfs 4096 Jan 9 10:35 akita

-rw-r--r-- 1 hdfs hdfs 18573432 Jan 9 10:34 akita-release.tar.gz

lrwxrwxrwx 1 hdfs hdfs 46 Jan 2 09:37 canal -> /var/lib/hadoop-hdfs/app/canal.deployer-1.0.25

drwxrwxr-x 6 hdfs hdfs 4096 Jan 2 09:36 canal.deployer-1.0.25

drwxrwxr-x 4 hdfs hdfs 4096 May 31 09:11 hadoop

lrwxrwxrwx 1 root root 50 Jun 5 12:34 spark -> /var/lib/hadoop-hdfs/app/spark-2.2.0-bin-hadoop2.6

drwxr-xr-x 14 hdfs hdfs 4096 Nov 9 2017 spark-2.1.1-bin-hadoop2.6

-rw-r--r-- 1 hdfs hdfs 198804211 Oct 23 2017 spark-2.1.1-bin-hadoop2.6.tgz

drwxr-xr-x 13 hdfs hdfs 4096 Jun 5 12:33 spark-2.2.0-bin-hadoop2.6

-rw-rw-r-- 1 hdfs hdfs 201706782 Jul 11 2017 spark-2.2.0-bin-hadoop2.6.tgz

drwxr-xr-x 13 hdfs hdfs 4096 Feb 23 03:46 spark-2.3.0-bin-hadoop2.6

-rw-rw-r-- 1 hdfs hdfs 224121109 Feb 23 03:54 spark-2.3.0-bin-hadoop2.6.tgz

lrwxrwxrwx 1 root root 25 Jun 6 09:04 spark23 -> spark-2.3.0-bin-hadoop2.6

第二步,修改配置文件和启动脚本

解压后,创建一个新的软连接 spark23到对应的目录:

ln -s /var/lib/hadoop-hdfs/app/spark-2.3.0-bin-hadoop2.6 spark23

然后配置对应的启动脚本:

[xxx@hnode10 bin]$ ls -l

total 9588

-rwxr-xr-x 1 hdfs hdfs 2991 Oct 23 2017 spark2-shell

-rwxr-xr-x 1 hdfs hdfs 1013 Oct 23 2017 spark2-submit

-rwxr-xr-x 1 root root 2993 Jun 6 17:39 spark23-shell

-rwxr-xr-x 1 root root 1015 Jun 6 17:41 spark23-submit

在spark23-submit中修改SPARK_HOME

export SPARK2_HOME=/var/lib/hadoop-hdfs/app/spark23

exec "${SPARK2_HOME}"/bin/spark-class org.apache.spark.deploy.SparkSubmit "$@"

在spark23-shell中修改SPARK_HOME

cygwin=false

case "$(uname)" in

CYGWIN*) cygwin=true;;

esac

# Enter posix mode for bash

set -o posix

export SPARK2_HOME=/var/lib/hadoop-hdfs/app/spark23

....

修改Spark2.3中的配置文件spark-defaults.conf

spark.yarn.jars hdfs://nameservice1/app/spark23/lib/*.jar

spark.history.fs.logDirectory hdfs://nameservice1/user/spark/applicationHistory

其中spark.yarn.jars指定了yarn使用的spark jar包目录。

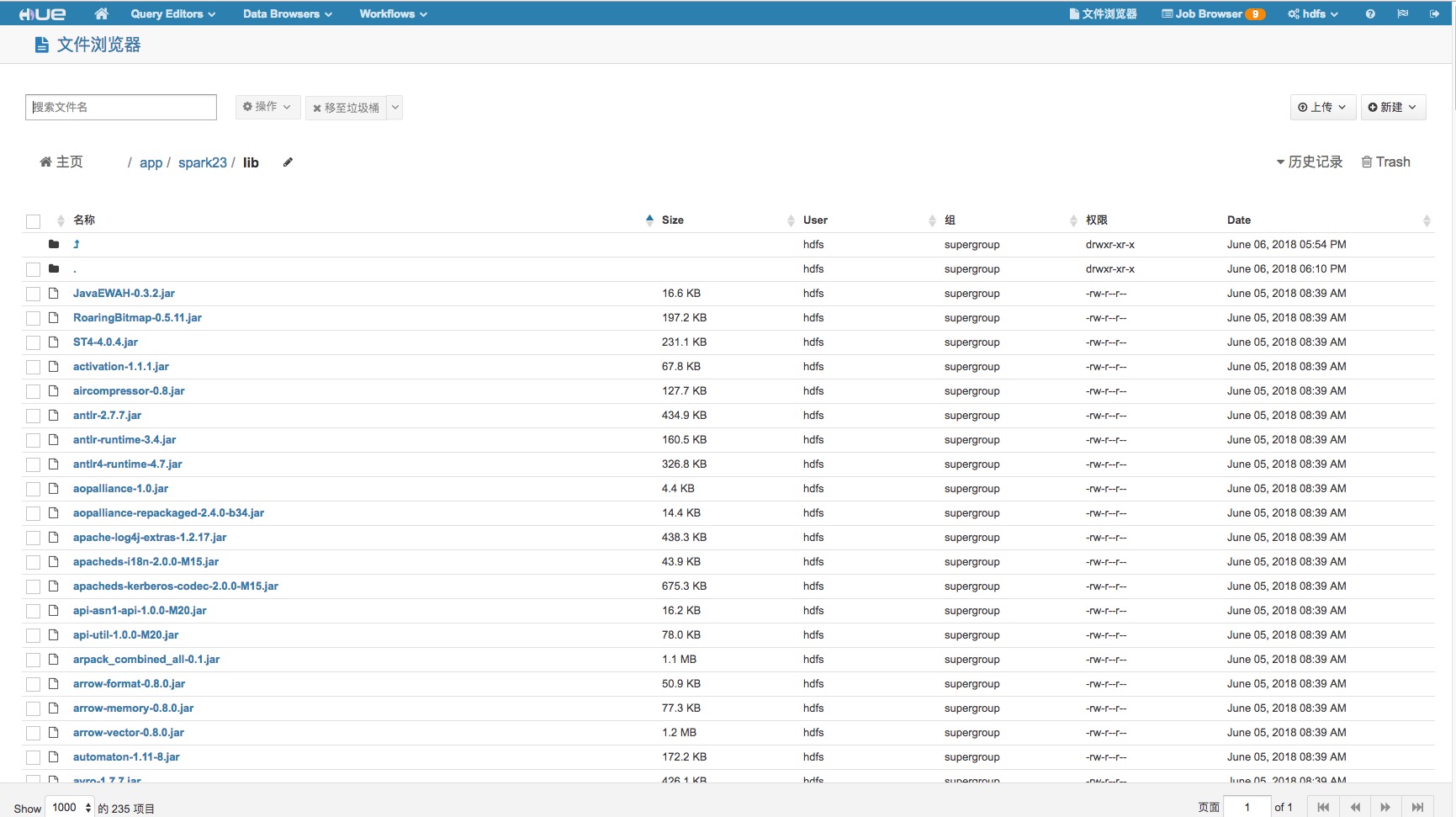

第三步,在hdfs中上传yarn使用的lib

最后,找一个hello world启动下试试吧~

CDH中如何升级Spark的更多相关文章

- 关于CDH中开发Spark

文章发自http://www.cnblogs.com/hark0623/p/4167363.html 转发请注明 注意:基于CDH进行Spark开发时,使用高版本的apache原生包即可:不需要使用C ...

- CentOS7安装CDH 第十章:CDH中安装Spark2

相关文章链接 CentOS7安装CDH 第一章:CentOS7系统安装 CentOS7安装CDH 第二章:CentOS7各个软件安装和启动 CentOS7安装CDH 第三章:CDH中的问题和解决方法 ...

- geotrellis使用(二十四)将Geotrellis移植到CDH中必须要填的若干个坑

目录 前言 若干坑 总结 一.前言 近期干了一件事情,将geotrellis程序移植到CDH中(关于CDH,可以参考安装ClouderaManager以及使用ClouderaManage ...

- cdh环境下,spark streaming与flume的集成问题总结

文章发自:http://www.cnblogs.com/hark0623/p/4170156.html 转发请注明 如何做集成,其实特别简单,网上其实就是教程. http://blog.csdn.n ...

- Apache Spark 2.2.0 中文文档 - Spark Streaming 编程指南 | ApacheCN

Spark Streaming 编程指南 概述 一个入门示例 基础概念 依赖 初始化 StreamingContext Discretized Streams (DStreams)(离散化流) Inp ...

- Apache Spark 2.2.0 中文文档 - Spark SQL, DataFrames and Datasets Guide | ApacheCN

Spark SQL, DataFrames and Datasets Guide Overview SQL Datasets and DataFrames 开始入门 起始点: SparkSession ...

- 某人在企业中遇到的Spark问题记录[持续更新]

https://github.com/ssg-7max/ssg 目前 ssg内公司内部 spark streaming 处理数据源是kafka 目前遇到最大的问题是,会延迟,例如我们配置1分钟让窗口计 ...

- CentOS7安装CDH 第九章:CDH中安装Kafka

相关文章链接 CentOS7安装CDH 第一章:CentOS7系统安装 CentOS7安装CDH 第二章:CentOS7各个软件安装和启动 CentOS7安装CDH 第三章:CDH中的问题和解决方法 ...

- CentOS7安装CDH 第八章:CDH中对服务和机器的添加与删除操作

相关文章链接 CentOS7安装CDH 第一章:CentOS7系统安装 CentOS7安装CDH 第二章:CentOS7各个软件安装和启动 CentOS7安装CDH 第三章:CDH中的问题和解决方法 ...

随机推荐

- Selenium实战总结(webwiew下拉框定位)

基于常见的两种下拉框的展示形式: 1.点击弹出下拉框: 2.鼠标移动弹出下拉框(move_to_element) 实例一[鼠标点击弹出的下拉框]: e.g百度首页的设置--高级搜索--时间: 导包: ...

- 2018.10.30 NOIP训练 【模板】树链剖分(换根树剖)

传送门 纯粹是为了熟悉板子. 然后发现自己手生了足足写了差不多25min而且输出的时候因为没开long longWA了三次还不知所云 代码

- static关键字的功能

转载:https://blog.csdn.net/guotianqing/article/details/79828100 C语言&C++ 1.局部变量 如果在一个函数内部定义了一个静态变量, ...

- android检测手机是否安装某个app

public static boolean isAvilible(Context context, String packageName){ //获取packagemanager final Pack ...

- 03 编写URL规则

3-1 URL编写规则 # 在每个App中设置独立的静态资源和模板文件并添加一个空白内容的urls.py文件. # 当程序收到用户请求的时候,首先在根目录的urls.py查找该URL属于哪个APP,然 ...

- php,微信公众号,获取用户地理位置 定位 经纬度

<?php //php插件下载地址: https://files.cnblogs.com/files/fan-bk/jssdk_php.rar //建立一个php文件 require_once ...

- 发布自己的第一版asp.net core的RESTful接口程序

使用window开发一个简单的asp.net Core的RESTfull程序,网上很多,这里不说,我是直接使用IDE自己生成的项目来发布的.没有修改过主要代码.在IDE里发布到本地目录,得到类似文件 ...

- 20171126--handlerThread

1.首先看下handlerThread和普通的线程Thread的使用区别: HandlerThread本质上就是一个普通Thread,只不过内部建立了Looper. 为线程创建Looper的方法如下: ...

- c++ cout、<< 、cin、>> 、endl 详解

std::cout是在#include<iostream>库中的ostream类型中的对象 std::表示命名空间,标准库定义的所有名字都在命名空间std中 std::cout是在#inc ...

- window+R

好记性不如烂笔头, window+R:打开运行 等同于:所有程序-->附件-->运行