课程一(Neural Networks and Deep Learning),第二周(Basics of Neural Network programming)—— 1、10个测验题(Neural Network Basics)

--------------------------------------------------中文翻译-----------------------------------------------------------------------------------------

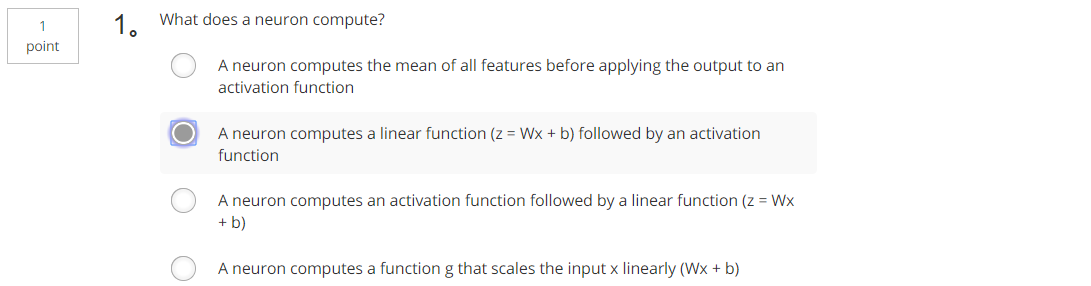

1、神经元的计算是什么?(B)

B. 神经元计算一个线性函数 (z = Wx + b), 然后是一个激活函数

C. 神经元计算一个激活函数, 后跟一个线性函数 (z = Wx + b)

D. 一个神经元计算一个函数 g, 它将输入 x 线性地缩放 (Wx + b)

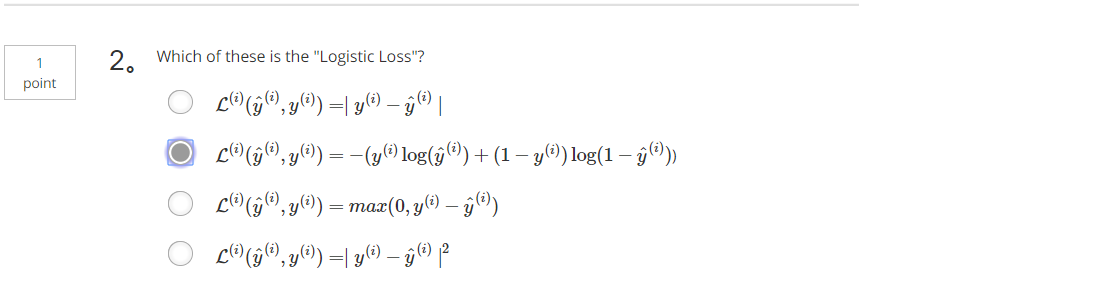

2、下面哪个是损失函数?(B)

见对应的英文题2

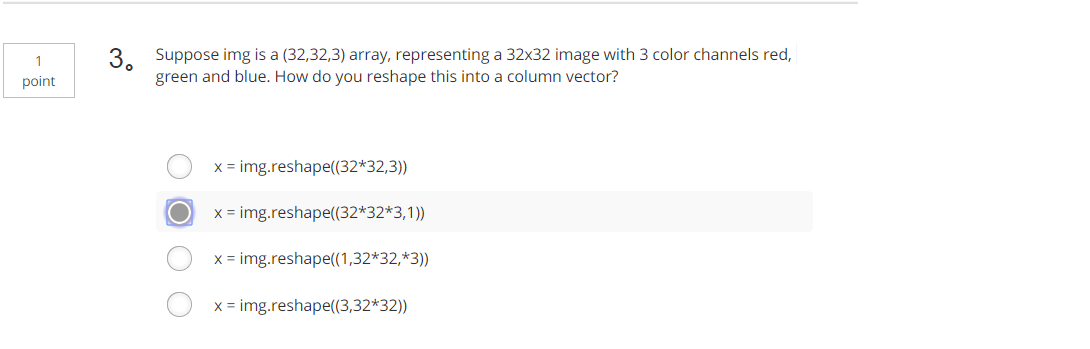

3、假设 img 是一个 (32,32,3) 数组, 代表一个32x32 的图像与3色通道红色, 绿色和蓝色。如何将其重塑为列向量?(B)

A. x = img 重塑 (32 * 32,3))

B. x = img 重塑 (32 * 32 * 3,1))

a = np.random.randn(2, 3) # a.shape = (2, 3)

b = np.random.randn(2, 1) # b.shape = (2, 1)

c = a + b

A. c.shape = (2, 1)

B. c.shape = (2, 3)

C. c.shape = (3, 2)

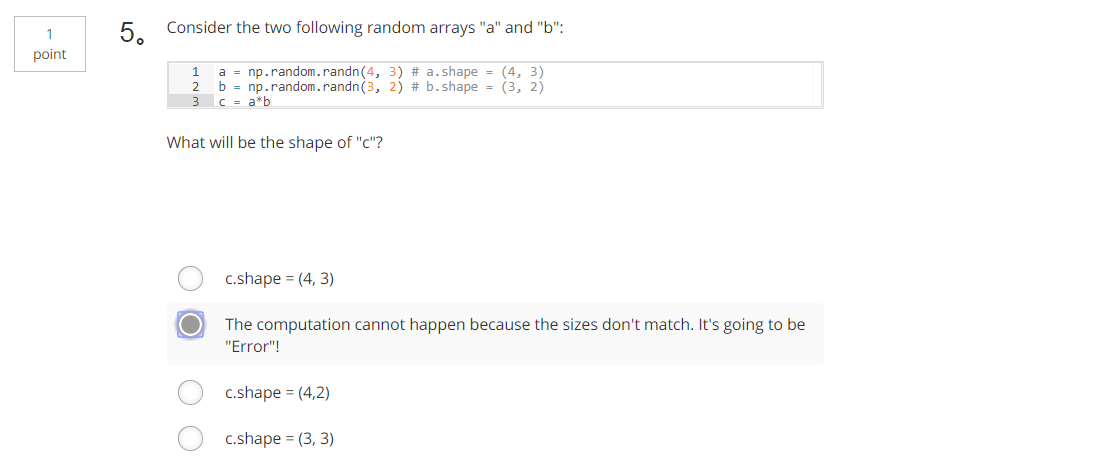

5、考虑以下两个随机数组 "a" 和 "b", "c" 的形状是什么?(A)

a = np.random.randn(4, 3) # a.shape = (4, 3)

b = np.random.randn(3, 2) # b.shape = (3, 2)

c = a*b

A. 由于大小不匹配, 无法进行计算。这将是 "错误"!

A. c.shape = (3, 3)

B. c.shape = (4, 2)

C. c.shape = (4, 3)

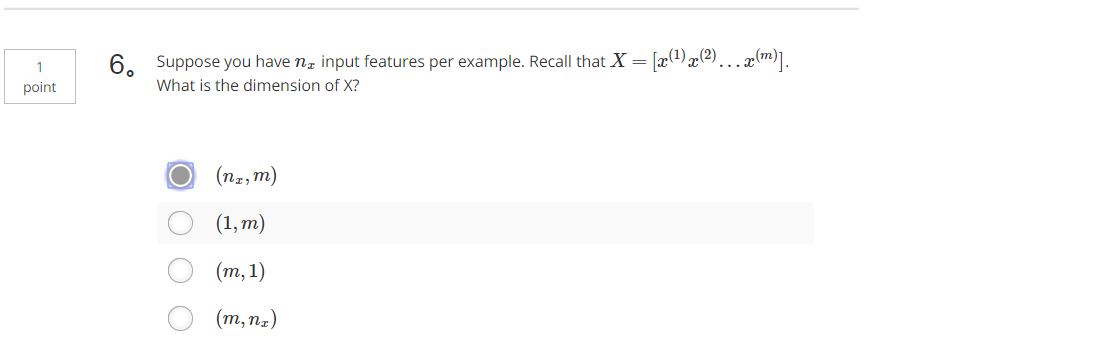

6、假设每一个样本的特征为nx维,X=[x(1)x(2)...x(m)],X的维度是多少?(A)

A. (nx,m)

B. (1,m)

C. (m,1)

D. (m,nx)

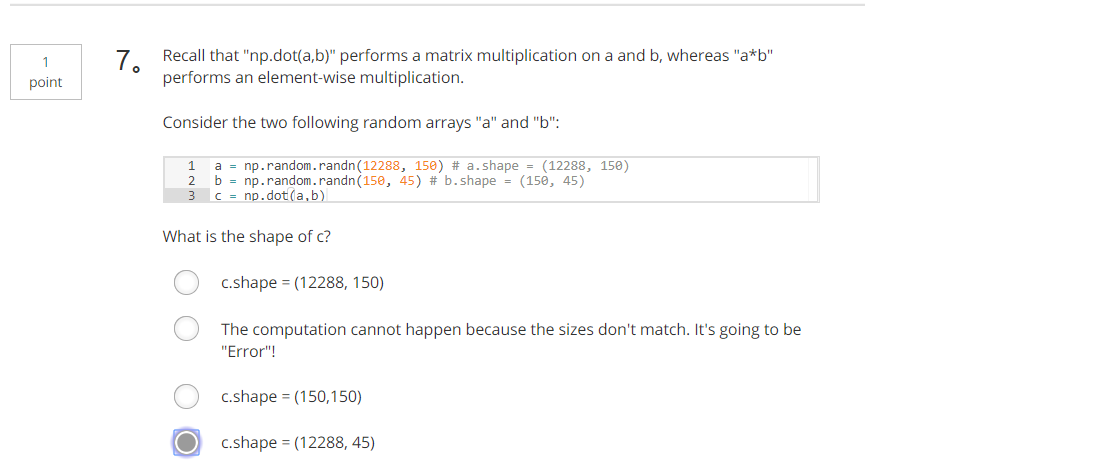

7、记得 "np. dot(a, b)" 在 a 和 b 上执行矩阵乘法, 而 "a * b" 执行元素乘法。考虑以下两个随机数组 "a" 和 "b":

a = np.random.randn(12288, 150) # a.shape = (12288, 150)

b = np.random.randn(150, 45) # b.shape = (150, 45)

c = np.dot(a,b)

A. c. 形状 = (12288, 150)

B. 由于大小不匹配, 无法进行计算。这将是 "错误"!

C. c. 形状 = (150150)

D. c. 形状 = (12288, 45)

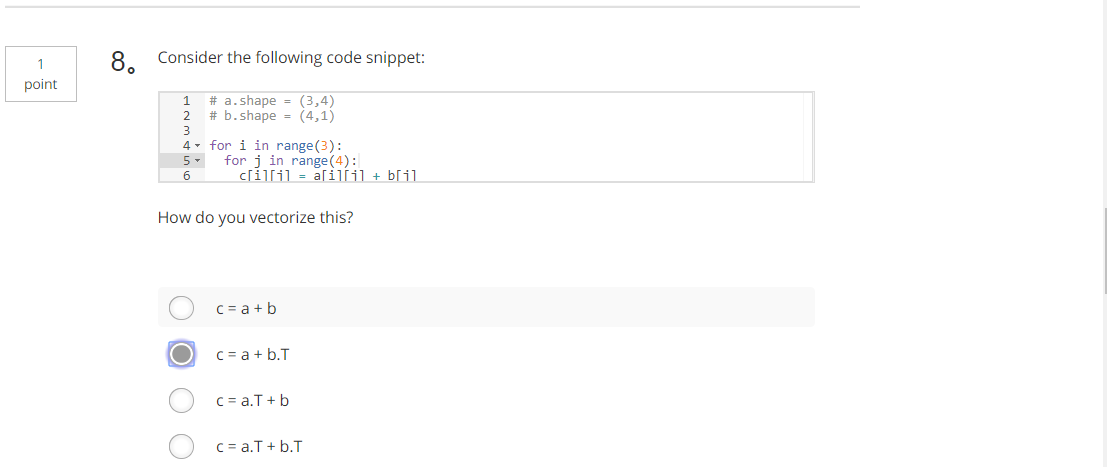

8、请考虑以下代码段,你怎么量化?(B)

# a.shape = (3,4)

# b.shape = (4,1) for i in range(3):

for j in range(4):

c[i][j] = a[i][j] + b[j]

A. c = a + b

B. c = a + b.T

C. c = a.T + b

D. c = a.T + b.T

9、请考虑以下代码:c的结果?(如果您不确定, 请随时在 python 中运行此查找)。(A)

a = np.random.randn(3, 3)

b = np.random.randn(3, 1)

c = a*b

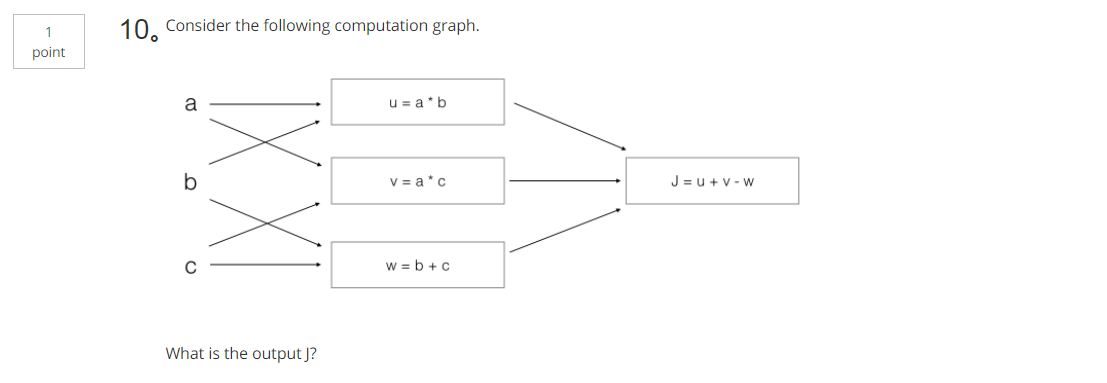

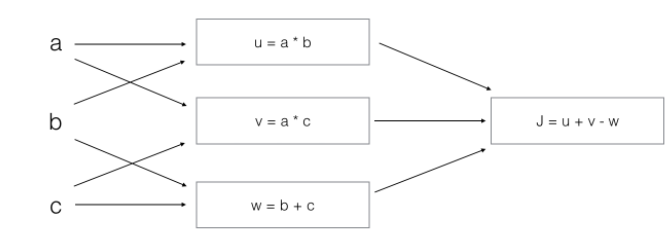

A. J = (c - 1)*(b + a)

B. J = (a - 1) * (b + c)

C. J = a*b + b*c + a*c

D. J = (b - 1) * (c + a)

课程一(Neural Networks and Deep Learning),第二周(Basics of Neural Network programming)—— 1、10个测验题(Neural Network Basics)的更多相关文章

- 吴恩达《深度学习》-第一门课 (Neural Networks and Deep Learning)-第二周:(Basics of Neural Network programming)-课程笔记

第二周:神经网络的编程基础 (Basics of Neural Network programming) 2.1.二分类(Binary Classification) 二分类问题的目标就是习得一个分类 ...

- 【DeepLearning学习笔记】Coursera课程《Neural Networks and Deep Learning》——Week2 Neural Networks Basics课堂笔记

Coursera课程<Neural Networks and Deep Learning> deeplearning.ai Week2 Neural Networks Basics 2.1 ...

- 【DeepLearning学习笔记】Coursera课程《Neural Networks and Deep Learning》——Week1 Introduction to deep learning课堂笔记

Coursera课程<Neural Networks and Deep Learning> deeplearning.ai Week1 Introduction to deep learn ...

- 第四节,Neural Networks and Deep Learning 一书小节(上)

最近花了半个多月把Mchiael Nielsen所写的Neural Networks and Deep Learning这本书看了一遍,受益匪浅. 该书英文原版地址地址:http://neuralne ...

- Neural Networks and Deep Learning学习笔记ch1 - 神经网络

近期開始看一些深度学习的资料.想学习一下深度学习的基础知识.找到了一个比較好的tutorial,Neural Networks and Deep Learning,认真看完了之后觉得收获还是非常多的. ...

- Neural Networks and Deep Learning

Neural Networks and Deep Learning This is the first course of the deep learning specialization at Co ...

- [C3] Andrew Ng - Neural Networks and Deep Learning

About this Course If you want to break into cutting-edge AI, this course will help you do so. Deep l ...

- 《Neural Networks and Deep Learning》课程笔记

Lesson 1 Neural Network and Deep Learning 这篇文章其实是 Coursera 上吴恩达老师的深度学习专业课程的第一门课程的课程笔记. 参考了其他人的笔记继续归纳 ...

- 课程一(Neural Networks and Deep Learning),第二周(Basics of Neural Network programming)—— 4、Logistic Regression with a Neural Network mindset

Logistic Regression with a Neural Network mindset Welcome to the first (required) programming exerci ...

- Neural Networks and Deep Learning 课程笔记(第四周)深层神经网络(Deep Neural Networks)

1. 深层神经网络(Deep L-layer neural network ) 2. 前向传播和反向传播(Forward and backward propagation) 3. 总结 4. 深层网络 ...

随机推荐

- Educational Codeforces Round 54 E. Vasya and a Tree(树上差分数组)

https://codeforces.com/contest/1076/problem/E 题意 给一棵树(n<=3e5),m(3e5)次查询,每次查询u,d,x,表示在u的子树中,给距离u&l ...

- excel中vba求摩尔圆包线

Dim f As Double, f1 As Double, f2 As Double, df As Double, oxy() As Double, R() As Double, k As Doub ...

- js判断软键盘是否开启弹出

移动端关于页面布局,如果底部有position:fixed的盒子,又有input,当软键盘弹出收起都会影响页面布局.这时候Android可以监听resize事件,代码如下,而ios没有相关事件. va ...

- BAT的真的适合创业团队吗?

平时在公司扮演一个逗比得角色和亲爱的们友好相处的我根本不愿意去思考这么深入的课题.本来在上一家公司就涉及的太深,心爱的一条小产品线被咔掉后心疼不已.只想深入研究技术不问世事了.怎奈何突然有一天说要招一 ...

- Codeforces Round #536 (Div. 2) B. Lunar New Year and Food Ordering

#include <bits/stdc++.h> #define N 300010 #define PII pair<int, int> using namespace std ...

- JS 对象(Object)和字符串(String)互转方法

利用原生JSON对象,将对象转为字符串 1 2 3 4 5 6 var jsObj = {}; jsObj.testArray = [1,2,3,4,5]; jsObj.name = 'CSS3'; ...

- 1、K-means

k-means(K均值) 1.无监督聚类算法 2.K---分成K类 3.分类准则:使得样本与各类中心之间的误差平方和最小 --------------------------------------- ...

- 2.启动MySql服务

windows10下启动mysql服务出现服务名无效的原因及解决方法 问题原因:mysql服务没有安装. 解决办法: 在 mysql bin目录下 以管理员的权限 执行 mysqld -install ...

- FastReport报表设计(仔细看)

FastReport报表设计 2011-06-16 16:56:19| 分类: 系统开发|举报|字号 订阅 下载LOFTER我的照片书 | 目录 5.1 前言 5.2 基本概念及操 ...

- 如何把jar包发布到maven私服

1.格式 mvn deploy:deploy-file -DgroupId=com.qiyi -DartifactId=sphinx -Dversion=1.0 -Dpackaging=jar -Df ...