Graph-GCN

前言

在大型图中,节点的低维向量embedding被证明了作为各种各样的预测和图分析任务的特征输入是非常有用的。顶点embedding最基本的基本思想是使用降维技术从高维信息中提炼一个顶点的邻居信息,存到低维向量中。这些顶点嵌入之后会作为后续的机器学习系统的输入,解决像顶点分类、聚类、链接预测这样的问题

GCN基本思想:把一个节点在图中的高纬度邻接信息降维到一个低维的向量表示.

GCN的优点: 可以捕捉graph的全局信息,从而很好地表示node的特征.

GCN的缺点: Transductive learning的方式,需要把所有节点都参与训练才能得到node embedding,无法快速得到新node的embedding。

transductive learning

GCN的方法 本质上是transductive learning (直推式的),图中的所以顶点都在训练embedding时参与.

transductive learning vs inductive learning

前人的工作专注于从一个固定的图中对顶点进行表示,很多现实中的应用需要很快的对未见过的顶点或是全新的图(子图)生成embedding。这种推断的能力对于高吞吐的机器学习系统来说很重要,这些系统都运作在不断演化的图上,而且时刻都会遇到未见过的顶点(比如Reddit上的帖子(posts),Youtube上的用户或视频)。因此,一种inductive的学习方法比transductive的更重要。

Transductive learning 得到新节点的难处:

要想得到新节点的表示,需要让新的graph或者subgraph去和已经优化好的node embedding去“对齐(align)”。然而每个节点的表示都是受到其他节点的影响,因此添加一个节点,意味着许许多多与之相关的节点的表示都应该调整。这会带来极大的计算开销,即使增加几个节点,也要完全重新训练所有的节点。

节点embedding

Grarep: Learning graph representations with global structural information. In KDD, 2015

node2vec: Scalable feature learning for networks. In KDD, 2016

Deepwalk: Online learning of social representations. In KDD, 2014

Line: Large-scale information network embedding. In WWW, 2015

Structural deep network embedding. In KDD, 2016

以上论文 embedding算法直接训练单个节点的节点embedding,本质上是transductive.而且需要大量的额外训练(如随机梯度下降)使他们能预测新的顶点。

图卷积网络

Spectral networks and locally connected networks on graphs. In ICLR, 2014

Convolutional neural networks on graphs with fast localized spectral filtering. In NIPS, 2016

Convolutional networks on graphs for learning molecular fingerprints. In NIPS,2015

Semi-supervised classification with graph convolutional networks. In ICLR, 2016

Learning convolutional neural networks for graphs. In ICML, 2016

这些方法中的大多数不能扩展到大型图,或者设计用于全图分类(或者两者都是)

GraphSAGE可以看作是对transductive的GCN框架对inductive下的扩展。

详细介绍GCN:

GCN为什么出现?

当前的CNN RNN不能够处理图结构的数据, 图的结构不规则, 可认为为无线维的数据, 没有平移不变性,

出现了 GNN, DeepWalk, node2vec等方法.

GNN 概述

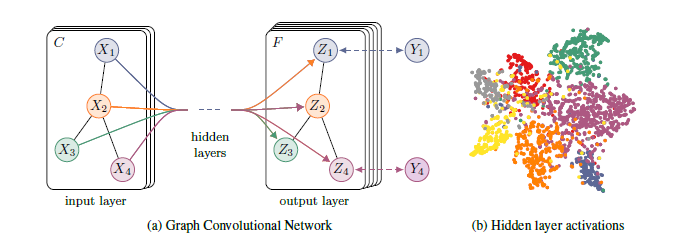

GCN,图卷积神经网络,实际上跟CNN的作用一样,就是一个特征提取器,只不过它的对象是图数据。GCN精妙地设计了一种从图数据中提取特征的方法,从而让我们可以使用这些特征去对图数据进行节点分类(node classification)、图分类(graph classification)、边预测(link prediction),还可以顺便得到图的嵌入表示(graph embedding),可见用途广泛。因此现在人们脑洞大开,让GCN到各个领域中发光发热。

GCN的定义

设 图中数据是 N个节点, 这些节点的特征组成一个N*D维的矩阵$X$作为特征矩阵, 形成一个N*N的邻接矩阵$A$,

一般在初始化时候:

$H_{v}^{0}=X_{v}^{0} \quad v\in NodeSet$

层之前的传播方式:

$H^{l+1}=\sigma(\tilde{D}^{-\frac{1}{2}}\tilde{A}\tilde{D}^{-\frac{1}{2}}H^{(l)}W^{(l)})$ (1)

$\tilde{A}=A+I$, I是一个单位矩阵,$\tilde{A}$是对称矩阵

$\tilde{D}$是度量矩阵,D在实数域是正定对称的,在复数域是hemite正定,$(\alpha,\beta)=x^{T}Ay$表示

$H^{l}$是每一层的特征, 对于输入层的话$H=x$

$\sigma$是非线性激活函数

$\tilde{D}^{-\frac{1}{2}}\tilde{A}\tilde{D}^{-\frac{1}{2}}$ 知道邻接矩阵,可以求得他的在线性空间中的一组基,

进行初等行变换,且A加上了单位矩阵且是对称的,极易求解.整个部分可以得到.

Eqn. (1) 很好的提取了图的特征

通过若干层的 node的特征由x变为了z, node之前的连接关系 都可由邻接矩阵 线性表述, 始终保持着

node之间的关系.

两层 GCN, 激活函数为Relu 和 Softmax 整体的forward:

$Z=f(X,A)= softmax(\hat{A}ReLU(\hat{A}XW^{0})W^{1})$,

where $\hat{A}=\tilde{D}^{-\frac{1}{2}}\tilde{A}\tilde{D}^{-\frac{1}{2}}$

如果任务是有监督的, 通过label计算crossentropy loss:

$L=- \sum \sum Y_{lf}lnZ_{lf}$

很少有节点有label, 所以称为semi-supervised.

每层 输入都包含了邻接矩阵A和node的特征H, 直接做一个内积,再乘一个可学习的参数矩阵, 并进行

非线性激活,可简单表示为:

$f(H^{l},A)=\sigma(AH^{(l)}W^{(l)})$

这个简单模型有一些局限性:

1.由于A为对称矩阵,且主对角线是0, 加上单位矩阵,即可引入自己的特征,避免只计算neighbor特征的加权和.

2.A是没有经过归一化的矩阵,这样与特征矩阵相乘会改变特征原本的分布,产生一些不可预测的问题。所以我们对A做一个标准化处理。首先让A的每一行加起来为1,我们可以乘以一个$D^{-1}$, 进一步的将

$D^{-1}$拆开与A相乘,得到对称归一化矩阵,与对称归一化拉普拉斯矩阵十分类似,而在谱图卷积的核心就是使用对称归一化拉普拉斯矩阵,这也是GCN的卷积叫法的来历

实验结果:

因为即使不训练,完全使用随机初始化的参数W,GCN提取出来的特征就以及十分优秀了!这跟CNN不训练是完全不一样的,后者不训练是根本得不到什么有效特征的。

GCN网络的层数多少比较好?论文的作者做过GCN网络深度的对比研究,在他们的实验中发现,GCN层数不宜多,2-3层的效果就很好了。

Graph-GCN的更多相关文章

- GNN 相关资料记录;GCN 与 graph embedding 相关调研

最近做了一些和gnn相关的工作,经常听到GCN 和 embedding 相关技术,感觉很是困惑,所以写下此博客,对相关知识进行索引和记录: 参考链接: https://www.toutiao.com/ ...

- 【GCN】图卷积网络初探——基于图(Graph)的傅里叶变换和卷积

[GCN]图卷积网络初探——基于图(Graph)的傅里叶变换和卷积 2018年11月29日 11:50:38 夏至夏至520 阅读数 5980更多 分类专栏: # MachineLearning ...

- GNN 相关资料记录;GCN 与 graph embedding 相关调研;社区发现算法相关;异构信息网络相关;

最近做了一些和gnn相关的工作,经常听到GCN 和 embedding 相关技术,感觉很是困惑,所以写下此博客,对相关知识进行索引和记录: 参考链接: https://www.toutiao.com/ ...

- GCN(Graph Convolutional Network)的简单公式推导

第一步:从前一个隐藏层到后一个隐藏层,对结点进行特征变换 第二步:对第一步进行具体实现 第三步:对邻接矩阵进行归一化(行之和为1) 邻接矩阵A的归一化,可以通过度矩阵D来实现(即通过D^-1*A来实现 ...

- GCN: Graph Convolutional Network

从CNN到GCN的联系与区别: https://www.zhihu.com/question/54504471/answer/332657604 更加详解Laplacian矩阵: https://ww ...

- GCN code parsing

GCN code parsing 2018-07-18 20:39:11 utils.py --- load data def load_data(path="../data/cora/ ...

- 【论文笔记】Spatial Temporal Graph Convolutional Networks for Skeleton-Based Action Recognition

Spatial Temporal Graph Convolutional Networks for Skeleton-Based Action Recognition 2018-01-28 15:4 ...

- 论文笔记之:Semi-supervised Classification with Graph Convolutional Networks

Semi-supervised Classification with Graph Convolutional Networks 2018-01-16 22:33:36 1. 文章主要思想: 2. ...

- Graph Convolutional Networks (GCNs) 简介

Graph Convolutional Networks 2018-01-16 19:35:17 this Tutorial comes from YouTube Video:https://www ...

- Graph 卷积神经网络:概述、样例及最新进展

http://www.52ml.net/20031.html [新智元导读]Graph Convolutional Network(GCN)是直接作用于图的卷积神经网络,GCN 允许对结构化数据进行端 ...

随机推荐

- 关于windows服务器的Security安全类日志的导出

对于windows服务器,日志的分类会有很多,可以通过wevtutil el 列出 有时可能会对Security安全类日志进行审计,这里简单讲一下安全类日志的导出方法 1.直接在cmd中执行 wevt ...

- dubbo学习(四)配置dubbo 注解方式配置

provider(生产者) service注解暴露服务 /** * 用户管理实现类 */ @Service //用的dubbo的注解,表明这是一个分布式服务 @Component //注册为sprin ...

- 趣图:这是拿offer极高的面试经验

扩展阅读 趣图:面试谈薪资就要这种底气 趣图:IT培训出来找工作 趣图:这是招聘超神级别的程序员?

- linux学习(四)Linux 文件基本属性

一.引言 Linux系统是一种典型的多用户系统,不同的用户处于不同的地位,拥有不同的权限. 为了保护系统的安全性,Linux系统对不同的用户访问同一文件(包括目录文件)的权限做了不同的规定. 在Lin ...

- Python2.7集成scrapy爬虫错误解决

运行报错: NotSupported: Unsupported URL scheme 'https':.... 解决方法:降低对应package的版本 主要是scrapy和pyOpenSSL的版本 具 ...

- 【MindSpore】Docker上成功使用MindSpore1.0.0的GPU版本

本文是在宿主机Ubuntu16.04上安装Docker(nvidia-docker),并成功进行MindSpore1.0.0的GPU训练: Ubuntu 16.04 Docker Nvidia-doc ...

- git如何上传文件夹

git是不支持上传空文件夹的,文件夹里面必须有文件才可以 1.本地仓库上传文件夹到远程 在本地仓库新建一个文件夹,如果里面没有文件,那么$ git push origin master 不能将文件夹p ...

- Python练习题 001:4个数字求不重复的3位数

听说做练习是掌握一门编程语言的最佳途径,那就争取先做满100道题吧. ----------------------------------------------------------------- ...

- 音频数据增强及python实现

博客作者:凌逆战 博客地址:https://www.cnblogs.com/LXP-Never/p/13404523.html 音频时域波形具有以下特征:音调,响度,质量.我们在进行数据增强时,最好只 ...

- sort函数居然能改变元素值?记一次有趣的Bug——四数之和

坐标leetcode: 我想都不想直接深度优先搜索暴力求解: class Solution { public: vector<vector<int>> res; //答案 in ...