三、k8s集群可用性验证与调参(第一章、k8s高可用集群安装)

作者:北京小远

出处:http://www.cnblogs.com/bj-xy/

参考课程:Kubernetes全栈架构师(电脑端购买优惠)

文档禁止转载,转载需标明出处,否则保留追究法律责任的权利!

目录:

一、集群可用性验证

k8s安装完成后需要进行可用性验证,因为k8s中有pod通信 server通信 node通信要保证通信正常

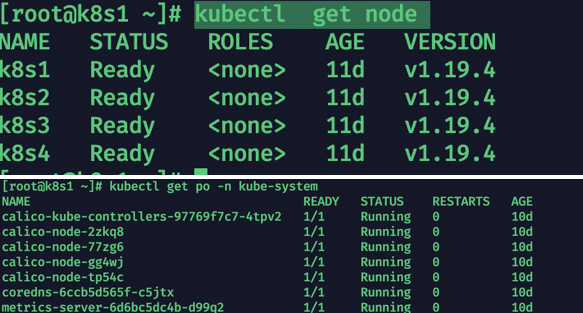

1、1查看基本组件情况

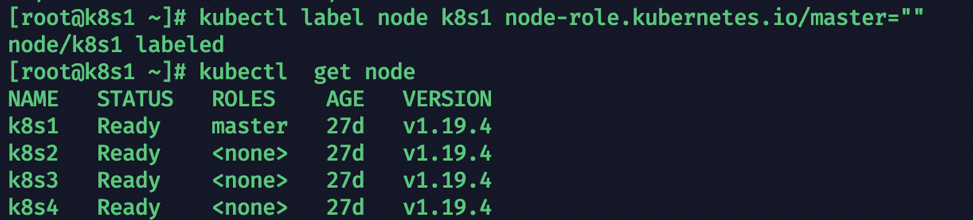

kubectl get node

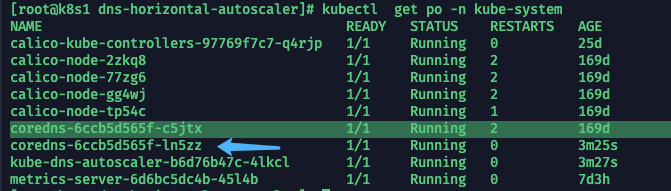

kubectl get po -n kube-system

1、2创建测试pod

cat<<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: busybox

namespace: default

spec:

containers:

- name: busybox

image: busybox:1.28

command:

- sleep

- "3600"

imagePullPolicy: IfNotPresent

restartPolicy: Always

EOF

1.3 测试连通性

1、测试pod能否解析同namespace的kubernetes的 svc

kubectl get svc (查看kubernetes的svc)

kubectl exec busybox -n default -- nslookup kubernetes (解析)

结果:

Server: 10.96.0.10

Address 1: 10.96.0.10 kube-dns.kube-system.svc.cluster.local

Name: kubernetes

Address 1: 10.96.0.1 kubernetes.default.svc.cluster.local

2、测试pod能否解析跨namespace的 svc

kubectl get svc -n kube-system

kubectl exec busybox -n default -- nslookup kube-dns.kube-system

结果:

Server: 10.96.0.10

Address 1: 10.96.0.10 kube-dns.kube-system.svc.cluster.local

Name: kube-dns.kube-system

Address 1: 10.96.0.10 kube-dns.kube-system.svc.cluster.local

3、测试每个节点能否访问kubernetes svc的443端口 与kube-dns service的53端口

kubectl get svc 获取 cluster ip

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 24d

在每个节点执行

telnet 10.96.0.1 443

测试kube-dns的联通

kubectl get svc -n kube-system

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kube-dns ClusterIP 10.96.0.10 <none> 53/UDP,53/TCP,9153/TCP 21d

metrics-server ClusterIP 10.111.181.43 <none> 443/TCP 21d

在每个节点执行

telnet 10.96.0.10 53

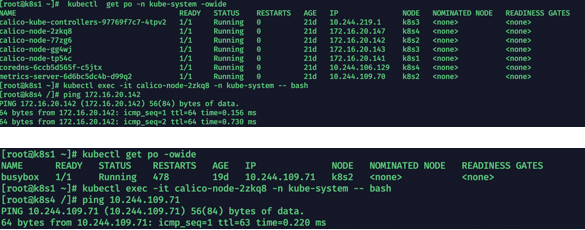

4、测试pod之间能否通信

kubectl get po -n kube-system -owide 获取pod

进入到calico-node的某台容器中

kubectl exec -it calico-node-2zkq8 -n kube-system -- bash

然后找一个其他节点的 calico-node pod的一个ip ping测试连通性

测试与busybox 测试容器的连通性

kubectl get po -owide

5、清除测试pod

kubectl delete po busybox

查看是否删除

kubectl get po

二、参数优化

2.1 容器配置参数优化

每台机器执行

cat > /etc/docker/daemon.json <<EOF

{

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "50m",

"max-file": "3"

},

"registry-mirrors": ["https://ufkb7xyg.mirror.aliyuncs.com"],

"max-concurrent-downloads": 10,

"max-concurrent-uploads": 5,

"live-restore": true

}

EOF

systemctl daemon-reload

systemctl restart docker

#删除状态是exited的容器

docker rm $(docker ps -q -f status=exited)

参数解析:

exec-opts:docker的CgroupDriver改成systemd

log-driver:日志格式

log-opts:日志存储大小与份数

registry-mirrors:镜像下载代理地址

max-concurrent-downloads:镜像下载启动的进程

max-concurrent-uploads:镜像上传启动的进程

live-restore:配置守护进程,让重启docker服务不重启容器

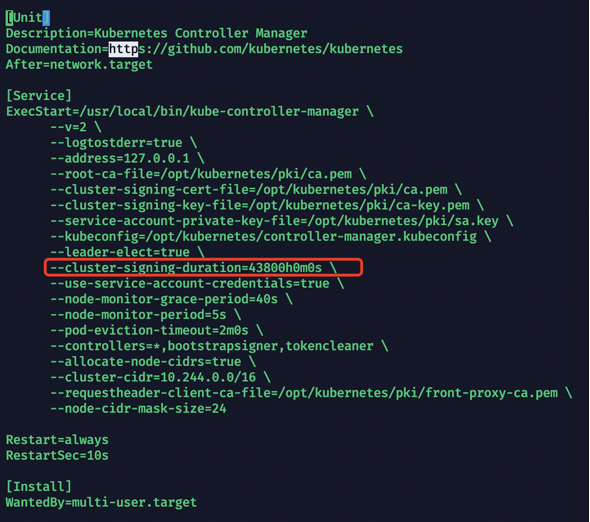

2.2 controller-manager配置参数优化

master节点配置

vim /usr/lib/systemd/system/kube-controller-manager.service

--cluster-signing-duration=43800h0m0s \

systemctl daemon-reload

systemctl restart kube-controller-manager

设置自动办法证书周期:

最大支持5年

--cluster-signing-duration

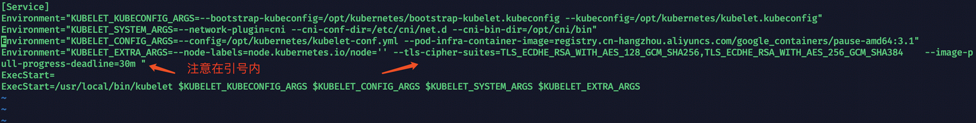

2.3 kubelet配置参数优化

每台机器执行

vim /etc/systemd/system/kubelet.service.d/10-kubelet.conf

Environment="KUBELET_EXTRA_ARGS=--node-labels=node.kubernetes.io/node='' --tls-cipher-suites=TLS_ECDHE_RSA_WITH_AES_128_GCM_SHA256,TLS_ECDHE_RSA_WITH_AES_256_GCM_SHA384 --image-pull-progress-deadline=30m "

解析

-tls-cipher-suites= 加密方式因为默认的加密方式不安全

--image-pull-progress-deadline 设置下载镜像的 deadline避免重复尝试

vim /opt/kubernetes/kubelet-conf.yml

rotateServerCertificates: true

allowedUnsafeSysctls:

- "net.core*"

- "net.ipv4.*"

kubeReserved:

cpu: "100m"

memory: 300Mi

ephemeral-storage: 10Gi

systemReserved:

cpu: "100m"

memory: 300Mi

ephemeral-storage: 10Gi

解析:

rotateServerCertificates 自动配置证书

allowedUnsafeSysctls 允许就该内核参数

kubeReserved 预留系统资源给k8s 根据机器资源分配

systemReserved

systemctl daemon-reload

systemctl restart kubelet

2.4 更改master节点的ROLES

设置所有master节点的角色

kubectl label node k8s1 node-role.kubernetes.io/master=""

三、设置coredns为自动扩容(可以不做)

1、资源配置文件

cat > dns-horizontal-autoscaler_v1.9.yaml << EOF

kind: ServiceAccount

apiVersion: v1

metadata:

name: kube-dns-autoscaler

namespace: kube-system

labels:

addonmanager.kubernetes.io/mode: Reconcile

---

kind: ClusterRole

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: system:kube-dns-autoscaler

labels:

addonmanager.kubernetes.io/mode: Reconcile

rules:

- apiGroups: [""]

resources: ["nodes"]

verbs: ["list", "watch"]

- apiGroups: [""]

resources: ["replicationcontrollers/scale"]

verbs: ["get", "update"]

- apiGroups: ["apps"]

resources: ["deployments/scale", "replicasets/scale"]

verbs: ["get", "update"]

# Remove the configmaps rule once below issue is fixed:

# kubernetes-incubator/cluster-proportional-autoscaler#16

- apiGroups: [""]

resources: ["configmaps"]

verbs: ["get", "create"]

---

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: system:kube-dns-autoscaler

labels:

addonmanager.kubernetes.io/mode: Reconcile

subjects:

- kind: ServiceAccount

name: kube-dns-autoscaler

namespace: kube-system

roleRef:

kind: ClusterRole

name: system:kube-dns-autoscaler

apiGroup: rbac.authorization.k8s.io

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: kube-dns-autoscaler

namespace: kube-system

labels:

k8s-app: kube-dns-autoscaler

kubernetes.io/cluster-service: "true"

addonmanager.kubernetes.io/mode: Reconcile

spec:

selector:

matchLabels:

k8s-app: kube-dns-autoscaler

template:

metadata:

labels:

k8s-app: kube-dns-autoscaler

annotations:

seccomp.security.alpha.kubernetes.io/pod: 'docker/default'

spec:

priorityClassName: system-cluster-critical

securityContext:

supplementalGroups: [ 65534 ]

fsGroup: 65534

nodeSelector:

kubernetes.io/os: linux

containers:

- name: autoscaler

image: registry.cn-beijing.aliyuncs.com/yuan-k8s/cluster-proportional-autoscaler-amd64:1.8.1

resources:

requests:

cpu: "20m"

memory: "10Mi"

command:

- /cluster-proportional-autoscaler

- --namespace=kube-system

- --configmap=kube-dns-autoscaler

- --target=deployment/coredns

- --default-params={"linear":{"coresPerReplica":16,"nodesPerReplica":4,"min":2,"max":4,"preventSinglePointFailure":true,"includeUnschedulableNodes":true}}

- --logtostderr=true

- --v=2

tolerations:

- key: "CriticalAddonsOnly"

operator: "Exists"

serviceAccountName: kube-dns-autoscaler

EOF

2、解析

-default-params中的参数

min:coredns最小数

max:coredns最打数

coresPerReplica:集群CPU核心数

nodesPerReplica:集群节点数

preventSinglePointFailure:设置为 时true,如果有多个节点,控制器确保至少有 2 个副本

includeUnschedulableNodes被设定为true,副本将刻度基于节点的总数。否则副本将仅根据可调度节点的数量进行扩展

注意:

- --target= 这里与kube-dns.yaml中定义的name一致

如果报错没有ConfigMap则创建下面的资源

cat > dns-autoscaler-ConfigMap.yaml << EOF

kind: ConfigMap

apiVersion: v1

metadata:

name: dns-autoscaler

namespace: kube-system

data:

linear: |-

{

"coresPerReplica": 16,

"nodesPerReplica": 4,

"min": 2,

"preventSinglePointFailure": true

}

EOF

3、创建

dns-horizontal-autoscaler_v1.9.yaml

4、查看

kubectl get po -n kube-system

三、k8s集群可用性验证与调参(第一章、k8s高可用集群安装)的更多相关文章

- kubernetes教程第一章-kubeadm高可用安装k8s集群

目录 Kubeadm高可用安装k8s集群 kubeadm高可用安装1.18基本说明 k8s高可用架构解析 kubeadm基本环境配置 kubeadm基本组件安装 kubeadm集群初始化 高可用Mas ...

- Linux centosVMware 集群介绍、keepalived介绍、用keepalived配置高可用集群

一.集群介绍 根据功能划分为两大类:高可用和负载均衡 高可用集群通常为两台服务器,一台工作,另外一台作为冗余,当提供服务的机器宕机,冗余将接替继续提供服务 实现高可用的开源软件有:heartbeat. ...

- Corosync+Pacemaker+crmsh构建Web高可用集群

一.概述: 1.1 AIS和OpenAIS简介 AIS应用接口规范,是用来定义应用程序接口(API)的开放性规范的集合,这些应用程序作为中间件为应用服务提供一种开放.高移植性的程序接口.是在实现高可用 ...

- 配置drbd高可用集群

前期准备: 同步时间 (两个节点) 节点一(172.16.21.6) [root@stu21 heartbeat2]# ntpdate 172.16.0.1 31 Dec 20:59:25 ntpda ...

- spark高可用集群搭建及运行测试

文中的所有操作都是在之前的文章spark集群的搭建基础上建立的,重复操作已经简写: 之前的配置中使用了master01.slave01.slave02.slave03: 本篇文章还要添加master0 ...

- rancher1.6高可用集群搭建

rancher高可用集群搭建 一.搭建环境 1.安装系统 下载centos最新版, http://mirrors.sohu.com/centos/7/isos/x86_64/CentOS-7-x86_ ...

- Redis总结(五)缓存雪崩和缓存穿透等问题 Web API系列(三)统一异常处理 C#总结(一)AutoResetEvent的使用介绍(用AutoResetEvent实现同步) C#总结(二)事件Event 介绍总结 C#总结(三)DataGridView增加全选列 Web API系列(二)接口安全和参数校验 RabbitMQ学习系列(六): RabbitMQ 高可用集群

Redis总结(五)缓存雪崩和缓存穿透等问题 前面讲过一些redis 缓存的使用和数据持久化.感兴趣的朋友可以看看之前的文章,http://www.cnblogs.com/zhangweizhon ...

- .Net Core2.1 秒杀项目一步步实现CI/CD(Centos7.2)系列一:k8s高可用集群搭建总结以及部署API到k8s

前言:本系列博客又更新了,是博主研究很长时间,亲自动手实践过后的心得,k8s集群是购买了5台阿里云服务器部署的,这个集群差不多搞了一周时间,关于k8s的知识点,我也是刚入门,这方面的知识建议参考博客园 ...

- Kubeadm 1.9 HA 高可用集群本地离线镜像部署【已验证】

k8s介绍 k8s 发展速度很快,目前很多大的公司容器集群都基于该项目,如京东,腾讯,滴滴,瓜子二手车,易宝支付,北森等等. kubernetes1.9版本发布2017年12月15日,每三个月一个迭代 ...

随机推荐

- EyeQ进展The Evolution of EyeQ

EyeQ进展The Evolution of EyeQ Mobileye's proven leadership in ADAS technologies is based in our EyeQ f ...

- ICCV2019论文点评:3D Object Detect疏密度点云三维目标检测

ICCV2019论文点评:3D Object Detect疏密度点云三维目标检测 STD: Sparse-to-Dense 3D Object Detector for Point Cloud 论文链 ...

- 菜鸟刷题路:剑指 Offer 05. 替换空格

剑指 Offer 05. 替换空格 class Solution { public String replaceSpace(String s) { StringBuilder str = new St ...

- springboot——重定向解决刷新浏览器造成表单重复提交的问题(超详细)

原因:造成表单重复提交的原因是当我们刷新浏览器的时候,浏览器会发送上一次提交的请求.由于上一次提交的请求方式为post,刷新浏览器就会重新发送这个post请求,造成表单重复提交. 解决办法: 将请求当 ...

- P2782 友好城市(最长不下降子序列)

题目描述 有一条横贯东西的大河,河有笔直的南北两岸,岸上各有位置各不相同的$N$个城市.北岸的每个城市有且仅有一个友好城市在南岸,而且不同城市的友好城市不相同.每对友好城市都向政府申请在河上开辟一条直 ...

- python赋值,深拷贝和浅拷贝的区别

1.赋值 list1=[[1,2],'fei',66] list2=list1 list1 [[1, 2], 'fei', 66] list2 [[1, 2], 'fei', 66] list2.ap ...

- UF_VEC 向量相关

Open C UF_VEC2_addUF_VEC2_affine_combUF_VEC2_ask_perpendicularUF_VEC2_componentsUF_VEC2_convex_combU ...

- 6.17考试总结(NOIP模拟8)[星际旅行·砍树·超级树·求和]

6.17考试总结(NOIP模拟8) 背景 考得不咋样,有一个非常遗憾的地方:最后一题少取膜了,\(100pts->40pts\),改了这么多年的错还是头一回看见以下的情景... T1星际旅行 前 ...

- gRPC趁现在还没大火,抢先了解一下

前言 系统分布式已经成为程序员的家常,将大型单体划分为相对简单的小模块,分散系统能力,提升系统扩展性.功能模块复用性等:各功能模块之间肯定会有很多数据共享和交互的应用场景,那就避免不了各模块之间的通信 ...

- 通过AI识图判断图片是否为小票

先在百度智能云中创建一个应用加入以下标记功能(没有智能云账号可以去创建一个,创建应用也都是些基本操作) 本次只用到标记的功能. 此功能在图像识别下面. 创建应用后,页面会出现平台分配的密钥:API K ...