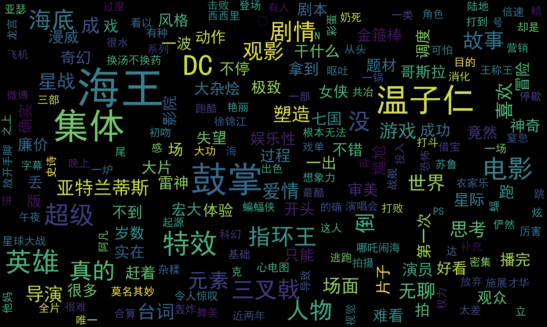

scrapy-redis爬取豆瓣电影短评,使用词云wordcloud展示

1、数据是使用scrapy-redis爬取的,存放在redis里面,爬取的是最近大热电影《海王》

2、使用了jieba中文分词解析库

3、使用了停用词stopwords,过滤掉一些无意义的词

4、使用matplotlib+wordcloud绘图展示

from redis import Redis

import json

import jieba

from wordcloud import WordCloud

import matplotlib.pyplot as plt

# 加载停用词

# stopwords = set(map(lambda x: x.rstrip('\n'), open('chineseStopWords.txt').readlines()))

stopwords = set()

with open('chineseStopWords.txt') as f:

for line in f.readlines():

stopwords.add(line.rstrip('\n'))

stopwords.add(' ')

# print(stopwords)

# print(len(stopwords))

# 读取影评

db = Redis(host='localhost')

items = db.lrange('review:items', 0, -1)

# print(items)

# print(len(items))

# 统计每个word出现的次数

# 过滤掉停用词

# 记录总数,用于计算词频

words = {}

total = 0

for item in items:

data = json.loads(item)['review']

# print(data)

# print('------------')

for word in jieba.cut(data):

if word not in stopwords:

words[word] = words.get(word, 0) + 1

total += 1

print(sorted(words.items(), key=lambda x: x[1], reverse=True))

# print(len(words))

# print(total)

# 词频

freq = {k: v / total for k, v in words.items()}

print(sorted(freq.items(), key=lambda x: x[1], reverse=True))

# 词云

wordcloud = WordCloud(font_path='simhei.ttf',

width=500,

height=300,

scale=10,

max_words=200,

max_font_size=40).fit_words(frequencies=freq) # Create a word_cloud from words and frequencies

plt.imshow(wordcloud, interpolation="bilinear")

plt.axis('off')

plt.show()

绘图结果:

参考:

https://github.com/amueller/word_cloud

http://amueller.github.io/word_cloud/

scrapy-redis爬取豆瓣电影短评,使用词云wordcloud展示的更多相关文章

- Scrapy实战篇(三)之爬取豆瓣电影短评

今天的主要内容是爬取豆瓣电影短评,看一下网友是怎么评价最近的电影的,方便我们以后的分析,以以下三部电影:二十二,战狼,三生三世十里桃花为例. 由于豆瓣短评网页比较简单,且不存在动态加载的内容,我们下面 ...

- python 爬取豆瓣电影短评并wordcloud生成词云图

最近学到数据可视化到了词云图,正好学到爬虫,各种爬网站 [实验名称] 爬取豆瓣电影<千与千寻>的评论并生成词云 1. 利用爬虫获得电影评论的文本数据 2. 处理文本数据生成词云图 第一步, ...

- 基于python的scrapy框架爬取豆瓣电影及其可视化

1.Scrapy框架介绍 主要介绍,spiders,engine,scheduler,downloader,Item pipeline scrapy常见命令如下: 对应在scrapy文件中有,自己增加 ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250

scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250 前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大 ...

- scrapy爬取豆瓣电影top250

# -*- coding: utf-8 -*- # scrapy爬取豆瓣电影top250 import scrapy from douban.items import DoubanItem class ...

- Scrapy中用xpath/css爬取豆瓣电影Top250:解决403HTTP status code is not handled or not allowed

好吧,我又开始折腾豆瓣电影top250了,只是想试试各种方法,看看哪一种的方法效率是最好的,一直进行到这一步才知道 scrapy的强大,尤其是和selector结合之后,速度飞起.... 下面我就采用 ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影

前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大家讲解一个完整爬虫的流程. 工具和环境 语言:python 2 ...

- urllib+BeautifulSoup无登录模式爬取豆瓣电影Top250

对于简单的爬虫任务,尤其对于初学者,urllib+BeautifulSoup足以满足大部分的任务. 1.urllib是Python3自带的库,不需要安装,但是BeautifulSoup却是需要安装的. ...

- 爬取豆瓣电影TOP 250的电影存储到mongodb中

爬取豆瓣电影TOP 250的电影存储到mongodb中 1.创建项目sp1 PS D:\scrapy> scrapy.exe startproject douban 2.创建一个爬虫 PS D: ...

随机推荐

- 线程中join()的用法

Thread中,join()方法的作用是调用线程等待该线程完成后,才能继续用下运行. public static void main(String[] args) throws Interrupted ...

- Duplicate entry * for key *

一.问题 插入数据时报错 Duplicate entry * for key * 二.分析 建表语句 CREATE TABLE `t_product_result_config` ( `id` var ...

- Bash 笔记

获取当前工作目录 basepath=$(cd `dirname $0`; pwd) 源文 : https://sexywp.com/bash-how-to-get-the-basepath-of-cu ...

- Linux下selinux简单梳理

在linux环境下执行某些程序时,偶尔会遇到来一个关于selinux的强制模式不可执行的情况,这种情况下需要关闭selinux或者将enforcing改为permissive模式后才能进行执行.sel ...

- Spring RPC 入门学习(3)-获取Student对象

Spring RPC传递对象. 1. 新建RPC接口:StudentInterface.java package com.cvicse.ump.rpc.interfaceDefine; import ...

- 研究C语言的新型编译环境TCC

C语言综合研究1 搭建一个tcc环境 研究过程: 问题引出:为什么要使用tcc环境,甚至连图形界面都没有,为什么要使用这样的化境? 按照我们学习的本质来讲,可能是为了体验C语言底层的相关特性,但是在研 ...

- chrome启用flash不询问

69版本之后 打开 chrome://flags/#enable-ephemeral-flash-permission 把它从Default改为Disabled 重新打开Chrome,进入 chrom ...

- PAT 1019 数字黑洞

https://pintia.cn/problem-sets/994805260223102976/problems/994805302786899968 给定任一个各位数字不完全相同的4位正整数,如 ...

- Activiti解析.bpmn文件获得User Task节点的CandidateUsers特性的值

参考文档: http://www.cnblogs.com/mingforyou/p/5351332.html http://blog.csdn.net/jackyrongvip/article/det ...

- Using Android Phone to recover SD card formatted with DD command under linux

Using Android Phone to recover SD card formatted with DD command under linux 1. Formatted a sd card ...