jieba分词学习

具体项目在githut里面:

应用jieba库分词

1)利用jieba分词来统计词频:

对应文本为我们队伍的介绍:jianjie.txt:

项目名称:碎片

项目描述:制作一个网站,拾起日常碎片,记录生活点滴!

项目成员:孔潭活、何德新、吴淑瑶、苏咏梅

成员风采:

孔潭活:2015034643032

何德新:

学号:2015034643017

风格:咸鱼王

擅长技术:设计

编程兴趣:机器学习、人工智能。希望的软工角色:项目经理。

一句话宣言:持而盈之,不如其已。揣而锐之,不可常保。道可道非常道;名可名非常名

吴淑谣:

学号:2015034643018

风格:细水长流

擅长技术:无,对C++比较熟悉

编程兴趣:对数据进行处理和分析

希望的软工角色:代码能力比较薄弱,希望负责技术含量不是很高的模块

一句话宣言:推陈出新,永无止境。

苏咏梅:

学号:2015034643025

风格:越挫越勇

擅长技术:没有比较擅长的,对MySQL与Java感兴趣

希望的软工角色:需求分析员

一句话宣言:要成功,先发疯,头脑简单向前冲

课程目标

一个小而美记录生活碎片的网站

代码:

import jieba

import jieba.analyse

import xlwt #写入Excel表的库

if name == "main":

wbk = xlwt.Workbook(encoding='ascii')

sheet = wbk.add_sheet("wordCount") # Excel单元格名字

word_lst = []

key_list = []

for line in open('jianjie.txt'): # jianjie.txt是需要分词统计的文档

item = line.strip('\n\r').split('\t') # 制表格切分

# print item

tags = jieba.analyse.extract_tags(item[0]) # jieba分词

for t in tags:

word_lst.append(t)

word_dict = {}

with open("wordCount.txt", 'w') as wf2: # 打开文件

for item in word_lst:

if item not in word_dict: # 统计数量

word_dict[item] = 1

else:

word_dict[item] += 1

for item in word_lst:

if word_dict[item]==1:

del word_dict[item]

orderList = list(word_dict.values())

orderList.sort(reverse=True)

# print orderList

for i in range(len(orderList)):

for key in word_dict:

if word_dict[key] == orderList[i]:

wf2.write(key + ' ' + str(word_dict[key]) + '\n') # 写入txt文档

key_list.append(key)

word_dict[key] = 0

for i in range(len(key_list)):

sheet.write(i, 1, label=orderList[i])

sheet.write(i, 0, label=key_list[i])

wbk.save('wordCount.xls') # 保存为 wordCount.xls文件

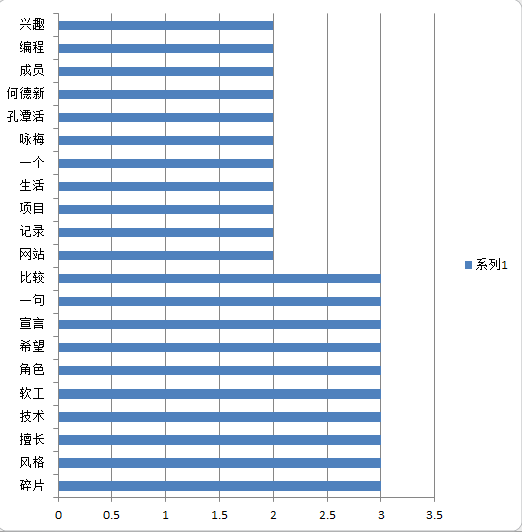

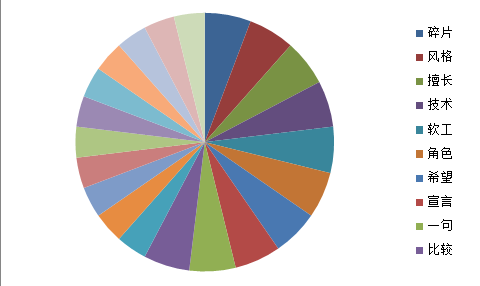

2)统计的词频会输出两个文件一个是txt文件另外一个是xls文件名字都是wordCount

我们利用excel来绘图

jieba分词学习的更多相关文章

- Lucene.net(4.8.0) 学习问题记录五: JIEba分词和Lucene的结合,以及对分词器的思考

前言:目前自己在做使用Lucene.net和PanGu分词实现全文检索的工作,不过自己是把别人做好的项目进行迁移.因为项目整体要迁移到ASP.NET Core 2.0版本,而Lucene使用的版本是3 ...

- jieba分词(2)

结巴分词系统中实现了两种关键词抽取法,一种是TF-IDF关键词抽取算法另一种是TextRank关键词抽取算法,它们都是无监督的算法. 以下是两种算法的使用: #-*- coding:utf-8 -*- ...

- jieba分词原理-DAG(NO HMM)

最近公司在做一个推荐系统,让我给论坛上的帖子找关键字,当时给我说让我用jieba分词,我周末回去看了看,感觉不错,还学习了一下具体的原理 首先,通过正则表达式,将文章内容切分,形成一个句子数组,这个比 ...

- jieba分词流程及部分源码解读(一)

首先我们来看一下jieba分词的流程图: 结巴中文分词简介 1)支持三种分词模式: 精确模式:将句子最精确的分开,适合文本分析 全模式:句子中所有可以成词的词语都扫描出来,速度快,不能解决歧义 搜索引 ...

- 自然语言处理课程(二):Jieba分词的原理及实例操作

上节课,我们学习了自然语言处理课程(一):自然语言处理在网文改编市场的应用,了解了相关的基础理论.接下来,我们将要了解一些具体的.可操作的技术方法. 作为小说爱好者的你,是否有设想过通过一些计算机工具 ...

- jieba分词-强大的Python 中文分词库

1. jieba的江湖地位 NLP(自然语言)领域现在可谓是群雄纷争,各种开源组件层出不穷,其中一支不可忽视的力量便是jieba分词,号称要做最好的 Python 中文分词组件. 很多人学习pytho ...

- python使用matplotlib画图,jieba分词、词云、selenuium、图片、音频、视频、文字识别、人脸识别

一.使用matplotlib画图 关注公众号"轻松学编程"了解更多. 使用matplotlib画柱形图 import matplotlib from matplotlib impo ...

- widows下jieba分词的安装

在切词的时候使用到jieba分词器,安装如下: 切入到结巴包,执行 python setup.py install 安装后,可以直接在代码中引用: import jieba

- 【原】关于使用jieba分词+PyInstaller进行打包时出现的一些问题的解决方法

错误现象: 最近在做一个小项目,在Python中使用了jieba分词,感觉非常简洁方便.在Python端进行调试的时候没有任何问题,使用PyInstaller打包成exe文件后,就会报错: 错误原因分 ...

随机推荐

- 【高德地图API】从零開始学高德JS API(四)搜索服务——POI搜索|自己主动完毕|输入提示|行政区域|交叉路口|自有数据检索

地图服务.大家能想到哪些?POI搜素,输入提示,地址解析,公交导航,驾车导航,步行导航,道路查询(交叉口),行政区划等等.假设说覆盖物Marker是地图的骨骼,那么服务,就是地图的气血. 有个各种各样 ...

- 异常处理(try...catch...final 和 throw , throws)

1.传统(弱语言)处理异常方式 原理:利用判断来控制异常出现 publicclass Test01 { publicstaticvoid main(String[] args) { Scanner s ...

- Linux设置口令复杂度和口令定期更换策略

Linux 密码复杂度设置pam_pwquality.pam_passwdqc(centos7) 1.Linux对应的密码策略模块有:pam_passwdqc 和 pam_pwquality . 其中 ...

- Android开发-各种各样好看漂亮的进度条,指示器,加载提示汇总

导读:之前项目中用到一些进度条,找了不少,打算写个demo自己总结一下,留着以后用, 有些是自己写的,有些是github上找的别人的库,如果大家觉得好看可以用,直接下载复制代码到项目里就可以用,ok ...

- Kubernetes1.91(K8s)安装部署过程(七)--coredns安装

为了是集群内的服务能使用dns进行服务解析,集群内需要使用dns服务器,可以按照kube官方dns,即kubedns或者其他的dns,比如coredns, 本例中按照的为coredns,按照简单,编辑 ...

- 爬虫代理squid

yum -y install squid 配置文件一般是在/etc/squid3/下的squid.conf文件 pyspider使用的时候只需要设置代理服务器为你配置好的服务器的IP就可以了 clas ...

- WorldWind源码剖析系列:经纬度格网类LatLongGrid

经纬度格网类LatLongGrid继承自可渲染对象类RenderableObject,是WorldWind中用来在星球外表绘制经纬度格网的封装类.其类图如下所示. 绘制经纬网格的主体函数为Render ...

- WorldWind源码剖析系列:外包围盒类BoundingBox和外包围球类BoundingSphere

PluginSDK中的外包围盒.外包围球分别用类 BoundingBox和BoundingSphere描述,其类图如下所示. 外包围盒BoundingBox类的corners字段用来存储外包围盒的8个 ...

- FreeBSD 12.0 版发布

FreeBSD 是一个自由且开源的类 Unix 操作系统,是 BSD Unix 的直系继承者.起始于 1993 年,FreeBSD 拥有悠久的历史与诸多衍生版本.其饱经考验,是最广泛应用的开源 BSD ...

- 何谓BLDC电机?BLDC电机是如何旋转的?

何谓BLDC电机?BLDC电机是如何旋转的?