Coursera台大机器学习技法课程笔记11-Gradient Boosted Decision Tree

将Adaboost和decision tree相结合,需要注意的地主是,训练时adaboost需要改变资料的权重,如何将有权重的资

料和decision tree相结合呢?方法很类似于前面讲过的bagging,通过采样资料来使资料获得不同的权重。

一棵完全的树的权值会无限大,可能出现过拟合。因此需要得到一棵弱分类的树,方法如下:

接下来比较深入的分析adaboost。经过代换,出现了如下惊人的结果: 某个资料的权重正比于投票分数

联系到之前学习的SVM,发现了一个秘密:投票的分数就是某个点到分隔线的距离(margin)。分数越高越好,就意味着u越小越好。在Adaboost过

程中,如果u的和越来越小,意味着margin越来越大,证明adaboost效果越好。

接下来这段没有听懂:大概是通过errADA作为上界,将zero-one做的更好。

下面是证明通过adaboost确实能做的更好。中间是一系列推导就不说了,直接上下图。这个推导是从另一方面解释Adaboost:为g赋权重的过程,实

际上就是优化的过程。

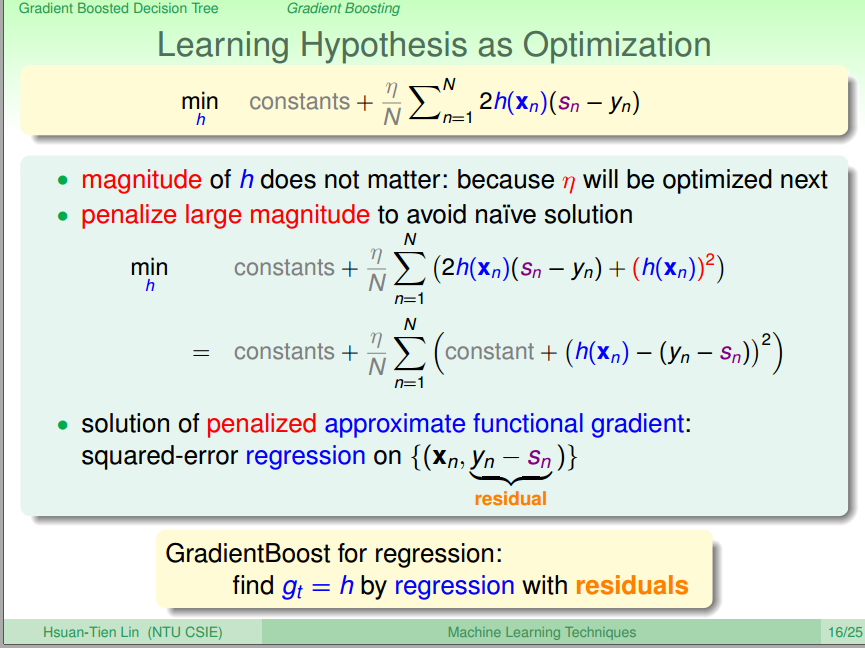

从上面可以看出,adaboost的过程,实际上就是选择最优的h,选择最优的步长n,不断对其进行优化的过程。将其推广到任意的err function,

任意的h,就得出了一种类似adaboost的方法:GradientBoost。

接下来将其用于regression,非常的理论。最后找到得到h的方法:对x,y-s做regression。

那么如何得到步长呢?最后得出如下形式:对余数和g做regression

最后是这个算法的过程:

下面是对aggregate的一个总结。对于blending(已经得到各种g)

对于learning(需要学习得到g并将其进行组合):

将这些模型进行糅合:

选择合适的aggregation模型:

这位博主对RF和GDBT进行了比较:http://blog.csdn.net/wh137795233/article/details/47750151

Coursera台大机器学习技法课程笔记11-Gradient Boosted Decision Tree的更多相关文章

- Coursera台大机器学习技法课程笔记01-linear hard SVM

极其淡腾的一学期终于过去了,暑假打算学下台大的这门机器学习技法. 第一课是对SVM的介绍,虽然之前也学过,但听了一次感觉还是很有收获的.这位博主总结了个大概,具体细节还是 要听课:http://www ...

- Coursera台大机器学习技法课程笔记10-Random forest

随机森林就是要将这我们之前学的两个算法进行结合:bagging能减少variance(通过g们投票),而decision tree的variance很大,资料不同,生成的树也不同. 为了得到不同的g, ...

- Coursera台大机器学习技法课程笔记14-Radial Basis Function Network

将Radial Basis Function与Network相结合.实际上衡量两个点的相似性:距离越近,值越大. 将神经元换为与距离有关的函数,就是RBF Network: 可以用kernel和RBF ...

- Coursera台大机器学习技法课程笔记03-Kernel Support Vector Machine

这一节讲的是核化的SVM,Andrew Ng的那篇讲义也讲过,讲的也不错. 首先讲的是kernel trick,为了简化将低维特征映射高维特征后的计算,使用了核技巧.讲义中还讲了核函数的判定,即什么样 ...

- Coursera台大机器学习技法课程笔记08-Adaptive Boosting

将分类器组合的过程中,将重点逐渐聚焦于那些被错分的样本点,这种做法背后的数学原因,就是这讲的内容. 在用bootstraping生成g的过程中,由于抽样对不同的g就生成了不同的u,接下来就是不断的调整 ...

- Coursera台大机器学习技法课程笔记04-Soft-Margin Support Vector Machine

之前的SVM非常的hard,要求每个点都要被正确的划分,这就有可能overfit,为此引入了Soft SVM,即允许存在被错分的点,将犯的错放在目 标函数中进行优化,非常类似于正则化. 将Soft S ...

- Coursera台大机器学习技法课程笔记02-Dual Support Vector Machine

这节课讲的是SVM的对偶问题,比较精彩的部分:为何要使用拉格朗日乘子以及如何进行对偶变换. 参考:http://www.cnblogs.com/bourneli/p/4199990.html http ...

- Coursera台大机器学习技法课程笔记07-Blending and Bagging

这一节讲如何将得到的feature或hypothesis组合起来用于预测. 1. 林老师给出了几种方法 在选择g时,需要选择一个很强的g来确保Eval最小,但如果每个g都很弱该怎么办呢 这个时候可以选 ...

- Coursera台大机器学习技法课程笔记05-Kernel Logistic Regression

这一节主要讲的是如何将Kernel trick 用到 logistic regression上. 从另一个角度来看soft-margin SVM,将其与 logistic regression进行对比 ...

随机推荐

- 基于 ARM的 Windows 10S 笔记本 转帖

首款骁龙笔记本华硕畅370评测:续航不俗 性能拖后腿 2018年06月21日 12:23 新浪数码 缩小字体放大字体收藏微博微信分享 相关阅读:国内首款骁龙本华硕畅370发布:6199元送一年无限 ...

- Ubuntu17安装Jenkins

Java安装 Jenkins基于Java, 所以需要先安装java. Linux下安装java只要配置java环境变量即可. 首先,解压java到相应目录,我一般习惯把安装的软件放到目录/usr/lo ...

- springsecurity实战

springsecurity是一种安全性框架,主要用于进行权限验证,下面是其基本使用方法: pom.xml <dependency> <groupId>org.springfr ...

- BZOJ2442 Usaco2011 Open修剪草坪(动态规划+单调队列)

显然可以dp.显然可以单调队列优化一下. #include<iostream> #include<cstdio> #include<cmath> #include& ...

- NOI&&NOIP知识点集萃

更新日志 \(update:2019-3-4\) 更新了自为风月马前卒的后缀数组(省选不到一个月了,我才开始学后缀数组怕是要凉凉) \(update:2019-2-21\) 更新了一篇李超线段树的讲解 ...

- IDEA中在目录中如何快速指定到当前的类

类似于myeclipse的 Link with Editor 其实也在IDEA的这个位置,跟狙击镜的图标一样,叫做Scroll from Source 不同的的是,IDEA的这个功能,需要手动点击,才 ...

- 新年的展望,2018 hello world~

虽然离$2017$到$2018$的跨年已经过去很久了,但还是想写点东西试图拯救一下最近有些颓势的自己~ $2017$对我来说是意义重大的一年,这一年里,我有欢笑也有泪水,有收获也有挫折,有坚强也有脆弱 ...

- Zookeeper可视化工具

zkui 简介 zkui它提供了一个管理界面,可以针对zookeepr的节点值进行CRUD操作,同时也提供了安全认证. 下载安装 项目地址 下载 $ git clone https://github. ...

- Sql数据库不能频繁连接

这个问题怎么说呢,我频繁的读一个json文件,所以就频繁的去连接了数据库.所以导致了数据库后来就不工作了(罢工?O(∩_∩)O哈哈~) 解决办法是加一个判断语句,如果是空的就连接,否则就别一直连接了. ...

- .net 里面打不出来ConfigurationManager

ConfigurationManager 这个东东是读取配置文件时需要的. 首先要引用命名空间里面 using System.Configuration; 其次呢,在解决方案的引用里,单机右键进行添加