jdbc调用sparksql on yarn

spark sql访问hive表

1.将hive-site.xml拷贝到spark目录下conf文件夹

2.(非必需)将mysql的jar包引入到spark的classpath,方式有如下两种:

方式1:需要在$SPARK_HOME/conf/spark-env.sh中的SPARK_CLASSPATH添加jdbc驱动的jar包

export SPARK_CLASSPATH=$SPARK_CLASSPATH:/usr/local/hive-1.2.1/lib/mysql-connector-java-5.1.31-bin.jar

方式2:在spark-sql命令中指定driver-class-path,如

local模式

spark-sql --driver-class-path /usr/local/hive-1.2.1/lib/mysql-connector-java-5.1.31-bin.jar

集群模式:

spark-sql --master yarn --driver-class-path /usr/local/hive-1.2.1/lib/mysql-connector-java-5.1.31-bin.jar

开启HiverServer2

默认模式为yarn-client,HiverServer作为一个yarn的应用运行,如图:

停止thriftserver

sbin/stop-thriftserver.sh

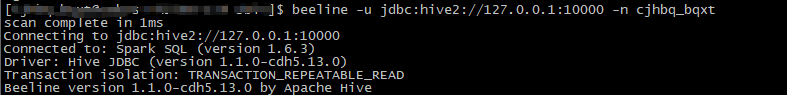

beeline客户端访问thrift server

通过-n指定sql以那个用户执行,下面两个ip是hadoop-master的内外网地址

beeline -u jdbc:hive2://10.9.2.100:10000 -n hive --hiveconf mapreduce.job.queuename=mxbs

beeline -u jdbc:hive2://122.23.368.32:10000 -n hive --hiveconf mapreduce.job.queuename=mxbs

java样例程序

import java.sql.*;

import java.util.HashSet;

import java.util.Set;

public class SimpleDemo1 {

private final static Set<String> HIVE_CONFIGS = initConfig();

/**

* hive conf设置

*

* @return

*/

private static Set<String> initConfig() {

Set<String> configs = new HashSet<String>();

configs.add("set mapreduce.job.queuename=queue1");

configs.add("set hive.cli.print.header=false");

return configs;

}

/**

* 临时去掉所有错误处理和资源关闭

* @param args

* @throws ClassNotFoundException

* @throws SQLException

*/

public static void main(String[] args) throws ClassNotFoundException, SQLException {

String jdbcdriver = "org.apache.hive.jdbc.HiveDriver";

String jdbcurl = "jdbc:hive2://127.0.0.1:10000";

String username = "user001";

String password = "";

Connection conn = null;

Statement statement = null;

Class.forName(jdbcdriver);

DriverManager.setLoginTimeout(20);

conn = DriverManager.getConnection(jdbcurl, username, password);

statement = conn.createStatement();

for (String config : HIVE_CONFIGS) {

statement.execute(config);

}

String sql = "select * from db1.test limit 10";

print(statement.executeQuery(sql));

}

}

maven引用:

<hadoop.version>2.6.0-cdh5.13.0</hadoop.version>

<hive-jdbc.version>1.1.0</hive-jdbc.version>

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-jdbc</artifactId>

<version>${hive-jdbc.version}</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>${hadoop.version}</version>

</dependency>

jdbc调用sparksql on yarn的更多相关文章

- jdbc调用sparksql

将hive-site.xml拷贝到spark目录下conf文件夹 local模式 spark-sql --driver-class-path /usr/local/hive-1.2.1/lib/mys ...

- Java数据库连接——JDBC调用存储过程,事务管理和高级应用

一.JDBC常用的API深入详解及存储过程的调用 相关链接:Jdbc调用存储过程 1.存储过程(Stored Procedure)的介绍 我们常用的操作数据库语言SQL语句在执行的时候需要先编译,然后 ...

- 使用 JDBC 调用函数 & 存储过程

/** * 如何使用 JDBC 调用存储在数据库中的函数或存储过程 */ @Test public void testCallableStatment() { Connection connectio ...

- shell脚本调用spark-sql

为了更方便的查询并产生报表, 需要使用shell脚本调用spark-sql spark/bin/spark-sql --master spark://host:7077 -f ${SQL_FILE} ...

- jdbc调用存储过程的方法

----------------------------jdbc调用存储过程的方法---------------------------------------------------private ...

- 使用JDBC调用数据库的存储过程

本篇讲述如何使用JDBC来调用MySQL数据库中的存储过程.建议在学习如何使用JDBC调用存储过程前,请先了解如何在数据库中使用存储过程. 存储过程是指在数据库系统中,一组为了完成特定功能的SQL语句 ...

- JDBC调用存储过程

一. JDBC调用存储过程 (1)使用存储过程SQL编写的程序代码,等一段语句和控制流语句.在创建时被编译成机器代码和存储在数据库中的client转让. 存储过程具有以下优势: 1.所生成的机器代码被 ...

- Java数据库连接--JDBC调用存储过程,事务管理和高级应用

相关链接:Jdbc调用存储过程 一.JDBC常用的API深入详解及存储过程的调用 1.存储过程的介绍 我们常用的操作数据库语言SQL语句在执行的时候要先进行编译,然后执行,而存储过程是在大型数据库系统 ...

- JDBC调用存储过程的例子

下面是我学到了Oracle存储过程,在这里跟大家简单的分享一下利用JDBC调用存储过程的例子: 废话就不啰嗦,现在就直接上机代码. 首先我利用的是Oracle中默认的 scott 数据库里的 emp员 ...

随机推荐

- vue.js 源代码学习笔记 ----- instance proxy

/* not type checking this file because flow doesn't play well with Proxy */ import config from 'core ...

- Git 配置ssh key的步骤

First start by setting up your own public/private key pair set. This can use either DSA or RSA, so b ...

- SpringMVC中的适配器

适配器模式(Adapter):将一个类的接口转换成客户希望的另外一个接口,Adapter模式使得原本由于接口不兼容而不能一起工作的那些类可以在一起工作 适用场景: 1.已经存在的类的接口不符合我们的需 ...

- Spring核心概念(二)

IOC/DI IOC(控制反转):对象(组件)的创建由代码中转移到外部容器(XML,注解) . DI(依赖注入):当类A需要使用类B时,那么我们需要为类A的属性赋值类B的对象. 这种现象我们称为依赖注 ...

- linux给一个文件夹开启权限

假如要给一个叫做xiaobang的文件夹权限,CD到这一级目录 chmod -R 777 xiaobang

- Goroutine是如何工作的?

翻译原文链接 转帖/转载请注明出处英文原文链接 发表于2014/02/24 Go语言 如果你刚刚接触Go语言,或者说你并不理解“并发不等于并行”这句话的含义,那么Rob Pike的讲座值得一看(在yo ...

- 【剑指offer】顺时针打印矩阵,C++实现

原创文章,转载请注明出处! 博客文章索引地址 1.题目 输入一个矩阵,按照从外向里以顺时针的顺序依次打印出每一个数字,例如,如果输入如下矩阵,则依次打印出数字1,2,3,4,8,12,16,15,14 ...

- 实战:向GitHub提交代码时触发Jenkins自动构建

当我们提交代码到GitHub后,可以在Jenkins上执行构建,但是每次都要动手去执行略显麻烦,今天我们就来实战Jenkins的自动构建功能,每次提交代码到GitHub后,Jenkins会进行自动构建 ...

- 使用PE工具箱 ughost 恢复系统导致被捆绑一堆软件的问题

很多的pe系统,都有这么一个东西, 没啥技术含量,就是给ghost 加一个UI 而已 , 但是使用这玩意恢复系统,会被感染一些捆绑软件 ,开机之后就会卡顿, 并下载一堆软件 包括 爱奇艺 , 百度搜 ...

- HDU1520 Anniversary party 树形DP基础

There is going to be a party to celebrate the 80-th Anniversary of the Ural State University. The Un ...