Flume线上日志采集【模板】

Flume线上日志采集【模板】

预装软件

Java

HDFS

Lzo/Lzop

系统版本

Flume 1.5.0-cdh5.4.0

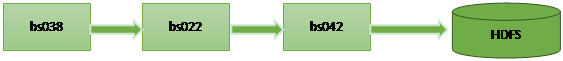

系统流程图

flume-env.sh配置文件

export JAVA_HOME=/usr/local/jdk1.7.0_55

export JAVA_OPTS="-Xms100m -Xmx2000m -Dcom.sun.management.jmxremote"

单机版写HDFS配置文件

[root@bs038 conf]# more flume_directHDFS.conf

#Define agent

agent1.channels=ch1

agent1.sources=avro-source1

agent1.sinks=log-sink1

#Defineamemorychannelcalledch1onagent1

agent1.channels.ch1.type=memory

agent1.channels.ch1.capacity=100000

agent1.channels.ch1.transactionCapacity=100000

agent1.channels.ch1.keep-alive=30

agent1.sources.avro-source1.interceptors = i1

agent1.sources.avro-source1.interceptors.i1.type = timestamp

#definesourcemonitorafile

agent1.sources.avro-source1.type=exec

agent1.sources.avro-source1.shell=/bin/bash -c

#agent1.sources.avro-source1.command=tail-n+0-F/home/storm/tmp/id.txt

agent1.sources.avro-source1.command=tail -F test.log

agent1.sources.avro-source1.channels=ch1

agent1.sources.avro-source1.threads=5

#Definealoggersinkthatsimplylogsalleventsitreceives

#andconnectittotheotherendofthesamechannel.

agent1.sinks.log-sink1.channel=ch1

agent1.sinks.log-sink1.type=hdfs

agent1.sinks.log-sink1.hdfs.path=/user/hadoop/cndns/flume/%Y%m%d%M

agent1.sinks.log-sink1.hdfs.writeFormat=Text

agent1.sinks.log-sink1.hdfs.filePrefix=cdns

agent1.sinks.log-sink1.hdfs.inUseSuffix=.tmp

#agent1.sinks.log-sink1.hdfs.fileType=DataStream

agent1.sinks.log-sink1.hdfs.fileType=CompressedStream

agent1.sinks.log-sink1.hdfs.codeC=lzop

agent1.sinks.log-sink1.hdfs.rollInterval=0

agent1.sinks.log-sink1.hdfs.rollSize=67108864

agent1.sinks.log-sink1.hdfs.rollCount=0

agent1.sinks.log-sink1.hdfs.batchSize=1000

agent1.sinks.log-sink1.hdfs.txnEventMax=1000

agent1.sinks.log-sink1.hdfs.callTimeout=60000

agent1.sinks.log-sink1.hdfs.appendTimeout=60000

终端配置文件

[root@bs038 conf]# more agent038.conf

agent1.sources = avro-source1

agent1.sinks = k1

agent1.channels = c1

agent1.sinks.k1.type = avro

agent1.sinks.k1.hostname = bs022.zx.nicx.cn

agent1.sinks.k1.port = 44444

#Defineamemorychannelcalledch1onagent1

agent1.channels.ch1.type=memory

agent1.channels.ch1.capacity=100000

agent1.channels.ch1.transactionCapacity=100000

agent1.channels.ch1.keep-alive=30

agent1.sources.avro-source1.interceptors = i1

agent1.sources.avro-source1.interceptors.i1.type = timestamp

agent1.sources.avro-source1.type=exec

agent1.sources.avro-source1.shell=/bin/bash -c

agent1.sources.avro-source1.command=tail -F test.log

agent1.sources.avro-source1.channels=ch1

agent1.sources.avro-source1.threads=5

agent1.channels.c1.type = file

agent1.channels.c1.checkpointDir = flume.checkpoint

agent1.channels.c1.dataDirs = flume.data

agent1.channels.c1.capacity = 200000000

agent1.channels.c1.keep-alive = 30

agent1.channels.c1.write-timeout = 30

agent1.channels.c1.checkpoint-timeout=600

agent1.sources.avro-source1.channels = c1

agent1.sinks.k1.channel = c1

中间传输流配置文件

agent2.sources = r2

agent2.sinks = k2

agent2.channels = c2

agent2.sources.r2.type = avro

agent2.sources.r2.bind = bs022.zx.nicx.cn

agent2.sources.r2.port = 44444

agent2.sinks.k2.type = avro

agent2.sinks.k2.hostname = bs042.zx.nicx.cn

agent2.sinks.k2.port = 55555

agent2.channels.c2.type = file

agent2.channels.c2.checkpointDir = flume.checkpoint

agent2.channels.c2.dataDirs = flume.data

agent2.channels.c2.capacity = 200000000

agent2.channels.c2.keep-alive = 30

agent2.channels.c2.write-timeout = 30

agent2.channels.c2.checkpoint-timeout=600

agent2.sources.r2.channels = c2

agent2.sinks.k2.channel = c2

写HDFS配置文件

[root@bs042 flume-ng-1.5.0-cdh5.4.0]# more conf/agent042.conf

#Define agent

agent1.channels=ch1

agent1.sources=avro-source1

agent1.sinks=log-sink1

#definesourcemonitorafile

agent1.sources.avro-source1.type = avro

agent1.sources.avro-source1.bind = bs042.zx.nicx.cn

agent1.sources.avro-source1.port = 55555

agent1.sources.avro-source1.interceptors = i1

agent1.sources.avro-source1.interceptors.i1.type = timestamp

#Definealoggersinkthatsimplylogsalleventsitreceives

#andconnectittotheotherendofthesamechannel.

agent1.sinks.log-sink1.channel=ch1

agent1.sinks.log-sink1.type=hdfs

agent1.sinks.log-sink1.hdfs.path=/user/hadoop/cndns/flume/%Y%m%d

agent1.sinks.log-sink1.hdfs.writeFormat=Text

agent1.sinks.log-sink1.hdfs.filePrefix=cdns

agent1.sinks.log-sink1.hdfs.inUseSuffix=.tmp

#agent1.sinks.log-sink1.hdfs.fileType=DataStream

agent1.sinks.log-sink1.hdfs.fileType=CompressedStream

agent1.sinks.log-sink1.hdfs.codeC=lzop

agent1.sinks.log-sink1.hdfs.rollInterval=0

agent1.sinks.log-sink1.hdfs.rollSize=67108864

agent1.sinks.log-sink1.hdfs.rollCount=0

agent1.sinks.log-sink1.hdfs.batchSize=1000

agent1.sinks.log-sink1.hdfs.txnEventMax=1000

agent1.sinks.log-sink1.hdfs.callTimeout=60000

agent1.sinks.log-sink1.hdfs.appendTimeout=60000

#Defineamemorychannelcalledch1onagent1

agent1.channels.ch1.type = file

agent1.channels.ch1.checkpointDir = flume.checkpoint

agent1.channels.ch1.dataDirs = flume.data

agent1.channels.ch1.capacity = 200000000

agent1.channels.ch1.keep-alive = 30

agent1.channels.ch1.write-timeout = 30

agent1.channels.ch1.checkpoint-timeout=600

agent1.sources.avro-source1.channels = ch1

agent1.sinks.log-sink1.channel = ch1

tail -F断点续传问题

tail -n +$(tail -n1 num) -F test.log 2>&1 | awk 'ARGIND==1{i=$0;next}{i++;if($0~/^tail/){i=0};print $0;print i >> "num";fflush("")}' num –

【注】

Flume线上日志采集【模板】的更多相关文章

- 研发流程 接口定义&开发&前后端联调 线上日志观察 模型变动

阿里等大厂的研发流程,进去前先了解一下_我们一起进大厂 - SegmentFault 思否 https://segmentfault.com/a/1190000021831640 接口定义 测试用例评 ...

- Nodejs线上日志部署

Nodejs 被越来越多的使用到线上系统中,但线上系统没有日志怎么行呢. 一.forever记录日志 我的线上系统使用forever来启动服务,最开始就直接使用了forever来记录 forever ...

- 线上日志集中化可视化管理:ELK

本文来自网易云社区 作者:王贝 为什么推荐ELK: 当线上服务器出了问题,我们要做的最重要的事情是什么?当需要实时监控跟踪服务器的健康情况,我们又要拿什么去分析?大家一定会说,去看日志,去分析日志.是 ...

- 从线上日志统计接口访问量QPS

这一阵子在面试,连续遇到好几家(大小厂都有)问我的项目线上qps的情况了,说实话,我作为一个大头兵,本来没关注过这个数据,只能含混地给个"大概.也许"的回答. 回来之后,我决定对业 ...

- 查看线上日志利器less

less实用命令 搜索 很多关于命令的解释有点令人困惑,因为前字,forward是向前,before也是前面. 上表示backward 下表示forward 向下搜索 / - 使用一个模式进行搜索,并 ...

- 记一次ArrayList产生的线上OOM问题

前言:本以为(OutOfMemoryError)OOM问题会离我们很远,但在一次生产上线灰度的过程中就出现了Java.Lang.OutOfMemoryError:Java heap space异常,通 ...

- Java架构师线上问题排查,这些命令程序员一定用得到!

Java架构师线上问题排查,这些命令程序员一定用得到! 线上问题排查,以下场景,你遇到过吗? 一.了解机器连接数情况 问题:1.2.3.4的sshd的监听端口是22,如何统计1.2.3.4的sshd服 ...

- 原创 记录一次线上Mysql慢查询问题排查过程

背景 前段时间收到运维反馈,线上Mysql数据库凌晨时候出现慢查询的报警,并把原始sql发了过来: --去除了业务含义的sql update test_user set a=1 where id=1; ...

- 基于Flume+LOG4J+Kafka的日志采集架构方案

本文将会介绍如何使用 Flume.log4j.Kafka进行规范的日志采集. Flume 基本概念 Flume是一个完善.强大的日志采集工具,关于它的配置,在网上有很多现成的例子和资料,这里仅做简单说 ...

随机推荐

- pacific-atlantic-water-flow(不错)

https://leetcode.com/problems/pacific-atlantic-water-flow/ // 其实,这道题目可以参考前面的那道:Trapping Rain Water I ...

- 设备树(Device Tree)

设备树介绍: 设备树是一个描述设备硬件资源的文件,该文件是由节点组成的树形结构.如下: / { node1 { a-string-property = "A string"; a- ...

- .NET 代码注入 CodeInject

CInject (or CodeInject) 允许直接往托管的代码中注入代码,而无需反编译.可在单个或者多个方法中注入你要执行的代码.使用 CInject 时你无需了解目标应用的细节,你通过注入来轻 ...

- Virtualbox中Linux添加新磁盘并创建分区

原文:https://www.linuxidc.com/Linux/2017-01/139616.htm ----------------------------------------------- ...

- 【React】初识React

React是什么 React是如今(2015年)最热门的前端技术. 在React中.一切皆组件. A JavaScript library for building user interfaces R ...

- linux CentOS6.5 yum安装mysql 5.6(转载&删改)

按:下面文章经过我一路测试没有问题,是篇好文,在此感谢作者 别踩我袈裟 .另因原文有些啰嗦,我自己有所删改,并尾后增加了一大段. 出处:https://www.cnblogs.com/renjido ...

- [置顶] 深入浅出Spring(四) Spring实例分析

上次的博文中 深入浅出Spring(二) IoC详解 和 深入浅出Spring(三) AOP详解中,我们分别介绍了一下Spring框架的两个核心一个是IoC,一个是AOP.接下来我们来做一个Sprin ...

- 算法笔记_137:二分图的最大匹配(Java)

目录 1 问题描述 2 解决方案 1 问题描述 何为二分图的最大匹配问题? 引用自百度百科: 首先得说明一下何为匹配: 给定一个二分图G,在G的一个子图M中,M的边集{E}中的任意两条边都不依附于 ...

- OpenERP7.0中非admin帐号新增其它用户问题

在OpenERP7.0中,通过admin新增了一个管理员帐号,然后登录管理员帐号,再新增其它用户时提示错误,系统提示对users没有create权限. 经测试了解,是因为安装了多公司模块后,在记录规则 ...

- 查看sqlserver 2008中性能低下的语句

经常使用这个语句来查看性能低下的sql语句: SELECT creation_time N'语句编译时间' ,last_execution_time N'上次执行时间' ,total_physical ...