hadoop2.2使用手册2:如何运行自带wordcount

问题导读:

1.hadoop2.x自带wordcount在什么位置?

2.运行wordcount程序,需要做哪些准备?

hadoop2.X使用手册1:通过web端口查看主节点、slave1节点及集群运行状态

基础上对hadoop2.2的进一步认识。这里交给大家如何运行hadoop2.2自带例子

1.找到examples例子

我们需要找打这个例子的位置:首先需要找到你的hadoop文件夹,然后依照下面路径:

/hadoop/share/hadoop/mapreduce会看到如下图:

- hadoop-mapreduce-examples-2.2.0.jar

复制代码

<ignore_js_op>

第二步:

我们需要需要做一下运行需要的工作,比如输入输出路径,上传什么文件等。

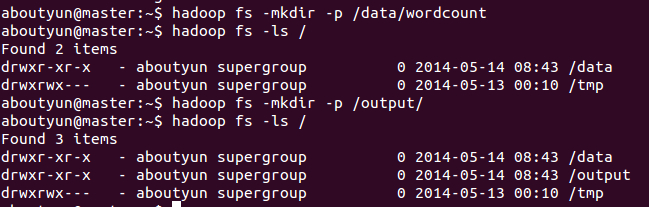

1.先在HDFS创建几个数据目录:

- hadoop fs -mkdir -p /data/wordcount

- hadoop fs -mkdir -p /output/

复制代码

<ignore_js_op>

2.目录/data/wordcount用来存放Hadoop自带的WordCount例子的数据文件,运行这个MapReduce任务的结果输出到/output/wordcount目录中。

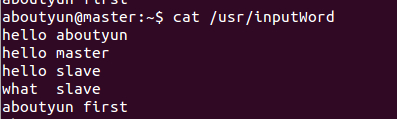

首先新建文件inputWord:

- vi /usr/inputWord

复制代码

新建完毕,查看内容:

- cat /usr/inputWord

复制代码

<ignore_js_op>

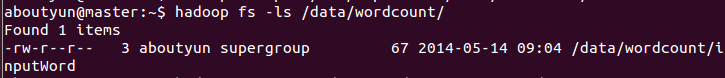

将本地文件上传到HDFS中:

- hadoop fs -put /usr/inputWord /data/wordcount/

复制代码

可以查看上传后的文件情况,执行如下命令:

- hadoop fs -ls /data/wordcount

复制代码

可以看到上传到HDFS中的文件。

<ignore_js_op>

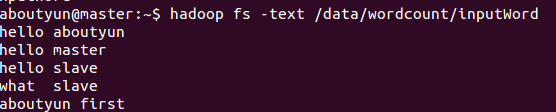

通过命令

- hadoop fs -text /data/wordcount/inputWord

复制代码

看到如下内容:

<ignore_js_op>

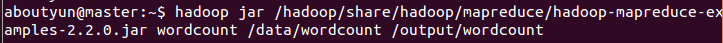

下面,运行WordCount例子,执行如下命令:

- hadoop jar /usr/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.2.0.jar wordcount /data/wordcount /output/wordcount

复制代码

<ignore_js_op>

可以看到控制台输出程序运行的信息:

aboutyun@master:~$ hadoop jar /usr/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.2.0.jar wordcount /data/wordcount /output/wordcount

14/05/14 10:33:33 INFO client.RMProxy: Connecting to ResourceManager at master/172.16.77.15:8032

14/05/14 10:33:34 INFO input.FileInputFormat: Total input paths to process : 1

14/05/14 10:33:34 INFO mapreduce.JobSubmitter: number of splits:1

14/05/14 10:33:34 INFO Configuration.deprecation: user.name is deprecated. Instead, use mapreduce.job.user.name

14/05/14 10:33:34 INFO Configuration.deprecation: mapred.jar is deprecated. Instead, use mapreduce.job.jar

14/05/14 10:33:34 INFO Configuration.deprecation: mapred.output.value.class is deprecated. Instead, use mapreduce.job.output.value.class

14/05/14 10:33:34 INFO Configuration.deprecation: mapreduce.combine.class is deprecated. Instead, use mapreduce.job.combine.class

14/05/14 10:33:34 INFO Configuration.deprecation: mapreduce.map.class is deprecated. Instead, use mapreduce.job.map.class

14/05/14 10:33:34 INFO Configuration.deprecation: mapred.job.name is deprecated. Instead, use mapreduce.job.name

14/05/14 10:33:34 INFO Configuration.deprecation: mapreduce.reduce.class is deprecated. Instead, use mapreduce.job.reduce.class

14/05/14 10:33:34 INFO Configuration.deprecation: mapred.input.dir is deprecated. Instead, use mapreduce.input.fileinputformat.inputdir

14/05/14 10:33:34 INFO Configuration.deprecation: mapred.output.dir is deprecated. Instead, use mapreduce.output.fileoutputformat.outputdir

14/05/14 10:33:34 INFO Configuration.deprecation: mapred.map.tasks is deprecated. Instead, use mapreduce.job.maps

14/05/14 10:33:34 INFO Configuration.deprecation: mapred.output.key.class is deprecated. Instead, use mapreduce.job.output.key.class

14/05/14 10:33:34 INFO Configuration.deprecation: mapred.working.dir is deprecated. Instead, use mapreduce.job.working.dir

14/05/14 10:33:35 INFO mapreduce.JobSubmitter: Submitting tokens for job: job_1400084979891_0004

14/05/14 10:33:36 INFO impl.YarnClientImpl: Submitted application application_1400084979891_0004 to ResourceManager at master/172.16.77.15:8032

14/05/14 10:33:36 INFO mapreduce.Job: The url to track the job: http://master:8088/proxy/application_1400084979891_0004/

14/05/14 10:33:36 INFO mapreduce.Job: Running job: job_1400084979891_0004

14/05/14 10:33:45 INFO mapreduce.Job: Job job_1400084979891_0004 running in uber mode : false

14/05/14 10:33:45 INFO mapreduce.Job: map 0% reduce 0%

14/05/14 10:34:10 INFO mapreduce.Job: map 100% reduce 0%

14/05/14 10:34:19 INFO mapreduce.Job: map 100% reduce 100%

14/05/14 10:34:19 INFO mapreduce.Job: Job job_1400084979891_0004 completed successfully

14/05/14 10:34:20 INFO mapreduce.Job: Counters: 43

File System Counters

FILE: Number of bytes read=81

FILE: Number of bytes written=158693

FILE: Number of read operations=0

FILE: Number of large read operations=0

FILE: Number of write operations=0

HDFS: Number of bytes read=175

HDFS: Number of bytes written=51

HDFS: Number of read operations=6

HDFS: Number of large read operations=0

HDFS: Number of write operations=2

Job Counters

Launched map tasks=1

Launched reduce tasks=1

Data-local map tasks=1

Total time spent by all maps in occupied slots (ms)=23099

Total time spent by all reduces in occupied slots (ms)=6768

Map-Reduce Framework

Map input records=5

Map output records=10

Map output bytes=106

Map output materialized bytes=81

Input split bytes=108

Combine input records=10

Combine output records=6

Reduce input groups=6

Reduce shuffle bytes=81

Reduce input records=6

Reduce output records=6

Spilled Records=12

Shuffled Maps =1

Failed Shuffles=0

Merged Map outputs=1

GC time elapsed (ms)=377

CPU time spent (ms)=11190

Physical memory (bytes) snapshot=284524544

Virtual memory (bytes) snapshot=2000748544

Total committed heap usage (bytes)=136450048

Shuffle Errors

BAD_ID=0

CONNECTION=0

IO_ERROR=0

WRONG_LENGTH=0

WRONG_MAP=0

WRONG_REDUCE=0

File Input Format Counters

Bytes Read=67

File Output Format Counters

Bytes Written=51

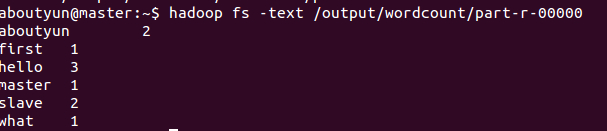

查看结果,执行如下命令:

- hadoop fs -text /output/wordcount/part-r-00000

复制代码

结果数据示例如下:

- aboutyun@master:~$ hadoop fs -text /output/wordcount/part-r-00000

- aboutyun 2

- first 1

- hello 3

- master 1

- slave 2

- what 1

复制代码

<ignore_js_op>

登录到Web控制台,访问链接http://master:8088/可以看到任务记录情况。

下一篇:hadoop2.2运行mapreduce(wordcount)问题总结

hadoop2.2使用手册2:如何运行自带wordcount的更多相关文章

- Hadoop 2.6.3运行自带WordCount程序笔记

运行平台:Hadoop 2.6.3 模式:完全分布模式 1.准备统计文本,以一段文字为例:eg.txt The Project Gutenberg EBook of War and Peace, by ...

- hadoop:如何运行自带wordcount

1.在linux系统创建文件 vi aa.txt --------i 进行编辑 输入 内容(多个单词例如:aa bb cc aa) 2.在HDFS上面创建文件夹 hdfs dfs -mkdir ...

- 指导手册04:运行MapReduce

指导手册04:运行MapReduce Part 1:运行单个MapReduce任务 情景描述: 本次任务要求对HDFS目录中的数据文件/user/root/email_log.txt进行计算处理, ...

- 伪分布式环境下命令行正确运行hadoop示例wordcount

首先确保hadoop已经正确安装.配置以及运行. 1. 首先将wordcount源代码从hadoop目录中拷贝出来. [root@cluster2 logs]# cp /usr/local/h ...

- VSCode 使用 Code Runner 插件无法编译运行文件名带空格的文件

本文同时在我的博客发布:VSCode 使用 Code Runner 插件无法编译运行文件名带空格的文件 - Skykguj 's Blog (sky390.cn) 使用 Visual Studio C ...

- 【hadoop2.6.0】安装+例子运行

由于下载的是hadoop的最新版,网上各种杂七杂八的东西都不适用.好在官网上说的也够清楚了.如果有人看这篇文章的话,最大的忠告就是看官网. 官网2.6.0的安装教程:http://hadoop.apa ...

- 【hadoop2.6.0】通过代码运行程序流程

之前跑了一下hadoop里面自带的例子,现在顺一下如何通过源代码来运行程序. 我懒得装eclipse,就全部用命令行了. 整体参考官网上的:http://hadoop.apache.org/docs/ ...

- hadoop2.X使用手册1:通过web端口查看主节点、slave1节点及集群运行状态

导读内容:1.如何通过web查看hdfs集群状态2.如何通过web查看运行在在主节点master上ResourceManager状态3.如何通过web查看运行在在slave节点NodeManager资 ...

- Ubuntu 12.04.5 LTS 上安装hadoop 2.6.0后运行自带的例程wordcount

注:我所有的操作均通过Xshell 5远程连接Ubuntu进行实施 第一步:启动hadoop,利用jps查看hadoop是否已经启动,如果没有启动用start-dfs.sh脚本启动(hadoop2.X ...

随机推荐

- angular2中的路由转场动效

1.为什么有的人路由转动效离场动效不生效? 自己研究发现是加动效的位置放错了 如下: <---! animate-state.component.html --> <div sty ...

- C++(二十七) — 深拷贝、浅拷贝、复制构造函数举例

1.复制构造函数.及new空间申请 复制构造函数,也是构造函数.只在初始化时调用,如果定义对象后赋值,比如,t1=t2,则只是运算符重载,没有调用构造函数. #include <iostream ...

- mongo docker image

mongo 保存压缩镜像 docker save -o ~/Desktop/mongo.tar mongo 7za a -mx=9 ~/Desktop/mongo.tar{.7z,} 导入或拉取镜像 ...

- Oracle登录被拒绝; 权限不足或用户名/口令无效

第一步: 打开CMD命令窗,输入如下命令:sqlplus "/as sysdba",回车 第二步: 输入命令:alter user sys identified by Orcl12 ...

- 分析器错误信息: 未能加载类型“xxx.Global”。

Global.asax错误 分析器错误 说明: 在分析向此请求提供服务所需资源时出错.请检查下列特定分析错误详细信息并适当地修改源文件. 分析器错误信息: 未能加载类型“xxx.Global”. 源错 ...

- WebApplication和WebSite的简单区别

初步认识网站和网站应用程序区别 1. 网页头部文件 网站 <%@ Page Language="VB" AutoEventWireup="false" C ...

- matlab eye 函数

eye(n,n) 产生一个n*n的单位矩阵 eye(n,m) 产生一个n*m的单位矩阵 eye(3,3) ans = 1 0 0 0 1 0 0 0 1 eye(3,4) ans = 1 0 0 0 ...

- OC-NSArray

一.认识数组 oc中可以把NSObject对象的子类放到数组这个集合中,但是int.float.double等基础数据类型需要先进行转换才可以存入数组. oc中数组以NS开头,其中分为可变数组和不可变 ...

- 前端中CSS属性大全

css属性 布局常用样式属性: width 设置元素(标签)的宽度,如:width:100px; height 设置元素(标签)的高度,如:height:200px; background 设置元素背 ...

- 一个浮动 css3效果

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...