PyTorch程序练习(二):循环神经网络的PyTorch实现

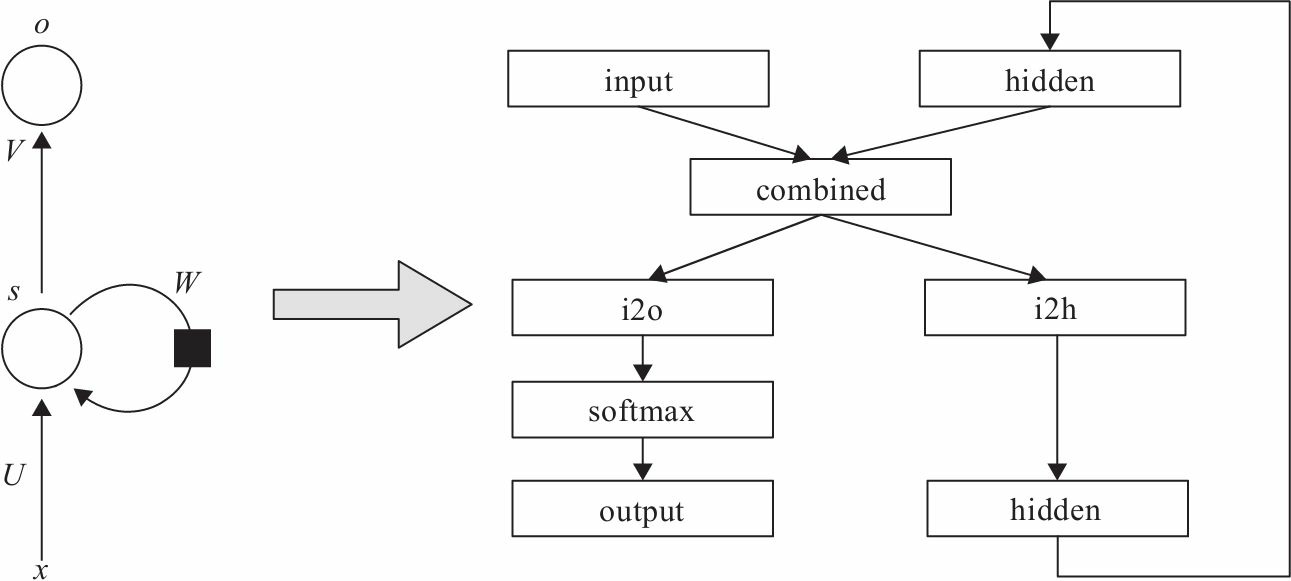

一、RNN实现

结构原理

代码实现

import torch

import torch.nn as nn

class RNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(RNN, self).__init__()

self.hidden_size = hidden_size

self.i2h = nn.Linear(input_size + hidden_size, hidden_size)

self.i2o = nn.Linear(input_size + hidden_size, output_size)

self.softmax = nn.LogSoftmax(dim=1)

def forward(self, input, hidden):

combined = torch.cat((input, hidden), 1)

hidden = self.i2h(combined) #全连接层

output: object = self.i2o(combined)

output = self.softmax(output)

return output, hidden

def initHidden(self):

return torch.zeros(1, self.hidden_size)

二、LSTM实现

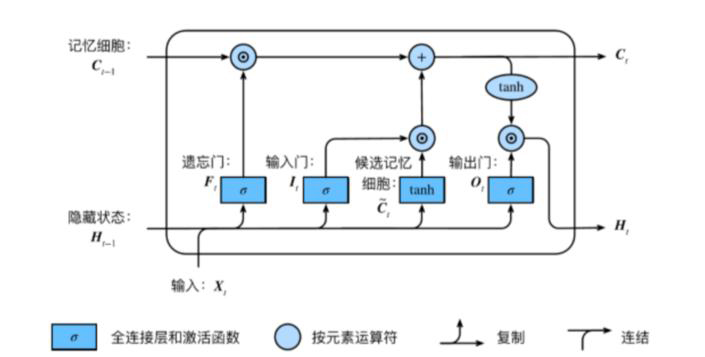

结构原理

封装好的LSTM

import torch

import torch.nn as nn

class LSTMTagger(nn.Module):

def __init__(self, embedding_dim, hidden_dim, vocab_size, tagset_size):

super(LSTMTagger, self).__init__()

self.hidden_dim = hidden_dim

self.word_embeddings = nn.Embedding(vocab_size, embedding_dim)

# LSTM以word_embeddings作为输入, 输出维度为 hidden_dim 的隐藏状态值

self.lstm = nn.LSTM(embedding_dim, hidden_dim)

# 线性层将隐藏状态空间映射到标注空间

self.hidden2tag = nn.Linear(hidden_dim, tagset_size)

self.hidden = self.init_hidden()

def init_hidden(self):

# 一开始并没有隐藏状态所以要先初始化一个

# 各个维度的含义是 (num_layers, minibatch_size, hidden_dim)

return (torch.zeros(1, 1, self.hidden_dim),

torch.zeros(1, 1, self.hidden_dim))

def forward(self, sentence):

embeds = self.word_embeddings(sentence)

lstm_out, self.hidden = self.lstm(embeds.view(len(sentence), 1, -1), self.hidden)

tag_space = self.hidden2tag(lstm_out.view(len(sentence), -1))

tag_scores = F.log_softmax(tag_space, dim=1)

return tag_scores未封装的LSTM

import torch

import torch.nn as nn

class LSTMCell(nn.Module):

def __init__(self, input_size, hidden_size, cell_size, output_size):

super(LSTMCell, self).__init__()

self.hidden_size = hidden_size

self.cell_size = cell_size

self.gate = nn.Linear(input_size + hidden_size, cell_size) # 门:线性全连接层

self.output = nn.Linear(hidden_size, output_size)

self.sigmoid = nn.Sigmoid()

self.tanh = nn.Tanh()

self.softmax = nn.LogSoftmax(dim=1)

def forward(self, input, hidden, cell):

combined = torch.cat((input, hidden), 1) #维度上连接

f_gate = self.sigmoid(self.gate(combined)) #遗忘门

i_gate = self.sigmoid(self.gate(combined)) #输入门

o_gate = self.sigmoid(self.gate(combined)) #输出门

z_state = self.tanh(self.gate(combined))

cell = torch.add(torch.mul(cell, f_gate), torch.mul(z_state, i_gate))

"""

cell长期记忆细胞:(cell·f_gate)+(z_state·i_gate)

遗忘门经过sigmoid后,值在[0,1]之间:

当f_gate趋于0时,和cell矩阵相乘后,记忆细胞为0,忘记长期记忆;

当f_gate区域1时,cell全部输入,作为长期记忆。

"""

hidden = torch.mul(self.tanh(cell), o_gate) #隐藏层:长期记忆细胞cell先过一层tanh激活函数,然后和输出门o_gate矩阵相乘

output = self.output(hidden) #隐藏层作为输出层的输出

output = self.softmax(output)

return output, hidden, cell

def initHidden(self):

return torch.zeros(1, self.hidden_size)

def initCell(self):

return torch.zeros(1, self.cell_size)三、GRU实现

结构原理

代码实现

import torch

import torch.nn as nn

class GRUCell(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(GRUCell, self).__init__()

self.hidden_size = hidden_size

self.gate = nn.Linear(input_size + hidden_size, hidden_size)

self.output = nn.Linear(hidden_size, output_size)

self.sigmoid = nn.Sigmoid()

self.tanh = nn.Tanh()

self.softmax = nn.LogSoftmax(dim=1)

def forward(self, input, hidden):

combined = torch.cat((input, hidden), 1)

z_gate = self.sigmoid(self.gate(combined)) #重置门

r_gate = self.sigmoid(self.gate(combined)) #更新门

combined01 = torch.cat((input, torch.mul(hidden, r_gate)), 1)

h1_state = self.tanh(self.gate(combined01))

h_state = torch.add(torch.mul((1 - z_gate), hidden), torch.mul(h1_state, z_gate))

output = self.output(h_state)

output = self.softmax(output)

return output, h_state

def initHidden(self):

return torch.zeros(1, self.hidden_size)四、程序分析

1、RNN(Recurrent Natural Network,循环神经网络)

PyTorch提供了两个版本的循环神经网络接口,单元版的输入是每个时间步,或循环神经网络的一个循环,而封装版的是一个序列。

2、LSTM(Long Short-TermMemory,长短时记忆网络)

LSTM是在RNN基础上增加了长时间记忆功能,具体通过增加一个状态C及利用3个门(Gate)实现对信息的更精准控制。

LSTM比标准的RNN多了3个线性变换,多出的3个线性变换的权重合在一起是RNN的4倍,偏移量也是RNN的4倍。所以,LSTM的参数个数是RNN的4倍。

除了参数的区别外,隐含状态除h0外,多了一个c0,两者形状相同,都是(num_layers*num_directions,batch,hidden_size),它们合在一起构成了LSTM的隐含状态。所以,LSTM的输入隐含状态为(h0,c0),输出的隐含状态为(hn,cn),其他输入与输出与RNN相同。

3、GRU(Gated Recurrent Unit,门控循环单元)

GRU网络结构与LSTM基本相同,主要区别是LSTM共有3个门,两个隐含状态;而GRU只有两个门,一个隐含状态。其参数是标准RNN的3倍。

PyTorch程序练习(二):循环神经网络的PyTorch实现的更多相关文章

- [Pytorch框架] 2.5 循环神经网络

文章目录 2.5 循环神经网络 2.5.1 RNN简介 RNN的起因 为什么需要RNN RNN都能做什么 2.5.2 RNN的网络结构及原理 RNN LSTM GRU 2.5.3 循环网络的向后传播( ...

- Pytorch循环神经网络LSTM时间序列预测风速

#时间序列预测分析就是利用过去一段时间内某事件时间的特征来预测未来一段时间内该事件的特征.这是一类相对比较复杂的预测建模问题,和回归分析模型的预测不同,时间序列模型是依赖于事件发生的先后顺序的,同样大 ...

- pytorch循环神经网络实现回归预测 代码

pytorch循环神经网络实现回归预测 学习视频:莫烦python # RNN for classification import torch import numpy as np import to ...

- 『PyTorch』第十弹_循环神经网络

RNN基础: 『cs231n』作业3问题1选讲_通过代码理解RNN&图像标注训练 TensorFlow RNN: 『TensotFlow』基础RNN网络分类问题 『TensotFlow』基础R ...

- 神经网络架构PYTORCH-初相识(3W)

who? Python是基于Torch的一种使用Python作为开发语言的开源机器学习库.主要是应用领域是在自然语言的处理和图像的识别上.它主要的开发者是Facebook人工智能研究院(FAIR)团队 ...

- MINIST深度学习识别:python全连接神经网络和pytorch LeNet CNN网络训练实现及比较(三)

版权声明:本文为博主原创文章,欢迎转载,并请注明出处.联系方式:460356155@qq.com 在前两篇文章MINIST深度学习识别:python全连接神经网络和pytorch LeNet CNN网 ...

- 解决运行pytorch程序多线程问题

当我使用pycharm运行 (https://github.com/Joyce94/cnn-text-classification-pytorch ) pytorch程序的时候,在Linux服务器 ...

- 神经网络架构PYTORCH-几个概念

使用Pytorch之前,有几个概念需要弄清楚. 什么是Tensors(张量)? 这个概念刚出来的时候,物理科班出身的我都感觉有点愣住了,好久没有接触过物理学的概念了. 这个概念,在物理学中怎么解释呢? ...

- PyTorch专栏(二)

专栏目录: 第一章:PyTorch之简介与下载 PyTorch简介 PyTorch环境搭建 第二章:PyTorch之60min入门 PyTorch 入门 PyTorch 自动微分 PyTorch 神经 ...

- NLP与深度学习(二)循环神经网络

1. 循环神经网络 在介绍循环神经网络之前,我们先考虑一个大家阅读文章的场景.一般在阅读一个句子时,我们是一个字或是一个词的阅读,而在阅读的同时,我们能够记住前几个词或是前几句的内容.这样我们便能理解 ...

随机推荐

- Go-Zero技能提升:深度探究goctl的妙用,轻松应对微服务开发挑战!(三)

前言 有位同学在群里说:"Go-Zero官方文档太简洁了,对小白有点不友好.好奇你们是怎么学习的?项目是怎么封装的?有什么提高开发效率的技巧吗?". 来来来,这期内容给你安排上,先 ...

- TypingLearn解决了我在学习英语中的一大痛点

上一次在博客园发贴还是在上一次(2021年),那个时候博客园就遇到了危机(被罚款).彼时在疫情期间,我个人生活也受到了影响,先后去了多个城市,最终在上海找到了 .NET Web开发的岗位,还是比较幸运 ...

- 防火墙规则之iptables

防火墙规则之iptables 一 如何禁止外面应用对某个端口访问 iptables -I INPUT -p TCP ! --source 127.0.0.1 --dport 8080 -j DROP ...

- k8s的知识图谱以及相关的知识梳理

一 kubernetes的知识图谱如下所示: 可以随时的根据自身情况来学习和深化对知识点的总结和归档

- 阿里面试:NIO为什么会导致CPU100%?

在 Java 中总共有三种 IO 类型:BIO(Blocking I/O,阻塞I/O).NIO(Non-blocking I/O,非阻塞I/O)和 AIO(Asynchronous I/O,异步I/O ...

- Prism 基础知识学习(五)发布订阅

Prism 基础知识学习(五)发布订阅 在 ViewBViewModel.cs中 1 public class ViewBViewModel : IDialogAware 2 { 3 /// < ...

- WPF ListBox 控件绑定 Binding

当我们需要用到循环的列表内容,并且模板化程度高的时候,建议使用 ListBox 来做绑定.XAML: <Window.DataContext> <local:VMTempTest/& ...

- kubernetes(k8s)

应用程序部署的演变过程 在部署应用程序的方式上,主要经历了三个时代 传统部署 互联网早期,会直接将应用程序部署在物理机上 优点: 简单,不需要其他技术的参与 缺点: 不能为应用程序定义资源使用边界,很 ...

- 解决PMML namespace URI httpwww.dmg.orgPMML-4_4 is not supported

使用pmml的方式跨平台部署机器学习模型时,在java中加载模型,出现了该错误 原因:java的jar包版本与PMML文件的版本不相符,jar包的版本过低无法解析PMML文件.如果升级jar包,加载模 ...

- ABC330

D 记录每一行,每一列有多少个 o,然后统计答案即可. code E 想到 \(mex^{i \le n}_{i = 1} a_i \le n\) 这整个题就可做了(赛时因为没想到这个,痛失 \(47 ...