tensorflow笔记(三)之 tensorboard的使用

tensorflow笔记(三)之 tensorboard的使用

版权声明:本文为博主原创文章,转载请指明转载地址

http://www.cnblogs.com/fydeblog/p/7429344.html

前言

这篇博客将介绍tensorflow当中一个非常有用的可视化工具tensorboard的使用,它将对我们分析训练效果,理解训练框架和优化算法有很大的帮助。

还记得我的第一篇tensorflow博客上的的例子吗?这篇博客会以第一篇tensorflow博客的tensorboard图为例进行展开。

我会把这篇博客的相关代码(代码也会贴在博客上,可以直接copy生成py文件用)和notebook放在文后的百度云链接上,欢迎下载!

1. 实践1--矩阵相乘

相应的代码

import tensorflow as tf

with tf.name_scope('graph') as scope:

matrix1 = tf.constant([[3., 3.]],name ='matrix1') #1 row by 2 column

matrix2 = tf.constant([[2.],[2.]],name ='matrix2') # 2 row by 1 column

product = tf.matmul(matrix1, matrix2,name='product')

sess = tf.Session()

writer = tf.summary.FileWriter("logs/", sess.graph)

init = tf.global_variables_initializer()

sess.run(init)

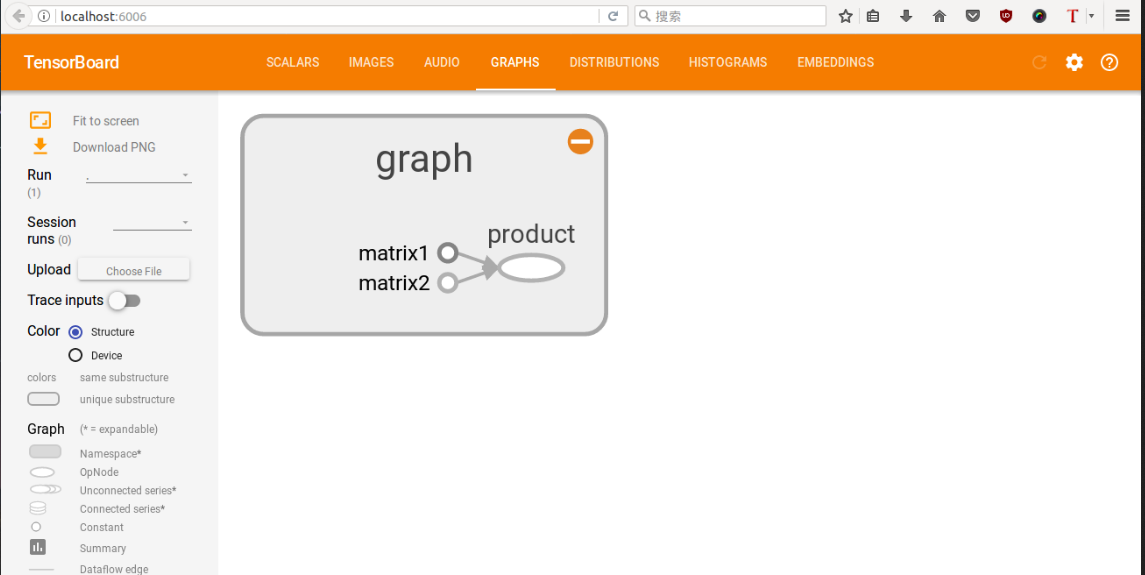

这里相对于第一篇tensorflow多了一点东西,tf.name_scope函数是作用域名,上述代码斯即在graph作用域op下,又有三个op(分别是matrix1,matrix2,product),用tf函数内部的name参数命名,这样会在tensorboard中显示,具体图像还请看下面。

很重要:运行上面的代码,查询当前目录,就可以找到一个新生成的文件,已命名为logs,我们需在终端上运行tensorboard,生成本地链接,具体看我截图,当然你也可以将上面的代码直接生成一个py文档在终端运行,也会在终端当前目录生成一个logs文件,然后运行tensorboard --logdir logs指令,就可以生成一个链接,复制那个链接,在google浏览器(我试过火狐也行)粘贴显示,对于tensorboard 中显示的网址打不开的朋友们, 请使用 http://localhost:6006 (如果这个没有成功,我之前没有安装tensorboard,也出现链接,但那个链接点开什么都没有,所以还有一种可能就是你没有安装tensorboard,使用pip install tensorboard安装tensorboard,python3用pip3 install tensorboard)

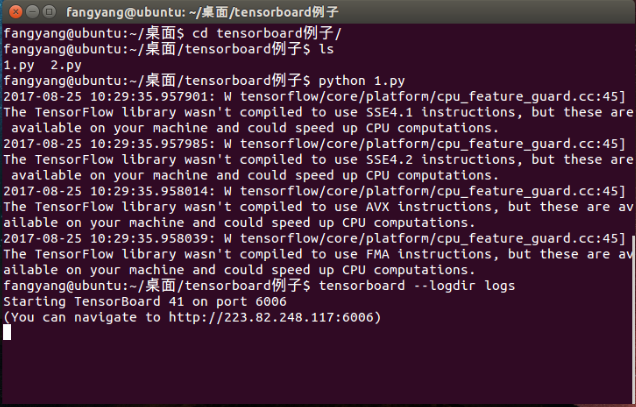

具体运行过程如下(中间的警告请忽略,我把上面的代码命名为1.py运行的)

可以看到最后一行出现了链接,复制那个链接,推荐用google浏览器打开(火狐我试过也行),也可以直接打开链接http://localhost:6006,这样更方便!

如果出现下图,则证明打开成功

2. 实践2---线性拟合(一)

上面那一个是小试牛刀,比较简单,没有任何训练过程,下面将第一篇tensorflow笔记中的第二个例子来画出它的流动图(哦,对了,之所有说是流动图,这是由于tensorflow的名字就是张量在图形中流动的意思)

代码如下:(命名文件2.py)

import tensorflow as tf

import numpy as np ## prepare the original data

with tf.name_scope('data'):

x_data = np.random.rand(100).astype(np.float32)

y_data = 0.3*x_data+0.1

##creat parameters

with tf.name_scope('parameters'):

weight = tf.Variable(tf.random_uniform([1],-1.0,1.0))

bias = tf.Variable(tf.zeros([1]))

##get y_prediction

with tf.name_scope('y_prediction'):

y_prediction = weight*x_data+bias

##compute the loss

with tf.name_scope('loss'):

loss = tf.reduce_mean(tf.square(y_data-y_prediction))

##creat optimizer

optimizer = tf.train.GradientDescentOptimizer(0.5)

#creat train ,minimize the loss

with tf.name_scope('train'):

train = optimizer.minimize(loss)

#creat init

with tf.name_scope('init'):

init = tf.global_variables_initializer()

##creat a Session

sess = tf.Session()

##initialize

writer = tf.summary.FileWriter("logs/", sess.graph)

sess.run(init)

## Loop

for step in range(101):

sess.run(train)

if step %10==0 :

print step ,'weight:',sess.run(weight),'bias:',sess.run(bias)

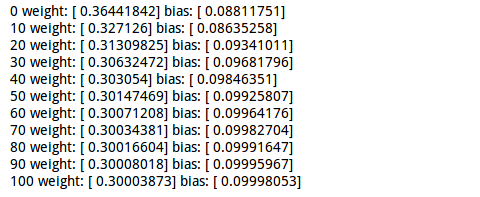

运行这个程序会打印一些东西,看过第一篇tensorflow笔记的人应该知道

具体输出如下:

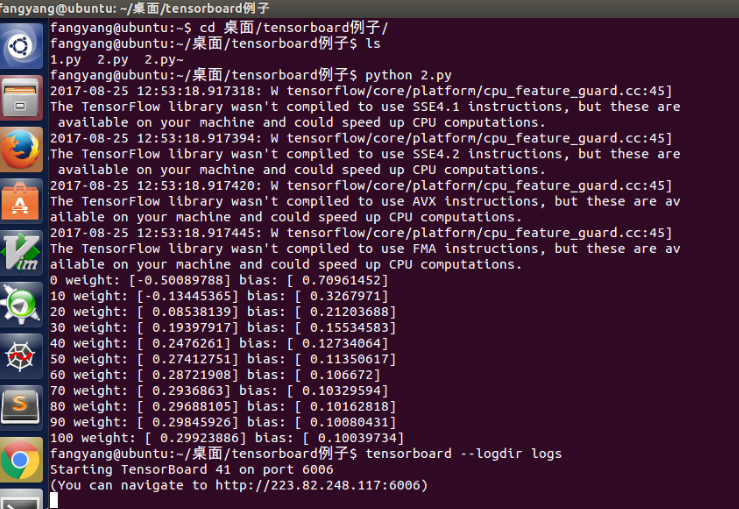

具体的运行过程如下图,跟第一个差不多

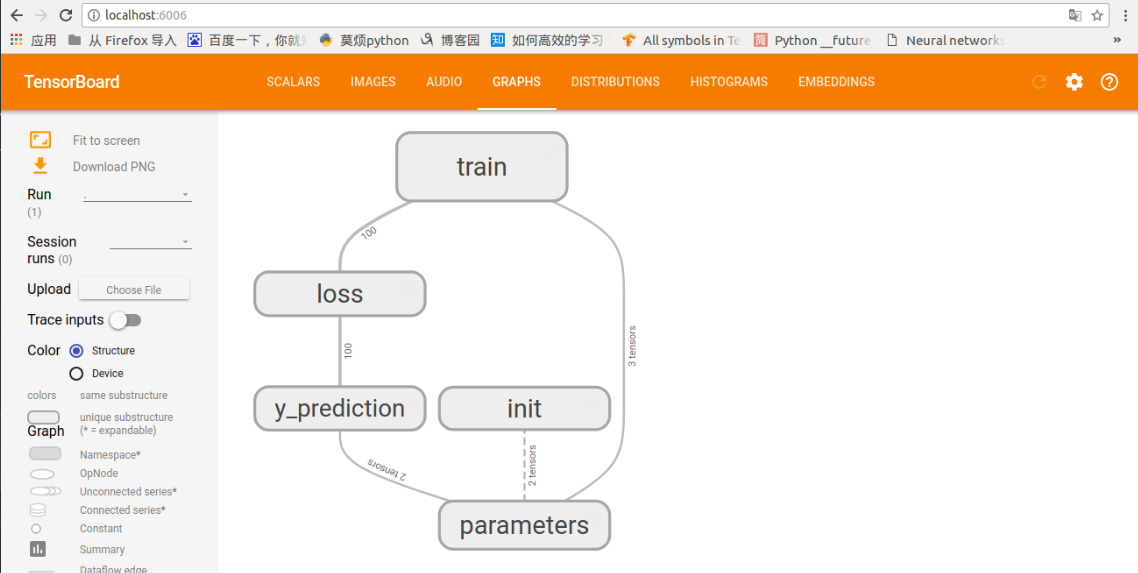

打开链接后,会出现下图

这个就是上面代码的流动图,先初始化参数,算出预测,计算损失,然后训练,更新相应的参数。

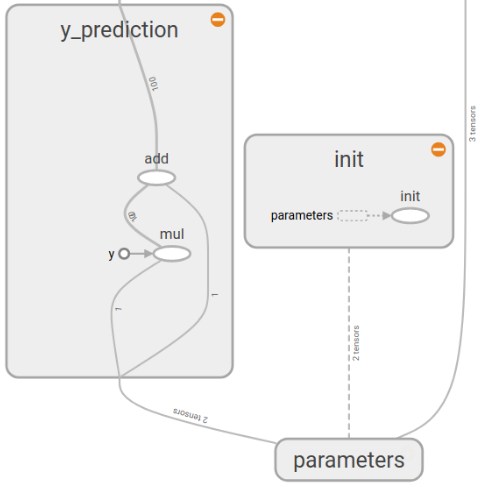

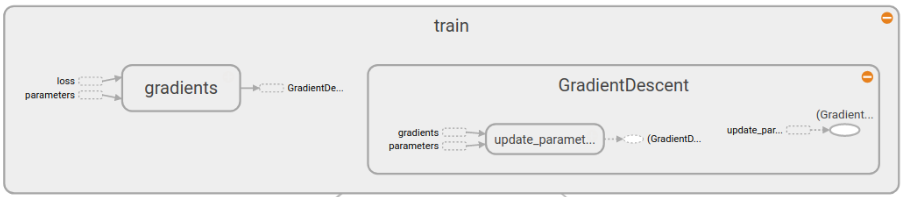

当然这个图还可以进行展开,里面有更详细的流动(截图无法全面,还请自己运行出看看哦)

Parameters部分

y_prediction部分和init部分

loss部分

还有最后的train部分

具体东西还请自己展开看看,不难理解

2. 实践2---线性拟合(二)

我们在对上面的代码进行再修改修改,试试tensorboard的其他功能,例如scalars,distributions,histograms,它们对我们分析学习算法的性能有很大帮助。

代码如下:(命名文件3.py)

import tensorflow as tf

import numpy as np ## prepare the original data

with tf.name_scope('data'):

x_data = np.random.rand(100).astype(np.float32)

y_data = 0.3*x_data+0.1

##creat parameters

with tf.name_scope('parameters'):

with tf.name_scope('weights'):

weight = tf.Variable(tf.random_uniform([1],-1.0,1.0))

tf.summary.histogram('weight',weight)

with tf.name_scope('biases'):

bias = tf.Variable(tf.zeros([1]))

tf.summary.histogram('bias',bias)

##get y_prediction

with tf.name_scope('y_prediction'):

y_prediction = weight*x_data+bias

##compute the loss

with tf.name_scope('loss'):

loss = tf.reduce_mean(tf.square(y_data-y_prediction))

tf.summary.scalar('loss',loss)

##creat optimizer

optimizer = tf.train.GradientDescentOptimizer(0.5)

#creat train ,minimize the loss

with tf.name_scope('train'):

train = optimizer.minimize(loss)

#creat init

with tf.name_scope('init'):

init = tf.global_variables_initializer()

##creat a Session

sess = tf.Session()

#merged

merged = tf.summary.merge_all()

##initialize

writer = tf.summary.FileWriter("logs/", sess.graph)

sess.run(init)

## Loop

for step in range(101):

sess.run(train)

rs=sess.run(merged)

writer.add_summary(rs, step)

闲麻烦,我把打印的去掉了,这里多了几个函数,tf.histogram(对应tensorboard中的scalar)和tf.scalar函数(对应tensorboard中的distribution和histogram)是制作变化图表的,两者差不多,使用方式可以参考上面代码,一般是第一项字符命名,第二项就是要记录的变量了,最后用tf.summary.merge_all对所有训练图进行合并打包,最后必须用sess.run一下打包的图,并添加相应的记录。

运行过程与上面两个一样

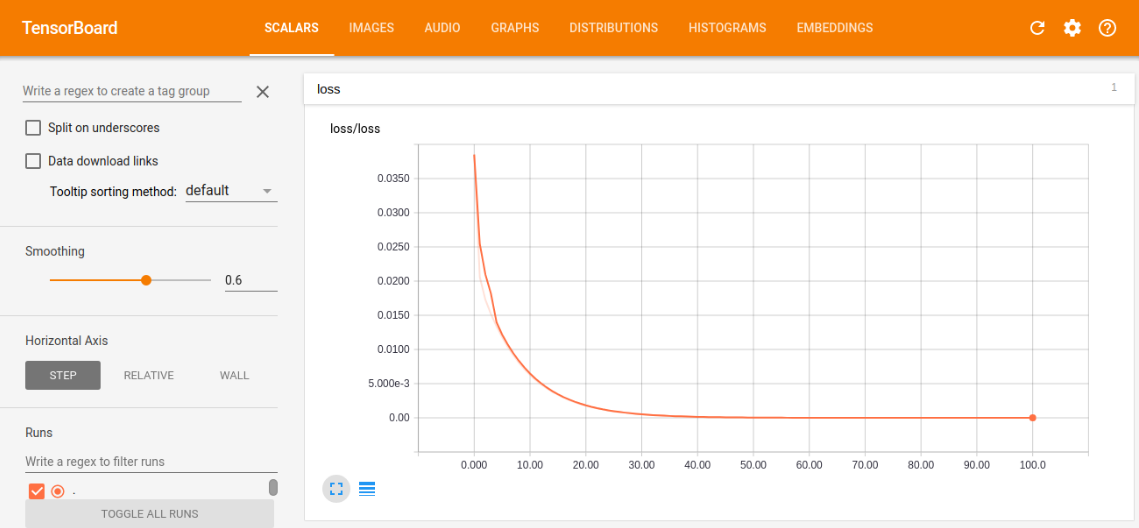

下面来看看tensorboard中的训练图吧

scalar中的loss训练图

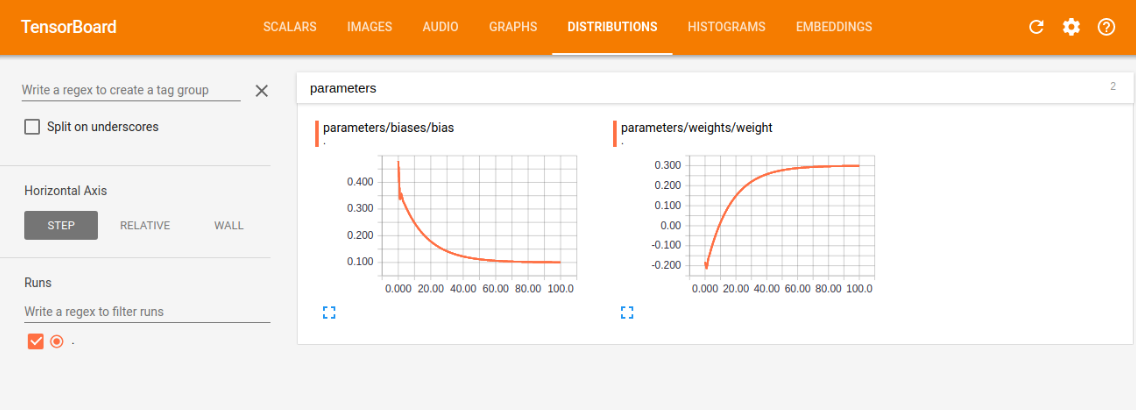

distribution中的weight和bias的训练图

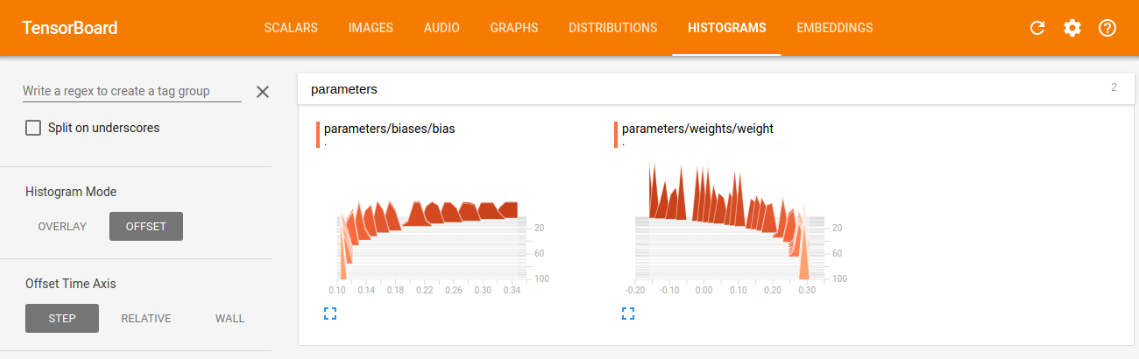

histogram中的weight和bias的训练图

我们可以根据训练图,对学习情况进行评估,比如我们看损失训练图,可以看到现在是一条慢慢减小的曲线,最后的值趋近趋近于0(这里趋近于0是由于我选的模型太容易训练了,误差可以逼近0,同时又能很好的表征系统的模型,在现实情况,往往都有误差,趋近于0反而是过拟合),这符合本意,就是要最小化loss,如果loss的曲线最后没有平滑趋近一个数,则说明训练的力度还不够,还有加大次数,如果loss还很大,说明学习算法不太理想,需改变当前的算法,去实现更小的loss,另外两幅图与loss类似,最后都是要趋近一个数的,没有趋近和上下浮动都是有问题的。

结尾

tensorboard的博客结束了,我写的只是基础部分,更多东西还请看官方的文档和教程,希望这篇博客能对你学习tensorboard有帮助!

notebook链接: https://pan.baidu.com/s/1o8lzN1g 密码: mbv8

tensorflow笔记(三)之 tensorboard的使用的更多相关文章

- TensorFlow笔记三:从Minist数据集出发 两种经典训练方法

Minist数据集:MNIST_data 包含四个数据文件 一.方法一:经典方法 tf.matmul(X,w)+b import tensorflow as tf import numpy as np ...

- tensorflow笔记2:TensorBoard

Tensorboard中的参数 Summary:所有需要在TensorBoard上展示的统计结果. tf.name_scope():为Graph中的Tensor添加层级,TensorBoard会按照代 ...

- Tensorflow 笔记 -- tensorboard 的使用

Tensorflow 笔记 -- tensorboard 的使用 TensorFlow提供非常方便的可视化命令Tensorboard,先上代码 import tensorflow as tf a = ...

- tensorflow笔记(一)之基础知识

tensorflow笔记(一)之基础知识 版权声明:本文为博主原创文章,转载请指明转载地址 http://www.cnblogs.com/fydeblog/p/7399701.html 前言 这篇no ...

- tensorflow笔记:使用tf来实现word2vec

(一) tensorflow笔记:流程,概念和简单代码注释 (二) tensorflow笔记:多层CNN代码分析 (三) tensorflow笔记:多层LSTM代码分析 (四) tensorflow笔 ...

- tensorflow笔记:模型的保存与训练过程可视化

tensorflow笔记系列: (一) tensorflow笔记:流程,概念和简单代码注释 (二) tensorflow笔记:多层CNN代码分析 (三) tensorflow笔记:多层LSTM代码分析 ...

- tensorflow笔记(二)之构造一个简单的神经网络

tensorflow笔记(二)之构造一个简单的神经网络 版权声明:本文为博主原创文章,转载请指明转载地址 http://www.cnblogs.com/fydeblog/p/7425200.html ...

- tensorflow笔记(四)之MNIST手写识别系列一

tensorflow笔记(四)之MNIST手写识别系列一 版权声明:本文为博主原创文章,转载请指明转载地址 http://www.cnblogs.com/fydeblog/p/7436310.html ...

- 【TensorFlow篇】--Tensorflow框架可视化之Tensorboard

一.前述 TensorBoard是tensorFlow中的可视化界面,可以清楚的看到数据的流向以及各种参数的变化,本文基于一个案例讲解TensorBoard的用法. 二.代码 设计一个MLP多层神经网 ...

随机推荐

- 通过ALM OTA API获取test case的信息,并上传测试结果到test set中

ALM提供了OTA接口,可以用来获取和上传测试数据到ALM.比如获取Test case的step信息.上传测试结果到test instance. 在ALM的Help中可以下载相关文档,这里以ALM11 ...

- 如何在python脚本里面连续执行adb shell后面的各种命令

如何在python脚本里面连续执行adb shell后面的各种命令 adb shell "cd /data/local && mkdir tmp" adb shel ...

- AugularJS从入门到实践(三)

前 言 前端 AngularJS是为了克服HTML在构建应用上的不足而设计的.(引用百度百科) AngularJS使用了不同的方法,它尝试去补足HTML本身在构建应用方面的缺陷.Angu ...

- 【HTML】谈谈html的meta标签

一.定义&用法 <meta> 元素可提供有关页面的元信息(meta-information),比如针对搜索引擎和更新频度的描述和关键词. <meta> 标签位于文档的头 ...

- Hexo博客添加SEO-评论系统-阅读统计-站长统计

原文地址:→传送门 写在前面 在五月出捣腾了一把个人博客,但是刚开始只做了一些基础设置,套路也没摸清,基础安装篇请看hexo从零开始到搭建完整,里面讲到了基础工具的安装及blog项目的文件夹含义,以及 ...

- PPK提供的浏览器类型及版本检测方法

PPK提供的浏览器类型及版本检测方法 一个常用但是被高估的Javascript函数就是浏览器检测.有些时候,你想给出一个说明或者加载一个页面来提示用户,以免使用Safari等浏览器. 使用方法: ...

- POJ 3259 Wormholes Bellman_ford负权回路

Description While exploring his many farms, Farmer John has discovered a number of amazing wormholes ...

- 基于FPGA的Uart接收图像数据至VGA显示

系统框图 前面我们设计了基于FPGA的静态图片显示,接下来我们来做做基于FPGA的动态图片显示,本实验内容为:由PC端上位机软件通过串口发送一幅图像数据至FPGA,FPGA内部将图像数据存储,最后扫描 ...

- Numpy 操作

一.Numpy 属性 # 列表转化为矩阵 In []: arr = np.array([[,,],[,,]]) In []: arr Out[]: array([[, , ], [, , ]]) 1, ...

- multiset与set

set的含义是集合,它是一个有序的容器,里面的元素都是排序好的,支持插入,删除,查找等操作,就 像一个集合一样.所有的操作的都是严格在logn时间之内完成,效率非常高. set和multiset的 ...