3-2 Hadoop集群伪分布模式配置部署

Hadoop伪分布模式配置部署

一、实验介绍

1.1 实验内容

- hadoop配置文件介绍及修改

- hdfs格式化

- 启动hadoop进程,验证安装

1.2 实验知识点

- hadoop核心配置文件

- 文件系统的格式化

- 测试WordCount程序

1.3 实验环境

- hadoop2.7.6

- CentOS6终端

1.4 适合人群

本课程难度为一般,属于初级级别课程,适合具有hadoop基础的用户。

1.5 相关文件

https://pan.baidu.com/s/1a_Pjl8uJ2d_-r1hbN05fWA

二、Hadoop伪分布式模式配置

注意:本实验需要按照上一节单机模式部署后继续进行操作,因此您必须先完成上一节实验。

2.1 相关配置文件修改

(若文件中没有添加的配置项,则系统为默认值,不会对该实验产生影响)

1).修改.bashrc:

由于平台环境与该实验hadoop版本不匹配问题,需要对.bashr文件中末尾处的环境变量做修改

$ vim /home/hadoop/.bashrc

修改为:

export HADOOP_HOME=/home/hadoop/hdfs

export PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/home/hadoop/hdfs/bin:/home/hadoop/hdfs/sbin

由于本实验不会用到hbase和hive,所以相关环境变量删除。

提醒:修改了配置文件后,如何使变量生效?上一节我们有使用到过,大家自行回顾一下。

2).修改core-site.xml:

$ vim/home/hadoop/hdfs/etc/hadoop/core-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/tmp</value>

</property>

</configuration>

常用配置项说明:

fs.defaultFS这是默认的HDFS路径。当有多个HDFS集群同时工作时,用户在这里指定默认HDFS集群,该值来自于hdfs-site.xml中的配置。fs.default.name这是一个描述集群中NameNode结点的URI(包括协议、主机名称、端口号),集群里面的每一台机器都需要知道NameNode的地址。DataNode结点会先在NameNode上注册,这样它们的数据才可以被使用。独立的客户端程序通过这个URI跟DataNode交互,以取得文件的块列表。

hadoop.tmp.dir是hadoop文件系统依赖的基础配置,很多路径都依赖它。如果hdfs-site.xml中不配置namenode和datanode的存放位置,默认就放在/tmp/hadoop-${user.name}这个路径中。

更多说明请参考core-default.xml,包含配置文件所有配置项的说明和默认值。

3).修改hdfs-site.xml:

$ vim/home/hadoop/hdfs/etc/hadoop/hdfs-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

常用配置项说明:

dfs.replication它决定着系统里面的文件块的数据备份个数。对于一个实际的应用,它应该被设为3(这个数字并没有上限,但更多的备份可能并没有作用,而且会占用更多的空间)。少于三个的备份,可能会影响到数据的可靠性(系统故障时,也许会造成数据丢失)dfs.data.dir这是DataNode结点被指定要存储数据的本地文件系统路径。DataNode结点上的这个路径没有必要完全相同,因为每台机器的环境很可能是不一样的。但如果每台机器上的这个路径都是统一配置的话,会使工作变得简单一些。默认的情况下,它的值为file://${hadoop.tmp.dir}/dfs/data这个路径只能用于测试的目的,因为它很可能会丢失掉一些数据。所以这个值最好还是被覆盖。dfs.name.dir这是NameNode结点存储hadoop文件系统信息的本地系统路径。这个值只对NameNode有效,DataNode并不需要使用到它。上面对于/temp类型的警告,同样也适用于这里。在实际应用中,它最好被覆盖掉。

更多说明请参考hdfs-default.xml,包含配置文件所有配置项的说明和默认值。

4).修改mapred-site.xml:

$ cp/home/hadoop/hdfs/etc/hadoop/mapred-site.xml.template/home/hadoop/hdfs/etc/hadoop/mapred-site.xml

$ vim/home/hadoop/hdfs/etc/hadoop/mapred-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

常用配置项说明:

mapred.job.trackerJobTracker的主机(或者IP)和端口。

更多说明请参考mapred-default.xml,包含配置文件所有配置项的说明和默认值

5).修改yarn-site.xml:

$ vim/home/hadoop/hdfs/etc/hadoop/yarn-site.xml

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

常用配置项说明:

yarn.nodemanager.aux-services通过该配置,用户可以自定义一些服务

更多说明请参考yarn-default.xml,包含配置文件所有配置项的说明和默认值

6). 修改 hadoop-env.sh:

$ sudo vim/home/hadoop/hdfs/etc/hadoop/hadoop-env.sh

修改 JAVA_HOME 如下:

exportJAVA_HOME=/usr/lib/jvm/java-8-oracle

exportHADOOP_CONF_DIR=/home/hadoop/hdfs/etc/hadoop

这样简单的伪分布式模式就配置好了。

三、格式化HDFS文件系统

在使用hadoop前,必须格式化一个全新的HDFS安装,通过创建存储目录和NameNode持久化数据结构的初始版本,格式化过程创建了一个空的文件系统。由于NameNode管理文件系统的元数据,而DataNode可以动态的加入或离开集群,因此这个格式化过程并不涉及DataNode。同理,用户也无需关注文件系统的规模。集群中DataNode的数量决定着文件系统的规模。DataNode可以在文件系统格式化之后的很长一段时间内按需增加。

3.1 格式化HDFS文件系统

$ hadoop namenode -format

会输出如下信息,则表格式化HDFS成功:

DEPRECATED: Use ofthisscript to execute hdfs commandisdeprecated.

Instead use the hdfs commandforit.

INFO namenode.NameNode: STARTUP_MSG:/************************************************************

STARTUP_MSG: Starting NameNode

STARTUP_MSG: host = [你的主机名]/[你的ip]

STARTUP_MSG: args = [-format]

STARTUP_MSG: version = 2.7.6

...

...

INFO util.GSet: Computing capacity for map NameNodeRetryCache

INFO util.GSet: VM type = 64-bit

INFO util.GSet: 0.029999999329447746% max memory 889 MB = 273.1 KB

INFO util.GSet: capacity = 2^15 = 32768 entries

INFO namenode.NNConf: ACLs enabled? false

INFO namenode.NNConf: XAttrs enabled? true

INFO namenode.NNConf: Maximum size of an xattr: 16384

INFO namenode.FSImage: Allocated new BlockPoolId: BP-549895748-192.168.42.3-1489569976471

INFO common.Storage: Storage directory /home/hadoop/hadop2.6-tmp/dfs/name has been successfully formatted.

INFO namenode.NNStorageRetentionManager: Going to retain 1 images with txid >= 0

NFO util.ExitUtil: Exiting with status 0

INFO namenode.NameNode: SHUTDOWN_MSG:

/************************************************************

SHUTDOWN_MSG: Shutting down NameNode at [你的主机名]//[你的ip]

************************************************************/

hadoop@c81af9a07ade:/opt/hadoop-2.7.6/bin$ jps

四、Hadoop集群启动

4.1 启动hdfs守护进程,分别启动NameNode和DataNode

$ start-dfs.sh

输出如下(可以看出分别启动了namenode, datanode, secondarynamenode,因为我们没有配置secondarynamenode,所以地址为0.0.0.0):

Starting namenodeson[]

hadoop@localhost'spassword:

localhost: starting namenode, loggingto/usr/local/hadoop/logs/hadoop-hadoop-namenode-G470.out

hadoop@localhost'spassword:

localhost: starting datanode, loggingto/usr/local/hadoop/logs/hadoop-hadoop-datanode-G470.out

localhost: OpenJDK64-BitServer VMwarning: You have loadedlibrary/usr/local/hadoop/lib/native/libhadoop.so.1.0.0which might have disabled stack guard. The VM will trytofix the stack guard now.

localhost: It'shighly recommended that you fix thelibrarywith'execstack-c <libfile>',orlink itwith'-z noexecstack'.

Starting secondary namenodes [0.0.0.0]

hadoop@0.0.0.0'spassword:

0.0.0.0: starting secondarynamenode, loggingto/usr/local/hadoop/logs/hadoop-hadoop-secondarynamenode-G470.out

4.2 启动yarn,使用如下命令启ResourceManager和NodeManager:

$ start-yarn.sh

4.3 检查是否运行成功

打开浏览器

- 输入:

http://localhost:8088进入ResourceManager管理页面 - 输入:

http://localhost:50070进入HDFS页面

可能出现的问题及调试方法:

启动伪分布后,如果活跃节点显示为零,说明伪分布没有真正的启动。原因是有的时候数据结构出现问题会造成无法启动datanode。如果使用hadoop namenode -format重新格式化仍然无法正常启动,原因是/tmp中的文件没有清除,则需要先清除/tmp/hadoop/*再执行格式化,即可解决hadoop datanode无法启动的问题。具体步骤如下所示:

# 删除hadoop:/tmp

$ hadoop fs -rmr /tmp

# 停止hadoop

$ stop-all.sh

# 删除/tmp/hadoop*

$ rm -rf /tmp/hadoop*

# 格式化

$ hadoop namenode -format

# 启动hadoop

$ start-all.sh

五、测试验证

测试验证还是使用上一节的 WordCount。

不同的是,这次是伪分布模式,使用到了 hdfs,因此我们需要把文件拷贝到 hdfs 上去。

首先创建相关文件夹(要一步一步的创建):

$ hadoop dfs -mkdir /user$ hadoop dfs -mkdir /user/hadoop$ hadoop dfs -mkdir /user/hadoop/input创建多层目录的简便方法:

$ hadoop dfs -mkdir-p /user/hadoop/input

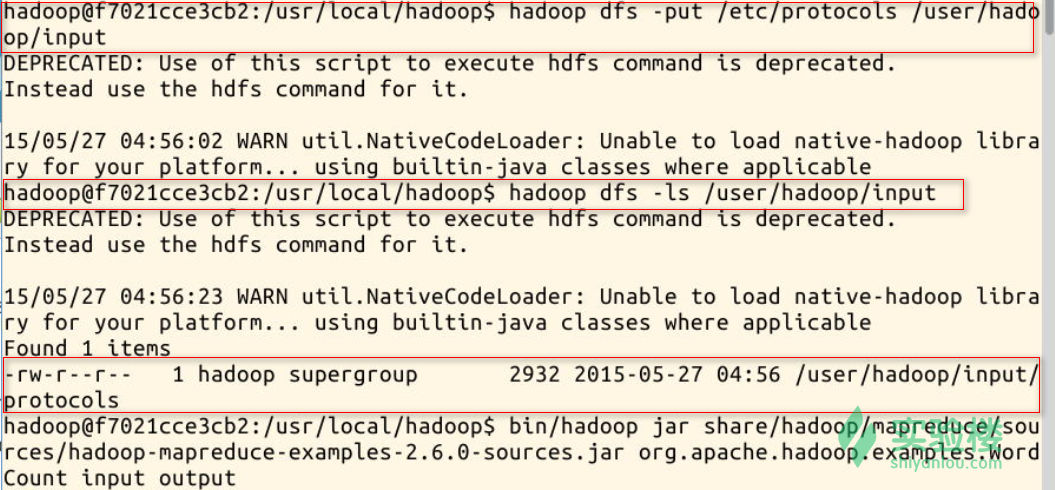

5.1 创建输入的数据,采用/etc/protocols文件作为测试

先将文件拷贝到 hdfs 上:

$ hadoop dfs -put/etc/protocols/user/hadoop/input

5.2 执行Hadoop WordCount应用(词频统计)

# 如果存在上一次测试生成的output,由于hadoop的安全机制,直接运行可能会报错,所以请手动删除上一次生成的output文件夹

$ hadoop jar/home/hadoop/hdfs/share/hadoop/mapreduce/sources/hadoop-mapreduce-examples-2.7.6-sources.jar wordcount/user/hadoop/input output

执行过程截图(部分):

5.3 查看生成的单词统计数据

$ hadoop dfs -cat/user/hadoop/output/*

六、关闭服务

$ stop-dfs.sh

$ stop-yarn.sh

七、小结

本实验讲解如何在单机模式下继续部署Hadoop为伪分布模式。

八、思考题

伪分布模式和单机模式配置上的区别主要是哪些?是否可以推论出如何部署真实的分布式Hadoop环境?

九、参考文档

本实验参考下列文档内容制作:

实验楼练习平台:http://www.shiyanlou.com/register?inviter=NTY0MzE5NjA1NjM3

3-2 Hadoop集群伪分布模式配置部署的更多相关文章

- Spark新手入门——2.Hadoop集群(伪分布模式)安装

主要包括以下三部分,本文为第二部分: 一. Scala环境准备 查看 二. Hadoop集群(伪分布模式)安装 三. Spark集群(standalone模式)安装 查看 Hadoop集群(伪分布模式 ...

- 3-3 Hadoop集群完全分布式配置部署

Hadoop集群完全分布式配置部署 下面的部署步骤,除非说明是在哪个服务器上操作,否则默认为在所有服务器上都要操作.为了方便,使用root用户. 1.准备工作 1.1 centOS6服务器3台 手动指 ...

- Hadoop伪分布模式配置部署

.实验环境说明 注意:本实验需要按照上一节单机模式部署后继续进行操作 1. 环境登录 无需密码自动登录,系统用户名 shiyanlou,密码 shiyanlou 2. 环境介绍 本实验环境采用带桌面的 ...

- 使用Docker搭建Hadoop集群(伪分布式与完全分布式)

之前用虚拟机搭建Hadoop集群(包括伪分布式和完全分布式:Hadoop之伪分布式安装),但是这样太消耗资源了,自学了Docker也来操练一把,用Docker来构建Hadoop集群,这里搭建的Hado ...

- 一脸懵逼学习基于CentOs的Hadoop集群安装与配置

1:Hadoop分布式计算平台是由Apache软件基金会开发的一个开源分布式计算平台.以Hadoop分布式文件系统(HDFS)和MapReduce(Google MapReduce的开源实现)为核心的 ...

- 一脸懵逼学习基于CentOs的Hadoop集群安装与配置(三台机器跑集群)

1:Hadoop分布式计算平台是由Apache软件基金会开发的一个开源分布式计算平台.以Hadoop分布式文件系统(HDFS)和MapReduce(Google MapReduce的开源实现)为核心的 ...

- 大数据中Hadoop集群搭建与配置

前提环境是之前搭建的4台Linux虚拟机,详情参见 Linux集群搭建 该环境对应4台服务器,192.168.1.60.61.62.63,其中60为主机,其余为从机 软件版本选择: Java:JDK1 ...

- Hadoop集群_Hadoop安装配置

1.集群部署介绍 1.1 Hadoop简介 Hadoop是Apache软件基金会旗下的一个开源分布式计算平台.以Hadoop分布式文件系统(HDFS,Hadoop Distributed Filesy ...

- Spark在Hadoop集群上的配置(spark-1.1.0-bin-hadoop2.4)

运行Spark服务,需要在每个节点上部署Spark. 可以先从主节点上将配置修改好,然后把Spark直接scp到其他目录. 关键配置 修改conf/spark-env.sh文件: export JAV ...

随机推荐

- java:构造方法:无参构造/有参构造 this static关键字 静态变量 静态方法 代码块 封装 静态常量。

/*构造方法是一种特殊的方法,专门用于构造/实例化对象,形式:[修饰符] 类名(){ }构造方法根据是否有参数分为无参构造和有参构造*/public class Dog { ...

- 解决springboot启动失败问题:Unable to start embedded container;

将一个springboot项目导入到eclipse后,启动时报错Unable to start embedded container,以下时全部错误信息: Application startup fa ...

- 怎么给PDF去除页眉页脚

PDF文件我们现在都会使用到,但有时需编辑PDF文件的时候,小伙伴们都知道该怎么操作吗,不知道的小伙伴不用担心,今天小编就来跟大家分享一下怎么删除PDF文件的页眉页脚,我们一起来看看下面的文章吧 操作 ...

- leetcode python快乐数

编写一个算法来判断一个数是不是“快乐数” “快乐数”的定义为:对于一个正整数,每一次将该数替换为它每个位置上的数字的平方和,然后重复该过程直到为1,也可能是无限循环但始终变不到1. 如果可以变为1,那 ...

- Node.js 操作 OSX 系统麦克风、扬声器音量

最近几年 Electron 很火,公司也正好有个项目想做跨平台客户端,大家研究了一下就选择了 Electron,第一次做 js 的项目遇到了不少坑,不过也都一点点解决了. 因为项目中需要对用户录音,H ...

- golang channel string 信号乱码

原因golang代码编写是允许在同一个for select代码结构中使用相同的变量名,这样会造成运行时chan发送的内容出现乱码现象,乱码率大概在98%左右,所以这是一个坑,希望大家别重复踩坑.以下是 ...

- SVM原理 (转载)

1. 线性分类SVM面临的问题 有时候本来数据的确是可分的,也就是说可以用 线性分类SVM的学习方法来求解,但是却因为混入了异常点,导致不能线性可分,比如下图,本来数据是可以按下面的实线来做超平面分离 ...

- Axure RP 8 软件介绍

介绍 此软件可以用于制作快速原型,也可以绘制中保真原型草图. 应用人群:产品经理.交互设计师.UI设计师.网页设计师. 原型分类:低保真(手绘草图).中保真(使用相关软件绘制出来的).高保真(包含效果 ...

- npm 安装cnpm淘宝镜像时报错解决

详细报错 D:\workspace\es61> npm install -g cnpm --registry=https://registry.npm.taobao.org npm WARN d ...

- Run Keyword And Ignore Error,Run Keyword And Return Status,Run Keyword And Continue On Failure,Run Keyword And Expect Error,Wait Until Keyword Succeeds用法

*** Test Cases ***case1 #即使错误也继续执行,也不记录失败,且可以返回执行状态和错误信息 ${Run Keyword And Ignore Error status} ${st ...