数据分析--降维--LDA和PCA

一、因子分析

因子分析是将具有错综复杂关系的变量(或样本)综合为少数几个因子,以再现原始变量和因子之间的相互关系,探讨多个能够直接测量,并且具有一定相关性的实测指标是如何受少数几个内在的独立因子所支配,并且在条件许可时借此尝试对变量进行分类。

因子分析的基本思想

根据变量间相关性的大小把变量分组,使得同组内的变量之间的相关性(共性)较高,并用一个公共因子来代表这个组的变量,而不同组的变量相关性较低(个性)。

因子分析的目的¶

因子分析的目的,通俗来讲就是简化变量维数。即要使因素结构简单化,希望以最少的共同因素(公共因子),能对总变异量作最大的解释,因而抽取得因子越少越好,但抽取的因子的累积解释的变异量越大越好。

主要内容:

(1):主成分分析 PCA

(2):线性判别分析 LDA

二、主成分分析 PCA

1、PCA

英语全称:Principal Component Analysis

用途:降维中最常用的一种手段

目标:提取最有价值的信息(基于方差)

问题:降维后的数据的意义?

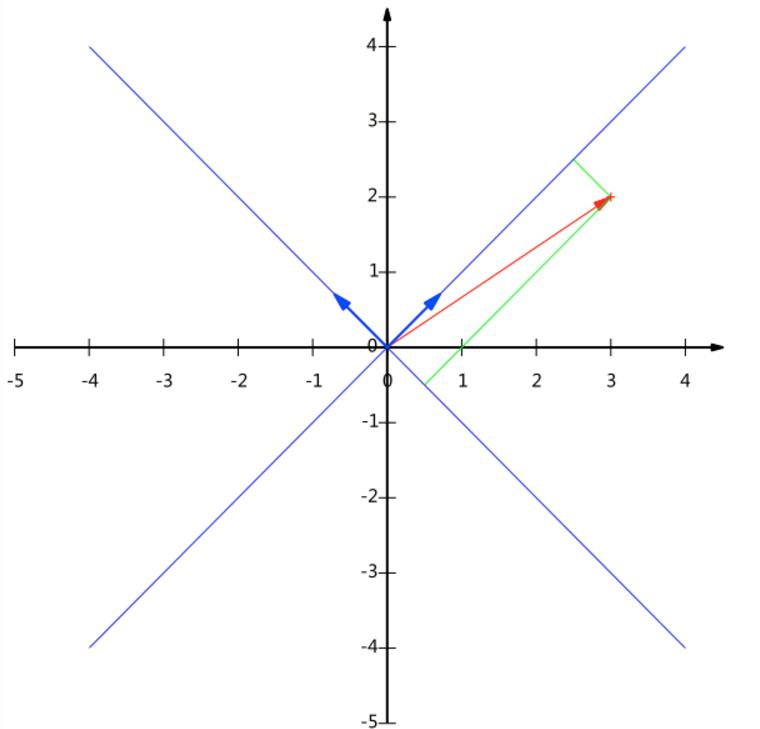

2、向量的表示及基变换

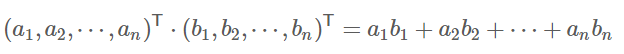

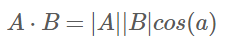

内积:

解释:

设向量B的模为1,则A与B的内积值等于A向B所在直线投影的矢量长度

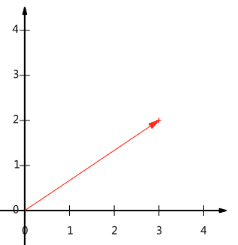

向量可以表示为(3,2)实际上表示线性组合:

基:(1,0)和(0,1)叫做二维空间中的一组基

基变换

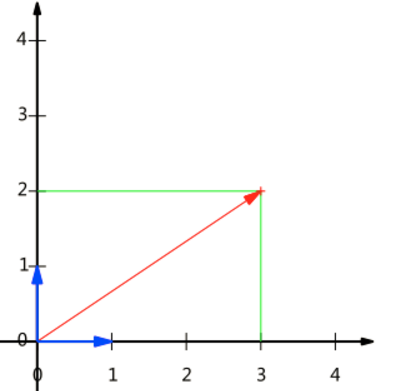

基是正交的(即内积为0,或直观说相互垂直)

要求:线性无关

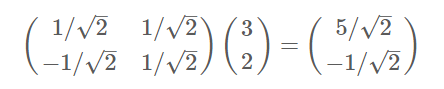

变换: 数据与一个基做内积运算,结果作为第一个新的坐标分量,然后与第二个基做内积运算,结果作为第二个新坐标的分量

数据(3,2)映射到基中坐标:

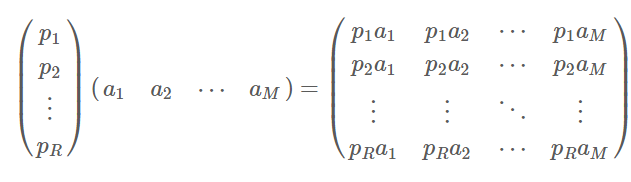

两个矩阵相乘的意义是将右边矩阵中的每一列列向量变换到左边矩阵中每一行行向量为基所表示的空间中去

协方差矩阵

方向:如何选择这个方向(或者说基)才能尽量保留最多的原始信息呢?

一种直观的看法是:希望投影后的投影值尽可能分散

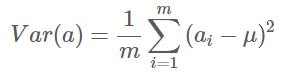

方差 :

寻找一个一维基,使得所有数据变换为这个基上的坐标表示后,方差值最大

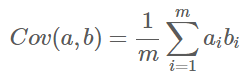

协方差(假设均值为0时):

协方差

如果单纯只选择方差最大的方向,后续方向应该会和方差最大的方向接近重合。

解决方案:为了让两个字段尽可能表示更多的原始信息,我们是不希望它们之间存在(线性)相关性的

协方差:可以用两个字段的协方差表示其相关性:

当协方差为0时,表示两个字段完全独立。为了让协方差为0,选择第二个基时只能在与第一个基正交的方向上选择。因此最终选择的两个方向一定是正交的。

优化目标

将一组N维向量降为K维(K大于0,小于N),目标是选择K个单位正交基,使原始数据变换到这组基上后,各字段两两间协方差为0,字段的方差则尽可能大

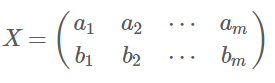

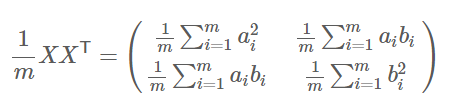

协方差矩阵:

矩阵对角线上的两个元素分别是两个字段的方差,而其它元素是a和b的协方差。

协方差矩阵对角化:即除对角线外的其它元素化为0,并且在对角线上将元素按大小从上到下排列

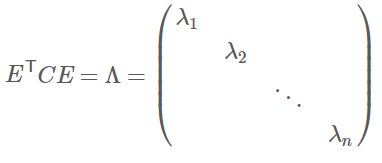

协方差矩阵对角化:

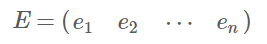

实对称矩阵:一个n行n列的实对称矩阵一定可以找到n个单位正交特征向量

实对称阵可进行对角化:

根据特征值的从大到小,将特征向量从上到下排列,则用前K行组成的矩阵乘以原始数据矩阵X,就得到了我们需要的降维后的数据矩阵Y

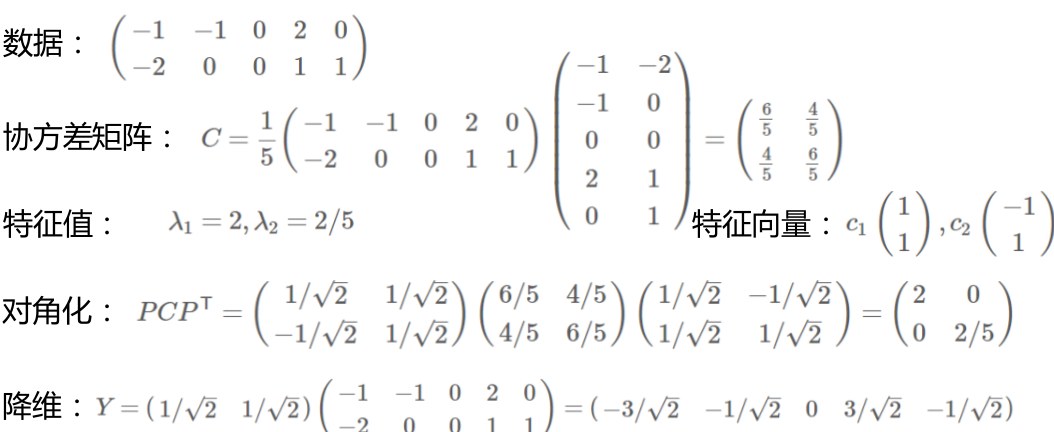

PCA实例

三、主成分分析 LDA

1、LDA

全称为:Linear Discriminant Analysis

用途:数据预处理中的降维,分类任务

历史:Ronald A. Fisher在1936年提出了线性判别方法

目标:LDA关心的是能够最大化类间区分度的坐标轴成分

将特征空间(数据集中的多维样本)投影到一个维度更小的 k 维子空间中,同时保持区分类别的信息

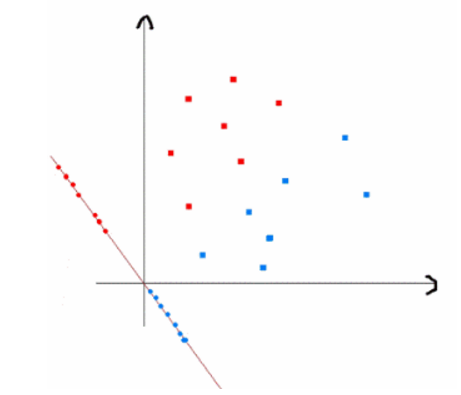

原理:投影到维度更低的空间中,使得投影后的点,会形成按类别区分,一簇一簇的情况,相同类别的点,将会在投影后的空间中更接近方法

监督性:LDA是“有监督”的,它计算的是另一类特定的方向

投影:找到更合适分类的空间

与PCA不同,更关心分类而不是方差

2、数学原理

目标: 找到该投影

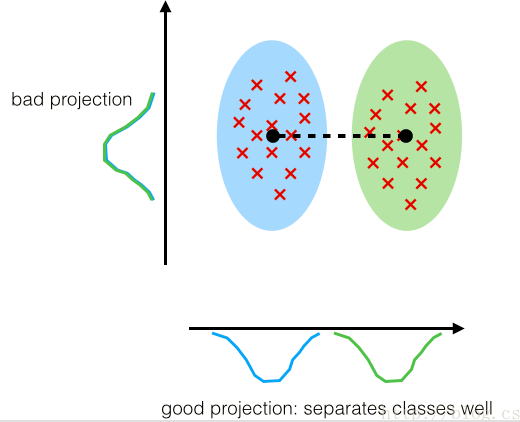

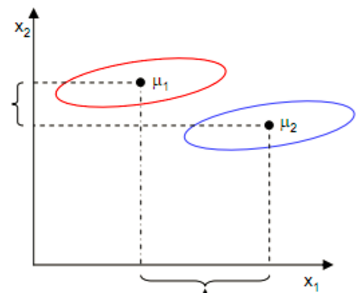

LDA分类的一个目标是使得不同类别之间的距离越远越好,同一类别之中的距离越近越好

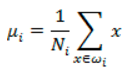

每类样例的均值:

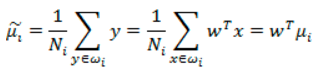

投影后的均值:

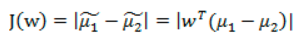

投影后的两类样本中心点尽量分离:

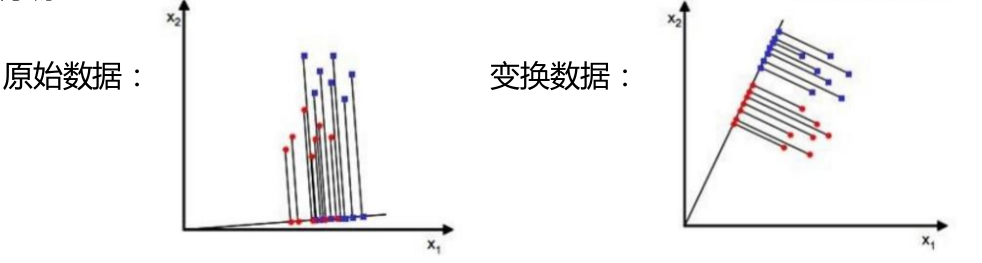

对于下图:

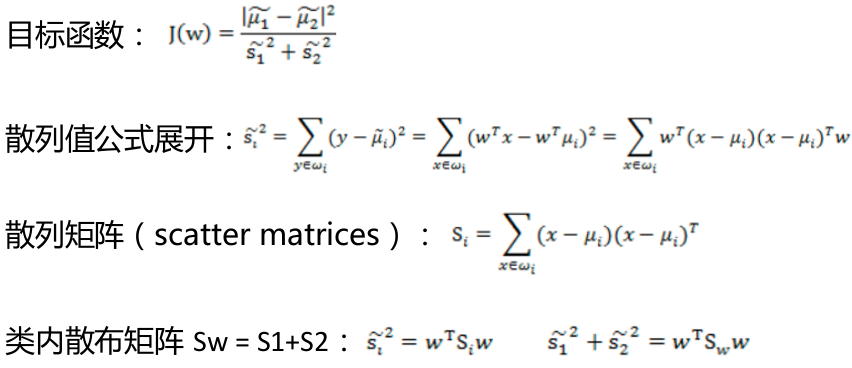

只最大化J(w)就可以了?

X1的方向可以最大化J(w),但是却分的不好

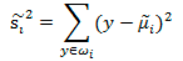

散列值:样本点的密集程度,值越大,越分散,反之,越集中

同类之间应该越密集些:

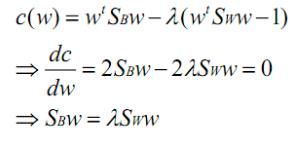

分母进行归一化:如果分子、分母是都可以取任意值的,那就会使得有无穷解,我们将分母限制为长度为1

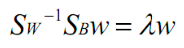

拉格朗日乘子法:

两边都乘以Sw的逆:

可见,w就是矩阵 的特征向量了

的特征向量了

数据分析--降维--LDA和PCA的更多相关文章

- 四大机器学习降维算法:PCA、LDA、LLE、Laplacian Eigenmaps

四大机器学习降维算法:PCA.LDA.LLE.Laplacian Eigenmaps 机器学习领域中所谓的降维就是指采用某种映射方法,将原高维空间中的数据点映射到低维度的空间中.降维的本质是学习一个映 ...

- 特征向量、特征值以及降维方法(PCA、SVD、LDA)

一.特征向量/特征值 Av = λv 如果把矩阵看作是一个运动,运动的方向叫做特征向量,运动的速度叫做特征值.对于上式,v为A矩阵的特征向量,λ为A矩阵的特征值. 假设:v不是A的速度(方向) 结果如 ...

- LDA和PCA降维的原理和区别

LDA算法的主要优点有: 在降维过程中可以使用类别的先验知识经验,而像PCA这样的无监督学习则无法使用类别先验知识. LDA在样本分类信息依赖均值而不是方差的时候,比PCA之类的算法较优. LDA算 ...

- 机器学习(十六)— LDA和PCA降维

一.LDA算法 基本思想:LDA是一种监督学习的降维技术,也就是说它的数据集的每个样本是有类别输出的.这点和PCA不同.PCA是不考虑样本类别输出的无监督降维技术. 我们要将数据在低维度上进行投影,投 ...

- 线性模型之LDA和PCA推导

线性模型之LDA和PCA 线性判别分析LDA LDA是一种无监督学习的降维技术. 思想:投影后类内方差最小,类间方差最大,即期望同类实例投影后的协方差尽可能小,异类实例的投影后的类中心距离尽量大. 二 ...

- 【降维】主成分分析PCA推导

本博客根据 百面机器学习,算法工程师带你去面试 一书总结归纳,公式都是出自该书. 本博客仅为个人总结学习,非商业用途,侵删. 网址 http://www.ptpress.com.cn 目录: PCA最 ...

- 【转】四大机器学习降维算法:PCA、LDA、LLE、Laplacian Eigenmaps

最近在找降维的解决方案中,发现了下面的思路,后面可以按照这思路进行尝试下: 链接:http://www.36dsj.com/archives/26723 引言 机器学习领域中所谓的降维就是指采用某种映 ...

- 降维算法整理--- PCA、KPCA、LDA、MDS、LLE 等

转自github: https://github.com/heucoder/dimensionality_reduction_alo_codes 网上关于各种降维算法的资料参差不齐,同时大部分不提供源 ...

- 机器学习笔记----四大降维方法之PCA(内带python及matlab实现)

大家看了之后,可以点一波关注或者推荐一下,以后我也会尽心尽力地写出好的文章和大家分享. 本文先导:在我们平时看NBA的时候,可能我们只关心球员是否能把球打进,而不太关心这个球的颜色,品牌,只要有3D效 ...

随机推荐

- 从窗口句柄得到菜单句柄(从HWND得到HMENU)

1. 如果HWND是主窗口,可以使用API: GetMenu(...) 得到属于主窗口的句柄,原型如下: HMENU GetMenu(HWND hWnd); 在MFC中原型如下: CMenu* Get ...

- 测试一下你的T-SQL基础知识-subquery

一直以为自己SQL挺好的,没有想到今天在重构存储过程遇到了一个子查询的问题,修改为自连接之后发现居然结果不对,于是有了下面的测试.假设表中有如下数数据,请问Query1,Query2,Query3的查 ...

- 一起学习MVC(4)Controllers的学习

控制器Controllers Controllers为控制器文档,AccountControllers内的方法对应View→Account下的cshtml文件. 我们看到Aco ...

- 万恶的KPI、新兴的OKR及让人纠结的程序员考核

最近两天在研究研发部门如何进行绩效管理(其实一直都在思考,关注,实践,总感觉无从下手,也想求助咨询公司,无奈囊中羞涩).查了两天的资料,主要的方向是KPI,OKR,谷歌等互联网公司的考核方法.这里做个 ...

- 基于C#语言MVC框架Aspose.Cells控件导出Excel表数据

控件bin文件下载地址:https://download.csdn.net/download/u012949335/10610726 @{ ViewBag.Title = "xx" ...

- kernel 调试 打印IP地址

#define NIPQUAD(addr) \ ((unsigned char *)&addr)[0], \ ((unsigned char *)&addr)[1], \ ((unsi ...

- C++ malloc 和 new 的函数说明

malloc 和 new 一些不同点 1. 数组变量的申请 int *p = (int *) malloc (sizeof(int) * 5); if(p==NUILL) return; free ...

- docker 运行容器,安装Nginx

########################################## #运行容器 #安装Nginx #搜索.下载镜像 docker search nginx docker pull n ...

- Python面向对象(成员修饰符)

day25 成员修饰符 class Foo: def __init__(self, name, age): self.name = name self.__age = age#私有,外部无法直接访问 ...

- about BFC

https://www.cnblogs.com/lhb25/p/inside-block-formatting-ontext.html Box.Formatting Context(BFC)