BeautifulSoup与aiohttp的简单应用-爬取《网上中华五千年》音频

香港电台的节目素质都比较不错,其中有个《中华五千年》的节目是以情景剧与旁白的形式来展示历史故事,由传说时代一直到民国,1983年首播至2000年,非常长寿的一个节目。网上能找到版本声音非常模糊,不过在其《网上中华五千年》的网站上可以在线收听所有节目。虽然可以在线听,但要science上网,而且在线听中断了就不能再续着听,很难受。因此,就想到利用Python来的爬虫来把节目都下载下来慢慢听。

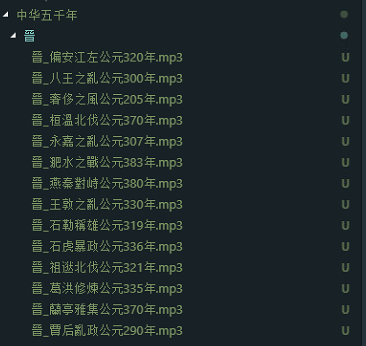

分析Html页面

在浏览器打开审查元素找到音频的链接标签,发现链接都在class为.listen-button的a标签里。只要定位到这个标签,取出text作为文件名,href作为下载url就可以了。

代码实现

代码很简单,首先,主体结构是这样的:

'''

下载中华五千年

'''

from bs4 import BeautifulSoup

import requests,urllib,re

import time

import aiohttp

import asyncio

import os async def main():

start_page = 1

while True:

url = 'http://rthk9.rthk.hk/chiculture/fivethousandyears/subpage{0}.htm'.format(start_page)

soup = await getUrl(url) #取html内容

if not soup.title: return #直到无内容退出

title = soup.title.text

title = title[title.rfind(' ')+1:]

listenbutton = soup.select(".listen-button") #查出所有.listen-button类的标签

#根据title 创建相应的文件夹

rootPath = './中华五千年/'

if not os.path.exists(rootPath + title):

os.makedirs(rootPath + title) for l in listenbutton:

if l.text != "":

href = l['href']

filename = str(title) +'_' + str(l.text)

if filename.find('公元') > -1

await download(filename=filename,url=href,title=title) #下载语音

start_page += 1 #下一页 asyncio.run(main())

其中异步函数(协程)getUrl :

async def getUrl(url):

async with aiohttp.ClientSession() as session:

#因需science上网所以需要本地代理

async with session.get(url,proxy='http://127.0.0.1:1080') as resp:

wb_data = await resp.text()

soup = BeautifulSoup(wb_data,'lxml')

return soup

异步下载语音函数 download:

async def download(url,filename,title):

file_name = './中华五千年/{0}/{1}'.format(title,filename + '.mp3')

async with aiohttp.ClientSession() as session:

async with session.get(url,proxy='http://127.0.0.1:1080') as resp:

with open(file_name, 'wb') as fd:

while True:

chunk = await resp.content.read()

if not chunk:

break

fd.write(chunk)

由于用了异步IO的方式,很快便可以下载完一页。

BeautifulSoup与aiohttp的简单应用-爬取《网上中华五千年》音频的更多相关文章

- Python超简单的爬取网站中图片

1.首先导入相关库 import requests import bs4 import threading #用于多线程爬虫,爬取速度快,可以完成多页爬取 import os 2.使用bs4获取htm ...

- 使用webmagic爬虫对百度百科进行简单的爬取

分析要爬取的网页源码: 1.打开要分析的网页,查看源代码,找到要爬取的内容: (选择网页里的一部分右击审查元素也行) 2.导入jar包,这个就直接去网上下吧: 3.写爬虫: package com.g ...

- web scraper——简单的爬取数据【二】

web scraper——安装[一] 在上文中我们已经安装好了web scraper现在我们来进行简单的爬取,就来爬取百度的实时热点吧. http://top.baidu.com/buzz?b=1&a ...

- Python爬取网上车市[http://www.cheshi.com/]的数据

#coding:utf8 #爬取网上车市[http://www.cheshi.com/]的数据 import requests, json, time, re, os, sys, time,urlli ...

- 【Python数据分析】简单爬虫 爬取知乎神回复

看知乎的时候发现了一个 “如何正确地吐槽” 收藏夹,里面的一些神回复实在很搞笑,但是一页一页地看又有点麻烦,而且每次都要打开网页,于是想如果全部爬下来到一个文件里面,是不是看起来很爽,并且随时可以看到 ...

- 12月4日学习爬虫007.使用Urllib模块进行简单网页爬取

笔记如下: 1.https是http加强版协议(安全协议)http(普通网络通信协议) 爬数据 如果爬https发现和理想中的数据不同,可以改为http 直接去掉s即可 2.使用Urllib爬取简单网 ...

- 【Python】简单实现爬取小说《天龙八部》,并在页面本地访问

背景 很多人说学习爬虫是提升自己的一个非常好的方法,所以有了第一次使用爬虫,水平有限,依葫芦画瓢,主要作为学习的记录. 思路 使用python的requests模块获取页面信息 通过re模块(正则表达 ...

- python简单爬虫爬取百度百科python词条网页

目标分析:目标:百度百科python词条相关词条网页 - 标题和简介 入口页:https://baike.baidu.com/item/Python/407313 URL格式: - 词条页面URL:/ ...

- Python爬虫之简单的爬取百度贴吧数据

首先要使用的第类库有 urllib下的request 以及urllib下的parse 以及 time包 random包 之后我们定义一个名叫BaiduSpider类用来爬取信息 属性有 url: ...

随机推荐

- ES6之箭头函数深入理解

相对于普通函数的区别 新的书写方式 this 的改变 不能当构造函数 没有 prototype 属性 没有 arguments 对象 新的书写方式 书写方式很简单!直接看下图, 常规方式写一个函数 c ...

- 各大版本idea永久破解激活方法

文章转载自:https://www.jiweichengzhu.com/article/a45902a1d7284c6291fe32a4a199e65c 如果还有问题,加群交流:686430774(就 ...

- 使用selesium和pytesseract识别验证码,达到登录网页目的

关于验证码问题,大多可以在网上了解到目前有四种解决方案:1.开发注释验证码2.开发开一个“后门”,设置一个万能码,输入万能码则通过3.通过cookies绕过验证码4.图形识别技术 前三种是比较快速也是 ...

- 改变UITabbar顶部分割线颜色

项目中是使用UITabbarController 因此改变UITabbar的分割线代码如下 由于美术没提供图片,所以自己创建了个图片 //改变tabbar 线条颜色 CGRect rect = CGR ...

- 《对“XXX::Invoke”类型的已垃圾回收委托进行了回调。这可能会导致应用程序崩溃、损坏和数据丢失。向非托管代码传递委托时,托管应用程序必须让这些委托保持活动状态,直到确信不会再次调用它们》的问题的解决方法

<对“XXX::Invoke”类型的已垃圾回收委托进行了回调.这可能会导致应用程序崩溃.损坏和数据丢失.向非托管代码传递委托时,托管应用程序必须让这些委托保持活动状态,直到确信不会再次调用它们& ...

- AtCoder Grand Contest 012 A

A - AtCoder Group Contest Time limit : 2sec / Memory limit : 256MB Score : 300 points Problem Statem ...

- Mysql的查询语句(联合查询、连接查询、子查询等)

Mysql的各个查询语句(联合查询.连接查询.子查询等) 一.联合查询 关键字:union 语法形式 select语句1 union[union选项] select 语句2 union[union选项 ...

- 常用的DOCS命令

1.Help 可以查看当前DOS常用命令,是帮助2.Help dir 查看Dir命令的帮助,使用帮助3.ipconfig 查看当前电脑的IP地址4.ping 127.0.0.1 测试与某一台电脑之间网 ...

- 在sz

在大城市,sz, 每天骑单车去公交车站. 每天用高德地图 坐快线巴士 车上下班要3个小时. 用guomei 的回收管家 回收 旧空调. 我在kfc 看书 在班车上睡觉/眯眼 在办公室睡觉,看书,工作 ...

- string类常用方法3