使用JAVA爬取网页图片

经过之前的HttpURLConnection还有各种流的结束,已经可以开始理解怎么下载网页上的一张图片了。

对各种流不理解的话,可以翻翻前面的随笔,讲得都比较详细。在此就不细讲了。

主要流程:

1、HttpURLConnection连接上图片的网址,打开一个InputStream。

2、把InputStream的内容读取到ByteArrayOutputStream中,此时ByteArrayOutputStream存储了图片数据的byte数组。

3、通过文件流,把byte数据填充到一个jpg文件中。

代码非常简单:

String strUrl = "http://ww4.sinaimg.cn/mw1024/005vbOHfgw1eylg2gnnrlj30ia0s87ac.jpg";

//构造URL

URL url = new URL(strUrl);

//构造连接

HttpURLConnection conn = (HttpURLConnection)url.openConnection();

//这个网站要模拟浏览器才行

conn.setRequestProperty("User-Agent","Mozilla/5.0 (Windows NT 6.3; WOW64; Trident/7.0; rv:11.0) like Gecko");

//打开连接

conn.connect();

//打开这个网站的输入流

InputStream inStream = conn.getInputStream();

//用这个做中转站 ,把图片数据都放在了这里,再调用toByteArray()即可获得数据的byte数组

ByteArrayOutputStream outStream = new ByteArrayOutputStream();

//用这个是很好的,不用一次就把图片读到了文件中

//要是需要把图片用作其他用途呢?所以直接把图片的数据弄成一个变量,十分有用

//相当于操作这个变量就能操作图片了

byte [] buf = new byte[1024];

//为什么是1024?

//1024Byte=1KB,分配1KB的缓存

//这个就是循环读取,是一个临时空间,多大都没关系

//这没有什么大的关系,你就是用999这样的数字也没有问题,就是每次读取的最大字节数。

//byte[]的大小,说明你一次操作最大字节是多少

//虽然读的是9M的文件,其实你的内存只用1M来处理,节省了很多空间.

//当然,设得小,说明I/O操作会比较频繁,I/O操作耗时比较长,

//这多少会有点性能上的影响.这看你是想用空间换时间,还是想用时间换空间了.

//时间慢总比内存溢出程序崩溃强.如果内存足够的话,我会考虑设大点.

int len = 0;

//读取图片数据

while((len=inStream.read(buf))!=-1){

System.out.println(len);

outStream.write(buf,0,len);

}

inStream.close();

outStream.close();

//把图片数据填入文件中

File file = new File("t.jpg");

FileOutputStream op = new FileOutputStream(file);

op.write(outStream.toByteArray());

op.close();

}

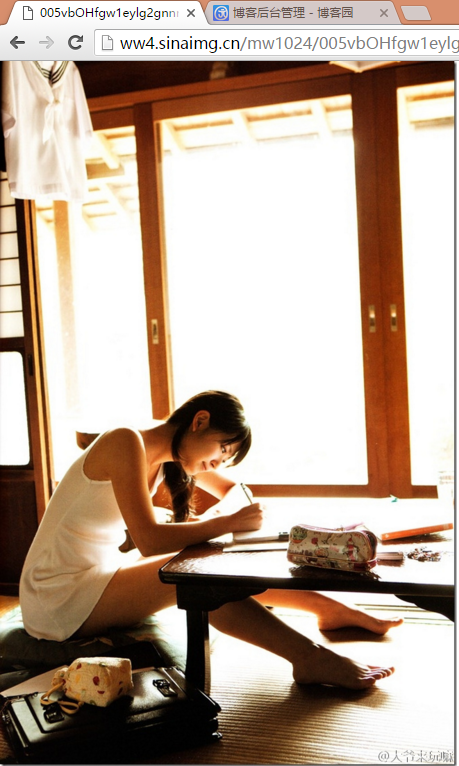

效果图:

使用JAVA爬取网页图片的更多相关文章

- java爬虫-简单爬取网页图片

刚刚接触到“爬虫”这个词的时候是在大一,那时候什么都不明白,但知道了百度.谷歌他们的搜索引擎就是个爬虫. 现在大二.再次燃起对爬虫的热爱,查阅资料,知道常用java.python语言编程,这次我选择了 ...

- python requests库爬取网页小实例:爬取网页图片

爬取网页图片: #网络图片爬取 import requests import os root="C://Users//Lenovo//Desktop//" #以原文件名作为保存的文 ...

- node:爬虫爬取网页图片

代码地址如下:http://www.demodashi.com/demo/13845.html 前言 周末自己在家闲着没事,刷着微信,玩着手机,发现自己的微信头像该换了,就去网上找了一下头像,看着图片 ...

- erlang 爬虫——爬取网页图片

说起爬虫,大家第一印象就是想到了python来做爬虫.其实,服务端语言好些都可以来实现这个东东. 在我们日常上网浏览网页的时候,经常会看到一些好看的图片,我们就希望把这些图片保存下载,或者用户用来做桌 ...

- Python3批量爬取网页图片

所谓爬取其实就是获取链接的内容保存到本地.所以爬之前需要先知道要爬的链接是什么. 要爬取的页面是这个:http://findicons.com/pack/2787/beautiful_flat_ico ...

- Java爬取 百度图片Google图片Bing图片

先看看抓取的结果. 8个Java类: Startup.java - main函数 ImageCrawler.java - Crawler基类 BaiduImageCrawler.java - 百度图片 ...

- 利用Python爬取网页图片

最近几天,研究了一下一直很好奇的爬虫算法.这里写一下最近几天的点点心得.下面进入正文: 你可能需要的工作环境: Python 3.6官网下载 我们这里以sogou作为爬取的对象. 首先我们进入搜狗图片 ...

- python爬取网页图片(二)

从一个网页爬取图片已经解决,现在想要把这个用户发的图片全部爬取. 首先:先找到这个用户的发帖页面: http://www.acfun.cn/u/1094623.aspx#page=1 然后从这个页面中 ...

- java 抓取网页图片

import java.io.File; import java.io.FileOutputStream; import java.io.InputStream; import java.io.Out ...

随机推荐

- TCP和Http的区别!(转) 真心有帮助!!!

一.From:http://thisliy.javaeye.com/blog/710122 http://wenku.baidu.com/view/14a30d0102020740be1e9b84.h ...

- Hosts文件路径及修改方法

(转自:http://www.techolics.com/softdev/20111029_100.html) 什么是Hosts文件? 根据百度百科的定义,Hosts文件是一个系统文件,这是一个本地的 ...

- 剑指offer--23.合并两个排序的链表

时间限制:1秒 空间限制:32768K 热度指数:421239 本题知识点: 链表 题目描述 输入两个单调递增的链表,输出两个链表合成后的链表,当然我们需要合成后的链表满足单调不减规则. class ...

- New Concept English three (35)

27 55 The word justice is usually associated with courts of law. We might say that justice has been ...

- html 压缩成一行

文章java gulp-htmlmin 减少下载的时间

- canvas 绘制图像

结果: 代码: <!DOCTYPE html> <html> <head lang="en"> <meta charset="U ...

- js将json数据动态生成表格

今天开发中遇到需要展示动态数据的问题, 具体要求是后端传来的json字符串,要在前端页面以table表格的形式展示, 其实没啥难的,就是拼接table标签,纯属体力活,于是自己写了个呆萌,保存起来,以 ...

- Is possible develop iOS game with Delphi Xe4 ? Pascal

下面的计划: 评估用Delphi XE4来开发游戏的可行性. 以及成本. (代价过大的话 估计还是不会被接受 所以某个角度来说这是个玩具) . 有几个选择, Asphyre 4.0 之后作者lifep ...

- MyBatis典型的错误org.apache.ibatis.binding.BindingException: Invalid bound statement (not found)

XXXmapper.java(接口) XXXmapper.xml(结果集映射) //此两个文件要在统一包下,且xml中的namespace是唯一的,为了区分须写成 该xml的全路径

- tp_link无线路由器台式机无法上网

昨天一个朋友问我为什么他买的无线路由器连到电脑上面以后不能上网,不过无线很正常,手机等无线设备都能够上网,但是家里的台式机却无法上网.估计很多朋友都遇到过这样的问题,其实问题很多简单.下面就来介绍一下 ...