spark学习5(hbase集群搭建)

第一步:Hbase安装

hadoop,zookeeper前面都安装好了

将hbase-1.1.3-bin.tar.gz上传到/usr/HBase目录下

[root@spark1 HBase]# chmod u+x hbase-1.1.3-bin.tar.gz[root@spark1 HBase]# tar -zxvf hbase-1.1.3-bin.tar.gz[root@spark1 HBase]# mv hbase-1.1.3 hbase-1.1[root@spark1 ~]# vi/etc/profile #配置环境变量export HBASE_HOME=/usr/HBase/hbase-1.1export PATH=$PATH:$HBASE_HOME/bin[root@spark1 ~]# source /etc/profile #使其生效

第二步:修改配置文件

编辑 hbase-env.xml

[root@spark1 conf]# vi hbase-env.sh# The java implementation to use. Java 1.7+ required.export JAVA_HOME=/usr/java/jdk# Extra Java CLASSPATH elements. Optional.export HBASE_CLASSPATH=/usr/HBase/hbase-1.1/conf# Tell HBase whether it should manage it's own instance of Zookeeper or not.export HBASE_MANAGES_ZK=false 使用HBASE自带的zookeeper管理集群用true,自己安装的用false

编辑 hbase-site.xml

[root@spark1 hbase-1.1]# mkdir tmp

[root@spark1 hbase-1.1]# cd conf[root@spark1 conf]# vi hbase-site.xml<property><name>hbase.tmp.dir</name><value>/usr/HBase/hbase-1.1/tmp</value></property><!-- 指定hbase在HDFS上存储的路径 --><property><name>hbase.rootdir</name><value>hdfs://spark1:9000/hbase</value></property><!-- 打开 hbase 分布模式 --><property><name>hbase.cluster.distributed</name><value>true</value></property><!-- 指定zk的地址,多个用“,”分割 --><property><name>hbase.zookeeper.quorum</name><value>spark1,spark2,spark3</value></property>

编辑 regionservers

[root@spark1 conf]# vi regionservers #添加从节点spark2spark3

第三步:搭建hbase集群

[root@spark1 usr]# scp -r HBase root@spark2:/usr/[root@spark1 usr]# scp -r HBase root@spark3:/usr/[root@spark1 ~]# scp -r /etc/profile root@spark2:/etc/[root@spark1 ~]# scp -r /etc/profile root@spark3:/etc/[root@spark2 ~]# source /etc/profile[root@spark3 ~]# source /etc/profile

第四步:启动 / 关闭 Hbase 数据库集群

启动前我先把hadoop启动和zookeeper启动

[root@spark1 ~]# zkServer.sh start #三个节点都要启动[root@spark1 ~]# zkServer.sh status #查看是否启动成功[root@spark1 ~]# start-all.sh #启动hadoop[root@spark1 ~]# start-hbase.sh[root@spark1 ~]# stop-hbase.sh

第五步:验证启动

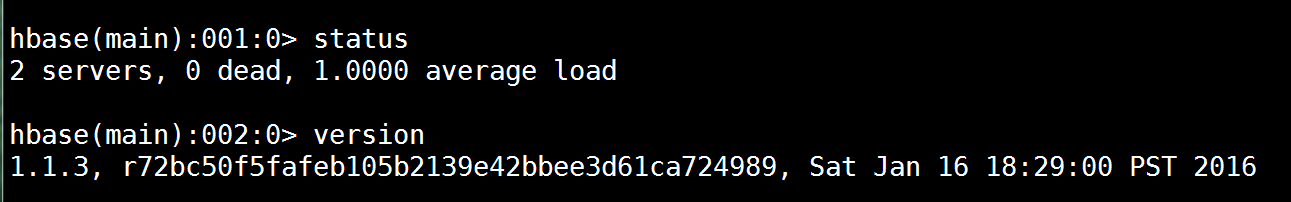

查看jps和hbase shell

[root@spark1 ~]# jps[root@spark1 ~]# hbase shellstatus #查看状态version #查看版本

spark学习5(hbase集群搭建)的更多相关文章

- 高可用Hadoop平台-HBase集群搭建

1.概述 今天补充一篇HBase集群的搭建,这个是高可用系列遗漏的一篇博客,今天抽时间补上,今天给大家介绍的主要内容目录如下所示: 基础软件的准备 HBase介绍 HBase集群搭建 单点问题验证 截 ...

- HBase集群搭建

HBase集群搭建 搭建环境:假设我们的linux环境已经准备好,包括网络.JDK.防火墙.主机名.免密登录等都没有问题,而且一定要有zookeeper.下面我们用3台linux虚拟机来搭建Hbase ...

- Hadoop+HBase 集群搭建

Hadoop+HBase 集群搭建 1. 环境准备 说明:本次集群搭建使用系统版本Centos 7.5 ,软件版本 V3.1.1. 1.1 配置说明 本次集群搭建共三台机器,具体说明下: 主机名 IP ...

- 【原创 Hadoop&Spark 动手实践 5】Spark 基础入门,集群搭建以及Spark Shell

Spark 基础入门,集群搭建以及Spark Shell 主要借助Spark基础的PPT,再加上实际的动手操作来加强概念的理解和实践. Spark 安装部署 理论已经了解的差不多了,接下来是实际动手实 ...

- Spark学习之在集群上运行Spark(6)

Spark学习之在集群上运行Spark(6) 1. Spark的一个优点在于可以通过增加机器数量并使用集群模式运行,来扩展程序的计算能力. 2. Spark既能适用于专用集群,也可以适用于共享的云计算 ...

- Hbase集群搭建及所有配置调优参数整理及API代码运行

最近为了方便开发,在自己的虚拟机上搭建了三节点的Hadoop集群与Hbase集群,hadoop集群的搭建与zookeeper集群这里就不再详细说明,原来的笔记中记录过.这里将hbase配置参数进行相应 ...

- hbase集群搭建参考资料

hadoop分布式集群搭建 http://www.ityouknow.com/hadoop/2017/07/24/hadoop-cluster-setup.html hbase分布式集群搭建: htt ...

- 基于centos6.5 hbase 集群搭建

注意本章内容是在上一篇文章“基于centos6.5 hadoop 集群搭建”基础上创建的 1.上传hbase安装包 hbase-0.96.2-hadoop2 我的目录存放在/usr/hadoop/hb ...

- 大数据中HBase集群搭建与配置

hbase是分布式列式存储数据库,前提条件是需要搭建hadoop集群,需要Zookeeper集群提供znode锁机制,hadoop集群已经搭建,参考 Hadoop集群搭建 ,该文主要介绍Zookeep ...

随机推荐

- 48、ViewFlow ---- 滑动广告页

<!-- main.xml --> <?xml version="1.0" encoding="utf-8"?> <LinearL ...

- Android实现splash

笔者近日遇到一个android中双splash的问题.要求先实现百度的logo,在接入自己的logo. public class MainActivity extends BaseActivity { ...

- mysql_表_操作

1.创建表 # 基本语法: create table 表名( 列名 类型 是否可以为空 默认值 自增 主键, 列名 类型 是否可以为空 )ENGINE=InnoDB DEFAULT CHARSET=u ...

- 客户端-服务器通信安全 sign key

API接口签名校验,如何安全保存appsecret? - 知乎 https://www.zhihu.com/question/40855191 要保证一般的客户端-服务器通信安全,可以使用3个密钥. ...

- DIV背景图片

.bigY{ position:absolute; width:95px; height:93px; visibility:visible; right: 277 ...

- SQL Server 2008 收缩日志 清空删除大日志文件

SQL2008 的收缩日志 由于SQL2008对文件和日志管理进行了优化,所以以下语句在SQL2005中可以运行但在SQL2008中已经被取消: (SQL2005) BackupLog DNName ...

- 前端基础 & Bootstrap框架

Bootstrap介绍 Bootstrap是Twitter开源的基于HTML.CSS.JavaScript的前端框架. 它是为实现快速开发Web应用程序而设计的一套前端工具包. 它支持响应式布局,并且 ...

- P2P-BT对端管理协议(附BT协议1.0)

对端管理 指的是远端peer集合的管理(尽管自身client也能够视为一个peer.但对端管理不包括自身peer) 一个client(client)必须维持与每一个远程peer连接的状态信息,即1V1 ...

- selenium 用autoIT上传下载文件

一.下载安装AutoIT 下载并安装AutoIT,下载链接:https://www.autoitscript.com/site/autoit/ AutoIT安装成功后,可以在开始菜单下看到AutoIT ...

- ELBO 与 KL散度

浅谈KL散度 一.第一种理解 相对熵(relative entropy)又称为KL散度(Kullback–Leibler divergence,简称KLD),信息散度(information dive ...