6.2.2 辅助类GenericOptionsParser,Tool和ToolRunner深入解析

辅助类GenericOptionsParser,Tool和ToolRunner

(1)为什么要用ToolRunner

将MapReduce Job配置参数写到java代码里,一旦变更意味着修改java文件源码、编译、打包、部署一连串事情。当MapReduce 依赖配置文件的时候,你需要手工编写java代码使用DistributedCache将其上传到HDFS中,以便map和reduce函数可以读取。:当你的map或reduce 函数依赖第三方jar文件时,你在命令行中使用”-libjars”参数指定依赖jar包时,但根本没生效。Hadoop有个可以GenericOptionsParser是一个类,用来解释常用的Hadoop命令行选项,通过简单的命令行参数来实现这样的功能,为Configuration对象设置相应的取值。通常不直接使用GenericOptionsParser,更方便的方式是:实现Tool接口,通过ToolRunner来运行应用程序,ToolRunner内部调用GenericOptionsParser来解析命令行。设置Configuration对象。

(2)使用ToolRunner步骤

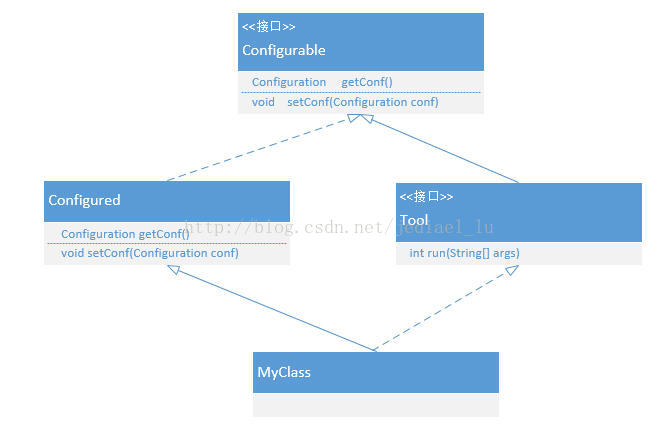

自定义一个ToolRunner类ToolRunnerDemo类,继承Configured类,实现Tool接口,实现Tool的run(String [] args)方法,并在main函数中调用ToolRunner. run(Tool tool, String[] args)静态方法。Run方法内部创建GenericOptionsParser parser = new GenericOptionsParser(conf, args);调用GenericOptionsParser解析命令行参数,解析完之后将参数设置到Configuration对象中。

1)创建ToolRunnerDemo对象

package org.jediael.hadoopdemo.toolrunnerdemo;

import java.util.Map.Entry;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.conf.Configured;

import org.apache.hadoop.util.Tool;

import org.apache.hadoop.util.ToolRunner;

public class ToolRunnerDemo extends Configured implements Tool {

static {

//Configuration.addDefaultResource("hdfs-default.xml");

//Configuration.addDefaultResource("hdfs-site.xml");

//Configuration.addDefaultResource("mapred-default.xml");

//Configuration.addDefaultResource("mapred-site.xml");

}

@Override

public int run(String[] args) throws Exception {

Configuration conf = getConf();

for (Entry<String, String> entry : conf) {

System.out.printf("%s=%s\n", entry.getKey(), entry.getValue());

}

return 0;

}

public static void main(String[] args) throws Exception {

int exitCode = ToolRunner.run(new ToolRunnerDemo(), args);//ToolRunnerDemo对象实现了Tool接口,形参传入对象引用,在调用tool.run()方法,实际是调用ToolRunner重写的run方法。

System.exit(exitCode);

}

}

Configurable接口只有两个函数,获取设置Configuration对象

package org.apache.hadoop.conf;

public interface Configurable {

void setConf(Configuration conf);

Configuration getConf();

}

Configred类实现了Configurable接口

package org.apache.hadoop.conf;

public class Configured implements Configurable {

private Configuration conf;

public Configured() {

this(null);

}

public Configured(Configuration conf) {

setConf(conf);

}

public void setConf(Configuration conf) {

this.conf = conf;

}

public Configuration getConf() {

return conf;

}

}

2)ToolRunner.run()函数内部创建GenericOptionsParser对象

public static int run(Configuration conf, Tool tool, String[] args) throws Exception {

if (conf == null) {

conf = new Configuration();

}

GenericOptionsParser parser = new GenericOptionsParser(conf, args);

tool.setConf(conf);

String[] toolArgs = parser.getRemainingArgs();

return tool.run(toolArgs);

}

3)GenericOptionsParser构造函数1调用构造函数2,构造函数2调用解析函数parseGeneralOptions

public GenericOptionsParser(Options opts, String[] args) throws IOException {

this(new Configuration(), opts, args);

}//构造函数1

public GenericOptionsParser(Configuration conf, Options options, String[] args) throws IOException {

this.parseGeneralOptions(options, conf, args);

this.conf = conf;

}//构造函数2

4)parseGeneralOptions先调用解析函数parser.parse解析命令行,然后再用函数this.processGeneralOptions()执行命令。

private void parseGeneralOptions(Options opts, Configuration conf, String[] args) throws IOException {

opts = buildGeneralOptions(opts);

GnuParser parser = new GnuParser();

try {

this.commandLine = parser.parse(opts, this.preProcessForWindows(args), true);

this.processGeneralOptions(conf, this.commandLine);

} catch (ParseException var7) {

LOG.warn("options parsing failed: " + var7.getMessage());

HelpFormatter formatter = new HelpFormatter();

formatter.printHelp("general options are: ", opts);

}

}

5)processGeneralOptions函数内部会根据不同的命令选项:fs、jt、conf、libjars、files、archives进行设置。

private void processGeneralOptions(Configuration conf, CommandLine line) throws IOException {

//设置默认的文件系统

if (line.hasOption("fs")) {

FileSystem.setDefaultUri(conf, line.getOptionValue("fs"));

}

//设置jobtracker服务ip地址和端口,用于监听并接收来自各个TaskTracker发送的心跳信息,包括资源使用情况和任务运行情况等信息。

String fileName;

if (line.hasOption("jt")) {

fileName = line.getOptionValue("jt");

if (fileName.equalsIgnoreCase("local")) {

conf.set("mapreduce.framework.name", fileName);

}

conf.set("yarn.resourcemanager.address", fileName, "from -jt command line option");

}

//添加新的配置文件

String[] arr$;

int len$;

int i$;

String prop;

String[] property;

if (line.hasOption("conf")) {

property = line.getOptionValues("conf");

arr$ = property;

len$ = property.length;

for(i$ = 0; i$ < len$; ++i$) {

prop = arr$[i$];

conf.addResource(new Path(prop));

}

}

//从本地文件系统中复制指定的jar包到jobtracker使用的共享文件系统中,添加到mapreduce任务路径,这个选项是一个很有用放入方法来添加任务的依赖jar包。

if (line.hasOption("libjars")) {

conf.set("tmpjars", this.validateFiles(line.getOptionValue("libjars"), conf), "from -libjars command line option");

URL[] libjars = getLibJars(conf);

if (libjars != null && libjars.length > 0) {

conf.setClassLoader(new URLClassLoader(libjars, conf.getClassLoader()));

Thread.currentThread().setContextClassLoader(new URLClassLoader(libjars, Thread.currentThread().getContextClassLoader()));

}

}

//从本地文件系统中复制指定的文件到jobtracker使用的共享文件系统中,使他们能够被mapreduce任务使用

if (line.hasOption("files")) {

conf.set("tmpfiles", this.validateFiles(line.getOptionValue("files"), conf), "from -files command line option");

}

//从本地文件系统中复制指定的档案到jobtracker使用的共享文件系统中,使他们能够被mapreduce任务使用。

if (line.hasOption("archives")) {

conf.set("tmparchives", this.validateFiles(line.getOptionValue("archives"), conf), "from -archives command line option");

}

//给属性设置属性值

if (line.hasOption('D')) {

property = line.getOptionValues('D');

arr$ = property;

len$ = property.length;

for(i$ = 0; i$ < len$; ++i$) {

prop = arr$[i$];

String[] keyval = prop.split("=", 2);

if (keyval.length == 2) {

conf.set(keyval[0], keyval[1], "from command line");

}

}

}

conf.setBoolean("mapreduce.client.genericoptionsparser.used", true);

if (line.hasOption("tokenCacheFile")) {

fileName = line.getOptionValue("tokenCacheFile");

FileSystem localFs = FileSystem.getLocal(conf);

Path p = localFs.makeQualified(new Path(fileName));

if (!localFs.exists(p)) {

throw new FileNotFoundException("File " + fileName + " does not exist.");

}

if (LOG.isDebugEnabled()) {

LOG.debug("setting conf tokensFile: " + fileName);

}

UserGroupInformation.getCurrentUser().addCredentials(Credentials.readTokenStorageFile(p, conf));

conf.set("mapreduce.job.credentials.json", p.toString(), "from -tokenCacheFile command line option");

}

}

6)设置好配置之后,所有的命令行都解析执行,参数都添加到了Configuration对象之中,接下来就可以获取这些参数。

在第2)步的ToolRunner的run函数中

public static int run(Configuration conf, Tool tool, String[] args) throws Exception {

if (conf == null) {

conf = new Configuration();

}

GenericOptionsParser parser = new GenericOptionsParser(conf, args);

tool.setConf(conf);

String[] toolArgs = parser.getRemainingArgs();

return tool.run(toolArgs);

}

parser.getRemainingArgs();获取的实际上是第4)步中解析的命令行参数

public String[] getRemainingArgs() {

return this.commandLine == null ? new String[0] : this.commandLine.getArgs();

}

7)调用tool接口的run方法,实际是调用ToolRunnerDemo重写的run方法。因为ToolRunnerDemo对象实现了Tool接口,ToolRunner.run函数形参传入ToolRunnerDemo对象引用,在调用tool.run()方法, 实际是调用ToolRunnerDemo重写的run方法。

@Override

public int run(String[] args) throws Exception {

Configuration conf = getConf();

for (Entry<String, String> entry : conf) {//输出所有的属性值

System.out.printf("%s=%s\n", entry.getKey(), entry.getValue());

}

return 0;

}

(3)使用ToolRunnerDemo设置hadoop参数调用实例

1)使用ToolRunnerDemo输出所有配置属性

[root@jediael project]#hadoop jar toolrunnerdemo.jar org.jediael.hadoopdemo.toolrunnerdemo.ToolRunnerDemo

io.seqfile.compress.blocksize=1000000

keep.failed.task.files=false

mapred.disk.healthChecker.interval=60000

dfs.df.interval=60000

dfs.datanode.failed.volumes.tolerated=0

mapreduce.reduce.input.limit=-1

mapred.task.tracker.http.address=0.0.0.0:50060

mapred.used.genericoptionsparser=true

mapred.userlog.retain.hours=24

dfs.max.objects=0

mapred.jobtracker.jobSchedulable=org.apache.hadoop.mapred.JobSchedulable

mapred.local.dir.minspacestart=0

hadoop.native.lib=true

2)通过-D指定新的参数,-D设置参数color为yello,grep查看设置属性

[root@jediael project]# hadoop org.jediael.hadoopdemo.toolrunnerdemo.ToolRunnerDemo -D color=yello | grep color

color=yello

3)通过-conf增加新的配置文件,-conf用于添加配置文件,wc命令用于查看配置数量。

hadoop jar toolrunnerdemo.jar org.jediael.hadoopdemo.toolrunnerdemo.ToolRunnerDemo-conf /opt/jediael/hadoop-1.2.0/conf/mapred-site.xml | wc

68 68 3028

其中mapred-site.xml的内容如下:

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>

(4)ToolRunner使用汇总

|

-D color=yello |

-D设置参数color为yello,grep查看设置属性 |

|

-conf conf/mapred-site.xml |

-conf用于添加配置文件 |

|

-fs uri |

//设置文件系统为uri指定的路径,等同-D fs.default.FS=url |

|

-jt 10.21.34.11:3800 |

//hadoop1中用于设置jobtracker的ip地址和端口,用于监听并接收来自各个TaskTracker发送的心跳信息,包括资源使用情况和任务运行情况等信息。hadoop2中用于指定YARN资源管理器地址。等同-D yarn.resourcemanager.address= 10.21.34.11:3800. |

|

-files file1,file2 |

从本地文件系统中复制指定的文件到jobtracker使用的共享文件系统中,使他们能够被mapreduce任务使用 |

|

-libjars jars1,jars2 |

从本地文件系统中复制指定的jar包到jobtracker使用的共享文件系统中,添加到mapreduce任务路径,这个选项是一个很有用放入方法来添加任务的依赖jar包。 |

|

-archives archive1,archive2 |

从本地文件系统中复制指定的档案到jobtracker使用的共享文件系统中,使他们能够被mapreduce任务使用。 |

参考文献:

https://blog.csdn.net/xin15200793067/article/details/12623797

https://blog.csdn.net/jediael_lu/article/details/38751885

https://blog.csdn.net/tototuzuoquan/article/details/72856761

自己开发了一个股票智能分析软件,功能很强大,需要的点击下面的链接获取:

https://www.cnblogs.com/bclshuai/p/11380657.html

6.2.2 辅助类GenericOptionsParser,Tool和ToolRunner深入解析的更多相关文章

- 关于Tool接口--------hadoop接口:extends Configured implements Tool 和 ToolRunner.run

我们在写Hadoop--map/reduce程序时,遇到使用按文件url来分析文件----------多表连接的DistributedCache方式,看不懂使用extends Configured i ...

- MapReduce编程实战之“调试”和"调优"

本篇内容 在上一篇的"初识"环节,我们已经在本地和Hadoop集群中,成功的执行了几个MapReduce程序,对MapReduce编程,已经有了最初的理解. 在本篇文章中,我们对M ...

- 使用ToolRunner运行Hadoop程序基本原理分析

为了简化命令行方式运行作业,Hadoop自带了一些辅助类.GenericOptionsParser是一个类,用来解释常用的Hadoop命令行选项,并根据需要,为Configuration对象设置相应的 ...

- 采用ToolRunner执行Hadoop基本面分析程序

为了简化执行作业的命令行.Hadoop它配备了一些辅助类.GenericOptionsParser它是一类.经常用来解释Hadoop命令行选项,并根据需要.至Configuration采取相应的对象设 ...

- 使用ToolRunner运行Hadoop程序基本原理分析 分类: A1_HADOOP 2014-08-22 11:03 3462人阅读 评论(1) 收藏

为了简化命令行方式运行作业,Hadoop自带了一些辅助类.GenericOptionsParser是一个类,用来解释常用的Hadoop命令行选项,并根据需要,为Configuration对象设置相应的 ...

- 解析GenericOptionsParser

hadoop源代码分析(4)-org.apache.hadoop.util包-GenericOptionsParser类[原创] 一 准备 hadoop版本:1.0.3,GenericOptio ...

- hadoop MapReduce 笔记

1. MapReduce程序开发步骤 编写map 和 reduce 程序–> 单元测试 -> 编写驱动程序进行验证-> 本地数据集调试 -> 部署到集群运行 用 ...

- Nutch源码阅读进程1---inject

最近在Ubuntu下配置好了nutch和solr的环境,也用nutch爬取了一些网页,通过solr界面呈现,也过了一把自己建立小搜索引擎的瘾,现在该静下心来好好看看nutch的源码了,先从Inject ...

- 《Hadoop权威》学习笔记五:MapReduce应用程序

一.API的配置---Configuration类 API的配置:Hadoop提供了专门的API对资源进行配置,Configuration类的实例(在org.apache.hadoop.conf包)包 ...

随机推荐

- 数据挖掘:关联规则的apriori算法在weka的源码分析

相对于机器学习,关联规则的apriori算法更偏向于数据挖掘. 1) 测试文档中调用weka的关联规则apriori算法,如下 try { File file = new File("F:\ ...

- [NOIp2018] luogu P5020 货币系统

还在补暑假作业. 题目描述 你有一个由 NNN 种面值的货币组成的货币系统.定义两个货币系统等价,当且仅当 ∀x∈N∗\forall x\in\N^*∀x∈N∗ 要么同时能被两个货币系统表示,要么同时 ...

- sql事务的使用及其技巧整理

sql事务的使用及其技巧整理 概述: 在实际项目开发中,为了确保数据操作结果的一致性等要求,事务是一个必不可少的解决利器. 根据SQLSERVER实现原理,其实,SQLSERVER的每一条执行语句都是 ...

- JetBrains系列软件激活码

T3ACKYHDVF-eyJsaWNlbnNlSWQiOiJUM0FDS1lIRFZGIiwibGljZW5zZWVOYW1lIjoi5bCP6bifIOeoi+W6j+WRmCIsImFzc2lnb ...

- xss姿势利用

1.定位页面可以出现xss的位置 可能会出现联合点利用 一个页面多个存储位置或者一个页面多个参数联合利用 例如输入xss 查看页面源码页面里有多个xss 或者多个参数显示 可以利用 需要注意的是有的是 ...

- jmeter打印变量的三种方式

1.使用Debug Sampler 2.使用log打印到jemter日志 3.使用System.out.println打印到cmd命令行

- mongodb学习笔记系列一

一.简介和安装 ./bin/mongod --dbpath /path/to/database --logpath /path/to/log --fork --port 27017 mongodb非常 ...

- 楼上请让路 RoarCTF2019 Writeup

Misc 签到题 RoarCTF{签到!!!} 黄金六年 文件尾部有一段base64,解码为16进制可以看到是一个压缩包 打开压缩包需要密码 使用pr抽帧 可以看到部分帧中有二维码,依次扫码即可得到k ...

- 微信小程序自定义弹窗(可通用)

效果图 .wxml <cover-view class='mask' wx:if='{{isShow}}'> <cover-view class='modal'> <co ...

- 使用 statcounter 统计 Hexo 博客访问量

介绍 statcounter是一个提供网站访问统计服务的网站: StatCounter is a simple but powerful real-time web analytics service ...