O2O场景下的推荐排序模型:

推荐系统遇上深度学习(五)--Deep&Cross Network模型理论和实践

推荐系统遇上深度学习系列:

推荐系统遇上深度学习(一)--FM模型理论和实践:https://www.jianshu.com/p/152ae633fb00

推荐系统遇上深度学习(二)--FFM模型理论和实践:https://www.jianshu.com/p/781cde3d5f3d

推荐系统遇上深度学习(三)--DeepFM模型理论和实践:

https://www.jianshu.com/p/6f1c2643d31b

推荐系统遇上深度学习(四)--多值离散特征的embedding解决方案:https://www.jianshu.com/p/4a7525c018b2

1、原理

Deep&Cross Network模型我们下面将简称DCN模型:

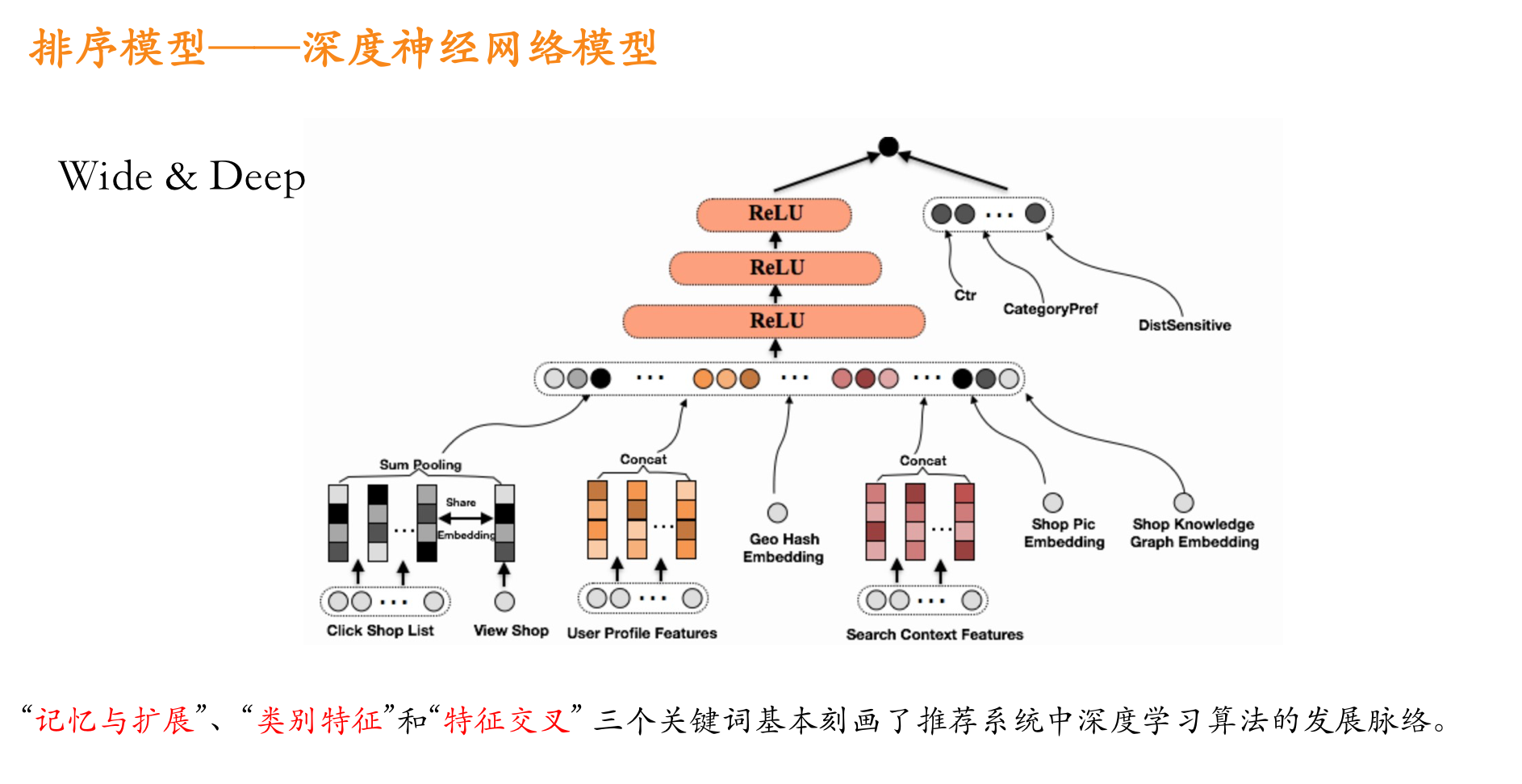

一个DCN模型从嵌入和堆积层开始,接着是一个交叉网络和一个与之平行的深度网络,之后是最后的组合层,它结合了两个网络的输出。完整的网络模型如图:

嵌入和堆叠层

我们考虑具有离散和连续特征的输入数据。在网络规模推荐系统中,如CTR预测,输入主要是分类特征,如“country=usa”。这些特征通常是编码为独热向量如“[ 0,1,0 ]”;然而,这往往导致过度的高维特征空间大的词汇。

为了减少维数,我们采用嵌入过程将这些离散特征转换成实数值的稠密向量(通常称为嵌入向量):

然后,我们将嵌入向量与连续特征向量叠加起来形成一个向量:

拼接起来的向量X0将作为我们Cross Network和Deep Network的输入

Cross Network

交叉网络的核心思想是以有效的方式应用显式特征交叉。交叉网络由交叉层组成,每个层具有以下公式:

一个交叉层的可视化如图所示:

可以看到,交叉网络的特殊结构使交叉特征的程度随着层深度的增加而增大。多项式的最高程度(就输入X0而言)为L层交叉网络L + 1。如果用Lc表示交叉层数,d表示输入维度。然后,参数的数量参与跨网络参数为:d * Lc * 2 (w和b)

交叉网络的少数参数限制了模型容量。为了捕捉高度非线性的相互作用,模型并行地引入了一个深度网络。

Deep Network

深度网络就是一个全连接的前馈神经网络,每个深度层具有如下公式:

Combination Layer

链接层将两个并行网络的输出连接起来,经过一层全链接层得到输出:

如果采用的是对数损失函数,那么损失函数形式如下:

总结

DCN能够有效地捕获有限度的有效特征的相互作用,学会高度非线性的相互作用,不需要人工特征工程或遍历搜索,并具有较低的计算成本。

论文的主要贡献包括:

1)提出了一种新的交叉网络,在每个层上明确地应用特征交叉,有效地学习有界度的预测交叉特征,并且不需要手工特征工程或穷举搜索。

2)跨网络简单而有效。通过设计,各层的多项式级数最高,并由层深度决定。网络由所有的交叉项组成,它们的系数各不相同。

3)跨网络内存高效,易于实现。

4)实验结果表明,交叉网络(DCN)在LogLoss上与DNN相比少了近一个量级的参数量。

这个是从论文中翻译过来的,哈哈。

2、实现解析

本文的代码根据之前DeepFM的代码进行改进,我们只介绍模型的实现部分,其他数据处理的细节大家可以参考我的github上的代码:

https://github.com/princewen/tensorflow_practice/tree/master/Basic-DCN-Demo

数据下载地址:https://www.kaggle.com/c/porto-seguro-safe-driver-prediction

不去下载也没关系,我在github上保留了几千行的数据用作模型测试。

模型输入

模型输入

模型的输入主要有下面几个部分:

self.feat_index = tf.placeholder(tf.int32,

shape=[None,None],

name='feat_index')

self.feat_value = tf.placeholder(tf.float32,

shape=[None,None],

name='feat_value')

self.numeric_value = tf.placeholder(tf.float32,[None,None],name='num_value')

self.label = tf.placeholder(tf.float32,shape=[None,1],name='label')

self.dropout_keep_deep = tf.placeholder(tf.float32,shape=[None],name='dropout_deep_deep')可以看到,这里与DeepFM相比,一个明显的变化是将离散特征和连续特征分开,连续特征不在转换成embedding进行输入,所以我们的输入共有五部分。

feat_index是离散特征的一个序号,主要用于通过embedding_lookup选择我们的embedding。feat_value是对应离散特征的特征值。numeric_value是我们的连续特征值。label是实际值。还定义了两个dropout来防止过拟合。

权重构建

权重主要包含四部分,embedding层的权重,cross network中的权重,deep network中的权重以及最后链接层的权重,我们使用一个字典来表示:

def _initialize_weights(self):

weights = dict()

#embeddings

weights['feature_embeddings'] = tf.Variable(

tf.random_normal([self.cate_feature_size,self.embedding_size],0.0,0.01),

name='feature_embeddings')

weights['feature_bias'] = tf.Variable(tf.random_normal([self.cate_feature_size,1],0.0,1.0),name='feature_bias')

#deep layers

num_layer = len(self.deep_layers)

glorot = np.sqrt(2.0/(self.total_size + self.deep_layers[0]))

weights['deep_layer_0'] = tf.Variable(

np.random.normal(loc=0,scale=glorot,size=(self.total_size,self.deep_layers[0])),dtype=np.float32

)

weights['deep_bias_0'] = tf.Variable(

np.random.normal(loc=0,scale=glorot,size=(1,self.deep_layers[0])),dtype=np.float32

)

for i in range(1,num_layer):

glorot = np.sqrt(2.0 / (self.deep_layers[i - 1] + self.deep_layers[i]))

weights["deep_layer_%d" % i] = tf.Variable(

np.random.normal(loc=0, scale=glorot, size=(self.deep_layers[i - 1], self.deep_layers[i])),

dtype=np.float32) # layers[i-1] * layers[i]

weights["deep_bias_%d" % i] = tf.Variable(

np.random.normal(loc=0, scale=glorot, size=(1, self.deep_layers[i])),

dtype=np.float32) # 1 * layer[i]

for i in range(self.cross_layer_num):

weights["cross_layer_%d" % i] = tf.Variable(

np.random.normal(loc=0, scale=glorot, size=(self.total_size,1)),

dtype=np.float32)

weights["cross_bias_%d" % i] = tf.Variable(

np.random.normal(loc=0, scale=glorot, size=(self.total_size,1)),

dtype=np.float32) # 1 * layer[i]

# final concat projection layer

input_size = self.total_size + self.deep_layers[-1]

glorot = np.sqrt(2.0/(input_size + 1))

weights['concat_projection'] = tf.Variable(np.random.normal(loc=0,scale=glorot,size=(input_size,1)),dtype=np.float32)

weights['concat_bias'] = tf.Variable(tf.constant(0.01),dtype=np.float32)

return weights

计算网络输入

这一块我们要计算两个并行网络的输入X0,我们需要将离散特征转换成embedding,同时拼接上连续特征:

# model

self.embeddings = tf.nn.embedding_lookup(self.weights['feature_embeddings'],self.feat_index) # N * F * K

feat_value = tf.reshape(self.feat_value,shape=[-1,self.field_size,1])

self.embeddings = tf.multiply(self.embeddings,feat_value)

self.x0 = tf.concat([self.numeric_value,

tf.reshape(self.embeddings,shape=[-1,self.field_size * self.embedding_size])]

,axis=1)Cross Network

根据论文中的计算公式,一步步计算得到cross network的输出:

# cross_part

self._x0 = tf.reshape(self.x0, (-1, self.total_size, 1))

x_l = self._x0

for l in range(self.cross_layer_num):

x_l = tf.tensordot(tf.matmul(self._x0, x_l, transpose_b=True),

self.weights["cross_layer_%d" % l],1) + self.weights["cross_bias_%d" % l] + x_l

self.cross_network_out = tf.reshape(x_l, (-1, self.total_size))Deep Network

这一块就是一个多层全链接神经网络:

self.y_deep = tf.nn.dropout(self.x0,self.dropout_keep_deep[0])

for i in range(0,len(self.deep_layers)):

self.y_deep = tf.add(tf.matmul(self.y_deep,self.weights["deep_layer_%d" %i]), self.weights["deep_bias_%d"%i])

self.y_deep = self.deep_layers_activation(self.y_deep)

self.y_deep = tf.nn.dropout(self.y_deep,self.dropout_keep_deep[i+1])

Combination Layer

最后将两个网络的输出拼接起来,经过一层全链接得到最终的输出:

# concat_part

concat_input = tf.concat([self.cross_network_out, self.y_deep], axis=1)

self.out = tf.add(tf.matmul(concat_input,self.weights['concat_projection']),self.weights['concat_bias'])定义损失

这里我们可以选择logloss或者mse,并加上L2正则项:

# loss

if self.loss_type == "logloss":

self.out = tf.nn.sigmoid(self.out)

self.loss = tf.losses.log_loss(self.label, self.out)

elif self.loss_type == "mse":

self.loss = tf.nn.l2_loss(tf.subtract(self.label, self.out))

# l2 regularization on weights

if self.l2_reg > 0:

self.loss += tf.contrib.layers.l2_regularizer(

self.l2_reg)(self.weights["concat_projection"])

for i in range(len(self.deep_layers)):

self.loss += tf.contrib.layers.l2_regularizer(

self.l2_reg)(self.weights["deep_layer_%d" % i])

for i in range(self.cross_layer_num):

self.loss += tf.contrib.layers.l2_regularizer(

self.l2_reg)(self.weights["cross_layer_%d" % i])剩下的代码就不介绍啦!

好啦,本文只是提供一个引子,有关DCN的知识大家可以更多的进行学习呦。

参考文章:

1、https://blog.csdn.net/roguesir/article/details/79763204

2、论文:https://arxiv.org/abs/1708.05123

O2O场景下的推荐排序模型:的更多相关文章

- 美团在O2O场景下的广告营销

美团作为中国最大的在线本地生活服务平台,覆盖了餐饮.酒店.旅行.休闲娱乐.外卖配送等方方面面生活场景,连接了数亿用户和数百万商户.如何帮助本地商户开展在线营销,使得他们能快速有效地触达目标用户群体提升 ...

- Entity Framework:如果允许模型处于非法状态,在某些场景下,记得清空DbContext

Entity Framework:如果允许模型处于非法状态,在某些场景下,记得清空DbContext 背景 之前写过两篇文章介绍模型的合法性: DDD:关于模型的合法性,Entity.IsValid( ...

- 深度排序模型概述(一)Wide&Deep/xDeepFM

本文记录几个在广告和推荐里面rank阶段常用的模型.广告领域机器学习问题的输入其实很大程度了影响了模型的选择,因为输入一般维度非常高,稀疏,同时包含连续性特征和离散型特征.模型即使到现在DeepFM类 ...

- 大厂技术实现 | 腾讯信息流推荐排序中的并联双塔CTR结构 @推荐与计算广告系列

作者:韩信子@ShowMeAI,Joan@腾讯 地址:http://www.showmeai.tech/article-detail/tencent-ctr 声明:版权所有,转载请联系平台与作者并注明 ...

- CI Weekly #11 | 微服务场景下的自动化测试与持续部署

又一周过去了,最近我们的工程师正在搞一个"大事情" --「[flow.ci](http://flow.ci/?utm_source=bokeyuan&utm_medium= ...

- 亿级流量场景下,大型缓存架构设计实现【1】---redis篇

*****************开篇介绍**************** -------------------------------------------------------------- ...

- 10.多shard场景下relevence score可能不准确

主要知识点 多shard场景下relevence score可能不准确的原因 多shard场景下relevence score可能不准确解决方式 一.多shard场景下relevance sc ...

- 难道主键除了自增就是GUID?支持k8s等分布式场景下的id生成器了解下

背景 主键(Primary Key),用于唯一标识表中的每一条数据.所以,一个合格的主键的最基本要求应该是唯一性. 那怎么保证唯一呢?相信绝大部分开发者在刚入行的时候选择的都是数据库的自增id,因为这 ...

- 硬核测试:Pulsar 与 Kafka 在金融场景下的性能分析

背景 Apache Pulsar 是下一代分布式消息流平台,采用计算存储分层架构,具备多租户.高一致.高性能.百万 topic.数据平滑迁移等诸多优势.越来越多的企业正在使用 Pulsar 或者尝试将 ...

随机推荐

- LeetCode236. 二叉树的最近公共祖先

* @lc app=leetcode.cn id=236 lang=cpp * * [236] 二叉树的最近公共祖先 * * https://leetcode-cn.com/problems/ ...

- Shell编程——运算符

1.declare命令: 声明变量的类型: -:给变量设定类型属性 +:给变量取消类型属性 -i:将变量声明为整数类型 -x:将变量声明为环境变量 -p:显示变量的类型 其中export是将num变为 ...

- <LinkedList> 369 (高)143 (第二遍)142 148

369. Plus One Linked List 1.第1次while: 从前往后找到第一个不是9的位,记录. 2.第2次while: 此位+1,后面的所有值设为0(因为后面的位都是9). 返回时注 ...

- 【2019.8.9 慈溪模拟赛 T1】数论(a)(打表找规律)

莫比乌斯反演 血亏! 比赛时看到这题先写了个莫比乌斯反演,然后手造了几组数据和暴力对拍的时候发现,居然答案就是\(nm\)... 吐槽数据范围太小... 下面给上出题人对此题的解释: 原式的物理意义, ...

- jQuery 源码解析(七) jQuery对象和DOM对象的互相转换

jQuery对象是一个类数组对象,它保存的是对应的DOM的引用,我们可以直接用[]获取某个索引内的DOM节点,也可以用get方法获取某个索引内的DOM节点,还可以用toArray()方法把jQuery ...

- 如何安装redis

主要方式有四种:1.使用 Docker 安装.2.通过 Github 源码编译.3.直接安装 apt-get install(Ubuntu).yum install(RedHat) 或者 brew i ...

- 解决java,C#,php,python MD5加密不一致问题

JAVA写法 public static String md5Base64(final String str, final String key) throws Exception { if ((nu ...

- python随机选取目录下的若干个文件

个人记录用. python模块random argparse shutil import argparse parser = argparse.ArgumentParser() parser.add_ ...

- java架构之路-(mysql底层原理)Mysql索引和查询引擎

今天我们来说一下我们的mysql,个人认为现在的mysql能做到很好的优化处理,不比收费的oracle差,而且mysql确实好用. 当我们查询慢的时候,我会做一系列的优化处理,例如分库分表,加索引.那 ...

- UWP 推荐 - 限时免费的RSS阅读器《RSS 追踪》登录 Windows 10

文/云之幻 前不久,博客作者 Bravo Yeung 写了一篇还算略受欢迎的关于 RSS 的文章 .Net开发者必知的技术类RSS订阅指南. RSS 现在用的人很少了,而且就算是我,也不过是在一周前才 ...