Hbase(四) 过滤器查询

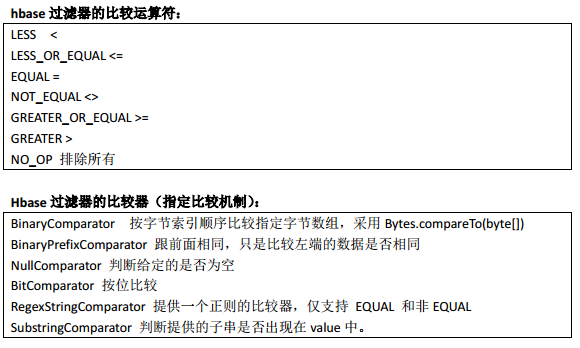

引言:过滤器的类型很多,但是可以分为两大类——比较过滤器,专用过滤器

过滤器的作用是在服务端判断数据是否满足条件,然后只将满足条件的数据返回给客户端;

一、hbase过滤器的分类

1、比较过滤器

行键过滤器 RowFilter

Filter filter1 = new RowFilter(CompareOp.LESS_OR_EQUAL, new BinaryComparator(Bytes.toBytes("row-22")));

scan.setFilter(filter1);

列族过滤器 FamilyFilter

Filter filter1 = new FamilyFilter(CompareFilter.CompareOp.LESS, new BinaryComparator(Bytes.toBytes("colfam3")));

scan.setFilter(filter1);

列过滤器 QualifierFilter

Filter filter = new QualifierFilter(CompareFilter.CompareOp.LESS_OR_EQUAL, new BinaryComparator(Bytes.toBytes("col-2")));

scan.setFilter(filter1);

值过滤器 ValueFilter

Filter filter = new ValueFilter(CompareFilter.CompareOp.EQUAL, new SubstringComparator(".4") );

scan.setFilter(filter1);

2、专用过滤器

单列值过滤器 SingleColumnValueFilter ----会返回满足条件的整行

SingleColumnValueFilter filter = new SingleColumnValueFilter(

Bytes.toBytes("colfam1"),

Bytes.toBytes("col-5"),

CompareFilter.CompareOp.NOT_EQUAL,

new SubstringComparator("val-5"));

filter.setFilterIfMissing(true); //如果不设置为 true,则那些不包含指定 column 的行也会返回

scan.setFilter(filter1);

单列值排除器 SingleColumnValueExcludeFilter -----返回排除了该列的结果 与上面的结果相反

前缀过滤器 PrefixFilter----针对行键

Filter filter = new PrefixFilter(Bytes.toBytes("row1"));

scan.setFilter(filter1);

列前缀过滤器 ColumnPrefixFilter

Filter filter = new ColumnPrefixFilter(Bytes.toBytes("qual2"));

scan.setFilter(filter1);

分页过滤器 PageFilter

代码实现:

package com.ghgj.hbase;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.client.HTable;

import org.apache.hadoop.hbase.client.Result;

import org.apache.hadoop.hbase.client.ResultScanner;

import org.apache.hadoop.hbase.client.Scan;

import org.apache.hadoop.hbase.filter.BinaryComparator;

import org.apache.hadoop.hbase.filter.BinaryPrefixComparator;

import org.apache.hadoop.hbase.filter.ByteArrayComparable;

import org.apache.hadoop.hbase.filter.ColumnPrefixFilter;

import org.apache.hadoop.hbase.filter.CompareFilter.CompareOp;

import org.apache.hadoop.hbase.filter.FamilyFilter;

import org.apache.hadoop.hbase.filter.Filter;

import org.apache.hadoop.hbase.filter.MultipleColumnPrefixFilter;

import org.apache.hadoop.hbase.filter.PageFilter;

import org.apache.hadoop.hbase.filter.PrefixFilter;

import org.apache.hadoop.hbase.filter.QualifierFilter;

import org.apache.hadoop.hbase.filter.RegexStringComparator;

import org.apache.hadoop.hbase.filter.RowFilter;

import org.apache.hadoop.hbase.filter.SingleColumnValueFilter;

import org.apache.hadoop.hbase.filter.SubstringComparator;

import org.apache.hadoop.hbase.util.Bytes;

import org.junit.Test;

public class HbasePageDemo {

// 声明静态配置

static Configuration conf = null;

private static final String ZK_CONNECT_STR =

"hadoop01:2181,hadoop02:2181,hadoop03:2181,hadoop04:2181,hadoop05:2181";

static {

conf = HBaseConfiguration.create();

conf.set("hbase.zookeeper.quorum", ZK_CONNECT_STR);

}

public static void main(String[] args) throws Exception {

String tableName = "testfilter";

String cfName = "f1";

final byte[] POSTFIX = new byte[] { 0x00 };

HTable table = new HTable(conf, tableName);

Filter filter = new PageFilter(3);

byte[] lastRow = null;

int totalRows = 0;

while (true) {

Scan scan = new Scan();

scan.setFilter(filter);

if(lastRow != null){

//注意这里添加了 POSTFIX 操作,用来重置扫描边界

byte[] startRow = Bytes.add(lastRow,POSTFIX);

scan.setStartRow(startRow);

}

ResultScanner scanner = table.getScanner(scan);

int localRows = 0;

Result result;

while((result = scanner.next()) != null){

System.out.println(localRows++ + ":" + result);

totalRows ++;

lastRow = result.getRow();

}

scanner.close();

if(localRows == 0) break;

}

System.out.println("total rows:" + totalRows);

} /

**

* 多种过滤条件的使用方法

* @throws Exception

*/

@Test

public void testScan() throws Exception{

HTable table = new HTable(conf, "person".getBytes());

Scan scan = new Scan(Bytes.toBytes("person_zhang_000001"),

Bytes.toBytes("person_zhang_000002"));

//前缀过滤器----针对行键

Filter filter = new PrefixFilter(Bytes.toBytes("person"));

//行过滤器 ---针对行键

ByteArrayComparable rowComparator = new

BinaryComparator(Bytes.toBytes("person_zhang_000001"));

RowFilter rf = new RowFilter(CompareOp.LESS_OR_EQUAL, rowComparator);

rf = new RowFilter(CompareOp.EQUAL , new

SubstringComparator("_2016-12-31_"));

//单值过滤器 1 完整匹配字节数组

new SingleColumnValueFilter("base_info".getBytes(), "name".getBytes(),

CompareOp.EQUAL, "zhangsan".getBytes());

//单值过滤器 2 匹配正则表达式

ByteArrayComparable comparator = new RegexStringComparator("zhang.");

new SingleColumnValueFilter("info".getBytes(), "NAME".getBytes(),

CompareOp.EQUAL, comparator);

//单值过滤器 3 匹配是否包含子串,大小写不敏感

comparator = new SubstringComparator("wu");

new SingleColumnValueFilter("info".getBytes(), "NAME".getBytes(),

CompareOp.EQUAL, comparator);

//键值对元数据过滤-----family 过滤----字节数组完整匹配

FamilyFilter ff = new FamilyFilter(CompareOp.EQUAL ,

new BinaryComparator(Bytes.toBytes("base_info")) //表中不存

在 inf 列族,过滤结果为空

);

//键值对元数据过滤-----family 过滤----字节数组前缀匹配

ff = new FamilyFilter(

CompareOp.EQUAL ,

new BinaryPrefixComparator(Bytes.toBytes("inf")) //表中存在以

inf 打头的列族 info,过滤结果为该列族所有行

);

//键值对元数据过滤-----qualifier 过滤----字节数组完整匹配

filter = new QualifierFilter(

CompareOp.EQUAL ,

new BinaryComparator(Bytes.toBytes("na")) //表中不存在 na

列,过滤结果为空

);

filter = new QualifierFilter(

CompareOp.EQUAL ,

new BinaryPrefixComparator(Bytes.toBytes("na")) //表中存在以

na 打头的列 name,过滤结果为所有行的该列数据

);

//基于列名(即 Qualifier)前缀过滤数据的 ColumnPrefixFilter

filter = new ColumnPrefixFilter("na".getBytes());

//基于列名(即 Qualifier)多个前缀过滤数据的 MultipleColumnPrefixFilter

byte[][] prefixes = new byte[][] {Bytes.toBytes("na"), Bytes.toBytes("me")};

filter = new MultipleColumnPrefixFilter(prefixes);

//为查询设置过滤条件

scan.setFilter(filter);

scan.addFamily(Bytes.toBytes("base_info"));

//一行

// Result result = table.get(get);

//多行的数据

ResultScanner scanner = table.getScanner(scan);

for(Result r : scanner){

/**

for(KeyValue kv : r.list()){

String family = new String(kv.getFamily());

System.out.println(family);

String qualifier = new String(kv.getQualifier());

System.out.println(qualifier);

System.out.println(new String(kv.getValue()));

}

*/

//直接从 result 中取到某个特定的 value

byte[] value = r.getValue(Bytes.toBytes("base_info"),

Bytes.toBytes("name"));

System.out.println(new String(value));

}

table.close();

}

}

分页过滤器 代码实现:

package com.ghgj.hbase.test1610; import org.apache.commons.lang.StringUtils;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.client.HTable;

import org.apache.hadoop.hbase.client.Result;

import org.apache.hadoop.hbase.client.ResultScanner;

import org.apache.hadoop.hbase.client.Scan;

import org.apache.hadoop.hbase.filter.Filter;

import org.apache.hadoop.hbase.filter.PageFilter;

import org.apache.hadoop.hbase.util.Bytes; /**

* 501条

*

* 每页100条,求第四页 : 301 - 400

*

* pageIndex:第几页

* pageNumber:每页几条

*

*

* 在hbase当中取一部分数据的取法:

* scan 'user_info',{COLUMNS => 'base_info:name',

* LIMIT => 4, STARTROW => 'zhangsan_20150701_0001'}

*

* mysqL:从第几条开始,取多少条

*

* 从mysql的分页规则引申到hbase的分页:把startRow转换成mysql的第几条

*/

public class HBasePageFilterDemo { private static final String ZK_CONNECT_STR = "hadoop03:2181,hadoop04:2181,hadoop05:2181"; private static final String TABLE_NAME = "user_info";

private static final String FAMILY_BASIC = "base_info";

private static final String FAMILY_EXTRA = "extra_info";

private static final String COLUMN_NAME = "name";

private static final String COLUMN_AGE = "age";

private static final String ROW_KEY = "rk0001"; private static Configuration config = null;

private static HTable table = null;

static {

config = HBaseConfiguration.create();

config.set("hbase.zookeeper.quorum", ZK_CONNECT_STR);

try {

table = new HTable(config, TABLE_NAME);

} catch (Exception e) {

e.printStackTrace();

}

} public static void main(String[] args) throws Exception { // ResultScanner pageData = getPageData("zhangsan_20150701_0001", 4);

ResultScanner pageData = getPageData(2, 4);

HBasePrintUtil.printResultScanner(pageData); // String lastRowkey = getLastRowkey(pageData);

// System.out.println(lastRowkey); } public static ResultScanner getPageData(int pageIndex, int pageNumber) throws Exception{

// 怎么把pageIndex 转换成 startRow

String startRow = null; if(pageIndex == 1){ // 当客户方法只取第一页的分页数据时,

ResultScanner pageData = getPageData(startRow, pageNumber);

return pageData; }else{

ResultScanner newPageData = null;

for(int i=0; i<pageIndex - 1; i++){ // 总共循环次数是比你取的页数少1

newPageData = getPageData(startRow, pageNumber);

startRow = getLastRowkey(newPageData);

byte[] add = Bytes.add(Bytes.toBytes(startRow), new byte[]{ 0X00 });

startRow = Bytes.toString(add);

}

newPageData = getPageData(startRow, pageNumber);

return newPageData;

}

} /**

* @param startRow

* @param pageNumber

* @return

* * scan 'user_info',{COLUMNS => 'base_info:name',

* LIMIT => 4, STARTROW => 'zhangsan_20150701_0001'}

* @throws Exception

*/

public static ResultScanner getPageData(String startRow, int pageNumber) throws Exception{

Scan scan = new Scan();

scan.addColumn(Bytes.toBytes("base_info"), Bytes.toBytes("name"));

// 設置當前查询的其实位置

if(!StringUtils.isBlank(startRow)){

scan.setStartRow(Bytes.toBytes(startRow));

}

// 第二个参数

Filter pageFilter = new PageFilter(pageNumber);

scan.setFilter(pageFilter); ResultScanner rs = table.getScanner(scan);

return rs;

} public static String getLastRowkey(ResultScanner rs){

String lastRowkey = null;

for(Result result : rs){

// System.out.println(result.getRow());

lastRowkey = Bytes.toString(result.getRow());

}

return lastRowkey;

// return null;

}

}

多条件过滤时,可以使用FilterList

List<Filter> filters = new ArrayList<Filter>();

SingleColumnValueFilter filter =new SingleColumnValueFilter(

Bytes.toBytes("info"),

Bytes.toBytes("age"),

CompareOp.LESS_OR_EQUAL,

new BinaryComparator(Bytes.toBytes("20")));

filters.add(filter); SingleColumnValueFilter filter1 =new SingleColumnValueFilter(

Bytes.toBytes("info"),

Bytes.toBytes("age"),

CompareOp.GREATER,

new BinaryComparator(Bytes.toBytes("18"))); filters.add(filter1); Filter filter2 = new ValueFilter(CompareOp.EQUAL, new SubstringComparator("lisi") );

filters.add(filter2); FilterList f=new FilterList(filters);

scan.setFilter(f);

Hbase(四) 过滤器查询的更多相关文章

- Hbase Filter过滤器查询详解

过滤器查询 引言:过滤器的类型很多,但是可以分为两大类——比较过滤器,专用过滤器 过滤器的作用是在服务端判断数据是否满足条件,然后只将满足条件的数据返回给客户端: hbase过滤器的比较运算符: LE ...

- 大数据笔记(十四)——HBase的过滤器与Mapreduce

一. HBase过滤器 1.列值过滤器 2.列名前缀过滤器 3.多个列名前缀过滤器 4.行键过滤器5.组合过滤器 package demo; import javax.swing.RowFilter; ...

- HBase - Filter - 过滤器的介绍以及使用 | 那伊抹微笑

博文作者:那伊抹微笑 csdn 博客地址:http://blog.csdn.net/u012185296 itdog8 地址链接 : http://www.itdog8.com/thread-214- ...

- ElasticSearch第四步-查询详解

ElasticSearch系列学习 ElasticSearch第一步-环境配置 ElasticSearch第二步-CRUD之Sense ElasticSearch第三步-中文分词 ElasticSea ...

- Hibernate之HQL添加过滤器查询的用法

HQL查询过程中支持添加过滤器.使用步骤是这样的: 首先在要查询的实体对象的映射中使用<filter-def>标签配置过滤器,并在相对应的<class>标签中添加对应的< ...

- 基于Solr的HBase多条件查询测试

背景: 某电信项目中采用HBase来存储用户终端明细数据,供前台页面即时查询.HBase无可置疑拥有其优势,但其本身只对rowkey支持毫秒级 的快 速检索,对于多字段的组合查询却无能为力.针对HBa ...

- solr与.net系列课程(四)solr查询参数的讲解与.net如何获取solr数据

solr与.net系列课程(四)solr查询参数的讲解与.net如何获取solr数据 上一节我们完成了solr连接数据库,细心的朋友会发现一个问题,就是solr其实和语言没有任何关系,配置完成后任何语 ...

- 转:arcgis api for js入门开发系列四地图查询

原文地址:arcgis api for js入门开发系列四地图查询 arcgis for js的地图查询方式,一般来说,总共有三种查询方式:FindTask.IdentifyTask.QueryTas ...

- MySQL之多表查询一 介绍 二 多表连接查询 三 符合条件连接查询 四 子查询 五 综合练习

MySQL之多表查询 阅读目录 一 介绍 二 多表连接查询 三 符合条件连接查询 四 子查询 五 综合练习 一 介绍 本节主题 多表连接查询 复合条件连接查询 子查询 首先说一下,我们写项目一般都会建 ...

随机推荐

- .net mvc 使用ueditor的开发(官网没有net版本?)

1.ueditor的下载导入 官网下载地址:https://ueditor.baidu.com/website/download.html · 介绍 有两种,一种开发版,一种Mini版,分别长这样: ...

- 时序数据库InfluxDB

在系统服务部署过后,线上运行服务的稳定性是系统好坏的重要体现,监控系统状态至关重要,经过调研了解,时序数据库influxDB在此方面表现优异. influxDB介绍 时间序列数据是以时间字段为每行数据 ...

- PHPCMS如何让手机站点取消浏览大图直接加载原图

一.然后找到phpcms\modules\wap\functions\global.func.php 文件,找到相关代码,如下图: return '<img src="'.thumb( ...

- 【Python入门学习】列表生成和函数生成器的方式实现杨辉三角

列表生成: L = [i for i in range(10)] 列表生成器: g = (i for i in range(10)) 函数生成器使用的关键字yield实现 例如fib生成器 def f ...

- 电脑提示‘您需要来自Administration的权限才能对此文件夹进行更改’怎么删除文件

电脑提示'您需要来自Administration的权限才能对此文件夹进行更改'怎么删除文件 应该怎么做 win7系统需要定期删除一些无用的文件,扩大内存空间,但是在删除文件的时候弹出提示"您 ...

- Python如何对折线进行平滑曲线处理?

在用python绘图的时候,经常由于数据的原因导致画出来的图折线分界过于明显,因此需要对原数据绘制的折线进行平滑处理,本文介绍利用插值法进行平滑曲线处理: 实现所需的库 numpy.scipy.mat ...

- 使用Scrapy构建一个网络爬虫

记得n年前项目需要一个灵活的爬虫工具,就组织了一个小团队用Java实现了一个爬虫框架,可以根据目标网站的结构.地址和需要的内容,做简单的配置开发,即可实现特定网站的爬虫功能.因为要考虑到各种特殊情形, ...

- 食物链 POJ 1182(种类并查集)

Description 动物王国中有三类动物A,B,C,这三类动物的食物链构成了有趣的环形.A吃B, B吃C,C吃A. 现有N个动物,以1-N编号.每个动物都是A,B,C中的一种,但是我们并不知道它到 ...

- java调试器

javac.exe是编译.java文件 java.exe是执行编译好的.class文件 javadoc.exe是生成Java说明文档 jdb.exe是Java调试器 javaprof.exe是剖析工具 ...

- POJ2528的另一种解法(线段切割)

题目:Mayor's posters 原文地址 首先本题题意是:有一面墙,被等分为1QW份,一份的宽度为一个单位宽度.现在往墙上贴N张海报,每张海报的宽度是任意 的,但是必定是单位宽度的整数倍,且&l ...