4.keras实现-->生成式深度学习之DeepDream

DeepDream是一种艺术性的图像修改技术,它用到了卷积神经网络学到的表示,DeepDream由Google于2015年发布。这个算法与卷积神经网络过滤器可视化技术几乎相同,都是反向运行一个卷积神经网络:对卷积神经网络的输入做梯度上升,以便将卷积神经网络靠顶部的某一层的某个过滤器激活最大化。但有以下几个简单的区别:

- 使用DeepDream,我们尝试将所有层的激活最大化,而不是将某一层的激活最大化,因此需要同时将大量特征的可视化混合在一起

- 不是从空白的、略微带有噪声的输入开始,而是从现有的图像开始,因此所产生的效果能够抓住已经存在的视觉模式,并以某种艺术性的方式将图像扭曲

- 输入图像是在不同的尺度上【叫作八度(octave)】进行处理的,这可以提高可视化的质量

我们将从一个在ImageNet上预训练的卷积神经网络(Keras内置的Inception V3模型)开始

#加载预训练的Inception V3模型

from keras.applications import inception_v3

from keras import backend as K #我们不需要训练模型,所以这个命令会禁用

K.set_learning_phase(0) #构建不包括全连接层的Inception V3网络。使用预训练的ImageNet权重来加载模型

model = inception_v3.InceptionV3(weights = 'imagenet',include_top=False)

接下来要计算损失loss,即在梯度上升过程中需要最大化的量。在第五章的过滤器可视化中,我们试图将某一层的某个过滤器的值最大化。这里,我们要将多个层的所有过滤器的激活同时最大化。具体来说,就是对一组靠近顶部的层激活的L2范数进行加权求和,然后将其最大化。选择哪些层(以及它们对最终损失的贡献)对生成的可视化结果具有很大影响,所以我们希望让这些参数变得易于配置。更靠近底部的层生成的是几何图案,而更靠近顶部的层生成的则是从中能够看出某些ImageNet类别(比如鸟或狗)的图案。我们将随意选择4层的配置,但以后一定要探索多个不同的配置

# 设置DeepDream配置

layer_contributions={

'mixed2':0.2,

'mixed3':3.,

'mixed4':2,

'mixed5':1.5,

}

#这个字典将层的名称映射为一个系数,这个系数定量表示该层激活对你要最大化的损失的贡献大小。

# 注意,层的名称硬编码在内置的inception V3应用中

#定义需要最大化的损失 #创建一个字典,将层的名称映射为层的实例

|

layer_dict ={'input_4':

<keras.engine.input_layer.InputLayer at 0x281714cc240>, activation.shape: (?, ?, ?, 288)(?, ?, ?, 768) (?, ?, ?, 768)(?, ?, ?, 768) loss: Tensor("add_19:0", shape=(),

|

#梯度上升过程 #这个张量用于保存生成的图像,即梦境图像

dream = model.input #计算损失相对于梦境图像的梯度

grads = K.gradients(loss,dream)[0] #将梯度标准化(重要技巧)

grads /= K.maximum(K.mean(K.abs(grads)),1e-7) #给定一张输出图像,设置一个keras函数来获取损失值和梯度值

outputs = [loss,grads]

fetch_loss_and_grads = K.function([dream],outputs) def eval_loss_and_grads(x):

outs = fetch_loss_and_grads([x])

loss_value = outs[0]

grad_values = outs[1]

return loss_value,grad_values #这个函数运行itertions次梯度上升

def gradient_ascent(x,iterations,step,max_loss=None):

for i in range(iterations):

loss_value,grad_values = eval_loss_and_grads(x)

if max_loss is not None and loss_value > max_loss:

break

print('...Loss value at',i,':',loss_value)

x += step * grad_values

return x

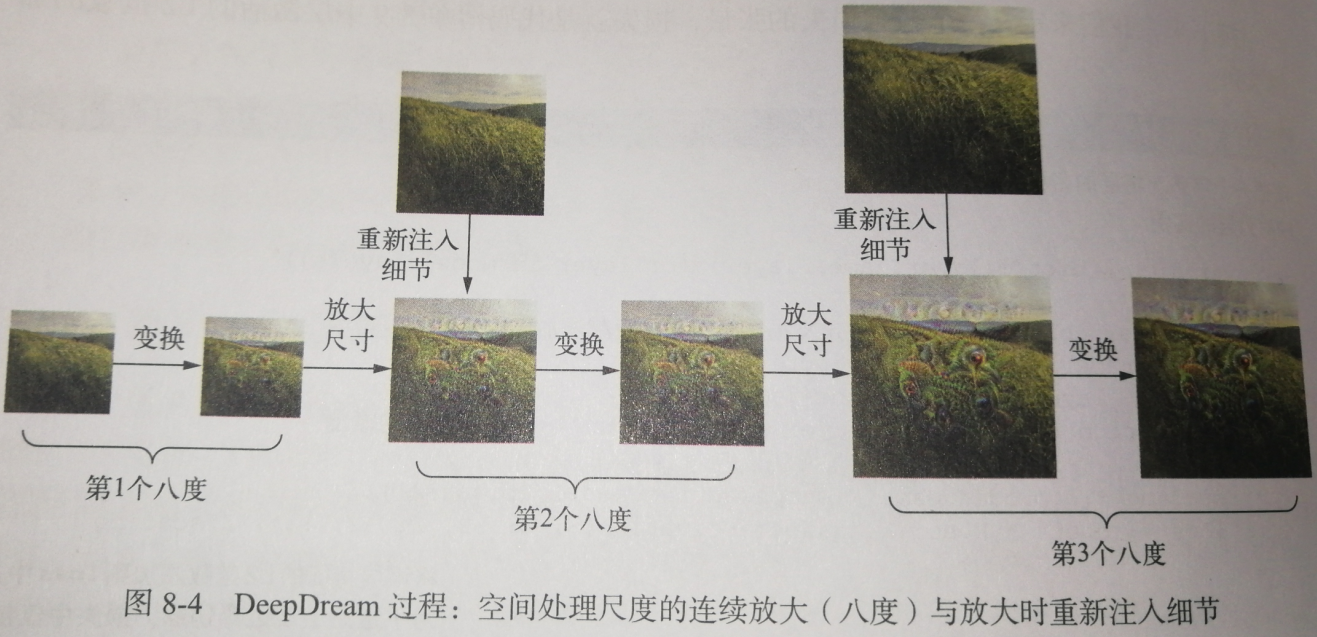

最后就是实际的DeepDream算法

首先,我们来定义一个列表,里面包含的是处理图像的尺度(也叫八度)。每个连续的尺度都是前一个的1.4倍(放大40%),即首先处理小图像,然后逐渐增大图像尺寸。对于每个连续的尺度,从最小到最大,我们都需要在当前尺度运行梯度上升,以便将之前定义的损失最大化。每次运行完梯度上升之后,将得到的图像放大40%。

在每次连续的放大之后(图像会变得模糊或像素化),为避免丢失大量图像细节,我们可以使用一个简单的技巧:每次放大之后,将丢失的细节重新注入到图像中。这种方法是可行的,因为我们知道原始图像放大到这个尺寸应该是什么样子。

给定一个较小的图像尺寸S和一个较大的图像尺寸L,你可以计算将原始图像大小调整为L与将原始图像大小调整为S之间的区别,这个区别可以定量描述从S到L的细节损失。

#辅助函数

import scipy

from keras.preprocessing import image def resize_img(img,size):

img = np.copy(img)

factors=(1,

float(size[0])/img.shape[1],

float(size[1])/img.shape[2],

1)

return scipy.ndimage.zoom(img,factors,order=1) def save_img(img,fname):

pil_img = deprocess_image(np.copy(img))

scipy.misc.imsave(fname,pil_img) def preprocess_image(image_path):

img = image.load_img(image_path)#打开图片

img = image.img_to_array(img)#把图片转成array形式

img = np.expand_dims(img,axis=0)#改变图像大小

img = inception_v3.preprocess_input(img)#将图像格式转换为Inception V3模型能够处理的张量

return img def deprocess_image(x): #通用函数,将一个张量转换为有效图像

if K.image_data_format() == 'channels_first':

x = x.reshape((3,x.shape[2],x.shape[3]))

x = x.transpose((1,2,0))

else:

x = x.reshape((x.shape[1],x.shape[2],3)) #对inception_v3.preprocess_input所做的预处理进行反向操作

x /= 2.

x += 0.5

x *= 255.

x = np.clip(x,0,255).astype('uint8')

return x

#在多个连续尺度上运行梯度上升

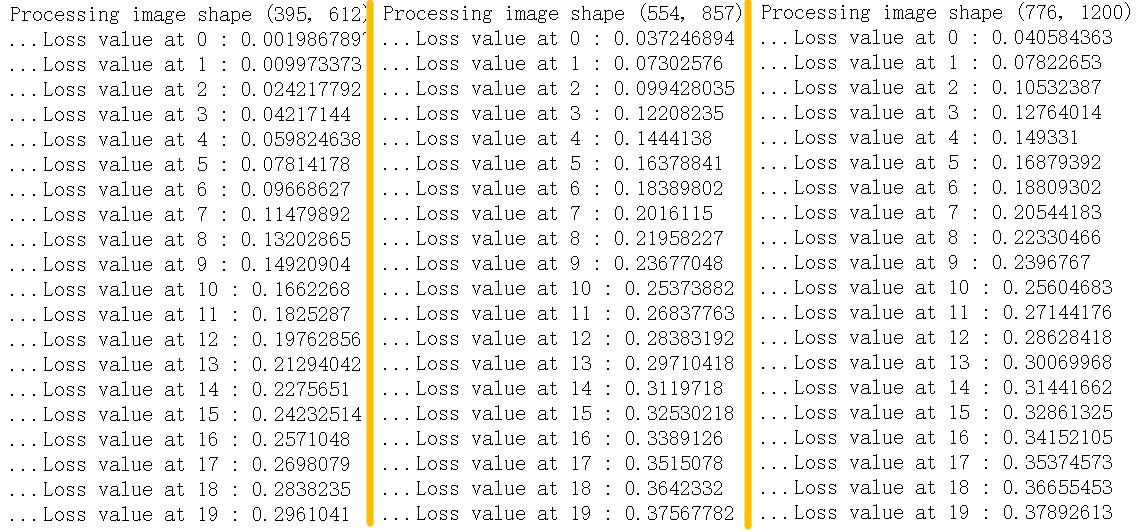

import numpy as np step = 0.01 #步长

num_octave = 3 #运行梯度上升的尺度个数

octave_scale = 1.4 #两个尺度之间的大小比例

iterations = 20 #在每个尺度上运行梯度上升的步数 max_loss = 10. #如果损失增大到大于10,我们要中断梯度上升的过程,以避免得到丑陋的伪影

base_image_path = 'IU.jpeg' #将这个变量修改为你要使用的图像的路径 img = preprocess_image(base_image_path)#将基础图像加载成一个numpy数组 original_shape = img.shape[1:3] #img.shape = (1, 776, 1200, 3)

successive_shapes = [original_shape] #[(776, 1200)]

for i in range(1,num_octave):

#准备一个由形状元组组成的列表,它定义了运行梯度上升的不同尺度

shape = tuple([int(dim/(octave_scale ** i)) for dim in original_shape])

successive_shapes.append(shape) #[(776, 1200), (554, 857), (395, 612)] successive_shapes = successive_shapes[::-1] #将形状列表反转,变为升序 original_img = np.copy(img)

shrunk_original_img = resize_img(img,successive_shapes[0])#将图像numpy数组的大小缩放到最小尺寸 for shape in successive_shapes:

print('Processing image shape',shape)

img = resize_img(img,shape)#将梦境图像放大

img = gradient_ascent(img,

iterations = iterations,

step = step,

max_loss = max_loss)

upscaled_shrunk_original_img = resize_img(shrunk_original_img,shape)

same_size_original = resize_img(original_img,shape)

lost_detail = same_size_original - upscaled_shrunk_original_img img += lost_detail

shrunk_original_img = resize_img(original_img,shape)

save_img(img,fname='dream_at_scale_'+str(shape)+'.png') save_img(img,fname='final_dream.png')

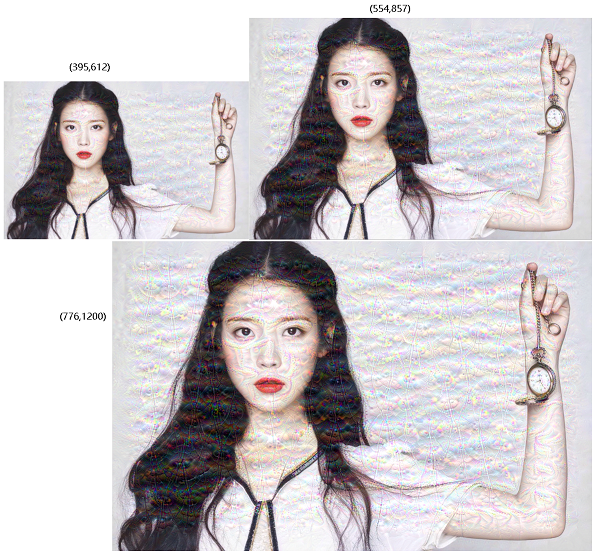

训练损失:

| 原图 | 效果图 |

|

|

4.keras实现-->生成式深度学习之DeepDream的更多相关文章

- 4.keras实现-->生成式深度学习之用变分自编码器VAE生成图像(mnist数据集和名人头像数据集)

变分自编码器(VAE,variatinal autoencoder) VS 生成式对抗网络(GAN,generative adversarial network) 两者不仅适用于图像,还可以 ...

- 4.keras实现-->生成式深度学习之用GAN生成图像

生成式对抗网络(GAN,generative adversarial network)由Goodfellow等人于2014年提出,它可以替代VAE来学习图像的潜在空间.它能够迫使生成图像与真实图像在统 ...

- 从零开始学会GAN 0:第一部分 介绍生成式深度学习(连载中)

本书的前四章旨在介绍开始构建生成式深度学习模型所需的核心技术.在第1章中,我们将首先对生成式建模领域进行广泛的研究,并从概率的角度考虑我们试图解决的问题类型.然后,我们将探讨我们的基本概率生成模型的第 ...

- 转:TensorFlow和Caffe、MXNet、Keras等其他深度学习框架的对比

http://geek.csdn.net/news/detail/138968 Google近日发布了TensorFlow 1.0候选版,这第一个稳定版将是深度学习框架发展中的里程碑的一步.自Tens ...

- [AI开发]centOS7.5上基于keras/tensorflow深度学习环境搭建

这篇文章详细介绍在centOS7.5上搭建基于keras/tensorflow的深度学习环境,该环境可用于实际生产.本人现在非常熟练linux(Ubuntu/centOS/openSUSE).wind ...

- 分别基于TensorFlow、PyTorch、Keras的深度学习动手练习项目

×下面资源个人全都跑了一遍,不会出现仅是字符而无法运行的状况,运行环境: Geoffrey Hinton在多次访谈中讲到深度学习研究人员不要仅仅只停留在理论上,要多编程.个人在学习中也体会到单单的看理 ...

- keras框架下的深度学习(一)手写体识别

这个系列文章主要记录使用keras框架来搭建深度学习模型的学习过程,其中有一些自己的想法和体会,主要学习的书籍是:Deep Learning with Python,使用的IDE是pycharm. 在 ...

- keras框架下的深度学习(二)二分类和多分类问题

本文第一部分是对数据处理中one-hot编码的讲解,第二部分是对二分类模型的代码讲解,其模型的建立以及训练过程与上篇文章一样:在最后我们将训练好的模型保存下来,再用自己的数据放入保存下来的模型中进行分 ...

- Python深度学习 deep learning with Python

内容简介 本书由Keras之父.现任Google人工智能研究员的弗朗索瓦•肖莱(François Chollet)执笔,详尽介绍了用Python和Keras进行深度学习的探索实践,涉及计算机视觉.自然 ...

随机推荐

- 【大数据系列】FileSystem Shell官方文档翻译

appendToFile cat checksum chgrp chmod chown copyFromLocal copyToLocal count cp createSnapshot delete ...

- js 判断数组重复元素以及重复的个数

知识点: .sort()方法用于对数组元素排序,并返回数组. var _arr = ['旅行箱', '旅行箱', '小米', '大米']; var _res = []; // _arr.sort(); ...

- sphinx配置文件详解

sphinx的配置文件是在配置的时候最容易出错的了: 我们先要明白几个概念: source:数据源,数据是从什么地方来的. index:索引,当有数据源之后,从数据源处构建索引.索引实际上就是相当于一 ...

- shell 进制转换

包括: i.任意进制转化为十进制((num=base#number)) [base和number必须一致,是同一种进制] ii.十进制转化为任意进制`echo "obase=进制;值&quo ...

- Windows Server 2008 R2之六活动目录域服务的卸载

活动目录域服务的卸载是将DC降级为独立服务器或成员服务器的过程. 在删除活动目录之前,为了防止操作失败操作系统故障,须对系统进行备份.同时,我们还必须对待删除的域控制器进行如下检查 1.是否有操作主控 ...

- 7.22 python面试题

2018-7-22 16:32:24 把面试题敲完了,,好强悍! Python 10期考试题 1.常用字符串格式化有那些?并说明他们的区别 # format 直接调用函数 # %s 语法塘 # %r ...

- css层叠样式优先级总结

虽然学前端最刚开始就是html+css,一直因为这些看起来太简单就没有什么总结,不过看似很简单的东西,研究起来也深不可测,问起来js可能回答的头头是道,css这么简单的东西,其中一个优先级的问题就能难 ...

- java-04-动手动脑

1String.equals()方法的实现代码 public boolean equals(Object anObject) { if (this == anObject) { return true ...

- HDU 1243 反恐训练营(最长公共序列)

反恐训练营 Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others) Total Submiss ...

- Oracle安装部署之rhel 5.8下静默安装oracle11gr2

1.图形界面下录制脚本如下: #-------------------------------------------------------------------------------# Do ...