Web Scraping using Python Scrapy_BS4 - using Scrapy and Python(2)

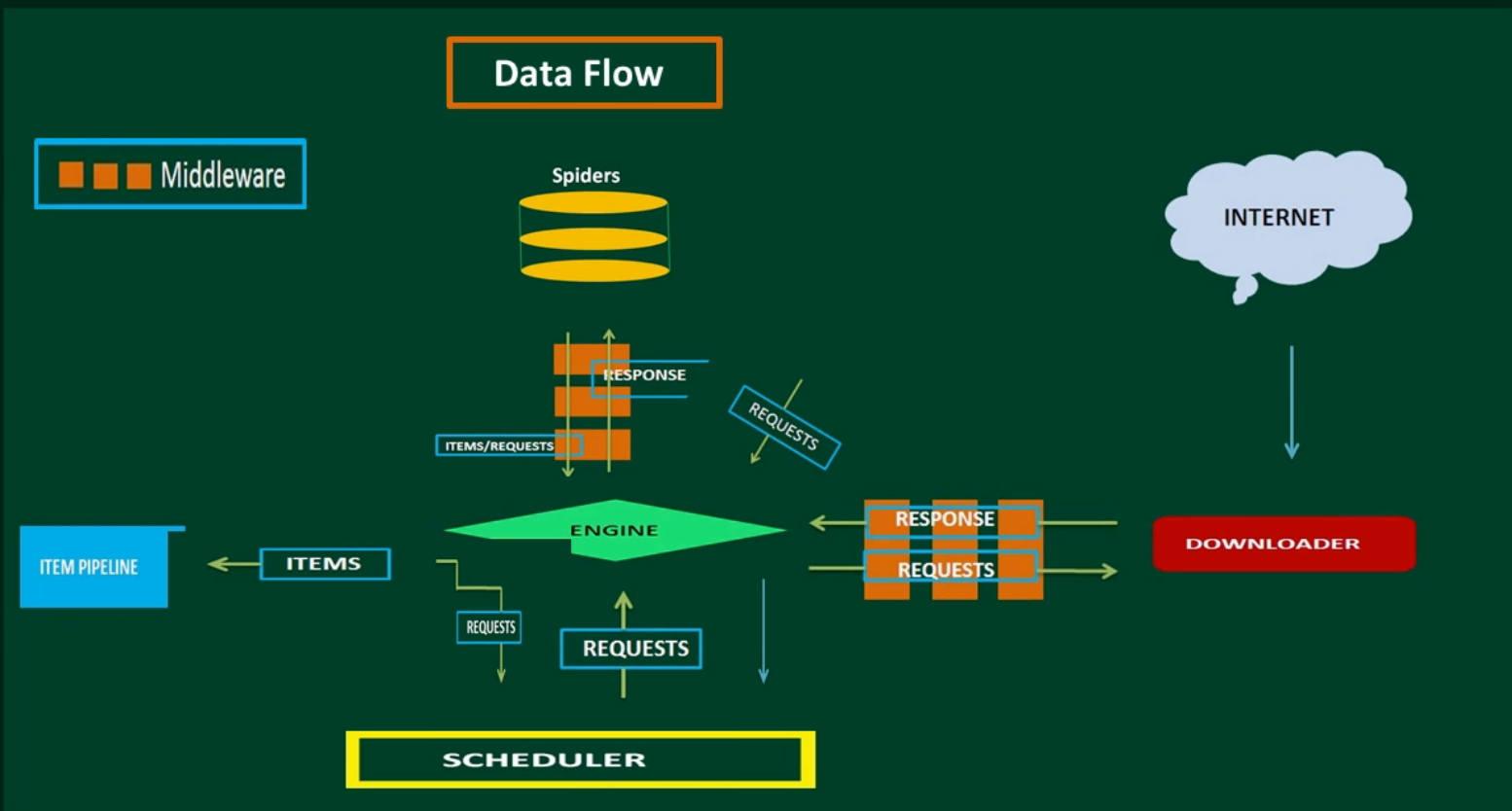

Scrapy Architecture

Creating a Spider.

Spiders are classes that you define that Scrapy uses to scrape(extract) information from a website(s).

- import scrapy

- class QuoteSpider(scrapy.Spider):

- name = "quote"

- start_urls = [

- 'https://bluelimelearning.github.io/my-fav-quotes/'

- ]

- def parse(self, response):

- for quote in response.css('div.quotes'):

- yield{

- 'quote':quote.css('p.aquote::text').extract(),

- 'author':quote.css('p.author::text').extract_first(),

- }

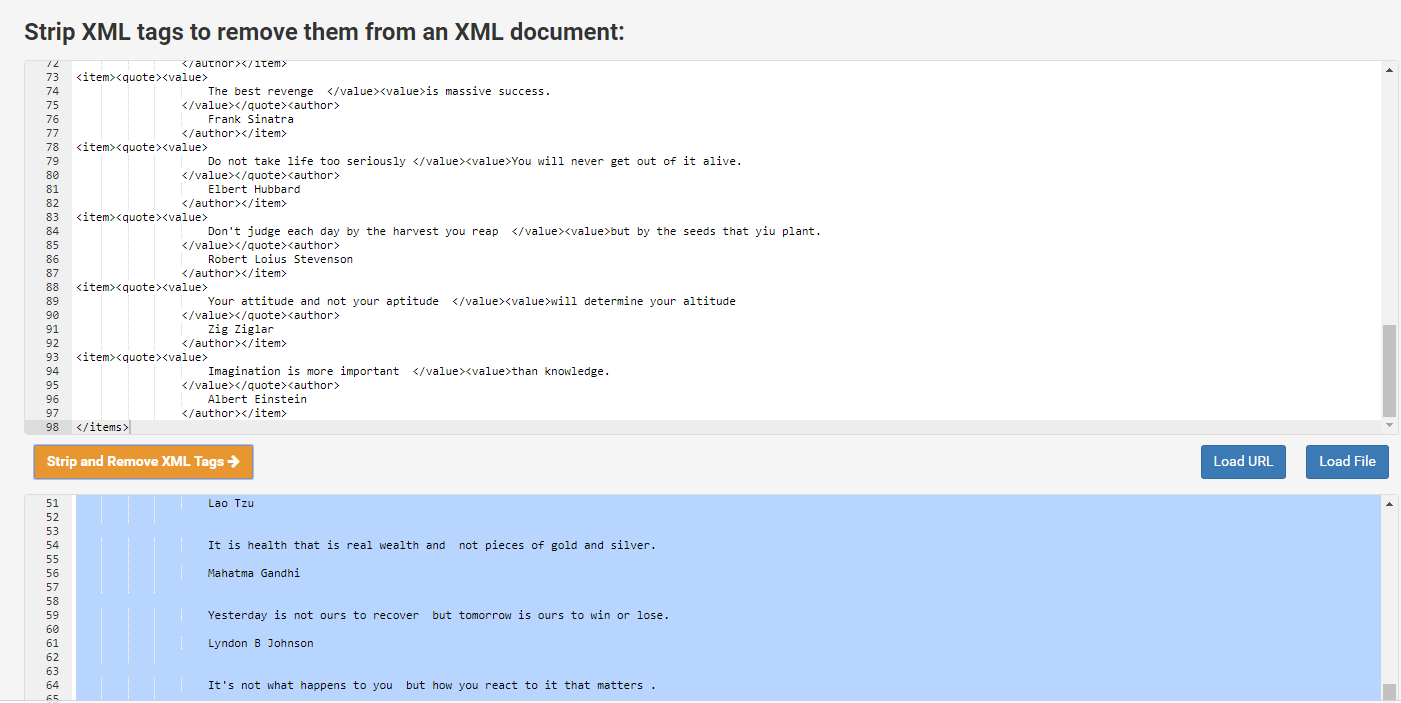

Running your spider and saving scrapped data.

- scrapy runspider quotes_spiders.py -o quotes.xml

https://www.cleancss.com/strip-xml/

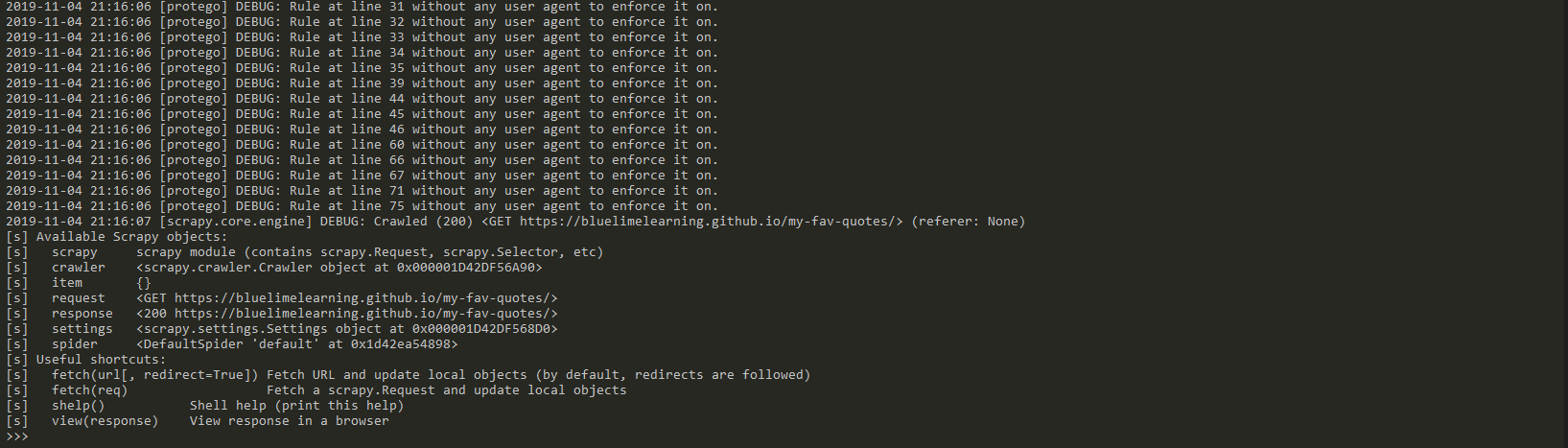

Scraping data with Scrapy Shell

- scrapy shell "https://bluelimelearning.github.io/my-fav-quotes/"

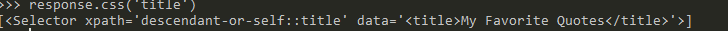

- response.css('title')

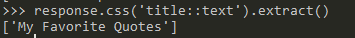

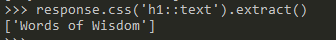

- response.css('title::text').extract()

- response.css('h1::text').extract()

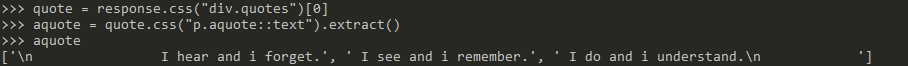

- quote = response.css("div.quotes")[]

- aquote = quote.css("p.aquote::text").extract()

- aquote

Web Scraping using Python Scrapy_BS4 - using Scrapy and Python(2)的更多相关文章

- Web Scraping using Python Scrapy_BS4 - using Scrapy and Python(1)

Create a new Scrapy project first. scrapy startproject projectName . Open this project in Visual Stu ...

- Web Scraping using Python Scrapy_BS4 - using BeautifulSoup and Python

Use BeautifulSoup and Python to scrap a website Lib: urllib Parsing HTML Data Web scraping script fr ...

- Web Scraping using Python Scrapy_BS4 - Software

Install the following software before web scraping. Visual Studio Code Python and Pip pip install vi ...

- Web Scraping using Python Scrapy_BS4 - Introduction

What is Web Scraping This is also referred to as web harvesting and web data extraction. This is the ...

- Web Scraping with Python

Python爬虫视频教程零基础小白到scrapy爬虫高手-轻松入门 https://item.taobao.com/item.htm?spm=a1z38n.10677092.0.0.482434a6E ...

- How To Crawl A Web Page with Scrapy and Python 3

sklearn实战-乳腺癌细胞数据挖掘(博主亲自录制视频) https://study.163.com/course/introduction.htm?courseId=1005269003& ...

- Web Scraping with Python读书笔记及思考

Web Scraping with Python读书笔记 标签(空格分隔): web scraping ,python 做数据抓取一定一定要明确:抓取\解析数据不是目的,目的是对数据的利用 一般的数据 ...

- <Web Scraping with Python>:Chapter 1 & 2

<Web Scraping with Python> Chapter 1 & 2: Your First Web Scraper & Advanced HTML Parsi ...

- Web scraping with Python (part II) « Jean, aka Sig(gg)

Web scraping with Python (part II) « Jean, aka Sig(gg) Web scraping with Python (part II)

随机推荐

- Mac App破解之路九 vscode插件破解

破解对象: luaide 破解目的:学习如何破解vscode插件 破解背景: vsscode用了这么多年,安装了很多插件,其中luaide插件是收费的. 说实话,100块并不贵, 我本来准备买的. ...

- C语言实现类

#ifndef __DEFINE__H__ #define __DEFINE__H__ #define vector3(type) \ typedef struct vector3_##type { ...

- 009.OpenShift管理及监控

一 资源限制 1.1 pod资源限制 pod可以包括资源请求和资源限制: 资源请求 用于调度,并控制pod不能在计算资源少于指定数量的情况下运行.调度程序试图找到一个具有足够计算资源的节点来满足pod ...

- MongoDB副本集replica set (二)--副本集环境搭建

(一)主机信息 操作系统版本:centos7 64-bit 数据库版本 :MongoDB 4.2 社区版 ip hostname 192.168.10.41 mongoserver1 192.16 ...

- Redis持久性——RDB和AOF

Redis持久性 Redis提供了不同的持久性选项: RDB持久性以指定的时间间隔执行数据集的时间点快照. AOF持久性记录服务器接收的每个写入操作,将在服务器启动时再次播放,重建原始数据集.使用与R ...

- ElasticSearch中倒排索引和正向索引

ElasticSearch搜索使用的是倒排索引,但是排序.聚合等不适合倒排索引使用的是正向索引 倒排索引 倒排索引表以字或词为关键字进行索引,表中关键字所对应的记录项记录了出现这个字或词的所有文档,每 ...

- 入门大数据---PySpark

一.前言 前面我们学习的是使用Scala和Java开发Spark.最近补充了下Python基础,那么就用Python开发下Spark.Python开发Spark简称PySpark. 二.环境准备 1. ...

- mysql无限级分类

第一种方案: 使用递归算法,也是使用频率最多的,大部分开源程序也是这么处理,不过一般都只用到四级分类. 这种算法的数据库结构设计最为简单.category表中一个字段id,一个字段fid(父id).这 ...

- 问题: No module named _gexf 解决方法

最近在参与一个社交网络数据可视化的项目,要在后端将社交网络信息组建成网络传至前端以使其可视化.前端使用Echart显示网络,后端要通过Python的Gexf库组建网络. Gexf库安装过程为: pip ...

- Dubbo及注册中心原理

本文首发于微信公众号[猿灯塔],转载引用请说明出处 今天是猿灯塔“365天原创计划”第4天. 今天呢!灯塔君跟大家讲: 一.Dubbo意义 网站应用的架构变化经历了一个从所有服务分布在一台服务器上(A ...