【Spark篇】--Spark中Standalone的两种提交模式

一、前述

Spark中Standalone有两种提交模式,一个是Standalone-client模式,一个是Standalone-master模式。

二、具体

1、Standalone-client提交任务方式

- 提交命令

./spark-submit --master spark://node01:7077 --class org.apache.spark.examples.SparkPi ../lib/spark-examples-1.6.

0-hadoop2.6.0.jar 100

./spark-submit --master spark://node01:7077 --deploy-mode client --class org.apache.spark.examples.SparkPi ../li

b/spark-examples-1.6.0-hadoop2.6.0.jar 100

解释:--class org.apache.spark.examples.SparkPi main函数

../lib/spark-examples-1.6.0-hadoop2.6.0.jar jar包

100 main函数需要参数

- 执行原理图解

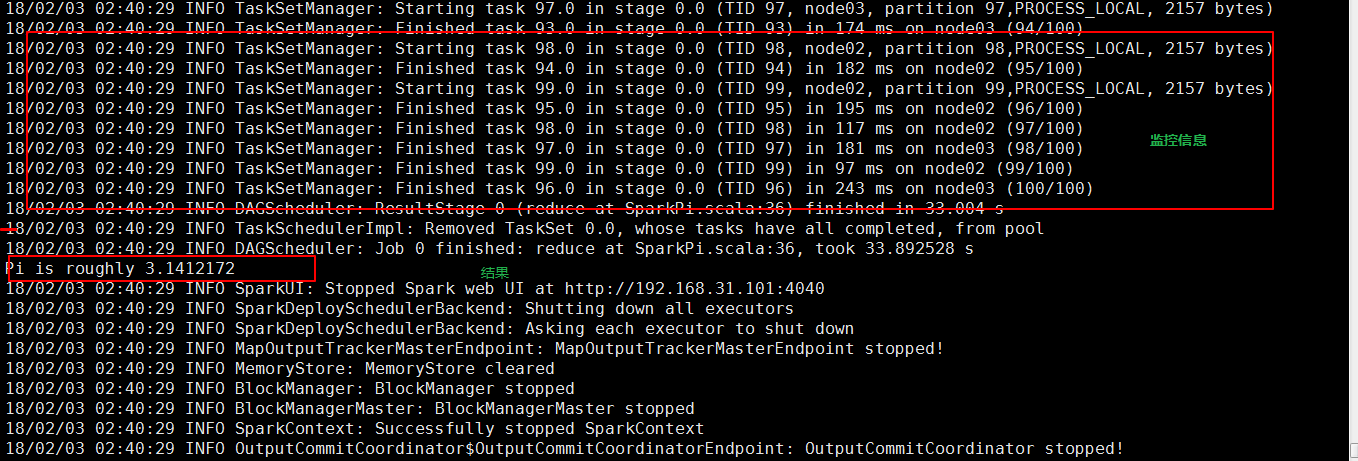

- 执行流程

1、client模式提交任务后,会在客户端启动Driver进程。

2、Driver会向Master申请启动Application启动的资源。

3、资源申请成功,Driver端将task发送到worker端执行。

4、worker将task执行结果返回到Driver端。

- 总结

个application到集群运行,次网卡流量暴增的问题。(因为要监控task的运行情况,会占用很多端口,如上图的结果图)客户端网卡通信,都被task监控信息占用。

2、Client端作用

1. Driver负责应用程序资源的申请

2. 任务的分发。

3. 结果的回收。

4. 监控task执行情况。

2、Standalone-cluster提交任务方式

- 提交命令

./spark-submit --master spark://node01:7077 --deploy-mode cluster --class org.apache.spark.examples.SparkPi ../

lib/spark-examples-1.6.0-hadoop2.6.0.jar 100

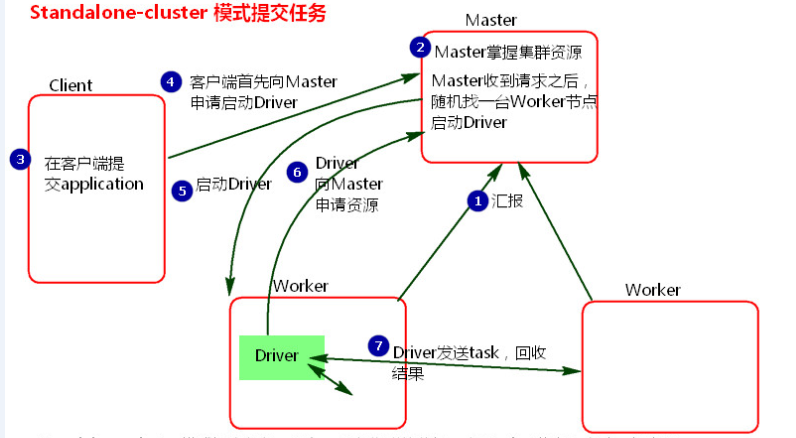

- 执行原理图解

- 执行流程

1、cluster模式提交应用程序后,会向Master请求启动Driver.(而不是启动application)

2、Master接受请求,随机在集群一台节点启动Driver进程。

3、Driver启动后为当前的应用程序申请资源。Master返回资源,并在对应的worker节点上发送消息启动Worker中的executor进程。

4、Driver端发送task到worker节点上执行。

5、worker将执行情况和执行结果返回给Driver端。Driver监控task任务,并回收结果。

- 总结

1、当在客户端提交多个application时,Driver会在Woker节点上随机启动,这种模式会将单节点的网卡流量激增问题分散到集群中。在客户端看不到task执行情况和结果。要去webui中看。cluster模式适用于生产环境

2、 Master模式先启动Driver,再启动Application。

【Spark篇】--Spark中Standalone的两种提交模式的更多相关文章

- Spark剖析-宽依赖与窄依赖、基于yarn的两种提交模式、sparkcontext原理剖析

Spark剖析-宽依赖与窄依赖.基于yarn的两种提交模式.sparkcontext原理剖析 一.宽依赖与窄依赖 二.基于yarn的两种提交模式深度剖析 2.1 Standalne-client 2. ...

- 小记--------spark的两种提交模式

spark的两种提交模式:yarn-cluster . yarn-client 图解

- spark基于yarn的两种提交模式

一.spark的三种提交模式 1.第一种,Spark内核架构,即standalone模式,基于Spark自己的Master-Worker集群. 2.第二种,基于YARN的yarn-cluster模式. ...

- 【Spark篇】---SparkStreaming+Kafka的两种模式receiver模式和Direct模式

一.前述 SparkStreamin是流式问题的解决的代表,一般结合kafka使用,所以本文着重讲解sparkStreaming+kafka两种模式. 二.具体 1.Receiver模式 原理图 ...

- 【Spark篇】---Spark中yarn模式两种提交任务方式

一.前述 Spark可以和Yarn整合,将Application提交到Yarn上运行,和StandAlone提交模式一样,Yarn也有两种提交任务的方式. 二.具体 1.yarn-clien ...

- Spark on YARN两种运行模式介绍

本文出自:Spark on YARN两种运行模式介绍http://www.aboutyun.com/thread-12294-1-1.html(出处: about云开发) 问题导读 1.Spark ...

- spark on mesos 两种运行模式

spark on mesos 有粗粒度(coarse-grained)和细粒度(fine-grained)两种运行模式,细粒度模式在spark2.0后开始弃用. 细粒度模式 优点 spark默认运行的 ...

- Spark on YARN的两种运行模式

Spark on YARN有两种运行模式,如下 1.yarn-cluster:适合于生产环境. Spark的Driver运行在ApplicationMaster中,它负责向YARN Re ...

- Spark Streaming中空batches处理的两种方法(转)

原文链接:Spark Streaming中空batches处理的两种方法 Spark Streaming是近实时(near real time)的小批处理系统.对给定的时间间隔(interval),S ...

随机推荐

- 网站发布出现“未能找到路径“path\bin\roslyn\csc.exe”....“和拒绝访问的解决办法

最近在2017上新建了一个MVC项目,发布是出现了各种奇怪的问题,其中一个错误是: 未能找到路径“path\bin\roslyn\csc.exe”.... 经过网上搜寻资料发现罪魁祸首就是NUGET里 ...

- shell 处理小数位加减法(比较)运算

有一个shell脚本需要处理小数位运算,刚开始使用了expr Java代码 a=7.9 b=10 c=`expr $a \> $b` 结果运算错误,因为expr只支持整数运算,不支持小数. ...

- 业务线接入前端异常监控sentry

1.前端异常处理的框架对比 是否开源 收费 语言 监控范围 sentry 是 自己搭建服务器(免费)价格 英文 Angular.AngularJs.Backbone.Ember.JavaScrip ...

- BigDecimal.valueOf

Those are two separate questions: "What should I use for BigDecimal?" and "What do I ...

- ISP PIPLINE (十二) Sharpening

什么是sharpening? 不解释,从左到右为sharpen , 从右到左为blur. 简单理解为边缘增强,使得轮廓清晰.增强对比度. 如何进行sharpening? 下面是实际sharpen的过程 ...

- JAVA基础复习与总结<五> String类_File类_Date类

String类 .Java字符串就是Unicode字符序列,例如串“Java”就是4个Unicoe字符组成. .Java没有内置的字符串类型,而是在标准java类库中提供了一个预定义的类String, ...

- PHP使用CURL抓取网页

CURL是一个非常强大的开源库,支持很多协议,包括HTTP.FTP.TELNET等,我们使用它来发送HTTP请求.它给我 们带来的好处是可以通过灵活的选项设置不同的HTTP协议参数,并且支持HTTPS ...

- 编程菜鸟的日记-Linux无处不在

原文来自:http://www.linuxfederation.com/linux-everywhere Linux无处不在 “Linux无处不在.从空间站到微波炉到有Linux.”你可能听说很多以及 ...

- Linux SVN服务器的搭建配置及分支的创建与合并

第一步:通过yum命令安装svnserve,命令如下: >yum -y install subversion 若需查看svn安装位置,可以用以下命令: >rpm -ql subversio ...

- Linux 管理进程

探查进程 参数 描述 -A 显示所有进程 -N 显示与指定参数不符的所有进程 -a 显示除控制进程(session leader1)和无终端进程外的所有进程 -d 显示除控制进程外的所有进程 -e 显 ...