神经网络与深度学习笔记 Chapter 2.

转载请注明出处http://www.cnblogs.com/zhangcaiwang/p/6886037.html

以前都没有正儿八经地看过英文类文档,神经网络方面又没啥基础,结果第一章就花费了我将近一周的晚上。不过还是有收获的,希望英文阅读水平越来越高吧。

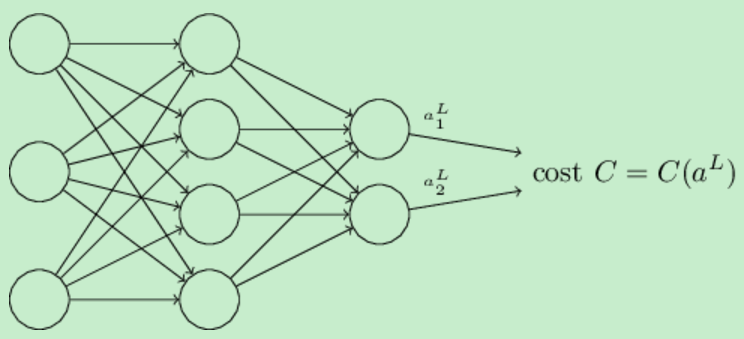

上一章讲解了神经网络如何通过梯度下降学习权重和偏差,但是没有讲解代价函数(cost function)的梯度是怎么求解的。本章中主要讲解一个用来计算代价函数梯度的快速算法:反向传播(backpropagation)算法。

Warm up: a fast matrix-based approach to computing the output from a neural network

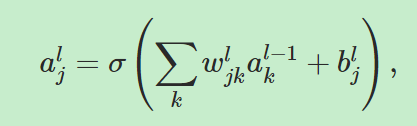

定义 表示第(l-1)层的第k个神经元到第l层的第j个神经元的权重。

表示第(l-1)层的第k个神经元到第l层的第j个神经元的权重。 表示第l层的第j个神经元的bias。

表示第l层的第j个神经元的bias。 表示地l层的第j个神经元的激活值。

表示地l层的第j个神经元的激活值。

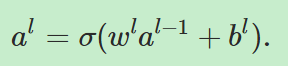

接下来我们要把下面的等式向量化:

=====》

=====》

其中al表示第l层网络的神经元的激活值构成的向量,wl、bl同理。其中 被称为加权输入(weighted input).

被称为加权输入(weighted input).

The two assumptions we need about the cost function

第一个假设是,损失函数可以写为单个训练样例(x1,x2,x3,x4,...,xn)的损失函数的平均值,也就是: ,这个假设在本系列文章中的其他损失函数中同样成立。我们做这个假设的原因是因为反向传播实际上让我们计算的是

,这个假设在本系列文章中的其他损失函数中同样成立。我们做这个假设的原因是因为反向传播实际上让我们计算的是 ,然后我们通过对每一个训练样例做平均来得到

,然后我们通过对每一个训练样例做平均来得到 。

。

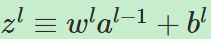

第二个假设是,损失函数可以写成神经网络的输出的函数,如下所示:

比如说二次损失函数(quadratic cost function)就满足这个要求,因为对于一个训练样例x的损失函数可以被写成 ,而它正是输出激活值的函数。

,而它正是输出激活值的函数。

The Hadamard product, s⊙t

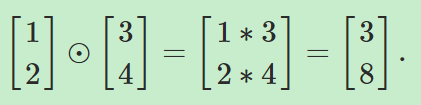

Hadamard乘积是用来定义向量之间的乘积。向量s和向量t的乘积的结果仍为一个向量,且元素为sjtj,也就是有 比如:

比如:

反向传播的四个基本方程

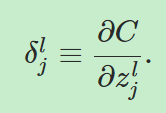

理解反向传播就是理解改变权重和bias是如何影响损失函数的。最终,这意味着计算 ,为了计算它们,我们要先引入一个中间量

,为了计算它们,我们要先引入一个中间量 ,它被称为第l层的第j个神经元的误差。定义:

,它被称为第l层的第j个神经元的误差。定义:

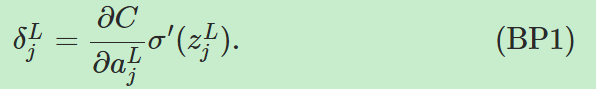

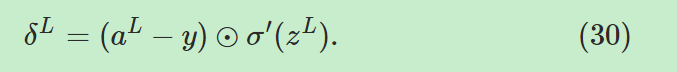

公式一,输出层误差公式:

------------------------>输出层单个神经元误差

------------------------>输出层单个神经元误差

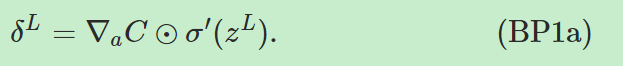

------------->输出层误差向量形式,

------------->输出层误差向量形式, 是偏导数

是偏导数 的向量。

的向量。

------------->输出层误差向量形式。如果单个神经元对单个输入样例的损失函数有

------------->输出层误差向量形式。如果单个神经元对单个输入样例的损失函数有 的形式,那么很容易有

的形式,那么很容易有 。

。

公式二,误差传递公式:

。对于这个公式的前一部分

。对于这个公式的前一部分 ,我们可以直观地认为当误差通过网络反向传播时

,我们可以直观地认为当误差通过网络反向传播时

它给了我们一种测量第l层神经元误差的方式。第二部分 把误差又进行反向传播并通过了激励函数,这样我们就得到了第l层加权输入中的误差。通过公式一和公式二,我们可以计算任意一层的误差,由公式一我们可以得到第L层的误差,用公式二反向传播可以获得l-1层的误差。依次向下进行。。。

把误差又进行反向传播并通过了激励函数,这样我们就得到了第l层加权输入中的误差。通过公式一和公式二,我们可以计算任意一层的误差,由公式一我们可以得到第L层的误差,用公式二反向传播可以获得l-1层的误差。依次向下进行。。。

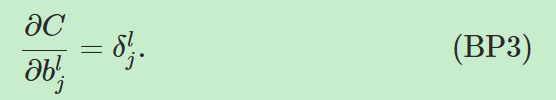

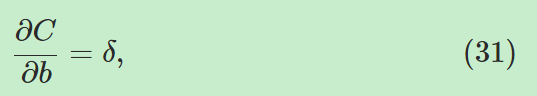

公式三,损失函数对网络中bias的偏导公式:

,这就是说

,这就是说 实际上等于损失函数的改变率

实际上等于损失函数的改变率 。该公式可以重写如公式(31):

。该公式可以重写如公式(31):

,它的意思是说某一神经元的δ值由该神经元的bias值表示。

,它的意思是说某一神经元的δ值由该神经元的bias值表示。

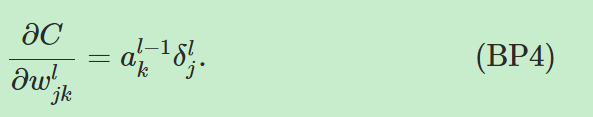

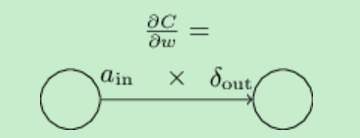

公式四,损失的改变率与网络中的权重的等式:

,这个公式表明了,如何通过a和δ计算

,这个公式表明了,如何通过a和δ计算 。它可以被简化重写如(32):

。它可以被简化重写如(32):

,用图表示就是

,用图表示就是 。公式(32)表明,当ain很小的时候,损失函数对权重的偏导数也会很小,我们称之为学习慢(learn slowly),也就是说从低激发值神经元深处的权重学习慢。

。公式(32)表明,当ain很小的时候,损失函数对权重的偏导数也会很小,我们称之为学习慢(learn slowly),也就是说从低激发值神经元深处的权重学习慢。

由以上分析可知,反向传播通过δ来计算代价函数对权重和偏置的偏导数,进而可以通过梯度下降推导出的公式对权重进行更新。反向传播算法的意义就在于不用通过对权重和bias真正求出偏导数,这省去了很大的麻烦。

参考资料:http://neuralnetworksanddeeplearning.com/chap2.html

神经网络与深度学习笔记 Chapter 2.的更多相关文章

- 神经网络与深度学习笔记 Chapter 6之卷积神经网络

深度学习 Introducing convolutional networks:卷积神经网络介绍 卷积神经网络中有三个基本的概念:局部感受野(local receptive fields), 共享权重 ...

- 神经网络与深度学习笔记 Chapter 1.

转载请注明出处:http://www.cnblogs.com/zhangcaiwang/p/6875533.html sigmoid neuron 微小的输入变化导致微小的输出变化,这种特性将会使得学 ...

- 神经网络与深度学习笔记 Chapter 3.

交叉熵 交叉熵是用于解决使用二次代价函数时当单个神经元接近饱和的时候对权重和bias权重学习的影响.这个公式可以看出,当神经元饱和的时候,sigma的偏导接近于0,w的学习也会变小.但是应用交叉熵作为 ...

- UFLDL深度学习笔记 (六)卷积神经网络

UFLDL深度学习笔记 (六)卷积神经网络 1. 主要思路 "UFLDL 卷积神经网络"主要讲解了对大尺寸图像应用前面所讨论神经网络学习的方法,其中的变化有两条,第一,对大尺寸图像 ...

- Deeplearning.ai课程笔记-神经网络和深度学习

神经网络和深度学习这一块内容与机器学习课程里Week4+5内容差不多. 这篇笔记记录了Week4+5中没有的内容. 参考笔记:深度学习笔记 神经网络和深度学习 结构化数据:如数据库里的数据 非结构化数 ...

- [DeeplearningAI笔记]神经网络与深度学习人工智能行业大师访谈

觉得有用的话,欢迎一起讨论相互学习~Follow Me 吴恩达采访Geoffrey Hinton NG:前几十年,你就已经发明了这么多神经网络和深度学习相关的概念,我其实很好奇,在这么多你发明的东西中 ...

- Google TensorFlow深度学习笔记

Google Deep Learning Notes Google 深度学习笔记 由于谷歌机器学习教程更新太慢,所以一边学习Deep Learning教程,经常总结是个好习惯,笔记目录奉上. Gith ...

- 深度学习笔记:优化方法总结(BGD,SGD,Momentum,AdaGrad,RMSProp,Adam)

深度学习笔记:优化方法总结(BGD,SGD,Momentum,AdaGrad,RMSProp,Adam) 深度学习笔记(一):logistic分类 深度学习笔记(二):简单神经网络,后向传播算法及实现 ...

- UFLDL深度学习笔记 (一)反向传播与稀疏自编码

UFLDL深度学习笔记 (一)基本知识与稀疏自编码 前言 近来正在系统研究一下深度学习,作为新入门者,为了更好地理解.交流,准备把学习过程总结记录下来.最开始的规划是先学习理论推导:然后学习一两种开源 ...

随机推荐

- tomcat一个端口配置多个项目

在server.xml中增加host节点 <Host name="localhost" appBase="webapps" <!--这是默认的--- ...

- 利用ssh反向代理以及autossh实现从外网连接内网服务器

前言 最近遇到这样一个问题,我在实验室架设了一台服务器,给师弟或者小伙伴练习Linux用,然后平时在实验室这边直接连接是没有问题的,都是内网嘛.但是回到宿舍问题出来了,使用校园网的童鞋还是能连接上,使 ...

- Mybatis JPA 代码构建

前段时间了解到Spring JPA,感觉挺好用,但其依赖于Hibernate,本人看到Hibernate就头大(不是说Hibernate不好哈,而是进阶太难),于是做了一个迷你版的Mybatis JP ...

- JavaScript中的几种继承方式对比

转自:http://blog.csdn.net/kkkkkxiaofei/article/details/46474069 从’严格’意义上说,JavaScript并不是一门真正的面向对象语言.这种说 ...

- swift3.0 coreData的使用-日记本demo

效果 需求分析 基于官方MasterDetail模板,官方写了很多复杂的coredata逻辑,在此基础上快速开发简单的日记本程序. - 主要功能:增.删.改.查 - 界面用默认的界面,将detail页 ...

- swift 3.0 基础练习 面向对象 类的扩展

要求 为NSString类添加split功能 为NSString类添加一个函数func split(splitStr: NSString)-> [NSString],split是把字符串以特定的 ...

- Python-cookies

附新手工具: python新手工具下载链接:http://pan.baidu.com/s/1eS8WMR4 密码:7eso 注册码:http://idea.liyang.io py和编辑器安装教程链接 ...

- python爬煎蛋妹子图--20多行代码搞定煎蛋妹子图库

如果说一个人够无聊的话... 就会做一些十分美(wei)丽(suo)的事情啦哈哈哈... 好的,话不多说,进入正题. 正如标题所示,我们今天的目标很简单: 代码要少,妹子要好. 步骤如下: 1. 首先 ...

- Python学习——(1)Centos安装Flask

一.环境 [root@localhost myproject]# cat /proc/version centos6.5 Linux version 2.6.32-642.11.1.el6.i686 ...

- HDU 6043 KazaQ's Socks (规律)

Description KazaQ wears socks everyday. At the beginning, he has nn pairs of socks numbered from 11 ...