spark集群搭建(三台虚拟机)——hadoop集群搭建(2)

!!!该系列使用三台虚拟机搭建一个完整的spark集群,集群环境如下:

virtualBox5.2、Ubuntu14.04、securecrt7.3.6_x64英文版(连接虚拟机)

jdk1.7.0、hadoop2.6.5、zookeeper3.4.5、Scala2.12.6、kafka_2.9.2-0.8.1、park1.3.1-bin-hadoop2.6

前面搭建了spark集群需要的系统环境,本文在前文基础上搭建hadoop集群

一、配置几个配置文件

hadoop的下载和配置只需在spark1上操作,然后拷贝到另外两台机器上即可,下面的配置均在spark1上进行

$ cd /usr/local/bigdata/hadoop #进入hadoop安装目录

$ cd ./etc/hadoop

1、core-site.xml

$ vim core-site.xml

添加如下,指定namenode的地址:

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://spark1:9000</value>

</property>

</configuration>

2、hdfs-site.xml

$ vim hdfs-site.xml

<configuration>

<property>

<name>dfs.name.dir</name>

<value>/usr/local/hadoop/data/namenode</value>

</property>

<property>

<name>dfs.data.dir</name>

<value>/usr/local/hadoop/data/datanode</value>

</property>

<property>

<name>dfs.tmp.dir</name>

<value>/usr/local/hadoop/data/tmp</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

</configuration>

3、mapred-site.xml,指定hadoop运行在yarn之上

$ mv mapred-site.xml.template mapred-site.xml

$ vim mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

4、yarn-site.xml

$ vim yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>spark1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

5、slaves

$ vim slaves

spark1

spark2

spark3

6、hadoop-env.sh

vim hadoop-env.sh

输入jdk完整路径

export JAVA_HOME=/usr/local/bigdata/jdk

二、另外两台机器

使用拷贝命令将hadoop拷贝过去

$ cd /usr/local/bigdata

$ scp -r hadoop root@spark2:/usr/local/bigdata

$ scp -r hadoop root@spark3:/usr/local/bigdata

三、配置hadoop环境变量,三台机器均需要配置

export HADOOP_HOME=/usr/local/bigdata/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export HADOOP_COMMOM_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

四、启动hadoop集群

格式化namenode

$ hdfs namenode -format

$ start-dfs.sh

此时三台机器启动如下,才算成功

spark1

root@spark1:/usr/local/bigdata/hadoop/etc/hadoop# jps

4275 Jps

3859 NameNode

4120 SecondaryNameNode

3976 DataNode

spark2

root@spark2:/usr/local/bigdata/hadoop/etc/hadoop# jps

6546 DataNode

6612 Jps

spark3

root@spark3:/usr/local/bigdata/hadoop/etc/hadoop# jps

4965 DataNode

5031 Jps

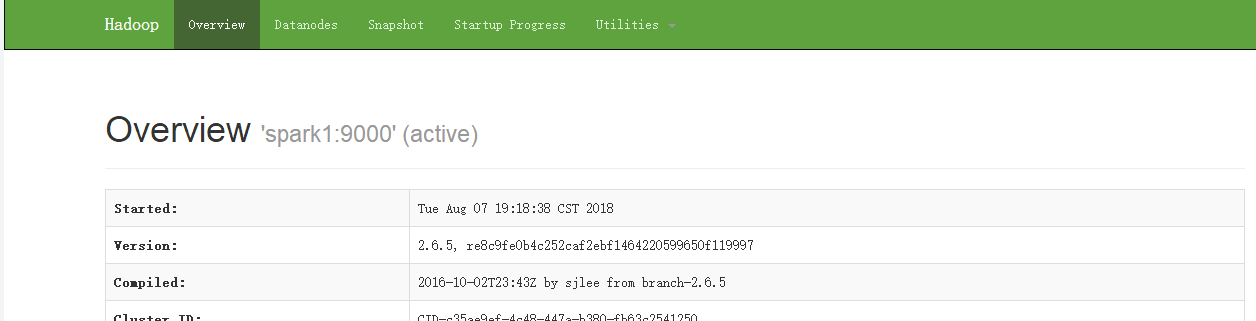

进入浏览器,访问http://spark1:50070

五、启动yarn集群

$ start-yarn.sh

此时spark1

root@spark1:/usr/local/bigdata/hadoop/etc/hadoop# jps

3859 NameNode

4803 Jps

4120 SecondaryNameNode

3976 DataNode

4443 ResourceManager

4365 NodeManager

spark2

root@spark2:/usr/local/bigdata/hadoop/etc/hadoop# jps

6546 DataNode

6947 Jps

6771 NodeManager

spark3

root@spark3:/usr/local/bigdata/hadoop/etc/hadoop# jps

5249 Jps

4965 DataNode

5096 NodeManager

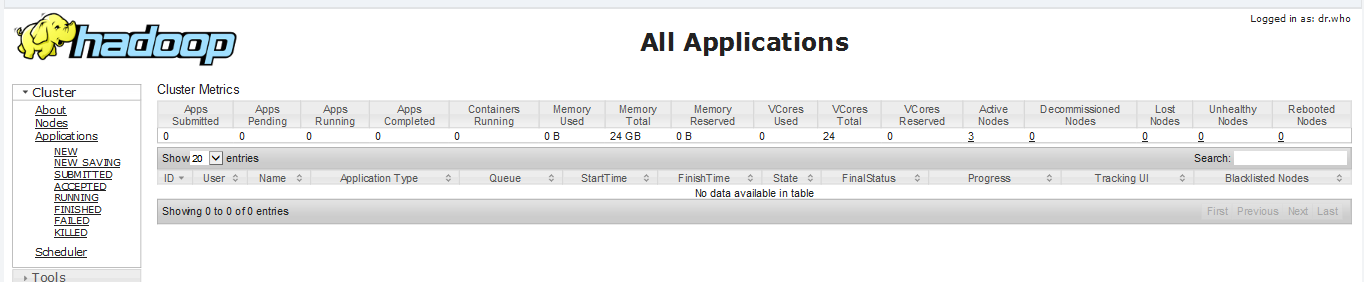

浏览器输入spark1:8088

spark集群搭建(三台虚拟机)——hadoop集群搭建(2)的更多相关文章

- Centos 7下VMware三台虚拟机Hadoop集群初体验

一.下载并安装Centos 7 传送门:https://www.centos.org/download/ 注:下载DVD ISO镜像 这里详解一下VMware安装中的两个过程 网卡配置 是Add ...

- 基于Docker快速搭建多节点Hadoop集群--已验证

Docker最核心的特性之一,就是能够将任何应用包括Hadoop打包到Docker镜像中.这篇教程介绍了利用Docker在单机上快速搭建多节点 Hadoop集群的详细步骤.作者在发现目前的Hadoop ...

- Hadoop4 利用VMware搭建自己的hadoop集群

前言: 前段时间自己学习如何部署伪分布式模式的hadoop环境,之前由于工作比较忙,学习的进度停滞了一段时间,所以今天抽出时间把最近学习的成果和大家分享一下. 本文要介绍的是如 ...

- 搭建简单的hadoop集群(译文)

本文翻译翻译自http://hadoop.apache.org/docs/r2.8.0/hadoop-project-dist/hadoop-common/ClusterSetup.html 具体的实 ...

- 在 Linux 服务器上搭建和配置 Hadoop 集群

实验条件:3台centos服务器,jdk版本1.8.0,Hadoop 版本2.8.0 注:hadoop安装和搭建过程中都是在用户lb的home目录下,master的主机名为host98,slave的主 ...

- Spark应用(app jar)发布到Hadoop集群的过程

记录了Spark,Hadoop集群的开启,关闭,以及Spark应用提交到Hadoop集群的过程,通过web端监控运行状态. 1.绝对路径开启集群 (每次集群重启,默认配置的hadoop集群中tmp文件 ...

- 虚拟机hadoop集群搭建

hadoop tar -xvf hadoop-2.7.3.tar.gz mv hadoop-2.7.3 hadoop 在hadoop根目录创建目录 hadoop/hdfs hadoop/hdfs/tm ...

- 搭建ubuntu版hadoop集群

用到的工具:VMware.hadoop-2.7.2.tar.jdk-8u65-linux-x64.tar.ubuntu-16.04-desktop-amd64.iso 1. 在VMware上安装ub ...

- Hadoop入门第四篇:手动搭建自己的hadoop小集群

前言 好几天没有更新了,本来是应该先写HDFS的相关内容,但是考虑到HDFS是我们后面所有学习的基础,而我只是简单的了解了一下而已,后面准备好好整理HDFS再写这块.所以大家在阅读这篇文章之前,请先了 ...

- Spark集群环境搭建——Hadoop集群环境搭建

Spark其实是Hadoop生态圈的一部分,需要用到Hadoop的HDFS.YARN等组件. 为了方便我们的使用,Spark官方已经为我们将Hadoop与scala组件集成到spark里的安装包,解压 ...

随机推荐

- [BZOJ1694/1742/3074]The Cow Run 三倍经验

Description John养了一只叫Joseph的奶牛.一次她去放牛,来到一个非常长的一片地,上面有N块地方长了茂盛的草.我们可 以认为草地是一个数轴上的一些点.Joseph看到这些草非常兴奋, ...

- Spring Cloud Alibaba(二) 配置中心多项目、多配置文件、分目录实现

介绍 之前Spring Cloud Config基础篇这篇文章介绍了Spring Cloud Config 配置中心基础的实现,今天继续聊下Spring Cloud Config 并结合nacos做服 ...

- 细谈Mysql事务

文章原创于公众号:程序猿周先森.本平台不定时更新,喜欢我的文章,欢迎关注我的微信公众号. 上一篇着重谈到了MySQL锁的概念,里面谈到了事务的概念,其实大部分开发者对于事务肯定不陌生,事务的概念其实就 ...

- 上传文件夹或上传文件到linux

http://jingyan.baidu.com/article/d169e18658995a436611d8ee.html https://www.cnblogs.com/nbf-156cwl/p/ ...

- Python斐波那契数列

今天偶然看到这个题目,闲着没事练一下手 if __name__ == '__main__': """ 斐波那契数列(Fibonacci sequence), 又称黄金分割 ...

- 你真的了解java序列化吗

问:可是我这个实体类,没有实现序列化那个接口,也能存到数据库,这是为什么呢? 想不通!我是用的注解和hibernate框架弄的! 难道说不实现序列化接口也能保存数据?不应该啊. @Entity pub ...

- PHPStorm 10 配置PHPUnit

PHPStorm 10 配置PHPUnit PHPUnit的安装 自己用的是Xampp,PHPUnit好像自带不好用. 不说废话: 自己看 According to official site htt ...

- day03课堂练习

简述变量的组成 变量由变量名,赋值符号,和变量值三个部分组成 简述变量名的命名规范 a.变量名必须有意义,要能反映变量值所描述的状态 b.变量名以字母.数字和下划线组成,不能用数字开头 c.不能以关键 ...

- Redis(六)复制

在分布式系统中为了解决单点问题,通常会把数据复制多个副本部署到其他机器,满足故障恢复和负载均衡等需求.Redis也是如此,它为我们提供了复制功能,实现了相同数据的多个Redis副本.复制功能是高可用R ...

- Spring中@Resource注解报错

描述:Spring框架中,@Resource注解报错,在书写时没有自动提示 解决方法:因为maven配置文件的pom.xml文件中缺少javax.annotation的依赖,在pom.项目路中加入依赖 ...