使用urllib

urlopen的基本用法:

工具为:python3(windows)

其完整表达式为:

urllib.request.urlopen(url, data=None, [timeout, ]*, cafile=None, capath=None, cadefault=False, context=None)

1、发出一个请求.打开bttpbin.org网页,此处为get方式的请求类型

>>>import urllib.request

>>> response = urllib.request.urlopen("http://httpbin.org")

#此处为将 结果赋值给response

>>> print(response.read().decode('utf-8'))

#得到的response是bytes类型,所以我们需要使用decode

httpbin.org:可以以后用来做http测试 2、此处为POST 类型的请求需要使用到data

>>> import urllib.parse

>>> import urllib.request

>>> data = bytes(urllib.parse.urlencode({"word":"hello"}),encoding="utf8")

#需要创建data参数,需要为bytes类型,用urlencode将字典传过去

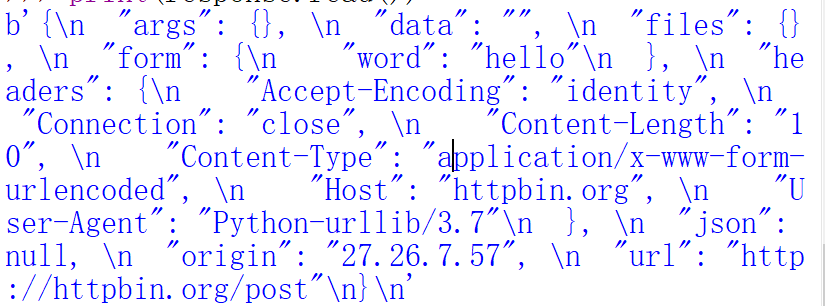

>>> response = urllib.request.urlopen("http://httpbin.org/post",data = data)

>>> print(response.read())

3、超时设置timeout

>>> import urllib.request

>>> response = urllib.request.urlopen("http://httpbin.org/get",timeout=1 )

>>> print(response.read())

发现下方有正常的响应

若超时的时间为0.1,如果出现异常,对异常进行捕获

>>> import socket

>>> import urllib.request

>>> import urllib.error

try:

response = urllib.request.urlopen("http://httpbin.org/get",timeout=0.1)

except urllib.error.URLError as e:

if isinstance(e.reason,socket.timeout):

print("TIME OUT")

会出现TIME OUT 结果。

发送请求之后出现响应 1、响应类型

>>> import urllib.request

>>> response = urllib.request.urlopen("http://httpbin.org")

>>> print(type(response))

<class 'http.client.HTTPResponse'>

2、状态码 响应头

>>> import urllib.request

>>> response =urllib.request.urlopen("http://httpbin.org")

>>> print(response.status) #此处为状态码,200显示为成功的意思

200

>>> print(response.getheaders()) #此处为获取所有的状态头,并且以元组的形式输出

[('Connection', 'close'), ('Server', 'gunicorn/19.9.0'), ('Date', 'Tue, 09 Oct 2018 12:49:34 GMT'), ('Content-Type', 'text/html; charset=utf-8'), ('Content-Length', '10122'), ('Access-Control-Allow-Origin', '*'), ('Access-Control-Allow-Credentials', 'true'), ('Via', '1.1 vegur')]

>>> print(response.getheader('Server'))

gunicorn/19.9.0

[此处表示为此处的服务器是由gunicorn/19.9.0所做]

response.read():获取响应体内容为bytes类型,我们可以用decode进行转化

>>> import urllib.request

>>> response = urllib.request.urlopen("http://httpbin.org")

>>> print(response.read().decode('utf-8'))

Request的基本用法

(如果我们想要发送header对象或者其他复杂东西,就需要用到Request)

>>> import urllib.request

>>> response = urllib.request.Request("http://httpbin.org")

>>> response = urllib.request.urlopen(request)

>>> print(response.read().decode('utf-8'))

正常输出,与上方直接输入的结果是完全一致,有了Request能够更加方便

此处为模仿火狐浏览器进行请求

from urllib import request,parse

url = "http://httpbin.org/post"

headers = {

"User-Agent":'Mozllia/4.0(compatible;MSIE 5.5;Windows NT)',

"Host":'httpbin.org'

}

dict = {

'name':'Germey'

}

data = bytes(parse.urlencode(dict),encoding="utf8")

req = request.Request(url=url,data=data,headers=headers,method="POST")

response= request.urlopen(req)

print(response.read().decode("utf-8"))

也会出现结果

使用urllib的更多相关文章

- python urllib

在伴随学习爬虫的过程中学习了解的一些基础库和方法总结扩展 1. urllib 在urllib.request module中定义下面的一些方法 urllib.request.urlopen(url,d ...

- Python3使用urllib访问网页

介绍 改教程翻译自python官网的一篇文档. urllib.request是一个用于访问URL(统一资源定位符)的Python模块.它以urlopen函数的形式提供了一个非常简单的接口,可以访问使用 ...

- 爬虫初探(1)之urllib.request

-----------我是小白------------ urllib.request是python3自带的库(python3.x版本特有),我们用它来请求网页,并获取网页源码. # 导入使用库 imp ...

- python 3.x urllib学习

urllib.request import urllib.request as ur url='http://ie.icoa.cn' user_agent = 'Mozilla/4.0 (compat ...

- Python爬虫学习(1): urllib的使用

1.urllib.urlopen 打开一个url的方法,返回一个文件对象,然后可以进行类似文件对象的操作 In [1]: import urllibIn [2]: file = urllib.urlo ...

- python2 与 python3 urllib的互相对应关系

urllib Python2 name Python3 nameurllib.urlopen() Deprecated. See urllib.request.urlopen() which mirr ...

- urllib+BeautifulSoup无登录模式爬取豆瓣电影Top250

对于简单的爬虫任务,尤其对于初学者,urllib+BeautifulSoup足以满足大部分的任务. 1.urllib是Python3自带的库,不需要安装,但是BeautifulSoup却是需要安装的. ...

- 初学python之urllib

urllib.request urlopen()urllib.urlopen(url, data, proxies) :创建一个表示远程url的类文件对象,然后像本地文件一样操作这个类文件对象来获取远 ...

- urllib.urlretrieve的用法

urllib.urlretrieve(url, local, cbk) urllib.urlretrieve(p,'photo/%s.jpg'%p.split('/')[-4]) url要下载的网站 ...

- 关于python3.X 报"import urllib.request ImportError: No module named request"错误,解决办法

#encoding:UTF-8 import urllib.request url = "http://www.baidu.com" data = urllib.request.u ...

随机推荐

- zabbix 微信告警机制

微信告警首先得注册一个企业微信,然后才能实现微信告警.自行百度 微信: 添加一个用户到上面创建的部门里面 创建完成记住 AgentID 和 Secret 下一步:记住企业 ID 1)编辑zabbix ...

- dns的抓包分析

dns: 域名系统(服务)协议 dns的解析全过程: 1. 浏览器先检查自身缓存中有没有被解析过的这个域名对应的ip地址,如果有,解析结束.同时域名被缓存的时间也可通过TTL属性来设置. 2. 如果浏 ...

- QIntValidator没有最小值的限制,继承然后写个新类来控制最小值

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明.本文链接:https://blog.csdn.net/firecityplans/article ...

- 自动化部署jenkins

jenkins下载网站 https://mirrors.tuna.tsinghua.edu.cn/jenkins/redhat/ 一.配置环境 [root@localhost ~]# hostname ...

- Bubble Cup 11 - Finals [Online Mirror, Div. 1]题解 【待补】

Bubble Cup 11 - Finals [Online Mirror, Div. 1] 一场很好玩的题啊! I. Palindrome Pairs 枚举哪种字符出现奇数次. G. AI robo ...

- Pointers and Memory

Stanford CS Education Library #102 一.Basic Pointers 指针主要有两个用途:使不同的代码段共享信息.方便链表(树)的处理. 指针示意图: derefer ...

- Cypress 自动化环境搭建

1.Cypress 下载: 官网下载,下载后直接解压即可,解压后便可单机 exe 文件打开 Ps:直接打开 exe 是会报错找不到 json文件的,所以还要安装依赖环境 运行 cypress 项目前, ...

- Jmeter 数据库测试

1.环境准备,下载驱动 mysql-connector-java-5.1.45-bin.jar 下载的 jar 包保存在 Jmeter 的文件的 lib 下的 ext 目录下,则不需要做其他的配置了, ...

- python-CSV格式清洗与转换、CSV格式列变换、CSV格式数据清洗【数据读入的三种方法】【strip、replace、split、join函数的使用】

1)CSV格式清洗与转换 描述 附件是一个CSV格式文件,提取数据进行如下格式转换: (1)按行进行倒序排列: (2)每行数据倒序排 ...

- 绕WAF文章收集

在看了bypassword的<在HTTP协议层面绕过WAF>之后,想起了之前做过的一些研究,所以写个简单的短文来补充一下文章里“分块传输”部分没提到的两个技巧. 技巧1 使用注释扰乱分块数 ...